NLTK与NLP原理及基础

Posted elpsycongroo

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了NLTK与NLP原理及基础相关的知识,希望对你有一定的参考价值。

参考https://blog.csdn.net/zxm1306192988/article/details/78896319

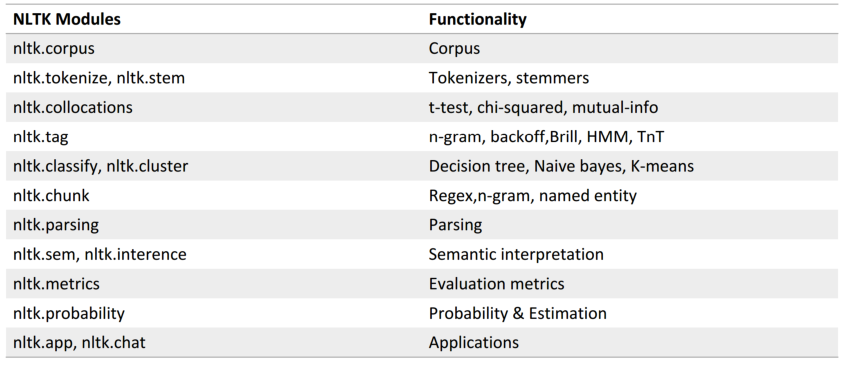

以NLTK为基础配合讲解自然语言处理的原理 http://www.nltk.org/

Python上著名的自然语?处理库

自带语料库,词性分类库

自带分类,分词,等功能

强?的社区?持

还有N多的简单版wrapper,如 TextBlob

NLTK安装(可能需要预先安装numpy)

pip install nltk

安装语料库

import nltk nltk.download()

NLTK自带语料库

>>> from nltk.corpus import brown >>> brown.categories() # 分类 [‘adventure‘, ‘belles_lettres‘, ‘editorial‘, ‘fiction‘, ‘government‘, ‘hobbies‘, ‘humor‘, ‘learned‘, ‘lore‘, ‘mystery‘, ‘news‘, ‘religion‘, ‘reviews‘, ‘romance‘, ‘science_fiction‘] >>> len(brown.sents()) # 一共句子数 57340 >>> len(brown.words()) # 一共单词数 1161192

文本处理流程:

文本 -> 预处理(分词、去停用词) -> 特征工程 -> 机器学习算法 -> 标签

分词(Tokenize)

把长句?拆成有“意义”的?部件

>>> import nltk >>> sentence = “hello, world" >>> tokens = nltk.word_tokenize(sentence) >>> tokens [‘hello‘, ‘,‘, ‘world‘]

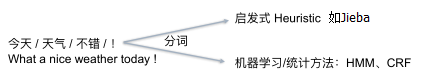

中英文NLP区别:

英文直接使用空格分词,中文需要专门的方法进行分词