阿里巴巴为什么让初始化集合时必须指定大小?

Posted vipstone

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了阿里巴巴为什么让初始化集合时必须指定大小?相关的知识,希望对你有一定的参考价值。

哈喽,亲爱的小伙伴们,技术学磊哥,进步没得说!欢迎来到新一期的性能解读系列,我是磊哥。

今天给大家带来的是关于阿里巴巴《Java开发手册》泰山版(最新)中关于集合初始化时的性能建议。

阿里巴巴《Java开发手册》第 1 章编程规范,第 6 节集合处理的第 17 条规定如下:

【推荐】集合初始化时,指定集合初始值大小。

说明:HashMap 使用 HashMap(int initialCapacity) 初始化,如果暂时无法确定集合大小,那么指定默认值(16)即可。

正例:initialCapacity = (需要存储的元素个数 / 负载因子) + 1。注意负载因子(即 loader factor)默认为 0.75,如果暂时无法确定初始值大小,请设置为 16(即默认值)。

反例:HashMap 需要放置 1024 个元素,由于没有设置容量初始大小,随着元素不断增加,容量 7 次被迫扩大,resize 需要重建 hash 表。当放置的集合元素个数达千万级别时,不断扩容会严重影响性能。

规范解读

此规范的主要目的完全是出于性能考虑,查看 HashMap 的源码也就可以发现此规范的原因,如果我们能为集合设置合理的大小就可以避免 HashMap 的扩容操作,而 HashMap 的扩容方法 resize 有很多逻辑判断和业务操作,如果设置了合理的大小就可以避免执行更多的代码,因此就可以更大限度的提高集合的执行效率,HashMap 的 resize 源码如下:

// 源码基于 JDK 8

final Node<K,V>[] resize() {

// 扩容前的数组

Node<K,V>[] oldTab = table;

// 扩容前的数组的大小和阈值

int oldCap = (oldTab == null) ? 0 : oldTab.length;

int oldThr = threshold;

// 预定义新数组的大小和阈值

int newCap, newThr = 0;

if (oldCap > 0) {

// 超过最大值就不再扩容了

if (oldCap >= MAXIMUM_CAPACITY) {

threshold = Integer.MAX_VALUE;

return oldTab;

}

// 扩大容量为当前容量的两倍,但不能超过 MAXIMUM_CAPACITY

else if ((newCap = oldCap << 1) < MAXIMUM_CAPACITY &&

oldCap >= DEFAULT_INITIAL_CAPACITY)

newThr = oldThr << 1; // double threshold

}

// 当前数组没有数据,使用初始化的值

else if (oldThr > 0) // initial capacity was placed in threshold

newCap = oldThr;

else { // zero initial threshold signifies using defaults

// 如果初始化的值为 0,则使用默认的初始化容量

newCap = DEFAULT_INITIAL_CAPACITY;

newThr = (int)(DEFAULT_LOAD_FACTOR * DEFAULT_INITIAL_CAPACITY);

}

// 如果新的容量等于 0

if (newThr == 0) {

float ft = (float)newCap * loadFactor;

newThr = (newCap < MAXIMUM_CAPACITY && ft < (float)MAXIMUM_CAPACITY ?

(int)ft : Integer.MAX_VALUE);

}

threshold = newThr;

@SuppressWarnings({"rawtypes","unchecked"})

Node<K,V>[] newTab = (Node<K,V>[])new Node[newCap];

// 开始扩容,将新的容量赋值给 table

table = newTab;

// 原数据不为空,将原数据复制到新 table 中

if (oldTab != null) {

// 根据容量循环数组,复制非空元素到新 table

for (int j = 0; j < oldCap; ++j) {

Node<K,V> e;

if ((e = oldTab[j]) != null) {

oldTab[j] = null;

// 如果链表只有一个,则进行直接赋值

if (e.next == null)

newTab[e.hash & (newCap - 1)] = e;

else if (e instanceof TreeNode)

// 红黑树相关的操作

((TreeNode<K,V>)e).split(this, newTab, j, oldCap);

else { // preserve order

// 链表复制,JDK 1.8 扩容优化部分

Node<K,V> loHead = null, loTail = null;

Node<K,V> hiHead = null, hiTail = null;

Node<K,V> next;

do {

next = e.next;

// 原索引

if ((e.hash & oldCap) == 0) {

if (loTail == null)

loHead = e;

else

loTail.next = e;

loTail = e;

}

// 原索引 + oldCap

else {

if (hiTail == null)

hiHead = e;

else

hiTail.next = e;

hiTail = e;

}

} while ((e = next) != null);

// 将原索引放到哈希桶中

if (loTail != null) {

loTail.next = null;

newTab[j] = loHead;

}

// 将原索引 + oldCap 放到哈希桶中

if (hiTail != null) {

hiTail.next = null;

newTab[j + oldCap] = hiHead;

}

}

}

}

}

return newTab;

}

性能评测

接下来我们来测试一下设置 size 的性能和不设置 size 的性能差别,我们已知需要插入 1024 个数据,根据默认的负载因子 0.75 和公式 (存储元素个数/负载因子)+1 得出需要设置的大小为 1367(取整)。

小贴士:公式“(存储元素个数/负载因子)+1”说明:因为 HashMap 的实际存储量等于:元素个数*负载因子,为了防止 HashMap 扩容,所以公式必须是“(存储元素个数/负载因子)+1”才能防止动态扩容。

本文我们依旧使用 Oracle 官方提供的 JMH(Java Microbenchmark Harness,JAVA 微基准测试套件)测试框架,首先现在 pom.xml 中添加 JMH 引用,配置如下:

<!-- https://mvnrepository.com/artifact/org.openjdk.jmh/jmh-core -->

<dependency>

<groupId>org.openjdk.jmh</groupId>

<artifactId>jmh-core</artifactId>

<version>{version}</version>

</dependency>

然后编写完整的测试代码:

import org.openjdk.jmh.annotations.*;

import org.openjdk.jmh.infra.Blackhole;

import org.openjdk.jmh.runner.Runner;

import org.openjdk.jmh.runner.RunnerException;

import org.openjdk.jmh.runner.options.Options;

import org.openjdk.jmh.runner.options.OptionsBuilder;

import java.util.HashMap;

import java.util.Map;

import java.util.concurrent.TimeUnit;

@BenchmarkMode(Mode.AverageTime) // 测试完成时间

@OutputTimeUnit(TimeUnit.NANOSECONDS)

@Warmup(iterations = 2, time = 1, timeUnit = TimeUnit.SECONDS) // 预热 2 轮,每次 1s

@Measurement(iterations = 5, time = 3, timeUnit = TimeUnit.SECONDS) // 测试 5 轮,每次 3s

@Fork(1) // fork 1 个线程

@State(Scope.Thread) // 每个测试线程一个实例

public class AlibabaHashMapTest {

public static void main(String[] args) throws RunnerException {

// 启动基准测试

Options opt = new OptionsBuilder()

.include(AlibabaHashMapTest.class.getSimpleName()) // 要导入的测试类

.build();

new Runner(opt).run(); // 执行测试

}

@Benchmark

public void noSizeTest(Blackhole blackhole) {

Map map = new HashMap();

for (int i = 0; i < 1024; i++) {

map.put(i, i);

}

// 为了避免 JIT 忽略未被使用的结果

blackhole.consume(map);

}

@Benchmark

public void setSizeTest(Blackhole blackhole) {

Map map = new HashMap(1367);

for (int i = 0; i < 1024; i++) {

map.put(i, i);

}

// 为了避免 JIT 忽略未被使用的结果

blackhole.consume(map);

}

}

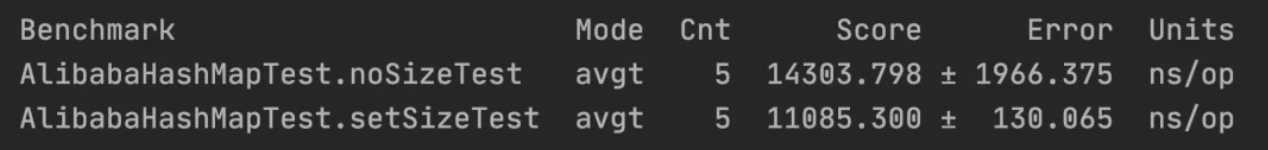

测试结果如下:

从上述结果可以看出,设置了大小的 HashMap 的性能约是没有设置大小的 1.29 倍。

总结

在初始化集合时,如果已知集合的数量,那么一定要在初始化时设置集合的容量大小,这样就可以有效的提高集合的性能,但需要注意的是 HashMap 的实际存储量是“元素个数*负载因子”,而负载因子默认是 0.75,因此在设置大小时,要使用“(存储元素个数/负载因子)+1”的公式计算出正确的值再进行设置。

以上是关于阿里巴巴为什么让初始化集合时必须指定大小?的主要内容,如果未能解决你的问题,请参考以下文章