NFS文件存储

Posted pansn

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了NFS文件存储相关的知识,希望对你有一定的参考价值。

NFS文件存储

NFS操作与部署

1. 安装 epel 库

yum upgrade -y

yum -y install epel-release

2. 配置防火墙

firewall-cmd --add-service=nfs --permanent --zone=public

firewall-cmd --add-service=mountd --permanent --zone=public

firewall-cmd --add-service=rpc-bind --permanent --zone=public

firewall-cmd --reload

生产环境应该使用更严格的方式

3. 安装 nfs-server

yum -y install nfs-utils rpcbind

systemctl enable rpcbind nfs-server nfs-lock nfs-idmap

systemctl start rpcbind nfs-server nfs-lock nfs-idmap

4. 创建 NFS 共享目录

mkdir /data

此共享目录存放 jumpserver 的录像及任务结果

5. 设置 NFS 访问权限

vi /etc/exports

/data 192.168.100.*(rw,sync,no_root_squash)

/data 是刚才创建的将被共享的目录, 192.168.100.* 表示整个 192.168.100.* 的资产都有括号里面的权限

也可以写具体的授权对象 /data 192.168.100.30(rw,sync,no_root_squash) 192.168.100.31(rw,sync,no_root_squash)

6. 使 exports 生效

exportfs -a

ubuntu安装nfs服务

1、安装nfs服务

不是root管理员运行

sudo apt install nfs-kernel-server

2、修改配置文件

vim /etc/export

/work 172.21.137.*(rw,sync,no_subtree_check,no_root_squash)

3、新建work共享目录

sudo /work

sudo chmod 755 /work -R

4、启动nfs服务

sudo service nfs-kernel-server start

5、检查nfs状态并设置开机启动

sudo nfsstat

sudo apt-get install sysv-rc-conf

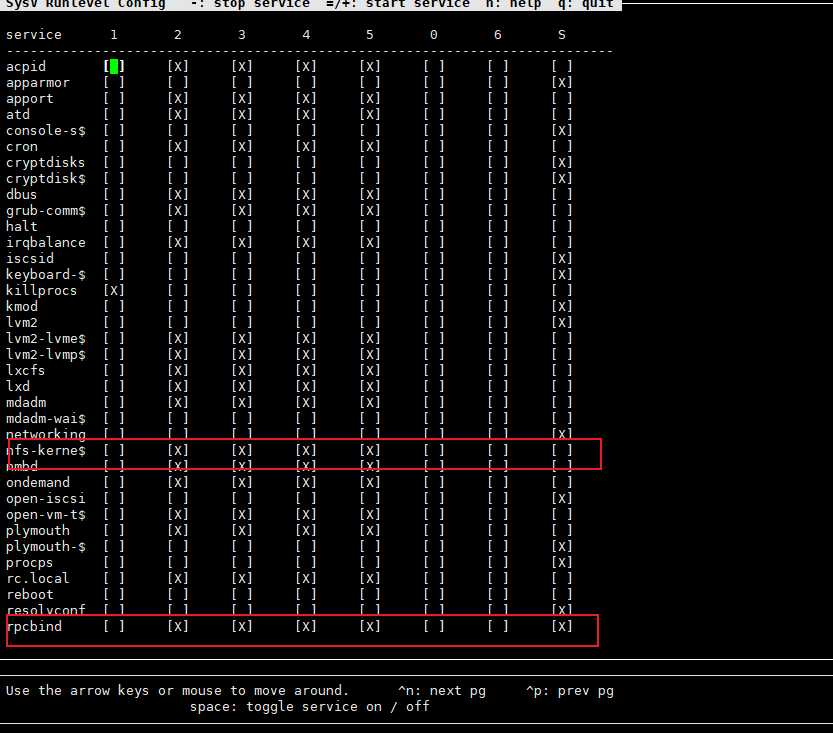

sudo sysv-rc-conf

5、nfs常用工具

#显示已经mount到本机nfs目录的客户端机器。

sudo showmount -e localhost

#将配置文件中的目录全部重新export一次!无需重启服务。

sudo exportfs -rv

#查看NFS的运行状态

sudo nfsstat

#查看rpc执行信息,可以用于检测rpc运行情况

sudo rpcinfo

#查看网络端口,NFS默认是使用111端口。

sudo netstat -tu -4

NFS-Client

6、安装NFS客户端

sudo apt install nfs-common

7、查看NFS服务器共享目录

rdadmin@RD-NFS-01-VT:/work$ sudo showmount -e 172.21.137.23

Export list for 172.21.137.23:

/work 172.21.137.*

8、挂载nfs服务

mkdir /{data_new,data_final,data} -pv

mount -t nfs -o soft,,timeo=10 172.21.137.23:/work /work

9、查看挂载

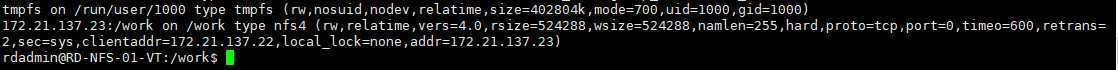

mount | grep nfs

rsize和wsize:

文件传输尺寸设定:V3没有限定传输尺寸,V2最多只能设定为8k,可以使用-rsize and -wsize 来进行设定。这两个参数的设定对于NFS的执行效能有较大的影响

bg:在执行mount时如果无法顺利mount上时,系统会将mount的操作转移到后台并继续尝试mount,直到mount成功为止。(通常在设定/etc/fstab文件时都应该使用bg,以避免可能的mount不上而影响启动速度)

fg:和bg正好相反,是默认的参数

nfsvers=n:设定要使用的NFS版本,默认是使用2,这个选项的设定还要取决于server端是否支持NFS VER 3

mountport:设定mount的端口

port:根据server端export出的端口设定,例如如果server使用5555端口输出NFS,那客户端就需要使用这个参数进行同样的设定

timeo=n:设置超时时间,当数据传输遇到问题时,会根据这个参数尝试进行重新传输。默认值是7/10妙(0.7秒)。如果网络连接不是很稳定的话就要加大这个数值,并且推荐使用HARD MOUNT方式,同时***也加上INTR参数,这样你就可以终止任何挂起的文件访问。

intr 允许通知中断一个NFS调用。当服务器没有应答需要放弃的时候有用处。

udp:使用udp作为nfs的传输协议(NFS V2只支持UDP)

tcp:使用tcp作为nfs的传输协议

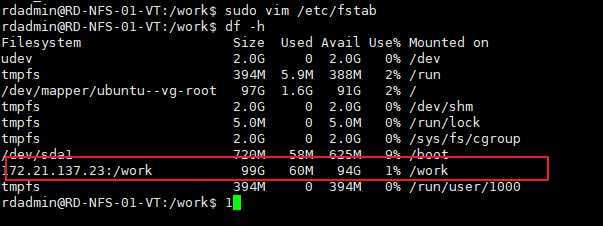

df -h

10、设置自动挂载

不要放入/etc/fatab做开机启动,因为fstab启动较早,那个时候网络服务还未启动,挂载会失败

vim /etc/rc.local

mount -t nfs -o soft,,timeo=10 172.21.137.23:/work /work

chmod +x /etc/rc.loacl

NFS优化

1、查看挂载配置

cat /var/lib/nfs/etab 查看NFS服务器端配置参数的细节

cat /proc/mounts 查看客户端mount的挂载参数细节

2、NFS客户端对mount挂载说明

fg/bg 默认[fg],在客户端执行挂载时,可以选择在前台(fg)执行还是在后台(bg)执行

soft/hart 默认[hart]当网络和server出问题时,soft参数会在超时后停止挂载,hard参数会一直挂载直到成功(但可能造成客户端无响应,常配合intr参数使用)

intr 当hard挂载资源timeout后,若使用intr参数可在超时后终端挂载,防止NFS锁死

resize/wsize 读出和写入的区块大小,影响客户端与服务器段传输数据的缓冲存储量

proto=tcp 默认[tcp]传输使用的协议,跨internet建议tcp有较好的纠错能力,内网建议用udp提高性能

3、挂载模式建议

追求极致

mount -t nfs -o fg,hart,intr,resize=13107,wsize=131072 172.16.1.31:/date/ /mnt

简单易用

mount -t nfs 172.16.1.31:/date/ /mnt

# 默认参数能满足大部分需求

4、mount -o可以使用的参数说明()

ro/rw ■以只读/读写方式挂载

dev/nodev 是否保留装置文件的特殊功能,如分区和光驱的区别,建议一般nodev

sync/async ●直接同步写入磁盘,还是异步先写入内存再后续写入硬盘

auto/noauto 允许/不允许以–a选项进行自动挂载

exec/noexec ●是否具有执行文件的权限,如果挂载的用途是数据存储,建议noexec

suid/nosuid ●挂载的文件系统,是否取消suid这个权限

user/nouser 是否允许一般用户的挂载与卸载功能

dirsync ●目录更新时同步写入磁盘

remount 尝试重新挂载已经挂载了的文件系统

noatime ■访问文件时不更新文件inode中的时间戳,高并发环境可提高性能

nodiratime ■同上,不更新目录的访问时间戳atime

defaults 使用所有选项的默认值(auto、nouser、rw、suid)

loop 挂载“回旋设备”以及“ISO镜像文件”

●表示安全优化参数,■表示性能优化参数,安全和性能是对立的

5 企业生产环境下NFS优化挂载3常见用法

1)默认挂载

mount -t nfs IP:目录 /挂载点

# 其实centos的默认挂载性能已经非常不错了

2)性能优化

# 减少更新访问时间戳产生的磁盘I/O

mount -t nfs -o noatime,nodiratime IP:目录 /挂载点

3)安全优化

# 进行执行和提权执行,防挂马

mount -t nfs -o nosuid,noexec,nodev IP:目录 /挂载点

4)安全和性能都优化

mount -t nfs -o nosuid,noexec,nodev,noatime,nodiratime,intr,rsize=131072,wsize=131072 IP:目录 /挂载点

注意:本地文件系统挂载时不能加odiratime选项,会报错

6 NFS内核优化说明和建

/proc/sys/net/core/rmem_default 指定接收套接字的缓冲区默认大小(默:124928)

/proc/sys/net/core/rmem_max 指定接收套接字的缓冲区的最大值(默:124928)

/proc/sys/net/core/wmem_default 指定发送套接字的缓冲区默认大小(默:124928)

/proc/sys/net/core/wmem_max 指定发送套接字的缓冲区的最大值(默:124928)

vim 在/etc/sysctl.d/local.conf

fs.file-max = 51200

net.core.rmem_max = 67108864

net.core.wmem_max = 67108864

net.core.rmem_default = 65536

net.core.wmem_default = 65536

net.core.netdev_max_backlog = 4096

net.core.somaxconn = 4096

net.ipv4.tcp_syncookies = 1

net.ipv4.tcp_tw_reuse = 1

net.ipv4.tcp_tw_recycle = 0

net.ipv4.tcp_fin_timeout = 30

net.ipv4.tcp_keepalive_time = 1200

net.ipv4.ip_local_port_range = 10000 65000

net.ipv4.tcp_max_syn_backlog = 4096

net.ipv4.tcp_max_tw_buckets = 5000

net.ipv4.tcp_fastopen = 3

net.ipv4.tcp_rmem = 4096 87380 67108864

net.ipv4.tcp_wmem = 4096 65536 67108864

net.ipv4.tcp_mtu_probing = 1

net.ipv4.tcp_congestion_control = hybla

sysctl --system

优化命令如下:

cat >>/etc/sysctl.conf<<EOF

net.core.wmem_dafault = 8388608

net.core.rmem_dafault = 8388608

net.core.wmem_max = 16777216

net.core.rmem_max = 16777216

EOF

sysctl -p

7 企业场景NFS共享存储优化小结

-

硬件:SAS/SSD硬盘,组RAID10,网卡千兆,多块网卡做bond

-

NFS服务端配置优化:

/目录 ip网段(rw,sync,all_squash,anonuid=65535,anongid=65534) -

NFS挂载客户端优化:

-o nosuid,noexec,nodev,noatime,nodiratime,intr,rsize=131072,wsize=131072 -

NFS服务器内核优化:命令见上面,要执行sysctl -p使配置生效

-

大型网站可用分布式文件系统替换NFS,Moosefs(mfs)和FastDFS适合小文件系统,GlusterFS适合大文件系统

如果卸载的时候提示

umount: /mnt: device is busy,需要退出挂载目录再进行挂载,如果是NFS server宕机了,则需要强制卸载,执行命令umount -lf /mnt

8 NFS系统的优缺点总结

优点:

1)简单,容易上手,容易掌握

2)数据直接可见,不想分布式文件系统数据不能直接看见

3)部署快速,维护简单方便且可控(满足要求的就是最好的)

4)可靠,数据可靠性高,经久耐用

5)服务非常稳定

缺点:

1)存在单点故障,可通过高负载和高可用方案弥补

2)大数据高并发下NFS效率和性能有限(但2千万/日PV以下都行,满足不了2千万那是架构太差)

3)FS数据是明文的,NFS本身不对数据完整性进行验证

4)多台客户机挂载一个NFS服务器时,连接管理维护麻烦,NFS服务器端出问题后,所有客户端都处于挂掉状态

5)耦合度高,一直存在连接,涉及同步(实时等待)和异步(解耦)概念,网站要尽量降低耦合度

建议:

对大中型网站(2000万/日PV以下)都有用武之地,在生产场景中,应该尽量多将数据访问往前退,将静态存储里面的资源通过CDN或缓存服务器提供服务,如果没有缓存服务或架构不好,存储服务器再多也扛不住,用户体验会很差,即使使用分布式文件系统也一样(CDN可以提供90-95%的数据访问服务,内存服务器3%,剩余的才是文件服务器提供的)

以上是关于NFS文件存储的主要内容,如果未能解决你的问题,请参考以下文章