Spark知识整理(未完待续)

Posted chengzipg

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Spark知识整理(未完待续)相关的知识,希望对你有一定的参考价值。

一、Spark支持的安装模式:

1、伪分布式(一台机器即可)

2、全分布式(至少需要3台机器)

二、Spark的安装配置

1、准备工作

- 安装Linux和JDK1.8

- 配置Linux:关闭防火墙、主机名、免密码登陆

2、安装部署Spark

- 解压:tar z-xvf spark-2.1.0-bin-hadoop2.7.tgz -C /root/trainning/

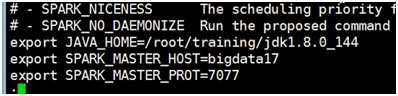

- 核心配置文件 :con/spark-env.sh (cp spark-env.sh.template spark-env.sh)

-

(伪分布式配置内容)

(伪分布式配置内容) - 启动:sbin/start-all.sh (出现Master和Worker进程)

- Web监控:http://hostname:8080

三、Spark执行工具

- spark-shell : 交互式命令工具

- spark-submit :应用程序提交工具

四、Spark运行模式和交互式Shell启动模式

1、local(本地模式)

单机运行,通常用于测试

- bin/spark-shell --master local (只启动一个executor)

- bin/spark-shell --master local[2] (启动2个executor)

- bin/spark-shell --master local[*] (启动跟cpu数目相同的executor)

2、standalone(独立模式)

独立运行在一个集群中

- bin/spark-shell --master spark://hostname:7077 (hostname可换成IP)

3、YARN/mesos

运行在资源管理器系统上,比如YARN说mesos

Spark on YARN存在两种模式 : yarn-client 和 yarn-cluster

- bin/spark-shell --master yarn-client

- bin/spark-shell --master yarn-cluster

以上是关于Spark知识整理(未完待续)的主要内容,如果未能解决你的问题,请参考以下文章