在pycharm上配置pyspark

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了在pycharm上配置pyspark相关的知识,希望对你有一定的参考价值。

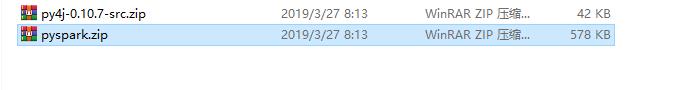

1、下载完spark,解压,我下载的是spark-2.4.1版本,在文件的 \\spark-2.4.1-bin-hadoop2.7\\python\\lib 中有两个文件

这两个文件之后会用到

2、由于使用了pyspark时from pyspark import SparkContext,需要下载py4j,直接pip即可

3、pycharm设置环境变量

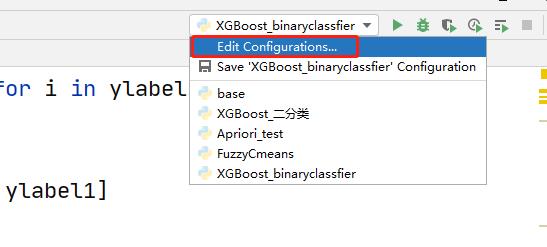

点击config

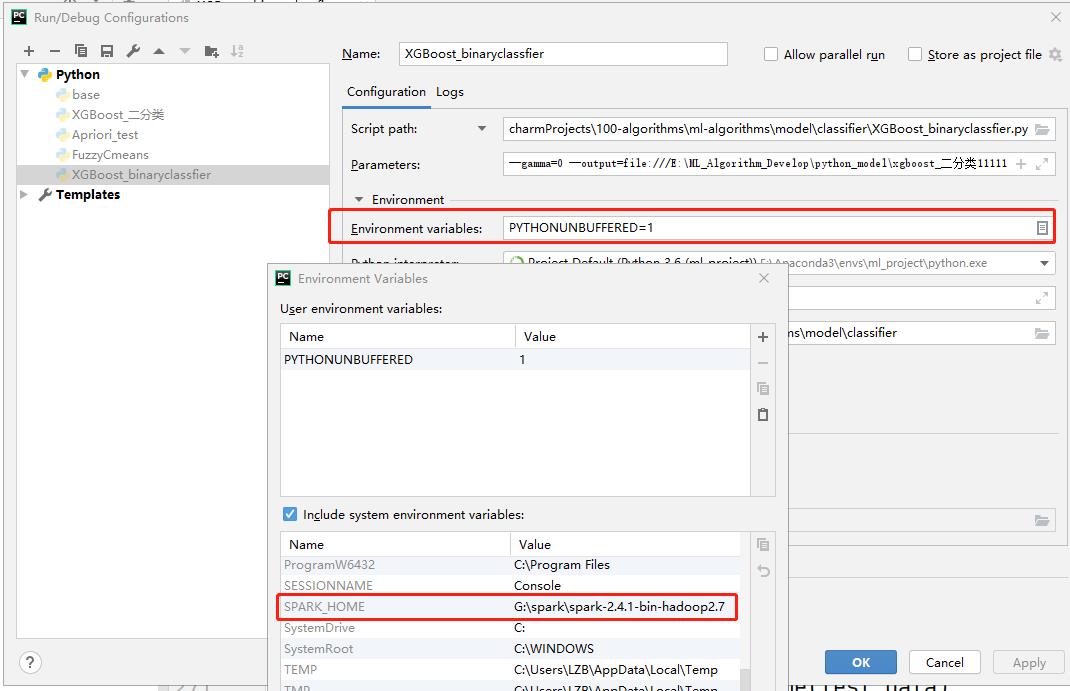

选择environment

创建环境变量,一个是SPARK_HOME,另外一个是PYTHONPATH,设置它们的values,SPARK_HOME的value是安装文件夹spark-2.1.1-bin-hadoop2.7的绝对路径,PYTHONPATH的value是该绝对路径/python,例如我的SPARK_HOME的value是G:\\spark\\spark-2.4.1-bin-hadoop2.7,那么我的PYTHONPATH的value是G:\\spark\\spark-2.4.1-bin-hadoop2.7\\python 。设置好了保存。(注意不管是路径的哪里,都不能有空格,尤其是结尾。)

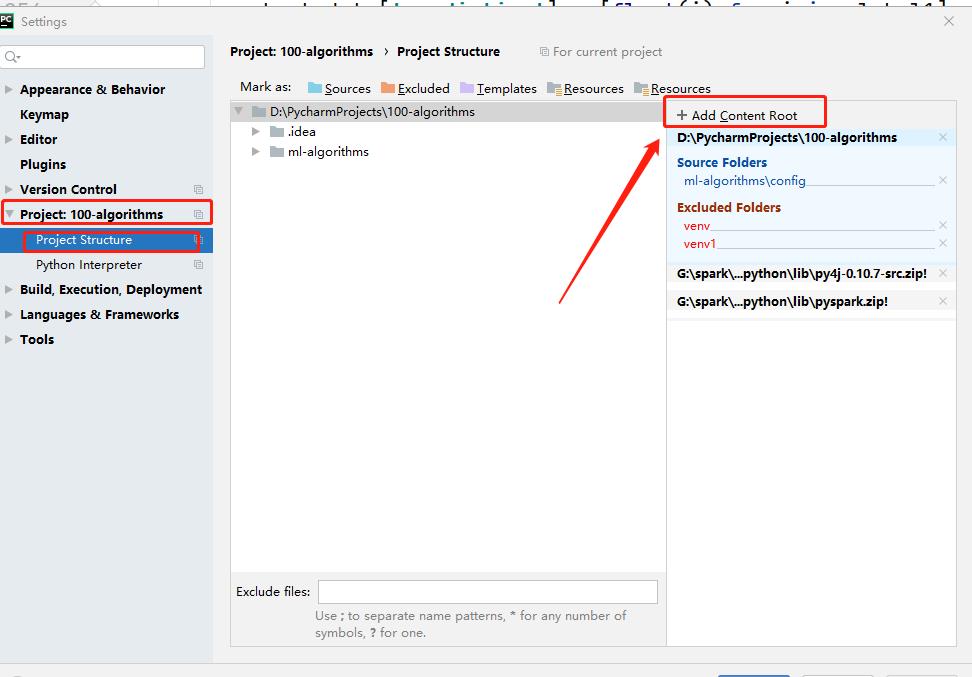

4、关键的一步,在setting中的project structure中点击右边的“add content root”,添加py4j-some-version.zip和pyspark.zip的路径(这两个文件都在Spark中的python文件夹下,上面提到过路径位置)

以上是关于在pycharm上配置pyspark的主要内容,如果未能解决你的问题,请参考以下文章