Python Celery初研究

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Python Celery初研究相关的知识,希望对你有一定的参考价值。

最近,换了一个工作环境去做研究,当然啦,新公司新作风,需要研究python并行分布式框架:Celery,不用多说,干呗。

然后就抽空看了一下,果然接口简单,开发容易,5分钟就写出了一个异步发送邮件的服务。

Celery本身不含消息服务,它使用第三方消息服务来传递任务,目前,Celery支持的消息服务有RabbitMQ、Redis甚至是数据库,当然Redis应该是最佳选择。

任务执行单元

Worker是Celery提供的任务执行的单元,worker并发的运行在分布式的系统节点中。

任务结果存储

Task result store用来存储Worker执行的任务的结果,Celery支持以不同方式存储任务的结果,包括AMQP, Redis,memcached, MongoDB,SQLAlchemy, Django ORM,Apache Cassandra, IronCache

另外, Celery还支持不同的并发和序列化的手段

并发

序列化

pickle, json, yaml, msgpack. zlib, bzip2 compression, Cryptographic message signing 等等

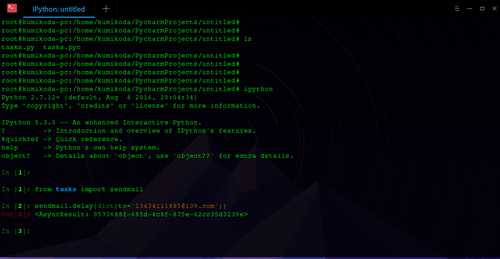

不废话,上初步研究的代码:

import sys reload(sys) import time from celery import Celery app = Celery(‘tasks‘, broker = ‘redis://localhost:6379/0‘) @app.task() def sendmail(mail): print(‘sending mail to %s...‘ % mail[‘to‘]) time.sleep(2.0) print(‘mail sent.‘)

我是直接连的redis。

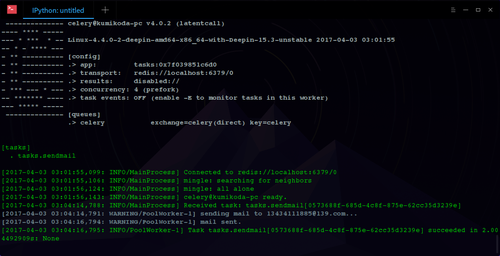

然后启动Celery处理任务:

celery -A tasks worker --loglevel=info

上面的命令行实际上启动的是Worker,如果要放到后台运行,可以扔给supervisor。

如何发送任务?非常简单:

可以看到,Celery的API设计真的非常简单。

然后,在Worker里就可以看到任务处理的消息:

这里我们可以发现,每一个task有一个唯一的ID,task异步执行在worker上。

Celery默认设置就能满足基本要求。Worker以Pool模式启动,默认大小为CPU核心数量,缺省序列化机制是pickle,但可以指定为json。由于Python调用UNIX/Linux程序实在太容易,所以,用Celery作为异步任务框架非常合适。

Celery还有一些高级用法,比如把多个任务组合成一个原子任务等,还有一个完善的监控接口,以后有空再继续研究。

本文出自 “Microsoft” 博客,请务必保留此出处http://1238306.blog.51cto.com/1228306/1912637

以上是关于Python Celery初研究的主要内容,如果未能解决你的问题,请参考以下文章