Python - 利用词云wordcloud,jieba和中国地图制作四大名著的热词图

Posted Johnthegreat

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Python - 利用词云wordcloud,jieba和中国地图制作四大名著的热词图相关的知识,希望对你有一定的参考价值。

热词图很酷炫,也非常适合热点事件,抓住重点,以图文结合的方式表现出来,很有冲击力。下面这段代码是制作热词图的,用到了以下技术:

jieba,把文本分词

wordcloud,制作热图

chardet,辨别文件的编码格式,其中中文统一为GB18030,更加的兼容

imageio,提取图片的形状

其他:自动识别文件编码,自动识别txt文件,图片文件名与txt文件一致,使用的是四大名著的文本(自行百度),部分中国地图

上代码:

import os

import jieba

import wordcloud

import chardet

import imageio

directory = "D:\\\\"

mask = imageio.imread(r"D:\\map.jpg") # 用于最后图像图形

directory_lists = os.scandir(directory)

for directory_list in directory_lists:

if directory_list.is_dir() or directory_list.path.split(\'.\')[-1] != "txt":

continue

with open(directory_list.path, \'rb\') as fd:

coding = chardet.detect(fd.read()[:1000])[\'encoding\']

if coding.upper() == \'GB2312\' or coding == \'GBK\':

coding = \'GB18030\'

file = open(directory_list.path, \'r\', encoding=coding)

text = file.read()

file.close()

jieba_text = \' \'.join(jieba.lcut(text))

w = wordcloud.WordCloud(height=800, width=1600, font_path=\'msyh.ttc\', background_color=\'white\', stopwords={\'Page\'}, mask=mask)

w.generate(jieba_text)

w.to_file(\'{}.png\'.format(directory_list.path.split(\'.\')[0]))

输出:

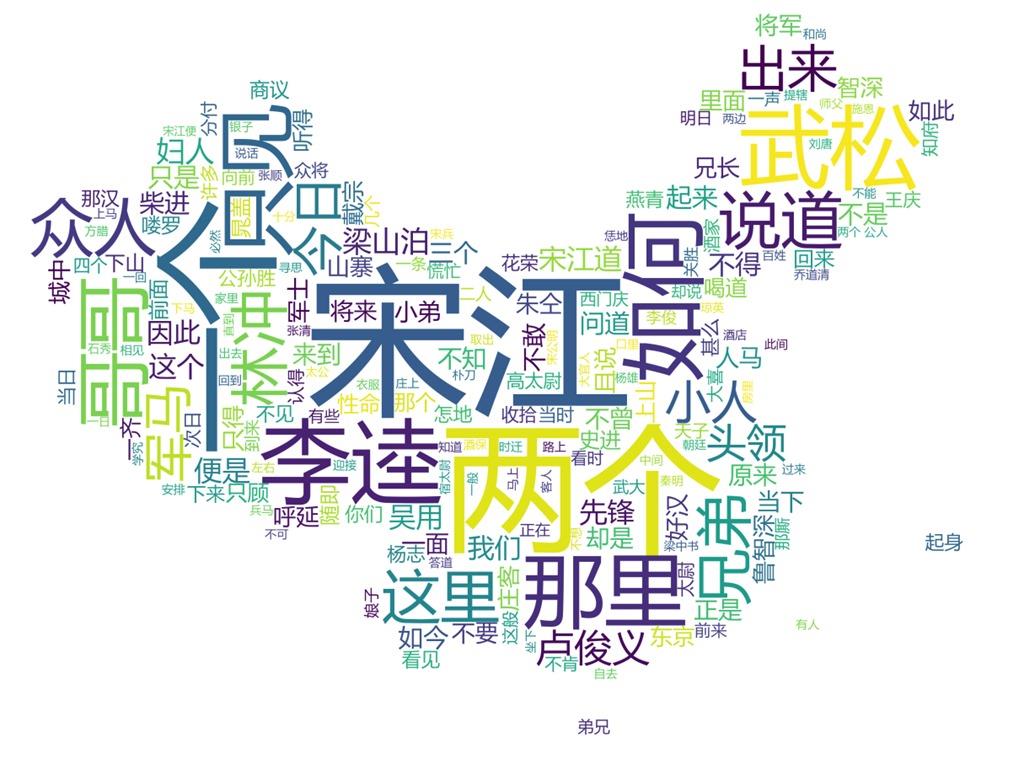

水浒传的如下

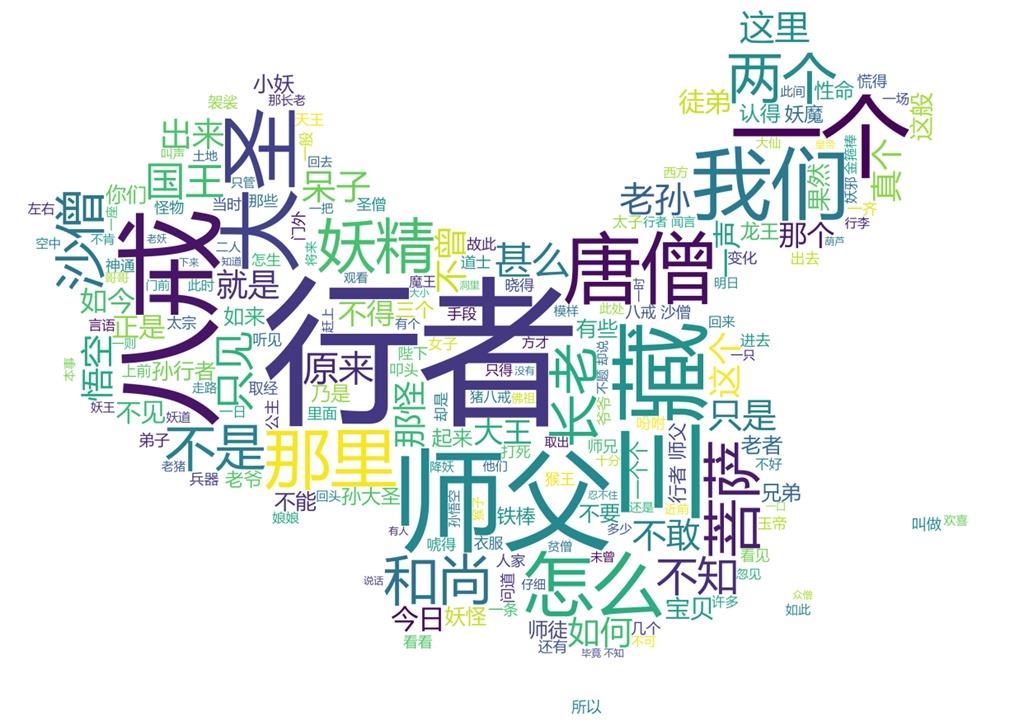

西游记的如下

仔细看输出的内容,还是挺有意思的,哈哈哈。

以上是关于Python - 利用词云wordcloud,jieba和中国地图制作四大名著的热词图的主要内容,如果未能解决你的问题,请参考以下文章