Dapper.Lite 背景介绍

Posted 0611163

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Dapper.Lite 背景介绍相关的知识,希望对你有一定的参考价值。

本人以前增删改查项目做的多,先是用ADO.NET+动软代码生成器,后来是NHibernate,再后来是各种DbHelper。我把各种DbHelper合成了一个DbHelper,后改名为LiteSql,后来觉得不如直接调用Dapper,于是有了Dapper.LiteSql。因为不想再维护两套,所以改名为Dapper.Lite,以后只维护这个。

5000多行代码,断断续续修改了很久,还是5000多行代码。并没有增加很多功能,我只希望它简单、稳定。

付出的时间代价非常大,让我觉得,业务程序员,是不应该造轮子的,所以下不为例。别看功能简单,要做到堪用很难,有很多测试项目。因为用户少,有些BUG只能自己发现,甚至是一些比较严重的BUG。

后面的维护计划,主要是修复BUG,提高质量。功能上保持稳定,尽量不做破坏性更改,可能也不会增加新功能。实现上,可能会做减法,减少不稳定因素。

NLPTransformer背景介绍

【NLP】Transformer背景介绍

1. Transformer的诞生

2018年10月,Google发出一篇论文《BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding》, BERT模型横空出世, 并横扫NLP领域11项任务的最佳成绩!

论文地址: https://arxiv.org/pdf/1810.04805.pdf

而在BERT中发挥重要作用的结构就是Transformer, 之后又相继出现XLNET,roBERT等模型击败了BERT,但是他们的核心没有变,仍然是:Transformer.

2. Transformer的优势

相比之前占领市场的LSTM和GRU模型,Transformer有两个显著的优势:

1, Transformer能够利用分布式GPU进行并行训练,提升模型训练效率.

2, 在分析预测更长的文本时, 捕捉间隔较长的语义关联效果更好.

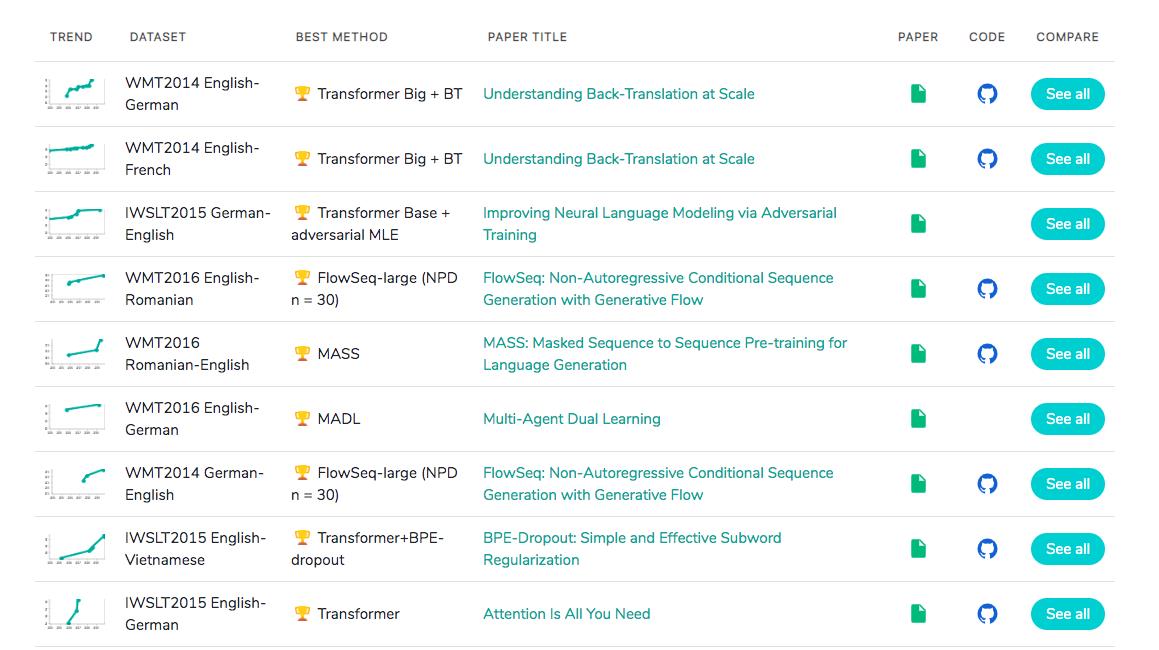

下面是一张在测评比较图:

3. Transformer的市场

在著名的SOTA机器翻译榜单上, 几乎所有排名靠前的模型都使用Transformer,

其基本上可以看作是工业界的风向标, 市场空间自然不必多说!

加油!

感谢!

努力!

以上是关于Dapper.Lite 背景介绍的主要内容,如果未能解决你的问题,请参考以下文章