如何打造营销闭环

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了如何打造营销闭环相关的知识,希望对你有一定的参考价值。

营销的闭环指的是将营销过程延伸到整个产品的生命周期(包括研发生产、广告传播、业务销售、售后服务等等),在消费者对产品进行消费的过程中不断给予营销,即在与用户的互动沟通中深度把握用户习惯和需求,以此来大大提高消费者对产品的认可度和忠诚度。

在过去,营销只是一个销售环节,在产品销售完成后,就会由后续的服务部门或代理商接手,消费者会在使用过程中逐渐淡化对该产品品牌的认可,客户忠诚度也会随时间推移而逐渐降低。而现在,闭环营销的产生在保持消费者对产品的高度认可和忠诚方面起了很大作用,它作为一种营销生态体系,早已成为了一种“以客户为中心”形成的组合营销策略。

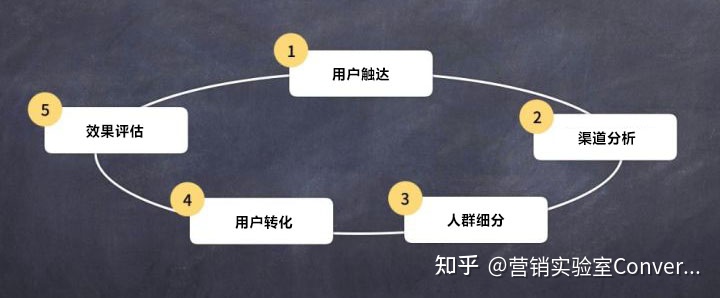

而对于营销闭环到底有几环,Convertlab倾向站在“以数据驱动营销闭环”的角度理解为有5环,用数据驱动则必须结合相对应的营销技术工具及手段来具体操作,这里我们一起说。

一、用户触达与数据采集

在整个营销活动中,用户触达是第一个,也是最为直接的一个动作,触达可以在很多平台上或通过很多手段(包括但不限于线下门店及自营或平台电商的交易接触/社交连接/官网/App/小程序及商品包装二维码扫描等)进行。所以,如果想快速广泛地把产品信息或活动内容推送下去,高效触达用户,只通过一个平台或只采取一种手段是不行的。

因此,尽可能全渠道地用各种方式接触消费者,采集到客户的第一手数据,是当前每个企业都渴望的事情。而全渠道就意味着会有海量数据在采集的过程中奔涌而来,通过各个通路也会使数据之间互相孤立、无法整合,呈现的面貌和后期分析的结果也会大有差别。

我们建议在用户触达的一开始就使用一体化客户数据平台(CDP),它可以通过放置埋点识别出客户是从哪个渠道来的,如果同一个客户从不同渠道进入系统,还可以自动对其身份进行辨别并加以合并,为后期数据分析客户行为提供完整并一致的客户洞察打下基础。另一方面,CDP作为企业第一方数据平台,可以完全为企业所用,任何数据调取、设置及查看都可以自行操作。

二、渠道分析与数据管理

在用户触达的同时或之后,运用渠道分析可以解决用户触达效率低、范围窄的问题。因为渠道分析的本质是要获取优质渠道,毕竟“流量少金多为水”,我们应该去找到那些最能带来收益的、最能节省获客成本的、优质客户最多的渠道。

打个比方,银行信用卡,它的App或产品并不是以注册用户多少来衡量用户是否有效的,因为只有持卡客户才会持续使用这个产品并不断创造收益。因此,在这个营销过程中,我们不能用App安装下载量和用户注册量来简单判断这个用户是不是有效,这个获客渠道是不是优质,更重要的是我们要通过对数据的提炼 找到最终关键步骤,即绑卡客户是从哪个渠道来,绑了卡的每一个客户都是在什么样的场景或出于什么样的动机和需要才产生了绑卡的行为。与此同时,我们也可以重点关注那些转换率高的、成本低的渠道,这也是最优渠道之一。

三、人群细化与数据分析

面对当前的消费者行为剧变,我们需要有更好、更有效的方法能够快速识别那些高价值人群。

对于零售品牌来说,找到潜在的高价值客户标志着营销已经成功了一半,比如,一个历史消费能力较高的用户,在搜索了商品后并没有购买,但他已经符合潜在高价值用户的特征,于是我们就可以针对他或者有相同特征的一群人以往的搜索和购买偏好与习惯,来设计不同的营销创意内容或活动,从而对这一部分人进行个性化的精准营销。

这个环节我们需要根据不同客户的不同特征(如基础的客户档案、多种身份、特征标签、消费/互动记录等),多维度合力对客户进行360°画像。在完成画像之后,就可以进行客群的分层分群(Segmentation),用以完成所有的数据分析洞察和精准营销工作。

选择细分能力强大和灵活,可以任意筛选并进行多级组合的DM hub系统,可以进一步针对客户真实的消费行为,以及用户与企业交互过程中产生的非消费行为数据进行分析,了解到客户的购买力、购买习惯、商品或服务的偏好、基于历史消费行为进行预测,以及通过分类、加工和分析形成客户洞察,从而引导消费转化,或比较相同类别人群的消费和非消费特征,以形成新的洞察(如发现高潜力的潜在高消费人群)。

Tips:用户画像构建的原则

对用户画像进行数据建模,应该结合客户实际的需求,找出相关的数据实体,以数据实体为中心规约数据维度类型和关联关系,形成符合客户实际情况的建模体系;对于维度分解,必须要以用户、行为、交易三类数据实体为中心,进行数据维度的分解和列举,根据相关性原则,选取和战略目的相关的数据维度,以此来避免产生过多无用数据干扰分析过程;针对不同角色人员的需求(如市场、销售、研发等),也要去设计适合各角色人员在用户画像工具中的使用功能和应用/操作流程。

四、用户转化与数据运营

对于用户转化这一环,最关键的还要看运营。当我们了解了用户行为偏好的时候,我们就能知道用户到了付费交易的节点上,最需要的是什么,又或者什么能刺激他们马上付款,以此来优化客户体验,提高他们的转化。还是以零售品牌来说,我们应该尽可能地将电商网站和线上体验简洁化、快速化且使用户有一个友好舒适的使用体验,运用平台规则并制定全渠道零售策略以提供最佳的会员营销体验,使用营销和运营工具来构建功能丰富的购物交互系统,也可以推动更多的在线流量转化为销售业绩。

另一方面,利用营销技术建立个性化的客户旅程(Customer Journey)以与客户建立牢固的关系,使用回馈更及时、使用更灵活、数据更直观的一体化营销云 平台,也有助于提升转化。在全面部署CDP客户数据平台并获取第一方实时数据后,进行Look alike广告增量,零售品牌可以为正在转化的细分受众群创建自动化内容,通过定制和个性化使其变得更加多样,对商品和用户进行区分,使用可定制的引擎,并根据用户细分出的需求特征或级别提供与之相对应的价格、内容和服务,这样的“千人千面”智能化、个性化营销也会增强用户转化并提升客户满意度和忠诚度。

五、效果评估与数据反馈

效果评估是建立闭环很关键的一步,通过闭环可以对整个营销活动效果进行分析,以此去提升每一次的营销效果。“以数据驱动营销闭环”并产生增长的核心,就是通过制定一个营销策略,执行下去,再利用回收数据反馈分析效果,以此查看到整个营销活动中哪里出现问题,逐步迭代优化,从而使营销效果越来越好。

从用户触达、渠道分析、人群细分、运营转化以及最终的营销效果反馈,营销的闭环一直都是“以始为终、以终为始”,环环相扣且互为助力,而这一切产生的目的也只有一个,那就是为了致力打造更好,能够更有效帮助企业最大限度挖掘用户价值的方法,从而去持续促进业务的增长。

自动驾驶的Pipline -- 如何打造自动驾驶的数据闭环?(中)

转载自

https://zhuanlan.zhihu.com/p/391629717

三篇文章全集:

2 云计算平台的基建和大数据处理技术

数据闭环需要一个云计算/边缘计算平台和大数据的处理技术,这个不可能在单车或单机实现的。大数据云计算发展多年,在资源管理调度、数据批处理/流处理、工作流管理、分布式计算、系统状态监控和数据库存储等方面提供了数据闭环的基础设施支持,比如亚马逊AWS、微软Azure和谷歌云等。

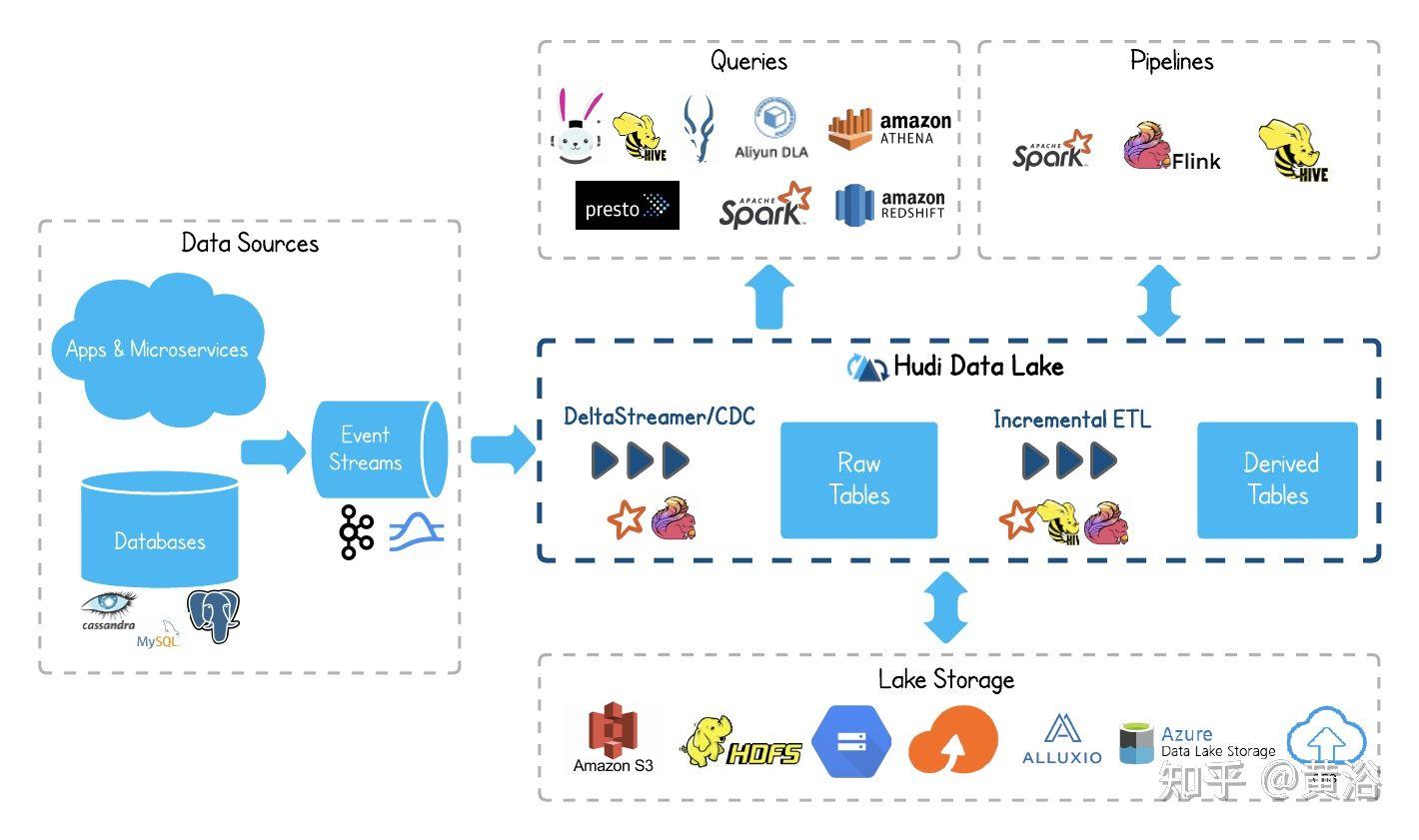

Amazon Elastic Compute Cloud(EC2)是亚马逊云服务AWS的一部分,而Amazon Elastic MapReduce(EMR) 是其大数据云平台,可使用多种开放源代码工具处理大量数据,例如数据流处理Apache Spark、数据仓库Apache Hive和Apache HBase、数据流处理Apache Flink、数据湖Apache Hudi和大数据分布式SQL查询引擎Presto。

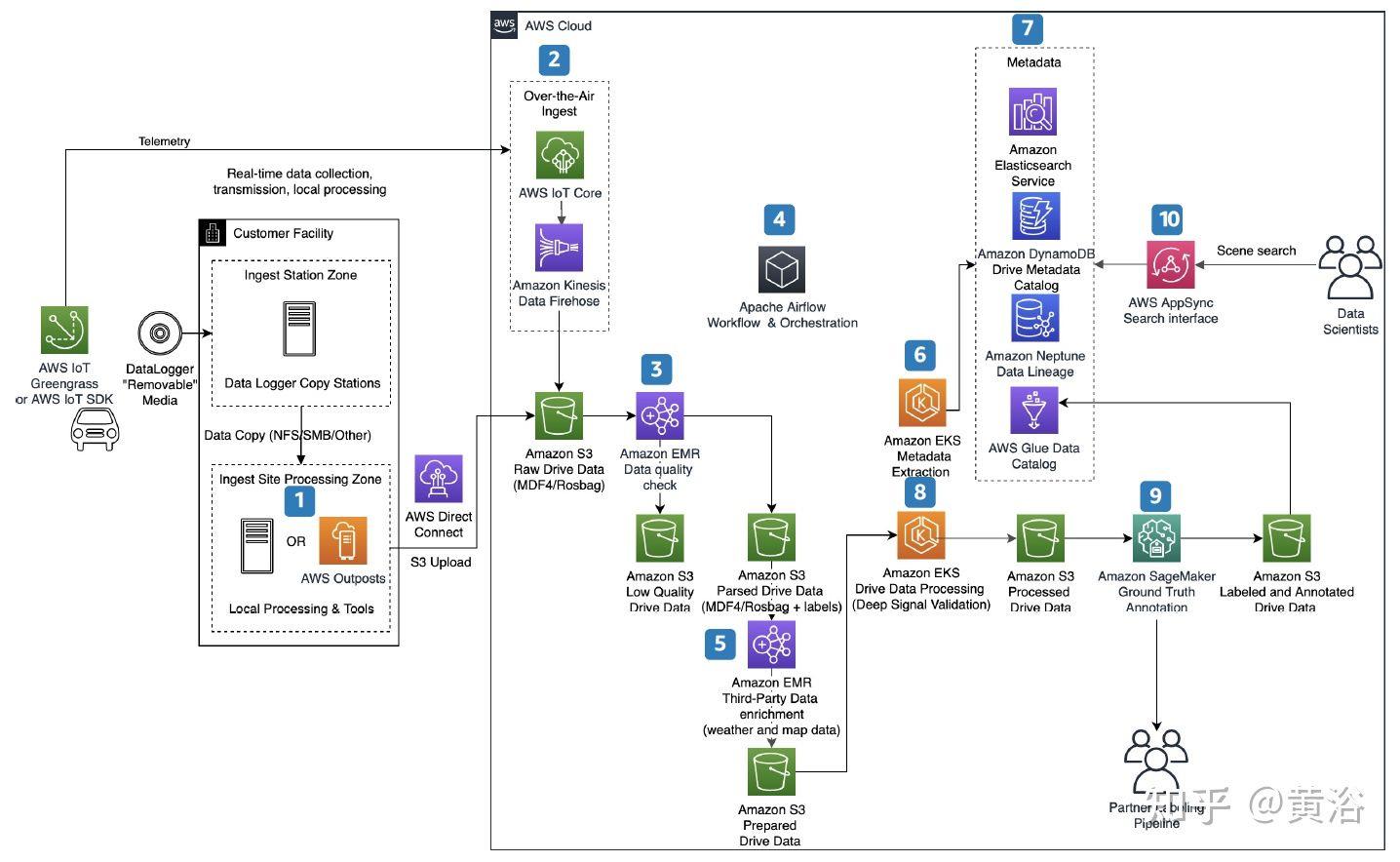

下图是亚马逊云AWS提供的自动驾驶数据处理服务平台例子:其中标明1-10个任务环节

- 使用 AWS Outposts (运行本地 AWS 基础设施和服务)从车队中提取数据以进行本地数据处理。

- 使用 AWS IoT Core (将 IoT 设备连接到 AWS 云,而无需配置或管理服务器)和 Amazon Kinesis Data Firehose (将流数据加载到数据湖、数据存储和分析服务中)实时提取车辆T-box数据,该服务可以捕获和转换流数据并将其传输给 Amazon S3(AWS全球数据存储服务)、Amazon Redshift(用标准 SQL 在数据仓库、运营数据库和数据湖中查询和合并 EB 级结构化和半结构化数据)、Amazon Elasticsearch Service(部署、保护和运行 Elasticsearch,是一种在 Apache Lucene 上构建的开源 RESTful 分布式搜索和分析引擎)、通用 HTTP 终端节点和服务提供商(如 Datadog、New Relic、MongoDB 和 Splunk),这里Amazon Kinesis 提供的功能Data Analytics, 可通过 SQL 或 Apache Flink (开源的统一流处理和批处理框架,其核心是分布流处理数据引擎)的实时处理数据流。

- 删除和转换低质量数据。

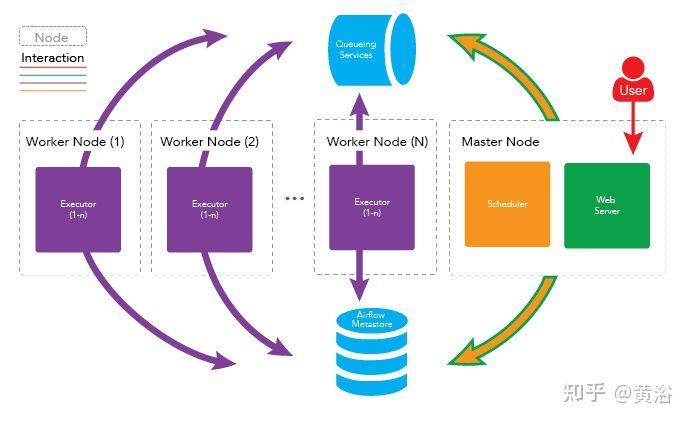

- 使用 Apache Airflow (开源工作流管理工具)安排提取、转换和加载 (ETL) 作业。

- 基于 GPS 位置和时间戳,附加天气条件来丰富数据。

- 使用 ASAM OpenSCENARIO (一种驾驶和交通模拟器的动态内容文件格式)提取元数据,并存储在Amazon DynamoDB (NoSQL 数据库服务)和 Amazon Elasticsearch Service中。

- 在 Amazon Neptune (图形数据库服务,用于构建查询以有效地导航高度互连数据集)存储数据序列,并且使用 AWS Glue Data Catalog(管理ETL服务的AWS Glue提供数据目录功能)对数据建立目录。

- 处理驾驶数据并深度验证信号。

- 使用 Amazon SageMaker Ground Truth (构建训练数据集的标记工具用于机器学习,包括 3D 点云、视频、图像和文本)执行自动数据标记,而Amazon SageMaker 整合ML功能集,提供基于 Web 的统一可视化界面,帮助数据科学家和开发人员快速准备、构建、训练和部署高质量的机器学习 (ML) 模型。

- AWS AppSync 通过处理与 AWS DynamoDB、AWS Lambda(事件驱动、自动管理代码运行资源的计算服务平台) 等数据源之间连接任务来简化数据查询/操作GraphQL API 的开发,在此使用是为特定场景提供搜索功能。

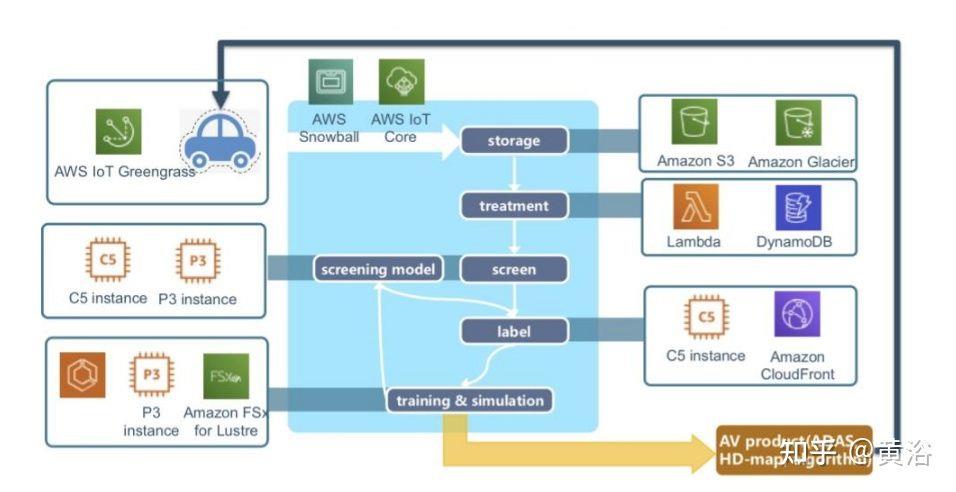

下图是AWS给出的一个自动驾驶数据流水线框架:数据收集、注入和存储、模型训练和部署;其中Snowball是AWS的边缘计算系列之一,负责车辆和AWS S3之间的数据传输; 其他还有两个,是AWS Snowcone和 AWS Snowmobile。

可以看到,AWS使用了数据存储S3、数据传输Snowball、数据库DynamoDB、数据流处理Flink和Spark、搜索引擎Elasticsearch、工作流管理Apache Airflow和机器学习开发平台SageMaker等。

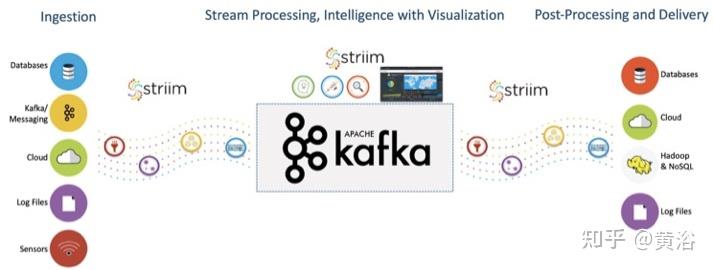

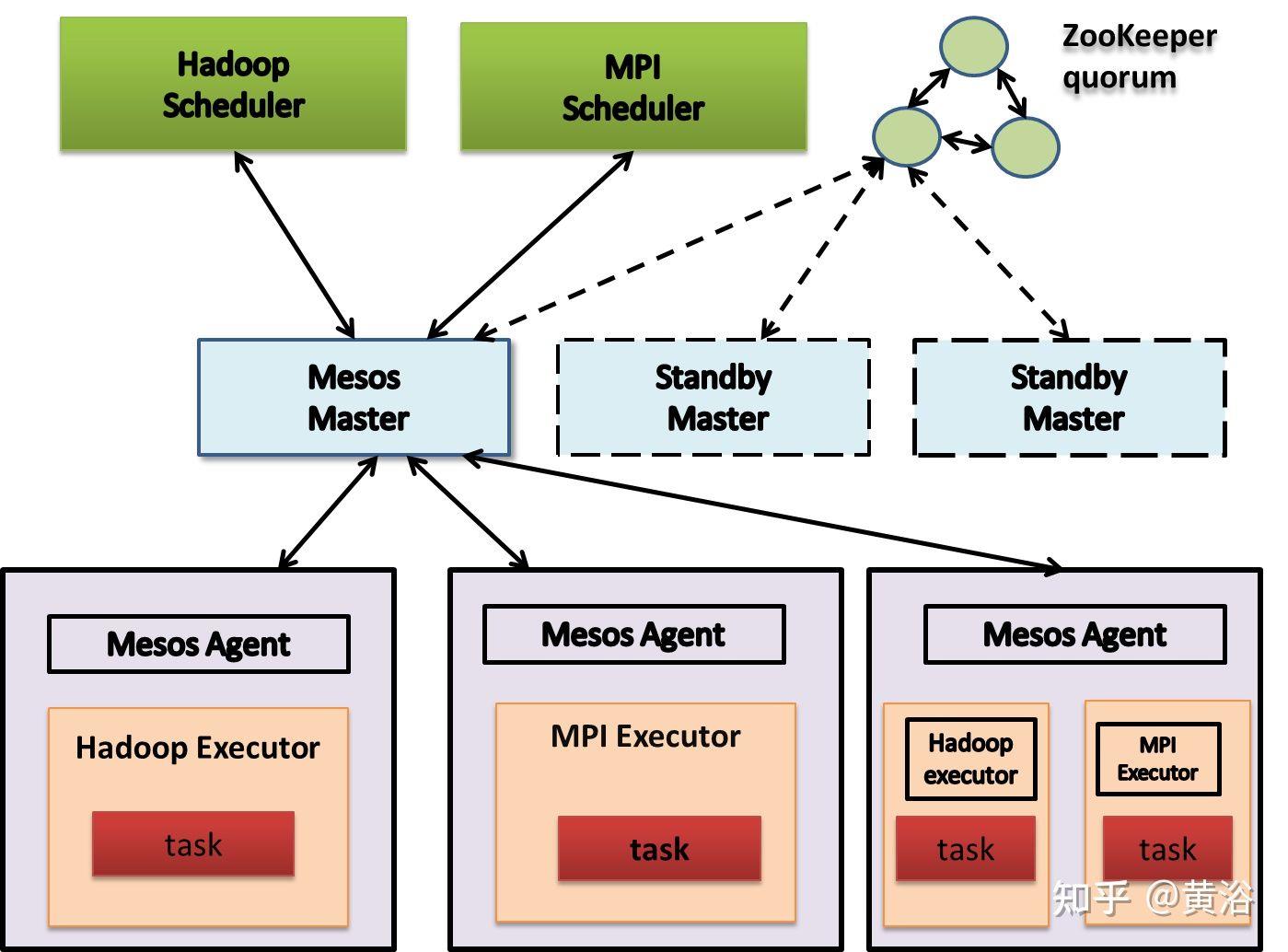

其他开源的使用,比如流处理的实时数据馈送平台Apache Kafka、资源管理&调度Apache Mesos和分布NoSQL数据库Apache Cassandra。

如图是国内自动驾驶公司Momenta基于亚马逊AWS建立的系统架构实例图:

其中AWS IoT Greengrass 提供边缘计算及机器学习推理功能,可以实时处理车辆中的本地规则和事件,同时最大限度地降低向云传输数据的成本。

其中P3实例和C5实例是Amazon EC2提供的。Amazon CloudFront是AWS的CDN,Amazon Glacier是在线文件存储服务,而Amazon FSx for Lustre 是可扩展的高性能文件存储系统。

除此之外,亚马逊指出的,Momenta采用的AWS服务还包括:监控可观测性服务Amazon CloudWatch、关系数据库Amazon Relational Database Service (Amazon RDS)、实时流数据处理和分析服务Amazon Kinesis(包括Video Streams、Data Streams、Data Firehose和Data Analytics)和消息队列服务Amazon Simple Queue Service (Amazon SQS)等。

最近Momenta还采用Amazon Elastic Kubernetes Service (EKS) 运行容器Kubernetes。此外亚马逊也推荐了Kubernetes服务,AWS Fargate。

Apache Kafka

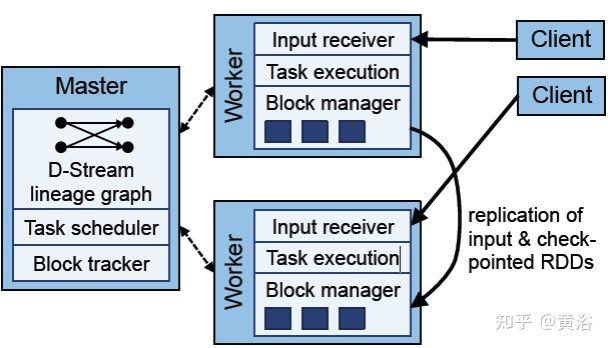

Apache Spark

Apache Flink

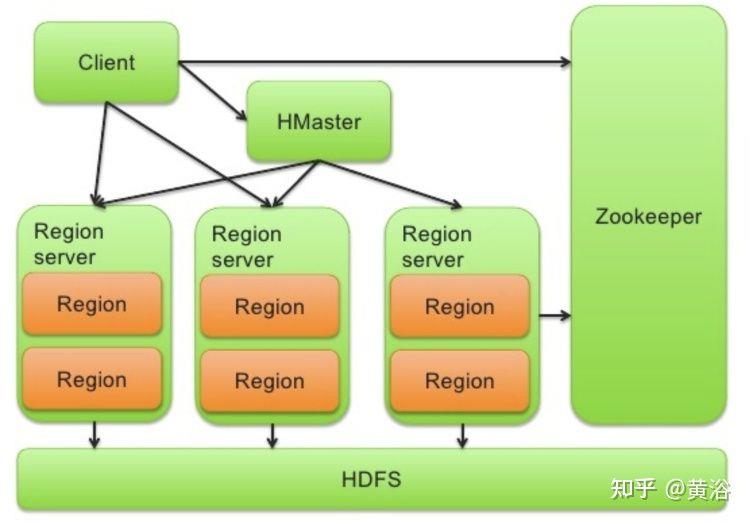

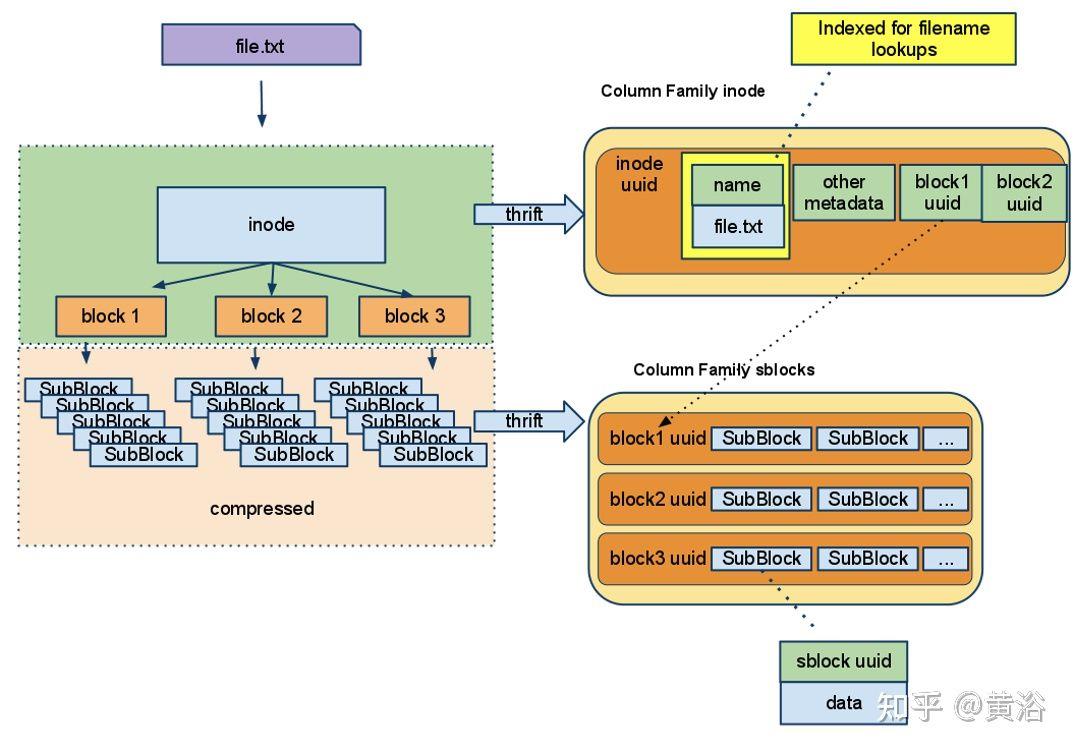

Apache HBase

Apache Cassandra

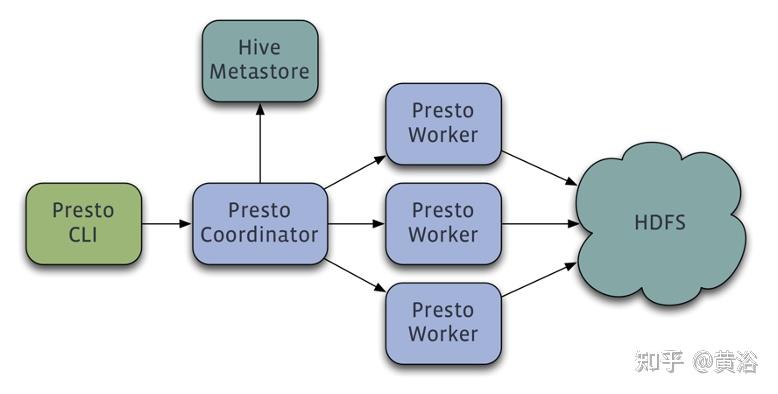

Presto

Apache Hudi

Apache Airflow

Apache Mesos

Kubernetes

3 训练数据标注工具

其实AWS的机器学习平台本身也提供了数据标注工具Amazon SageMaker Ground Truth。

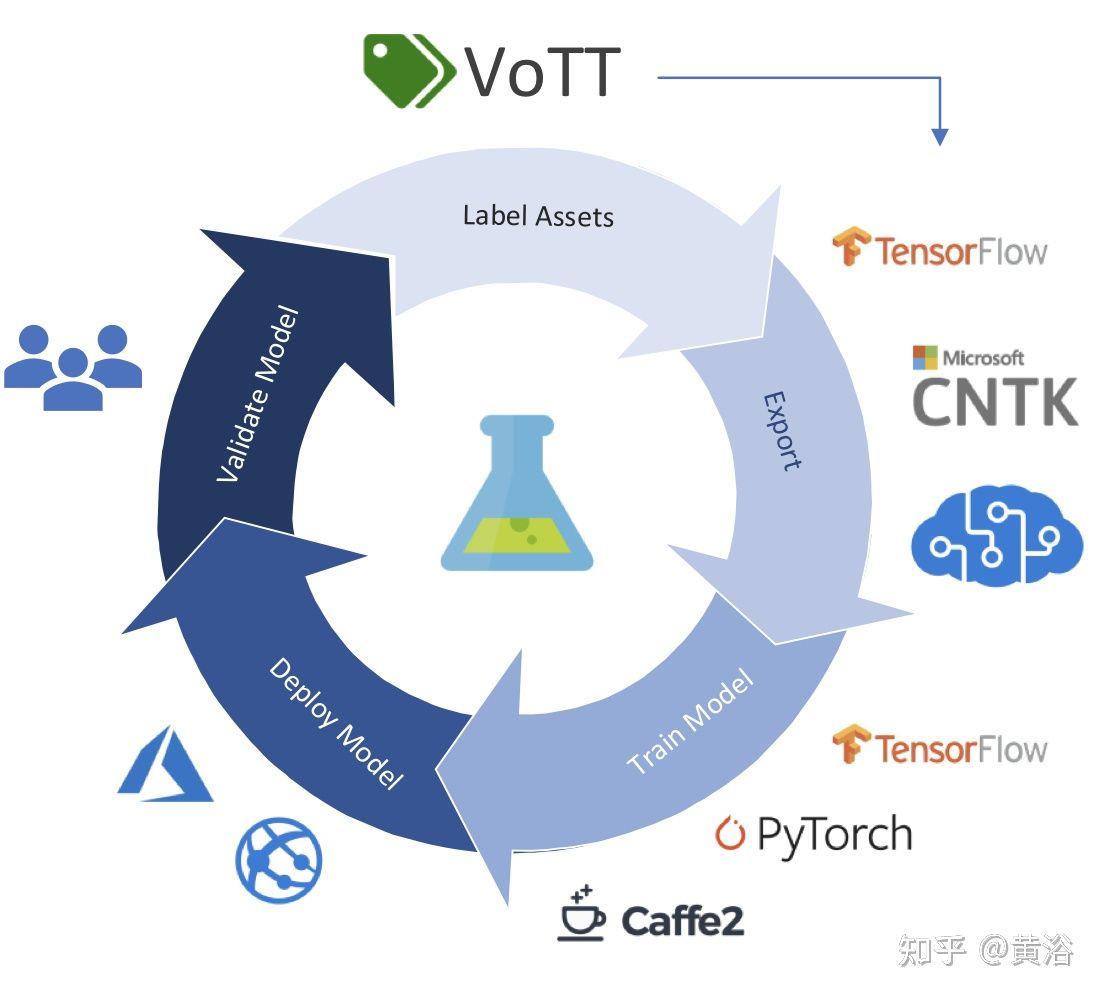

如图是微软开源标注工具VOTT(Video Object Tagging Tool):

https://github.com/Microsoft/VoTT/

标注工具可以是全自动、半自动和手工等3类。

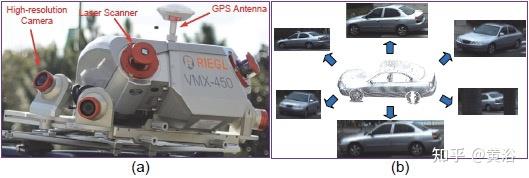

比如人工标注工具:摄像头图像LabelMe和激光雷达点云PCAT

还有半自动标注工具:摄像头CVAT、VATIC,激光雷达3D BAT、SAnE,图像点云融合Latte

自动标注工具:基本没有开源(商用也没有吧)的工具可用。

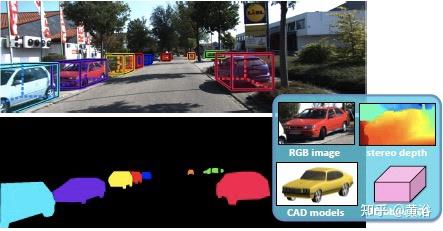

这里有一些自动标注方面的论文:

- “Beat the MTurkers: Automatic Image Labeling from Weak 3D Supervision“

- “Auto-Annotation of 3D Objects via ImageNet“

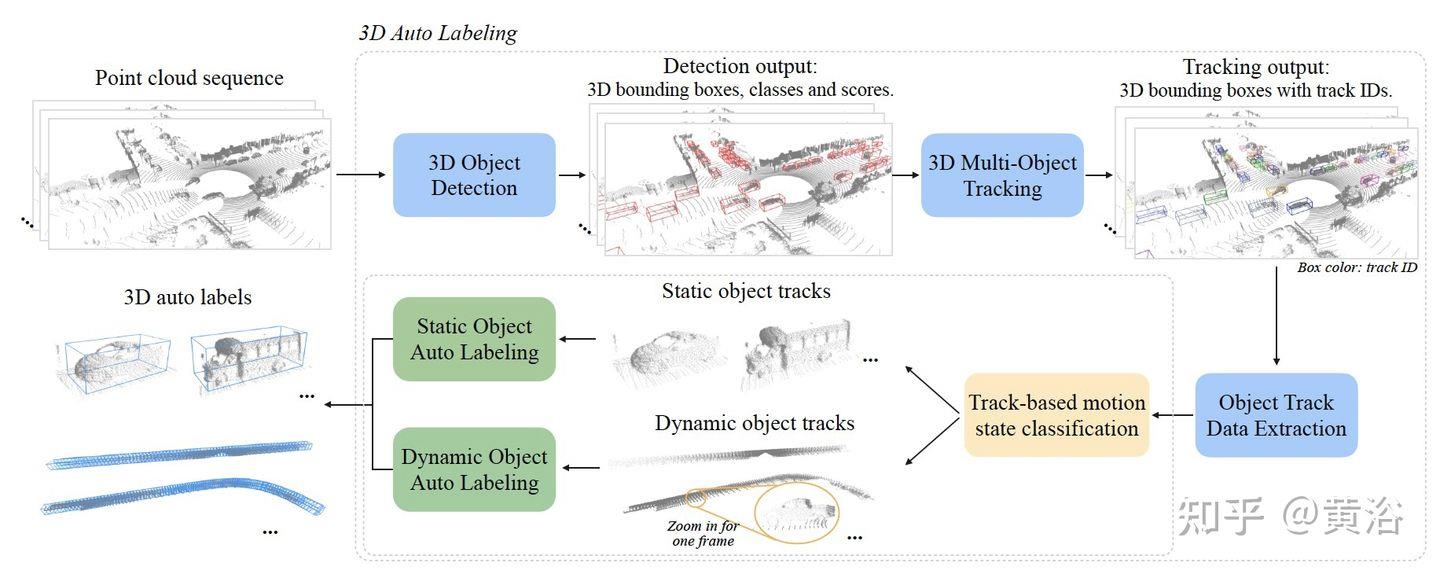

“Offboard 3D Object Detection from Point Cloud Sequences“

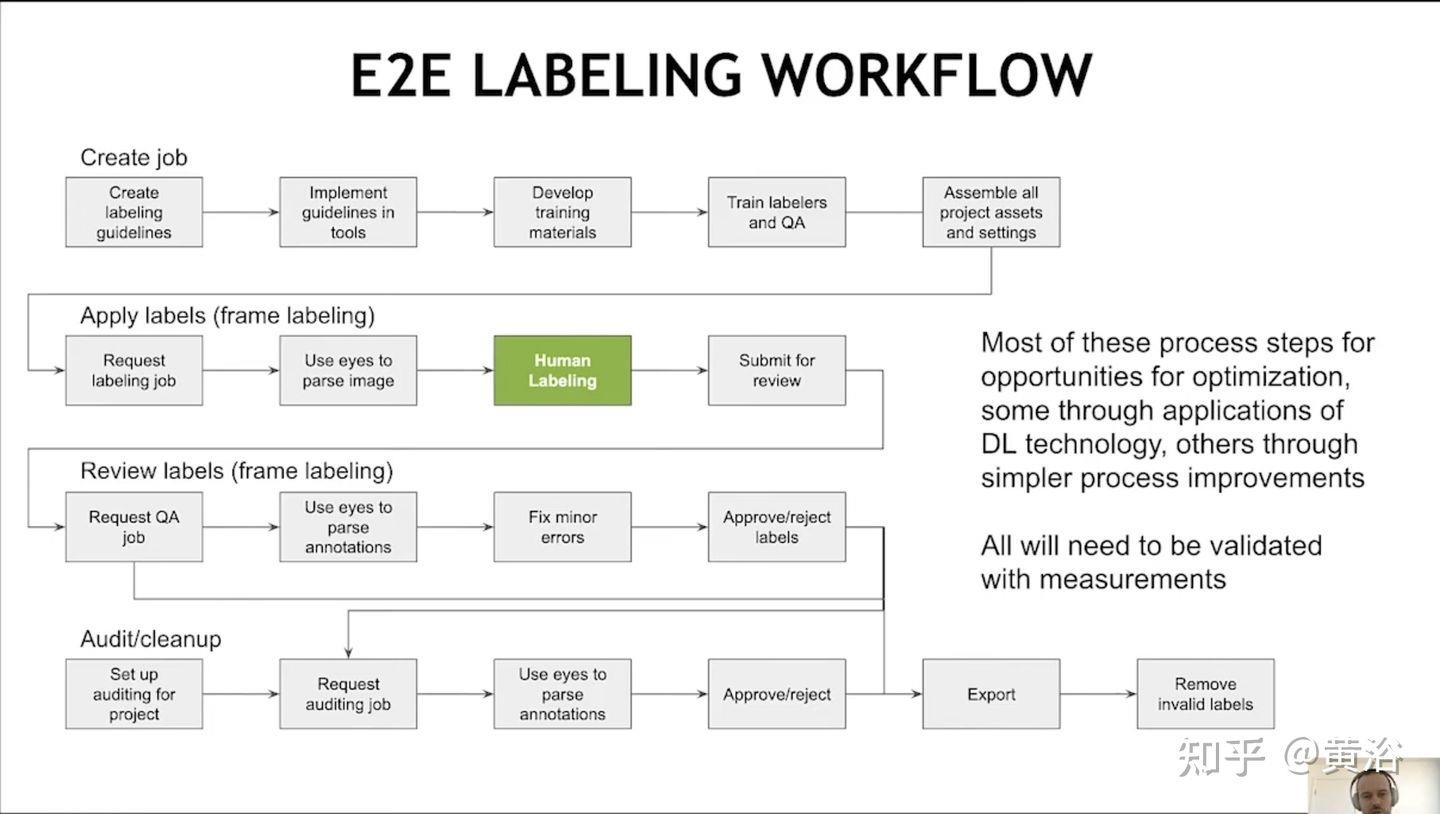

这里是Nvidia在会议报告中给出的端到端标注流水线:它需要人工介入

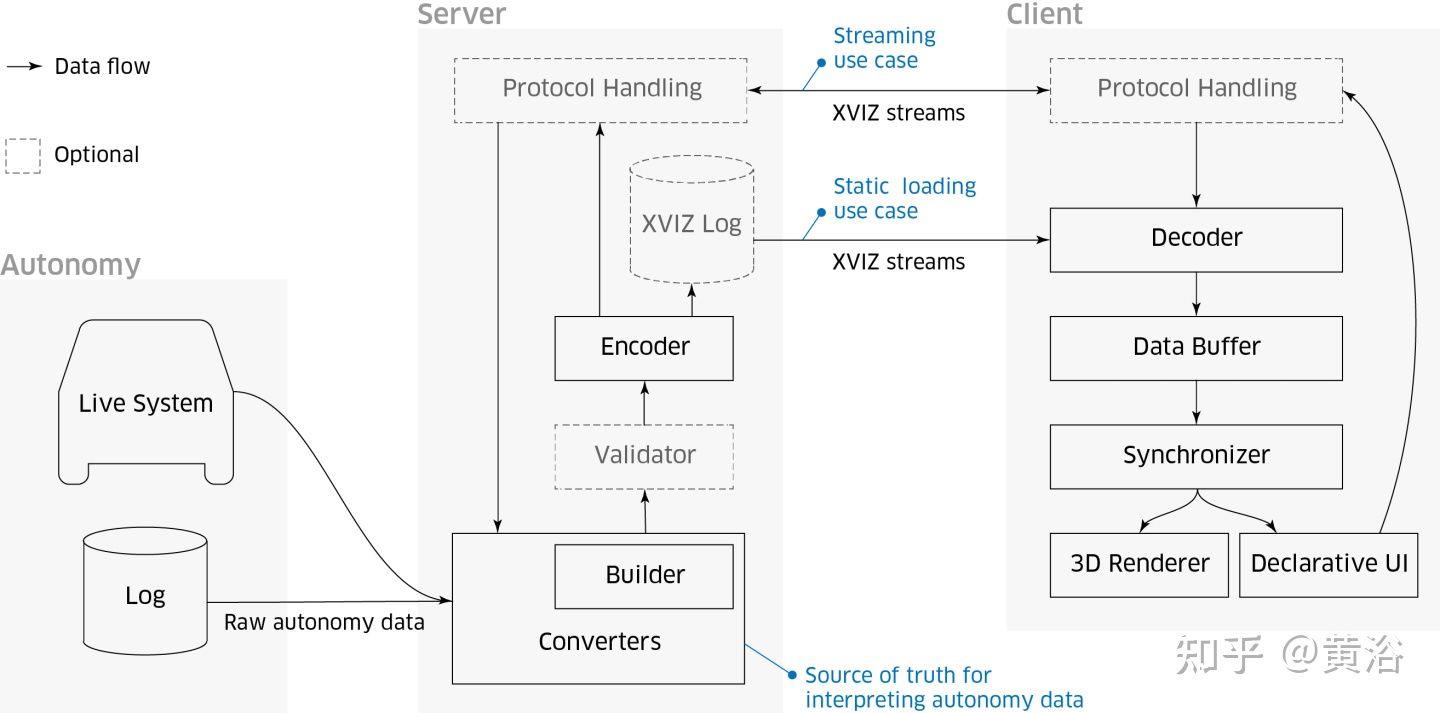

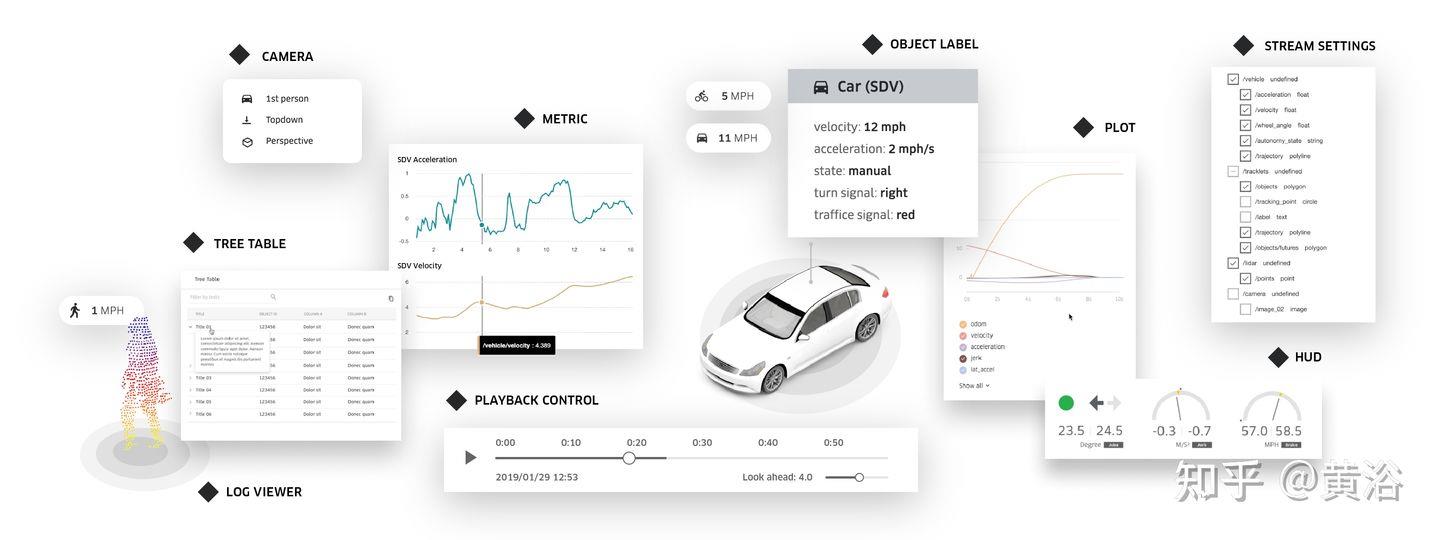

在这里顺便提一下“数据可视化”的问题,各种传感器数据除了标注,还需要一个重放、观察和调试的平台。如图是Uber提供的开源可视化工具 Autonomous Visualization System (AVS):

https://avs.auto/#/

其中”XVIZ“是提出的自动驾驶数据实时传输和可视化协议:

另外,“streetscape.gl“是一个可视化工具包,在XVIZ 协议编码自动驾驶和机器人数据。 它提供了一组可组合的 React 组件,对 XVIZ 数据进行可视化和交互。

4 大型模型训练平台

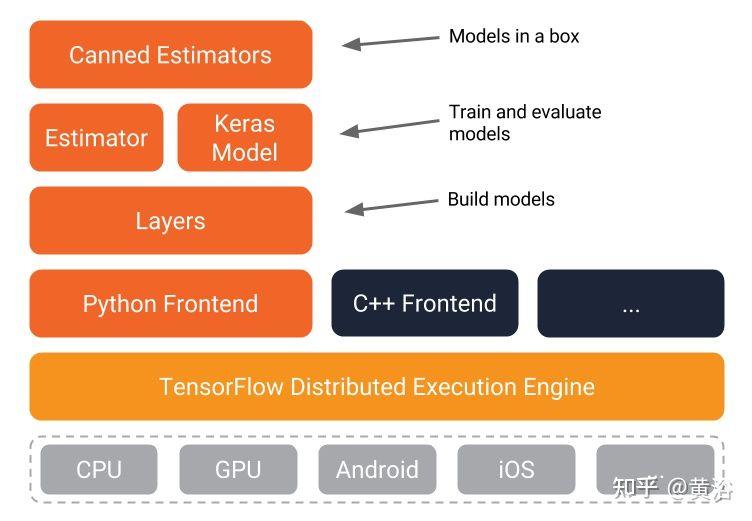

模型训练平台,主要是机器学习(深度学习)而言,前面亚马逊AWS提供了自己的ML平台SageMaker。我们知道最早有开源的软件Caffe,目前最流行的是Tensorflow和Pytorch(Caffe2并入)。

Tensorflow

Pytorch

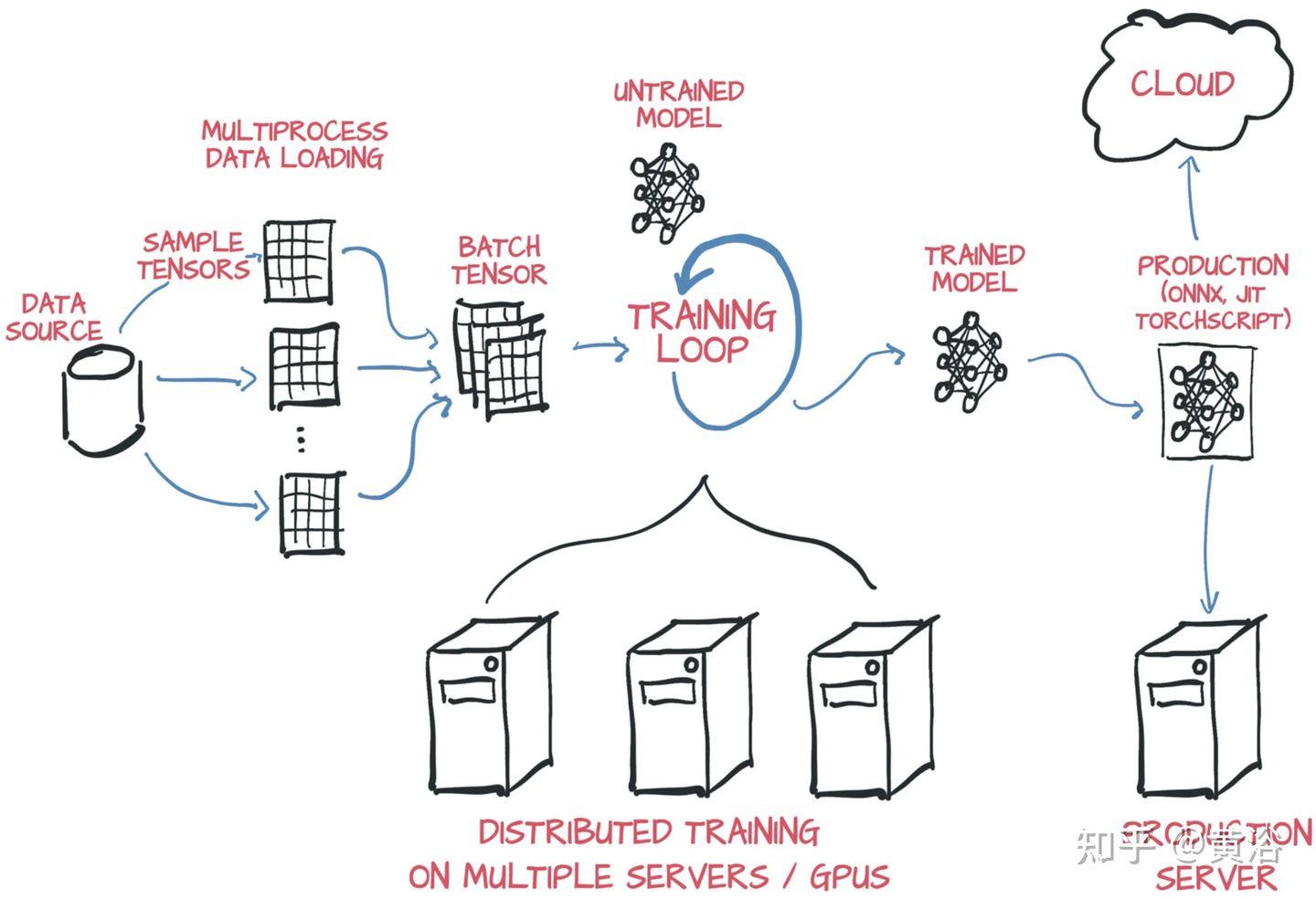

在云平台部署深度学习模型训练,一般采用分布式。按照并行方式,分布式训练一般分为数据并行和模型并行两种。当然,也可采用数据并行和模型并行的混合。

模型并行:不同GPU负责网络模型的不同部分。例如,不同网络层被分配到不同的GPU,或者同一层不同参数被分配到不同GPU。

数据并行:不同GPU有模型的多个副本,每个GPU分配不同的数据,将所有GPU计算结果按照某种方式合并。

模型并行不常用,而数据并行涉及各个GPU之间如何同步模型参数,分为同步更新和异步更新。同步更新等所有GPU的梯度计算完成,再计算新权值,同步新值后,再进行下一轮计算。异步更新是每个GPU梯度计算完无需等待,立即更新权值,然后同步新值进行下一轮计算。

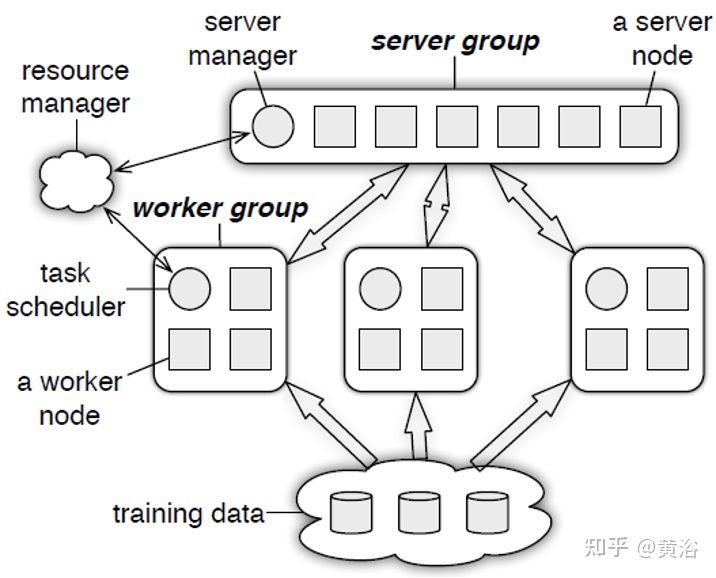

分布式训练系统包括两种架构:Parameter Server Architecture(PS,参数服务器)和Ring -AllReduce Architecture(环-全归约)。

如下图是PS结构图:

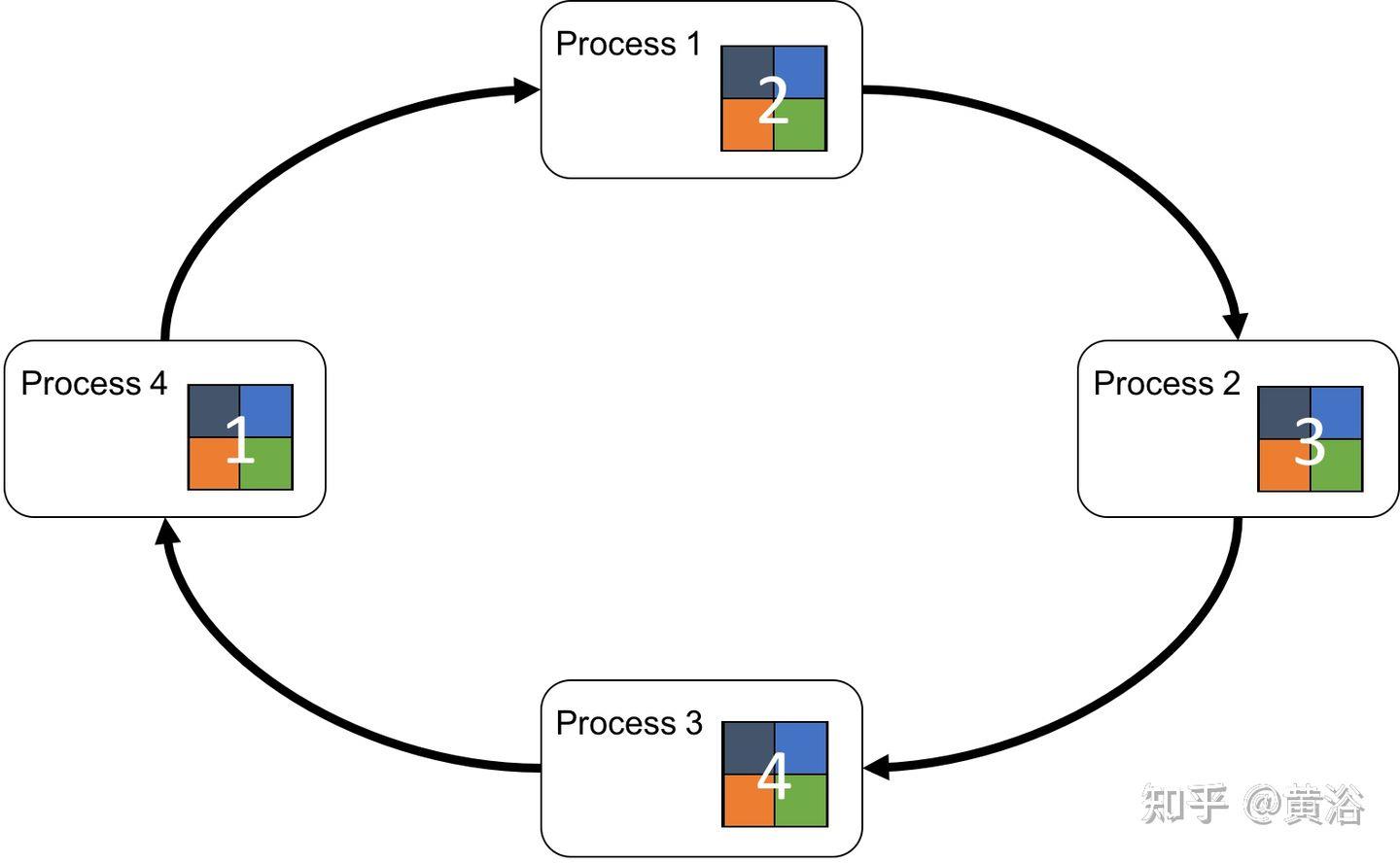

这个图是Ring AllReduce的架构图:

Pytorch现在和多个云平台建立合作关系,可以安装使用。比如AWS,在AWS Deep Learning AMIs、AWS Deep Learning Containers和Amazon SageMaker,都可以训练Pytorch模型,最后采用TorchServe进行部署。

Pytorch提供两种方法在多GPU平台切分模型和数据:

- DataParallel: DataParallel更易于使用。不过,通信是瓶颈,GPU利用率通常很低,而且不支持分布式。

- distributedataparallel: DistributedDataParallel支持模型并行和多进程,单机/多机都可以,是分布训练。

PyTorch 自身提供几种加速分布数据并行的训练优化技术,如 bucketing gradients、overlapping computation with communication 以及 skipping gradient synchronization 等。

Tensorflow在模型设计和训练使用也方便,可以使用高阶 Keras API;对于大型机器学习训练任务,使用 Distribution Strategy API 在不同的硬件配置上进行分布式训练,而无需更改模型定义。

其中Estimator API 用于编写分布式训练代码,允许自定义模型结构、损失函数、优化方法以及如何进行训练、评估和导出等内容,同时屏蔽与底层硬件设备、分布式网络数据传输等相关的细节。

- tf.distribute.MirroredStrategy支持在一台机器的多个 GPU 上进行同步分布式训练。该策略会为每个 GPU 设备创建一个副本。模型中的每个变量都会在所有副本之间进行镜像。这些变量将共同形成一个名为MirroredVariable的单个概念变量。这些变量会通过应用相同的更新彼此保持同步。

- tf.distribute.experimental.MultiWorkerMirroredStrategy与MirroredStrategy非常相似。它实现了跨多个工作进程的同步分布式训练,而每个工作进程可能有多个 GPU。与MirroredStrategy类似,它也会跨所有工作进程在每个设备的模型中创建所有变量的副本。

- tf.distribute.experimental.ParameterServerStrategy支持在多台机器上进行参数服务器PS训练。在此设置中,有些机器会被指定为工作进程,有些会被指定为参数服务器。模型的每个变量都会被放在参数服务器上。计算会被复制到所有工作进程的所有 GPU 中。(注:该策略仅适用于 Estimator API。)

5 模型测试和检验

模型的测试和检验可以分成多种方式:

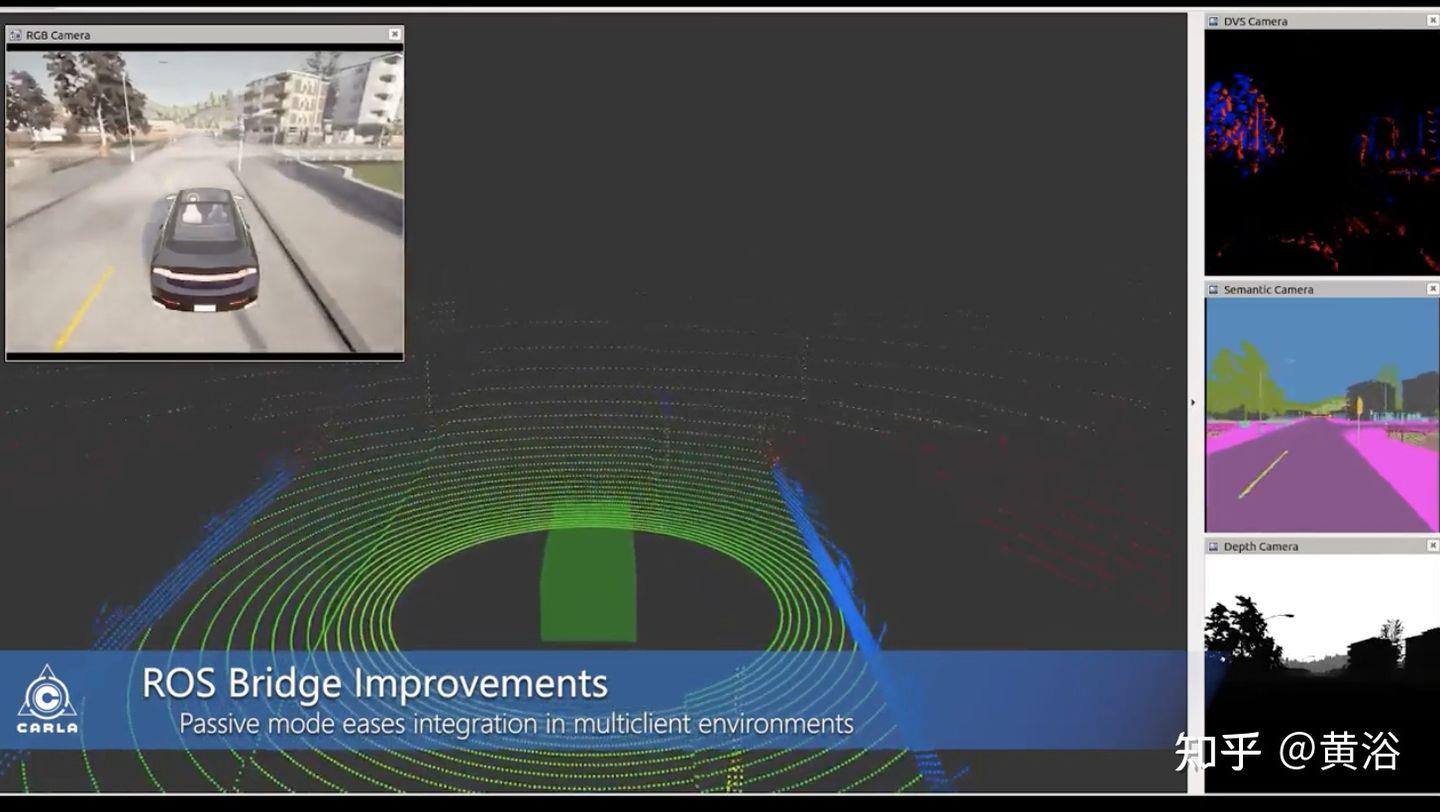

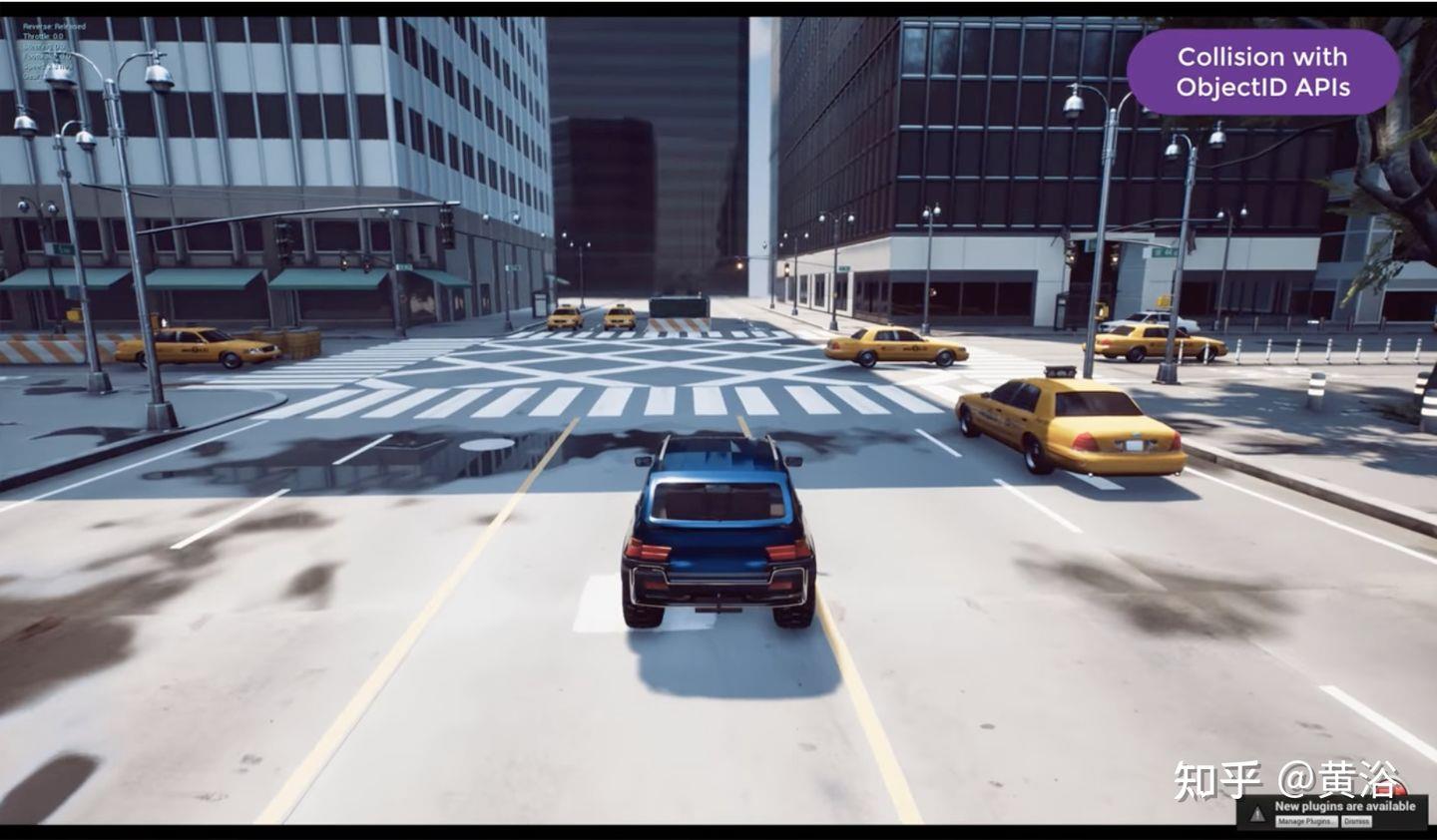

一是仿真测试检验。建立仿真测试环境,比如开源的一些软件平台:

Carla: https://github.com/carla-simulator/carla

AirSim: https://microsoft.github.io/AirSim/

LGSVL: https://www.svlsimulator.com/

还有一些成熟的商用软件,也可以构建仿真测试环境:Prescan和VTD。存在一些仿真子模块,比如开源的交通流仿真方面SUMO,商用的动力学仿真方面CarSim、Trucksim和Carmaker等。测试方式包括模型在环(MIL)、软件在环(SIL)、硬件在环(HIL)和整车在环(VIL)等。传感器的仿真,特别是摄像头的图像生成,除了图形学的渲染方式,还有基于机器学习的方式。

这里列出Uber ATG发表的一系列仿真建模论文:

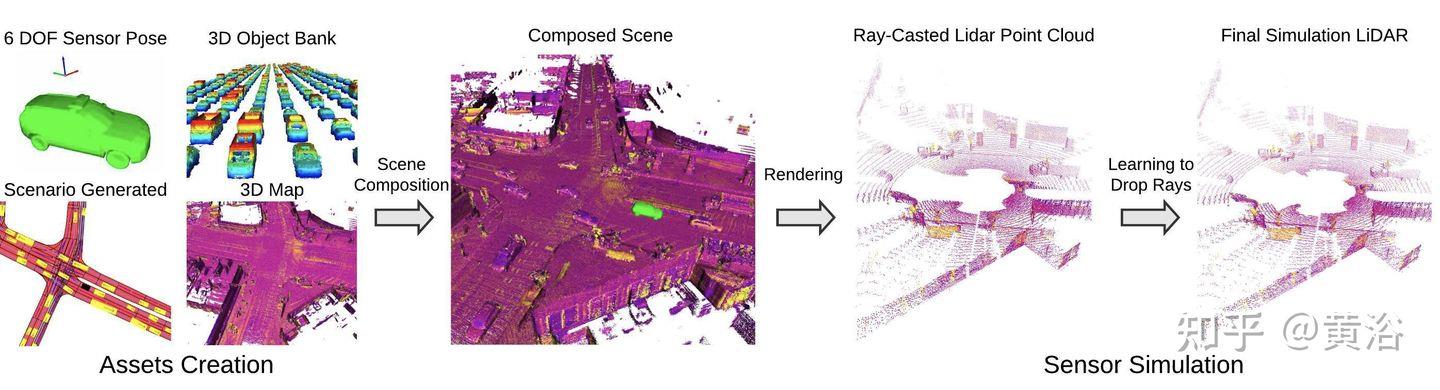

- “LiDARsim: Realistic LiDAR Simulation by Leveraging the Real World“

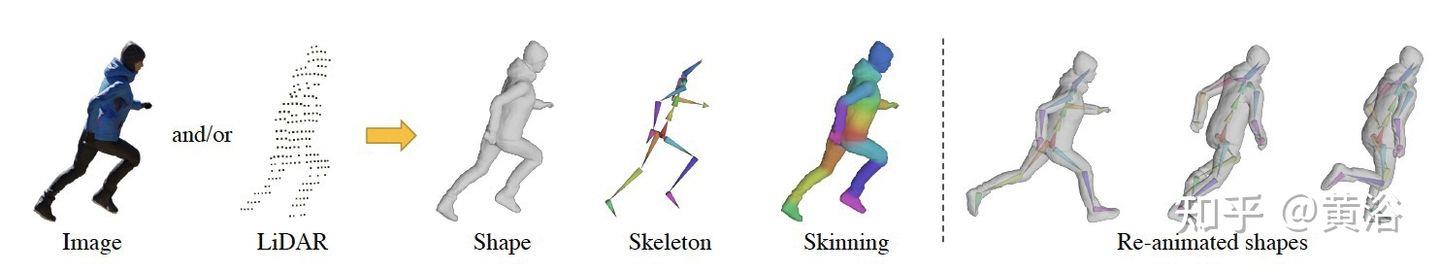

- ”S3: Neural Shape, Skeleton, and Skinning Fields for 3D Human Modeling“

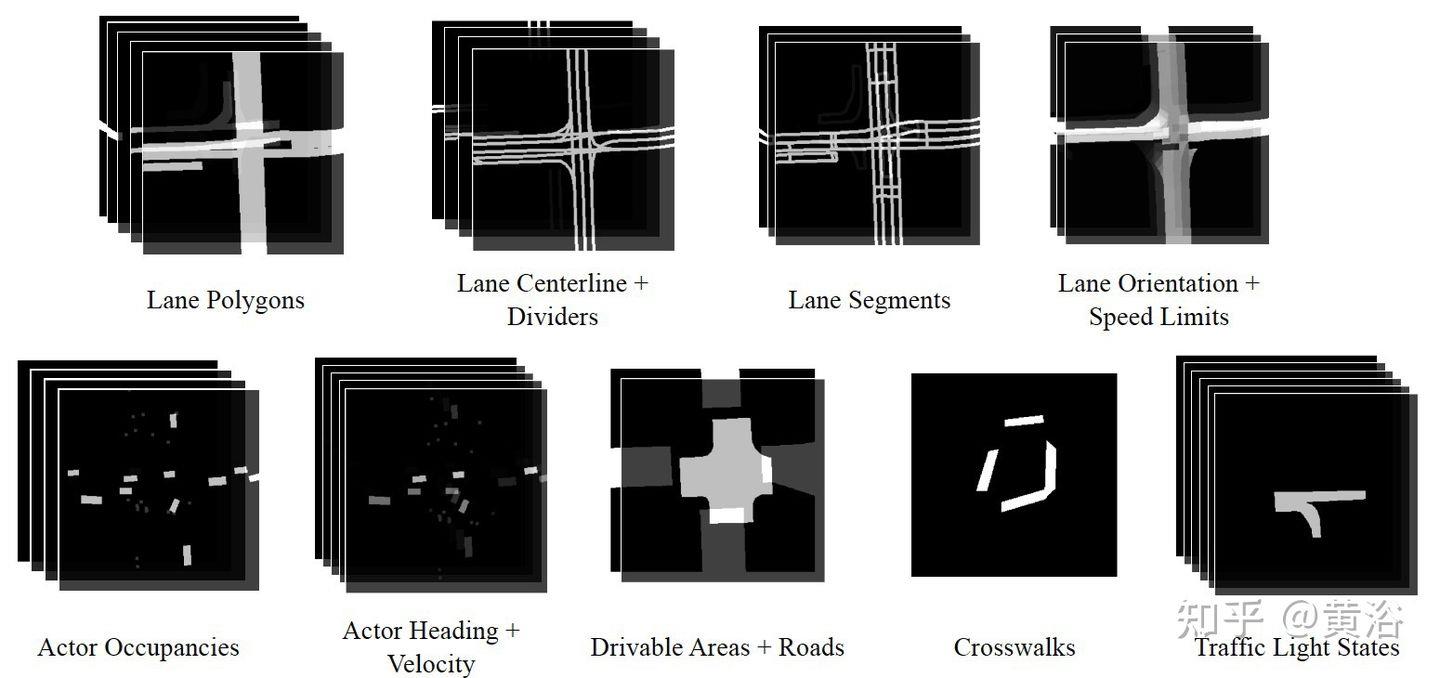

- ”SceneGen: Learning to Generate Realistic Traffic Scenes“

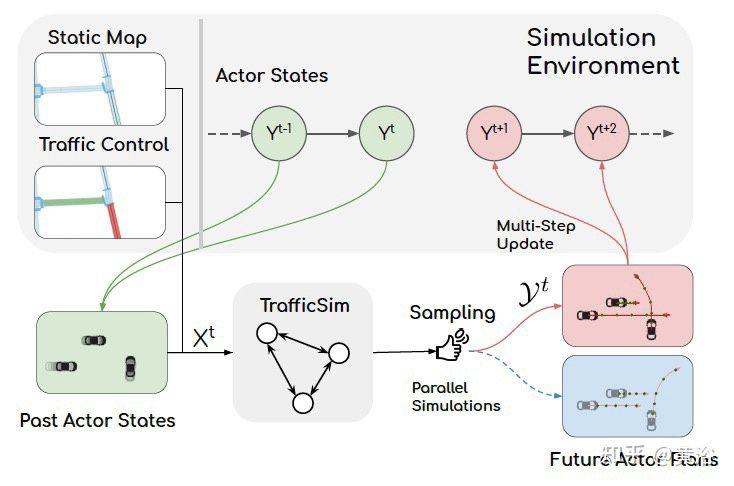

- ”TrafficSim: Learning to Simulate Realistic Multi-Agent Behaviors“

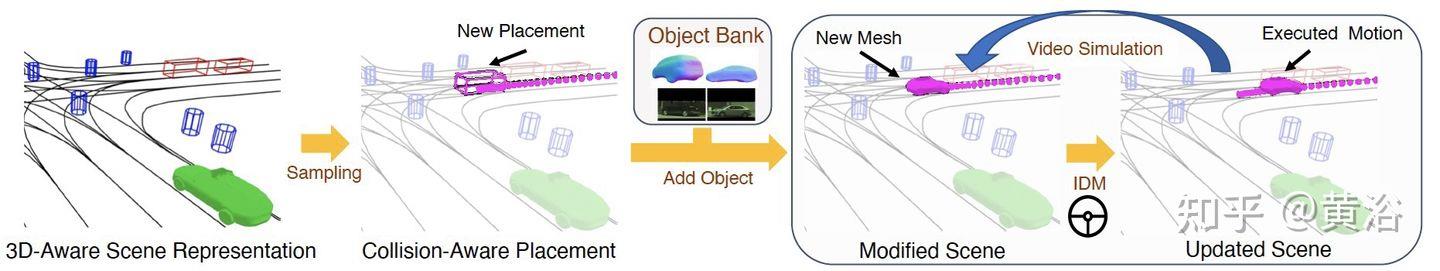

”GeoSim: Realistic Video Simulation via Geometry-Aware Composition for Self-Driving“

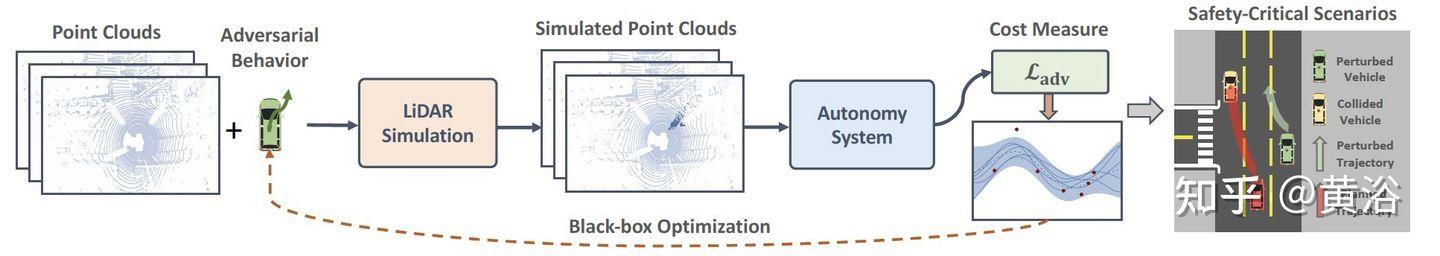

“AdvSim: Generating Safety-Critical Scenarios for Self-Driving Vehicles“

另外谷歌Waymo最近推出的传感器仿真工作:

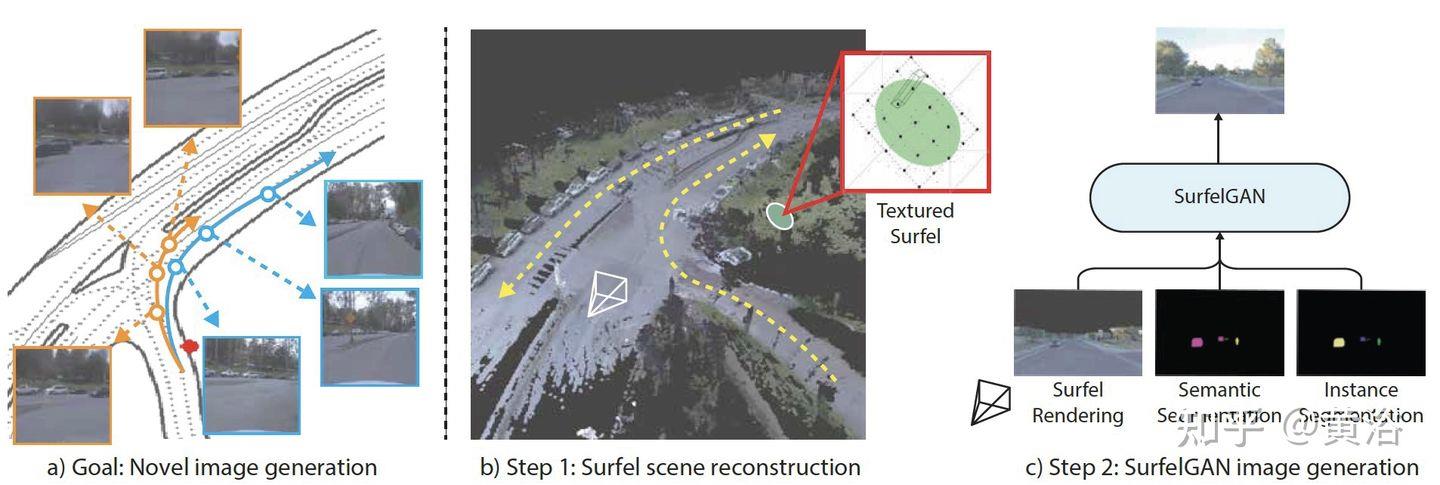

”SurfelGAN: Synthesizing Realistic Sensor Data for Autonomous Driving“

二是封闭场地的实车测试检验。各大车企都有自己的测试基地,现在自动驾驶方面也可使用。其开销远大于仿真系统。

谷歌waymo测试场

三是开放场地的测试检验。现在好多L4级别的自动驾驶,比如无人出租车/无人卡车/无人送货,都在做这种政府批准的实际驾驶实验区测试。这种测试,必要时候安全员的接管或者遥控接管,都是需要花费大量投入的。

GM的自动驾驶公司Cruise在旧金山测试

最后是用户的测试检验。这个是特斯拉特有的影子模式,以及FSD beta版本测试的志愿者模式。

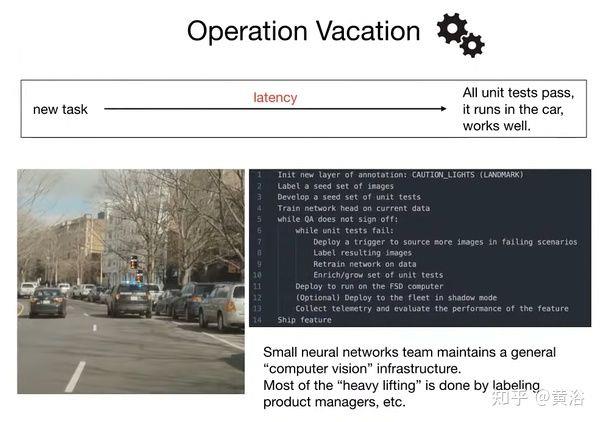

特斯拉的“Operation Vacation”模式

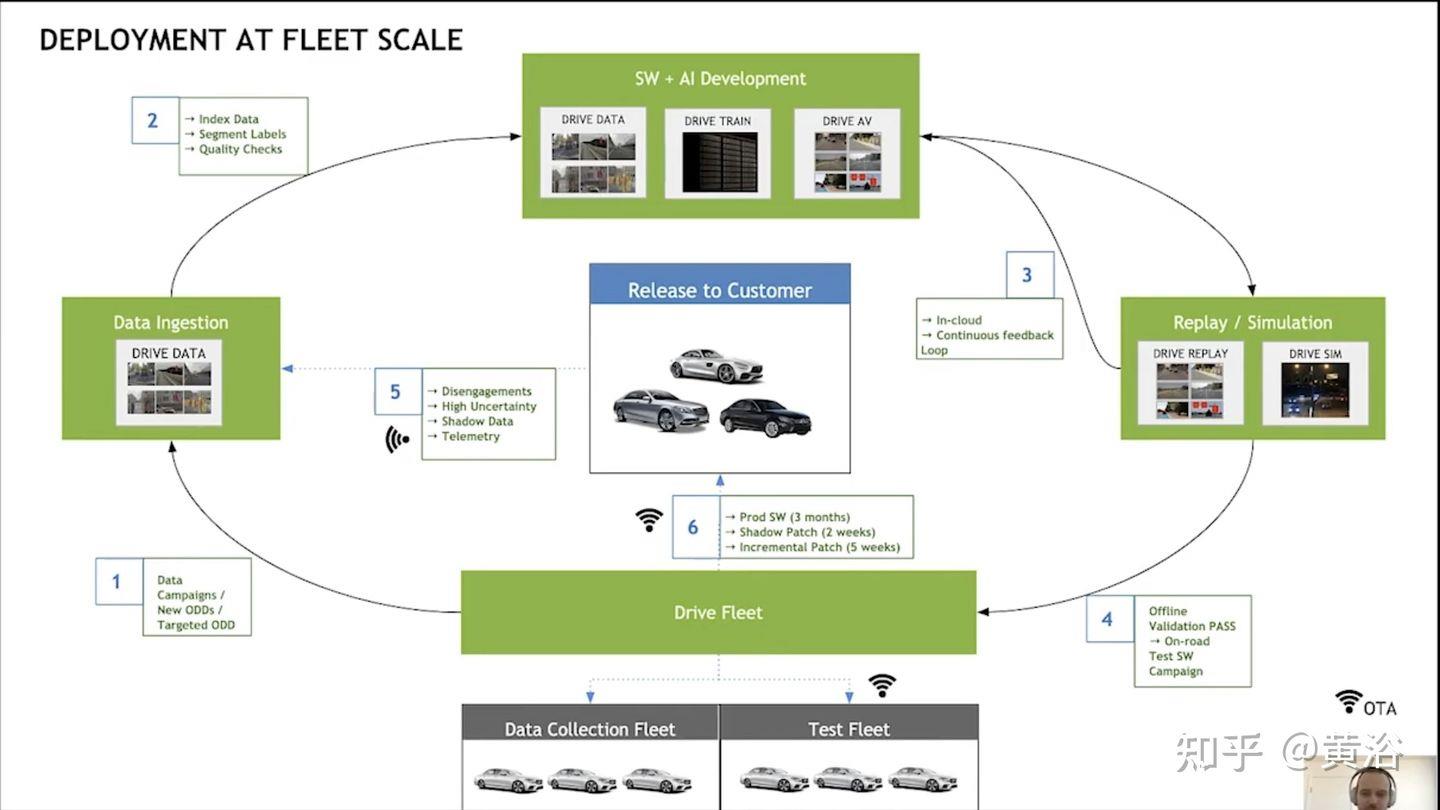

如图是英伟达报告描述的车队级别的模型部署闭环:

以上是关于如何打造营销闭环的主要内容,如果未能解决你的问题,请参考以下文章