为什么MySQL单表不能超过2000万行?

Posted 华为云开发者社区

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了为什么MySQL单表不能超过2000万行?相关的知识,希望对你有一定的参考价值。

摘要:MySQL一张表最多能存多少数据?

本文分享自华为云社区《为什么MySQL单表不能超过2000万行?》,作者: GaussDB 数据库 。

最近看到一篇《我说MySQL每张表最好不要超过2000万数据,面试官让我回去等通知》的文章,非常有趣。

文中提到,他朋友在面试的过程中说,自己的工作就是把用户操作信息存到MySQL里,因为数据量超大(5000万条左右),需要每天定时生成3张表,然后将数据取模分别存到这三张表里。

下面是两人的对话:

面试后续暂且不论,不过,互联网江湖上的确流传着一个说法:单表数据量超过500万行时就要进行分表分库,已经超过2000万行时MySQL的性能就会急剧下降。

那么,MySQL一张表最多能存多少数据?

今天我们就从技术层面剖析一下,MySQL单表数据不能过大的根本原因是什么?

猜想一:是索引深度吗?

很多人认为:数据量超过500万行或2000万行时,引起B+tree的高度增加,延长了索引的搜索路径,进而导致了性能下降。事实果真如此吗?

我们先理一下关系,MySQL采用了索引组织表的形式组织数据,叶子节点存储数据,非叶子节点存储主键与页面号的映射关系。若用户的主键长度是8字节时,MySQL中页面偏移占4个字节,在非叶子节点的时候实际上是8+4=12个字节,12个字节表示一个页面的映射关系。

MySQL默认是16K的页面,抛开它的配置header,大概就是15K,因此,非叶子节点的索引页面可放15*1024/12=1280条数据,按照每行1K计算,每个叶子节点可以存15条数据。同理,三层就是15*1280*1280=24576000条数据。只有数据量达到24576000条时,深度才会增加为4,所以,索引深度没有那么容易增加,详细数据可参考下表:

搜索路径延长导致性能下降的说法,与当时的机械硬盘和内存条件不无关系。

之前机械硬盘的IOPS在100左右,而现在普遍使用的SSD的IOPS已经过万,之前的内存最大几十G,现在服务器内存最大可达到TB级。

因此,即使深度增加,以目前的硬件资源,IO也不会成为限制MySQL单表数据量的根本性因素。

那么,限制MySQL单表不能过大的根本性因素是什么?

猜想二:是SMO无法并发吗?

我们可以尝试从MySQL所采用的存储引擎InnoDB本身来探究一下。

大家知道InnoDB引擎使用的是索引组织表,它是通过索引来组织数据的,而它采用B+tree作为索引的数据结构。

B+Tree操作非原子,所以当一个线程做结构调整(SMO,Struction-Modification-Operation)时一般会涉及多个节点的改动。

SMO动作过程中,此时若有另一个线程进来可能会访问到错误的B+Tree结构,InnoDB为了解决这个问题采用了乐观锁和悲观锁的并发控制协议。

InnoDB对于叶子节点的修改操作如下:

方式一,先采用乐观锁的方式尝试进行修改

对根节点加S锁(shared lock,叫共享锁,也称读锁),依次对非叶子节点加S锁。

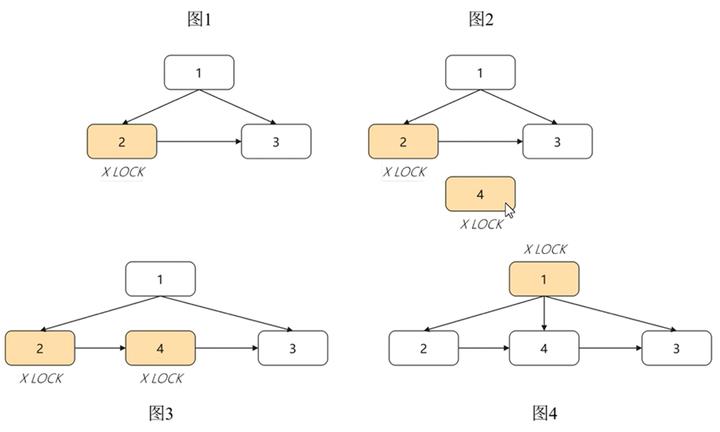

如果叶子节点的修改不会引起B+Tree结构变动,如分裂、合并等操作,那么只需要对叶子节点进行加X锁(exclusive lock,叫排他锁,也称为写锁)即可完成修改。如下图中所示 :

方式二,采用悲观锁的方式

如果对叶子结点的修改会触发SMO,那么会采用悲观锁的方式。

采用悲观锁,需要重新遍历B+Tree,对根节点加全局SX锁(SX锁是行锁),然后从根节点到叶子节点可能修改的节点加X锁。

在整个SMO过程中,根节点始终持有SX锁(SX锁表示有意向修改这个保护的范围,SX锁与SX锁、X锁冲突,与S锁不冲突),此时其他的SMO则需要等待。

因此,InnoDB对于简单的主键查询比较快,因为数据都存储在叶子节点中,但对于数据量大且改操作比较多的TP型业务,并发会有很严重的瓶颈问题。

在对叶子节点的修改操作中,InnoDB可以实现较好的1与1、1与2的并发,但是无法解决2的并发。因为在方式2中,根节点始终持有SX锁,必须串行执行,等待上一个SMO操作完成。这样在具有大量的SMO操作时,InnoDB的B+Tree实现就会出现很严重的性能瓶颈。

解决方案

目前业界有一个更好的方案B-Link Tree,与B+Tree相比,B-Link Tree优化了B+Tree结构调整时的锁粒度,只需要逐层加锁,无需对root节点加全局锁。因此,可以做到在SMO过程中写操作的并发执行,保持高并发下性能的稳定。

B-Link Tree主要改进点有2个:

1.中间节点增加link指针,指向右兄弟节点;

2.每个节点内增加字段high key,存储该节点中最大的key值。

新增的link指针是为了解决SMO过程中并发写的问题,在SMO过程中,B-Link Tree对修改节点逐层加锁,修改完一层即可放锁,然后去加上一层节点的锁继续修改。这样在InnoDB引擎中被SMO阻塞的写操作可以有机会在SMO操作过程中并发进行。

如下图所示,在节点2分裂为节点2和4的过程中,只需要在最后一步将父节点1指向新节点4时,对父节点1加锁,其他操作均无需对父节点加锁,更无需对root节点加锁,因此,大大提升了SMO过程中写操作的并发度。

由此可见,与B+Tree全局加锁对比,B-Link Tree在高并发操作下的性能是显著优于B+Tree的。GaussDB当前采用的就是B-Link Tree索引数据结构。

InnoDB的索引组织表更容易触发SMO

索引组织表的叶子节点,存储主键以及应对行的数据,InnoDB默认页面为16K,若每行数据的大小为1000字节,每个叶子节点仅能存储16行数据。

在索引组织表中,当叶子节点的扇出值过低时,SMO的触发将更加频繁,进而放大了SMO无法并发写的缺陷。

目前业界有一个堆组织表的数据组织方案,也是华为云数据库GaussDB采用的方案。它的叶子节点存储索引键以及对应的行指针(所在的页面编号及页内偏移),堆组织表叶子节点可以存更多的数据,分析可得在同样的数据量与业务并发量下,堆组织表会比索引组织表发生SMO概率低许多。

性能对比

在8U32G的两台服务器分别搭建了MySQL(B+Tree和索引组织表)与GaussDB(B-Link Tree和堆组织表)的环境,进行了如下性能验证:

实验场景:在基础表的场景上,测试增量随机插入性能。

1.基础表总大小10G,包含主键随机分布的1000w行数据,每行数据1k;

2.插入主键随机分布的1000w行数据,每行数据大小1k,测试并发插入性能。

结论:随着并发数的上升,GaussDB能稳步提升系统的TPS,而MySQL并发数的提高并不能带来TPS的显著提升。

综上所述,MySQL无法支持大数据量下并发修改的根本原因,是由于其索引并发控制协议的缺陷造成的,而MySQL选择索引组织表,又放大了这一缺陷。所以,开源MySQL数据库更适用于主键查询为主的简单业务场景,如互联网类应用,对于复杂的商业场景限制比较明显。

相比之下 ,采用B-Link Tree和堆组织表的GaussDB数据库在性能和场景应用方面更胜一筹。

mysql优化注意事项

MySQL 性能

①最大数据量

抛开数据量和并发数,谈性能都是耍流氓。MySQL 没有限制单表最大记录数,它取决于操作系统对文件大小的限《阿里巴巴 Java 开发手册》提出单表行数超过 500 万行或者单表容量超过 2GB,才推荐分库分表。

性能由综合因素决定,抛开业务复杂度,影响程度依次是硬件配置、MySQL 配置、数据表设计、索引优化。500 万这个值仅供参考,并非铁律。

我曾经操作过超过 4 亿行数据的单表,分页查询最新的 20 条记录耗时 0.6 秒,SQL 语句大致是:

select field_1,field_2 from table where id < #{prePageMinId} order by id desc limit 20

prePageMinId 是上一页数据记录的最小 ID。虽然当时查询速度还凑合,随着数据不断增长,有朝一日必定不堪重负。

分库分表是个周期长而风险高的大活儿,应该尽可能在当前结构上优化,比如升级硬件、迁移历史数据等等,实在没辙了再分。对分库分表感兴趣的同学可以阅读分库分表的基本思想。

②最大并发数

并发数是指同一时刻数据库能处理多少个请求,由 max_connections 和 max_user_connections 决定。

max_connections 是指 MySQL 实例的最大连接数,上限值是 16384,max_user_connections 是指每个数据库用户的最大连接数。

MySQL 会为每个连接提供缓冲区,意味着消耗更多的内存。如果连接数设置太高硬件吃不消,太低又不能充分利用硬件。

一般要求两者比值超过 10%,计算方法如下:

max_used_connections / max_connections * 100% = 3/100 *100% ≈ 3%

查看最大连接数与响应最大连接数:

show variables like ‘%max_connections%‘; show variables like ‘%max_user_connections%‘;

在配置文件 my.cnf 中修改最大连接数:

[mysqld] max_connections = 100 max_used_connections = 20

③查询耗时 0.5 秒

建议将单次查询耗时控制在 0.5 秒以内,0.5 秒是个经验值,源于用户体验的 3 秒原则。如果用户的操作 3 秒内没有响应,将会厌烦甚至退出。

响应时间=客户端 UI 渲染耗时+网络请求耗时+应用程序处理耗时+查询数据库耗时,0.5 秒就是留给数据库 1/6 的处理时间。

④实施原则

相比 NoSQL 数据库,MySQL 是个娇气脆弱的家伙。它就像体育课上的女同学,一点纠纷就和同学闹别扭(扩容难),跑两步就气喘吁吁(容量小并发低),常常身体不适要请假(SQL 约束太多)。

如今大家都会搞点分布式,应用程序扩容比数据库要容易得多,所以实施原则是数据库少干活,应用程序多干活:

-

充分利用但不滥用索引,须知索引也消耗磁盘和 CPU。

-

不推荐使用数据库函数格式化数据,交给应用程序处理。

-

不推荐使用外键约束,用应用程序保证数据准确性。

-

写多读少的场景,不推荐使用唯一索引,用应用程序保证唯一性。

-

适当冗余字段,尝试创建中间表,用应用程序计算中间结果,用空间换时间。

-

不允许执行极度耗时的事务,配合应用程序拆分成更小的事务。

-

预估重要数据表(比如订单表)的负载和数据增长态势,提前优化。

数据表设计

①数据类型

数据类型的选择原则,更简单或者占用空间更小:

-

如果长度能够满足,整型尽量使用 tinyint、smallint、medium_int 而非 int。

-

如果字符串长度确定,采用 char 类型。

-

如果 varchar 能够满足,不采用 text 类型。

-

精度要求较高的使用 decimal 类型,也可以使用 BIGINT,比如精确两位小数就乘以 100 后保存。

- 尽量采用 timestamp 而非 datetime。

相比 datetime,timestamp 占用更少的空间,以 UTC 的格式储存自动转换时区。

②避免空值

MySQL 中字段为 NULL 时依然占用空间,会使索引、索引统计更加复杂。从 NULL 值更新到非 NULL 无法做到原地更新,容易发生索引分裂影响性能。

因此尽可能将 NULL 值用有意义的值代替,也能避免 SQL 语句里面包含 is not null 的判断。

③Text 类型优化

由于 Text 字段储存大量数据,表容量会很早涨上去,影响其他字段的查询性能。建议抽取出来放在子表里,用业务主键关联。

索引优化

索引分类如下:

-

普通索引:最基本的索引。

-

组合索引:多个字段上建立的索引,能够加速复合查询条件的检索。

-

唯一索引:与普通索引类似,但索引列的值必须唯一,允许有空值。

-

组合唯一索引:列值的组合必须唯一。

-

主键索引:特殊的唯一索引,用于唯一标识数据表中的某一条记录,不允许有空值,一般用 primary key 约束。

-

全文索引:用于海量文本的查询,MySQL 5.6 之后的 InnoDB 和 MyISAM 均支持全文索引。由于查询精度以及扩展性不佳,更多的企业选择 Elasticsearch。

索引优化原则:

-

分页查询很重要,如果查询数据量超过 30%,MySQL 不会使用索引。

-

单表索引数不超过 5 个、单个索引字段数不超过 5 个。

-

字符串可使用前缀索引,前缀长度控制在 5-8 个字符。

-

字段唯一性太低,增加索引没有意义,如:是否删除、性别。

- 合理使用覆盖索引,如下所示:

select login_name, nick_name from member where login_name = ?

login_name, nick_name 两个字段建立组合索引,比 login_name 简单索引要更快。

SQL 优化

①分批处理

博主小时候看到鱼塘挖开小口子放水,水面有各种漂浮物。浮萍和树叶总能顺利通过出水口,而树枝会挡住其他物体通过,有时还会卡住,需要人工清理。

MySQL 就是鱼塘,最大并发数和网络带宽就是出水口,用户 SQL 就是漂浮物。

不带分页参数的查询或者影响大量数据的 update 和 delete 操作,都是树枝,我们要把它打散分批处理,下面举例说明。

业务描述:更新用户所有已过期的优惠券为不可用状态。

SQL 语句:

update status=0 FROM `coupon` WHERE expire_date <= #{currentDate} and status=1;

如果大量优惠券需要更新为不可用状态,执行这条 SQL 可能会堵死其他 SQL,分批处理伪代码如下:

int pageNo = 1;

int PAGE_SIZE = 100;

while(true) {

List<Integer> batchIdList = queryList(‘select id FROM `coupon` WHERE expire_date <= #{currentDate} and status = 1 limit #{(pageNo-1) * PAGE_SIZE},#{PAGE_SIZE}‘);

if (CollectionUtils.isEmpty(batchIdList)) {

return;

}

update(‘update status = 0 FROM `coupon` where status = 1 and id in #{batchIdList}‘)

pageNo ++;

}

②操作符 <> 优化

通常 <> 操作符无法使用索引,举例如下,查询金额不为 100 元的订单:

select id from orders where amount != 100;

如果金额为 100 的订单极少,这种数据分布严重不均的情况下,有可能使用索引。

鉴于这种不确定性,采用 union 聚合搜索结果,改写方法如下:

(select id from orders where amount > 100) union all (select id from orders where amount < 100 and amount > 0)

③OR 优化

在 Innodb 引擎下 OR 无法使用组合索引,比如:

select id,product_name from orders where mobile_no = ‘13421800407‘ or user_id = 100;

OR 无法命中 mobile_no + user_id 的组合索引,可采用 union,如下所示:

(select id,product_name from orders where mobile_no = ‘13421800407‘) union (select id,product_name from orders where user_id = 100);

此时 id 和 product_name 字段都有索引,查询才最高效。

④IN 优化

IN 适合主表大子表小,EXIST 适合主表小子表大。由于查询优化器的不断升级,很多场景这两者性能差不多一样了。

尝试改为 Join 查询,举例如下:

select id from orders where user_id in (select id from user where level = ‘VIP‘);

采用 Join 如下所示:

select o.id from orders o left join user u on o.user_id = u.id where u.level = ‘VIP‘;

⑤不做列运算

通常在查询条件列运算会导致索引失效,如下所示,查询当日订单:

select id from order where date_format(create_time,‘%Y-%m-%d‘) = ‘2019-07-01‘;

date_format 函数会导致这个查询无法使用索引,改写后:

select id from order where create_time between ‘2019-07-01 00:00:00‘ and ‘2019-07-01 23:59:59‘;

⑥避免Select All

如果不查询表中所有的列,避免使用 SELECT *,它会进行全表扫描,不能有效利用索引。

⑦Like 优化

Like 用于模糊查询,举个例子(field 已建立索引):

SELECT column FROM table WHERE field like ‘%keyword%‘;

这个查询未命中索引,换成下面的写法:

SELECT column FROM table WHERE field like ‘keyword%‘;

去除了前面的 % 查询将会命中索引,但是产品经理一定要前后模糊匹配呢?全文索引 fulltext 可以尝试一下,但 Elasticsearch 才是终极武器。

⑧Join 优化

Join 的实现是采用 Nested Loop Join 算法,就是通过驱动表的结果集作为基础数据,通过该结数据作为过滤条件到下一个表中循环查询数据,然后合并结果。

如果有多个 Join,则将前面的结果集作为循环数据,再次到后一个表中查询数据。

驱动表和被驱动表尽可能增加查询条件,满足 ON 的条件而少用 Where,用小结果集驱动大结果集。

被驱动表的 Join 字段上加上索引,无法建立索引的时候,设置足够的 Join Buffer Size。

禁止 Join 连接三个以上的表,尝试增加冗余字段。

⑨Limit 优化

Limit 用于分页查询时越往后翻性能越差,解决的原则:缩小扫描范围,如下所示:

select * from orders order by id desc limit 100000,10 耗时0.4秒 select * from orders order by id desc limit 1000000,10 耗时5.2秒

先筛选出 ID 缩小查询范围,写法如下:

select * from orders where id > (select id from orders order by id desc limit 1000000, 1) order by id desc limit 0,10 耗时0.5秒

如果查询条件仅有主键 ID,写法如下:

select id from orders where id between 1000000 and 1000010 order by id desc 耗时0.3秒

如果以上方案依然很慢呢?只好用游标了,感兴趣的朋友阅读 JDBC 使用游标实现分页查询的方法。

其他数据库

作为一名后端开发人员,务必精通作为存储核心的 MySQL 或 SQL Server,也要积极关注 NoSQL 数据库,他们已经足够成熟并被广泛采用,能解决特定场景下的性能瓶颈。

此文转载自https://mp.weixin.qq.com/s/NWt4eBNM43AjeTbyLPTCpQ

以上是关于为什么MySQL单表不能超过2000万行?的主要内容,如果未能解决你的问题,请参考以下文章