可见光遥感目标检测主要难点与研究方法概述

Posted CV技术指南(微信公众号)

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了可见光遥感目标检测主要难点与研究方法概述相关的知识,希望对你有一定的参考价值。

前言 可见光遥感图像目标检测属于计算机视觉下面目标检测的重要分支,其具有常规目标检测的普遍性问题,又具有遥感图像目标检测的特殊性问题,针对遥感图像的特殊性问题与普遍性问题在目标检测的通用框架下做出改变与优化,以解决遥感图像目标检测的特殊性与普遍性问题。首先需要明确通用目标检测框架的部分构成,以便于后续在遥感图像检测问题明确哪部分做出改变,改变的地方怎么用在模型之中,做到提纲挈领,熟稔于心。

本教程禁止转载。同时,本教程来自知识星球【CV技术指南】更多技术教程,可加入星球学习。

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

【CV技术指南】CV全栈指导班、基础入门班、论文指导班 全面上线!!

需要先验知识

1.1、通用目标检测框架构成

现代目标检测框架主要由三个部分组成:

- Backbone:主干网络,用来提取图像特征,广泛应用的网络如Resnet50、Resnet101系列,DenseNet,VGG等等。

- Neck:主要用于进行特征融合等操作,如FPN,PAN及其各种变体。

- Head:预测头,输入backbone和Neck提取的特征最终得到检测结果。

检测器又可以分为单阶段,两阶段、多阶段检测器,也可以分为anchor-based,anchor-free以及transfomer系列query-based等等,在这里不做展开。

1.2、优化思路

根据目标检测框架图,它的优化模型思路也比较清晰了:

- 想办法提高模型提取特征的能力,使用更加强力的Backbone,比如ResNext,Res2Net等等。

- 在Neck层想更多拌饭,考虑更加高效的融合特征,也就有了FPN的各种变种,PAN,Bifpn甚至采用NAS的思路搜索一个最佳的特征融合方案。

- Label Assignment优化,我们知道在目标检测中一个很关键的问题在于如何平衡网络学习的正负例样本,如何选择好的正样本,这些都是Label Assignment方向做的事情。

- 损失函数上的优化,这一部分在不仅仅是目标检测,在不同任务领域都是重中之重,比如平衡正负例样本,难易例样本的Focal loss,比如考虑用任意分布来做回归的GFL等等,面对不同的问题,我们需要设计更贴合实际的损失函数。

主要研究难点

上面讲到了通用目标检测的基本框架和一些常用的优化思路,下面我们一起来看看可见光遥感目标检测中都有哪些难点,它和通用目标检测都有哪些方面的不同。

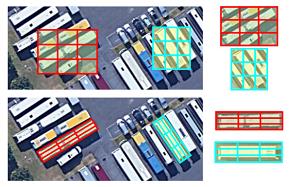

1、旋转目标的检测问题,一直都是遥感图像目标检测的重要解决的问题。以前基于水平框的方法无法精确的包围遥感图像,所以提议生成带角度的旋转框来包围遥感图像。图2说明了生成旋转框的必要性。

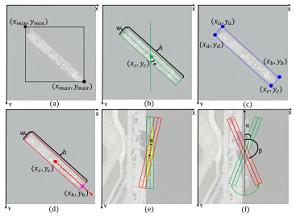

在处理旋转目标的检测问题时候,主要的思路是:1、旋转等变检测器,用来提取旋转不变特征,属于特征提取阶段。2、特征精细化模块,用于特征对齐,属于Head阶段的改进。3、自适应点来学习非轴向特征与任意方向特征,属于特征提取阶段。4、将水平关键点检测用到旋转关键点检测,去除锚框设置,属于Head部分改进。5、设计新的损失函数,属于反向传播优化参数阶段。 2、高纵横比问题,这个问题集中体现在遥感图像中船只的检测上面。因为船只属于瘦长目标,所以当角度发生很小的变化时,其包围框的变化是非常剧烈的。图3展示了高纵横比检测的特殊性。

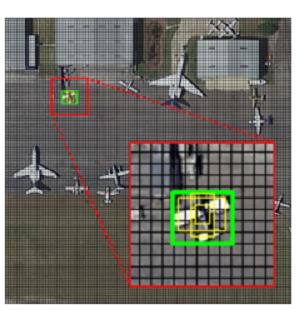

在处理舰船这种高纵横比的问题上,主要思路是:1、中心点提取,通过关键点来定位舰船中心,属于Head部分改进。2、根据对象的形状信息和特征分布动态选择样本,属于特征提取部分的改进。3、累积特征金字塔,用来增强在各个尺度的语义信息,属于Neck部分改进。3、小目标的检测问题,小目标的检测问题不属于遥感图像特有的检测问题,属于目标检测的普遍性的问题,主要是由于小目标提供的像素点信息较少,无法提取到鲁棒性的特征。图4,展示了遥感目标检测的小目标问题。

在处理小目标的检测问题上,主要的思路是:1、对于提取到的特征分配不同的重加权模块,属于特征提取阶段。2、基于接受区域的标签分配策略,属于Head部分改进。

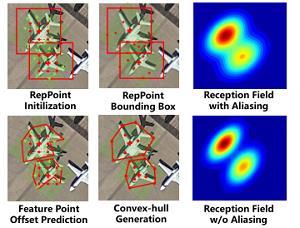

4、复杂背景问题,由于遥感图像的视角开阔,得到的图像的尺寸往往大于一般的图像,这就使得图像里面的前景信息与背景信息极度不平衡,造成模型学习不到优质的前景信息。还会造成目标的重叠遮挡等问题,这就使得包围框的生成是不够准确的。图五展示了遥感图像中复杂的背景问题。

在处理复杂背景的题上,主要的思路是:1、提出像素级别损失函数,更精确计算IoU面积,属于反向传播优化参数阶段.2、提出学习凸包特征方法,属于特征提取阶段。

5、密集物体检测,密集物体检测也不属于遥感图像专有的问题,密集的物体不利于包围框的生成,造成定位的不准确。图6展示遥感图像中密集物体检测问题。

在处理密集物体检测问题上,主要的思路是:提出新的角度标签编码策略,根据标签来设定新的损失函数,属于反向传播优化参数阶段.

6、遥感图像目标检测的新范式,由于Transormers的横空出世,把cv问题转变为了CNN与Transormers各占据半壁江山,现在也有很多用Transormers来做遥感图像目标检测,并且也取得了不错的效果,Transormers主要的有点是能够学习到图片的全局特征,但是其缺点是需要大量的数据才能够表现出最佳的性能。Transormers与CNN到底鹿死谁手,我们只能拭目以待。

后续的文章我会带大家从上面说到的遥感目标检测面临的实际问题以及不同的解决思路出发,以近年的主要论文为主,详细为大家介绍遥感目标检测~

欢迎关注公众号CV技术指南,专注于计算机视觉的技术总结、最新技术跟踪、经典论文解读、CV招聘信息。

【技术文档】《从零搭建pytorch模型教程》122页PDF下载

QQ交流群:470899183。群内有大佬负责解答大家的日常学习、科研、代码问题。

其它文章

一次性分割一切,比SAM更强,华人团队的通用分割模型SEEM来了

CVPR\'23|向CLIP学习预训练跨模态!简单高效的零样本参考图像分割方法

CVPR23 Highlight|拥有top-down attention能力的vision transformer

【CV技术指南】咱们自己的CV全栈指导班、基础入门班、论文指导班 全面上线!!

CVPR 2023|21 篇数据集工作汇总(附打包下载链接)

CVPR 2023|两行代码高效缓解视觉Transformer过拟合,美图&国科大联合提出正则化方法DropKey

ViT-Adapter:用于密集预测任务的视觉 Transformer Adapter

CodeGeeX 130亿参数大模型的调优笔记:比FasterTransformer更快的解决方案

CVPR 2023 深挖无标签数据价值!SOLIDER:用于以人为中心的视觉

上线一天,4k star | Facebook:Segment Anything

目标检测轻量化压缩

目标检测轻量化压缩

目标检测难点概述

目标检测是计算机视觉中一个重要问题,在行人跟踪、车牌识别、无人驾驶等领域都具有重要的研究价值。近年来,随着深度学习对图像分类准确度的大幅度提高,基于深度学习的目标检测算法逐渐成为主流。

自 2014 年以来,目标检测框架分为two-stage 和 one-stage 两大类,前者以经典方法 Faster R-CNN 为代表,后者以 YOLO 和 SSD 为主要框架。近年来,两类最深刻的idea:更好的基础网络

& 融合不同卷积层的特征叠加在经典方法上,产生了大量变体。

结合近两年的计算机视觉会议的相关论文可以看出,对于目标检测而言,目前主要存在以下几个问题:

- 对于小目标物体的检测(如小于30像素的目标物体)、遮挡面积较大的目标以及区分图像中与目标物体外形相似的非目标物体等问题需要在今后的研究中继续加强。

- 实时性检测与处理。对于自动驾驶或汽车辅助驾驶等对实时处理能力要求较高的应用场景,进一步提高目标检测的计算速度和准确度是至关重要的。

- 提高小数据量训练的检测效果。目前迁移学习的实现策略是先在现有大数据中进行训练,然后再将模型进行微调。虽然此方法能够实现,但检测精度和速度还有待进一步提高。

- 目前基于深度学习的目标检测所涉及的行业领域越来越多,很难获取大量的监督数据或数据的标准成本过高,进而导致缺少用于网络训练的样本数据。

近年来,许多学者在目标检测难点方面已经做出许多成果,本文主要介绍秘籍一:模型加速之轻量化网络。

动机:

目标:想要获得一个实时的模型,且尽可能的准确。

我们有一个大模型性能很好,但是很慢:

我们有个小模型速度很快,但是性能很差:

动机:面临的挑战

1、由于容量和能力,小模型很难达到一个很好的性能。

2、精确度和模型压缩之间的差距还是很大

3、物体检测比分类要困难得多:

a、 标签的计算更加昂贵

b、 类别不均衡

c、多任务同时需要分类和回归

4、直接应用蒸馏在检测模型上并不能很好的工作。

背景,前人的工作:

1、 大网络的加速

a、减少通道的数量 (训练前)

b、剪枝 (训练后)

c、low rank decomposition (低秩分解见下图)

HWS:高宽通道数。D越小越快,D越大总结信息能力越强。 resnet bottlenek 也是同样的道理,FC层也可以分解

秘籍一. 模型加速之轻量化网络

从模型设计时就采用一些轻量化的思想,例如采用深度可分离卷积、分组卷积等轻量卷积方式,减少卷积过程的计算量。此外,利用全局池化来取代全连接层,利用1×1卷积实现特征的通道降维,也可以降低模型的计算量,这两点在众多网络中已经得到了应用。

对于轻量化的网络设计,目前较为流行的有SqueezeNet、MobileNet及ShuffleNet等结构。其中,SqueezeNet采用了精心设计的压缩再扩展的结构,MobileNet使用了效率更高的深度可分离卷积,而ShuffleNet提出了通道混洗的操作,进一步降低了模型的计算量。

下面将详细介绍:

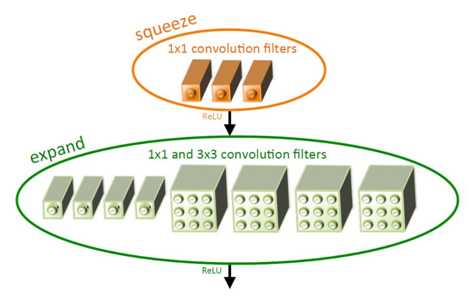

1.SqueezeNet:压缩再扩展

随着网络结构的逐渐加深,模型的性能有了大幅度提升,但这也增加了网络参数与前向计算的时间。SqueezeNet从网络结构优化的角度出发,使用了如下3点策略来减少网络参数,提升网络性能:

1)使用1×1卷积来替代部分的3×3卷积,可以将参数减少为原来的1/9。

2)减少输入通道的数量,这一点也是通过1×1卷积来实现,通道数量的减少可以使后续卷积核的数量也相应地减少。

3) 将降采样后置。在减少通道数之后,使用多个尺寸的卷积核进行计算,以保留更多的信息,提升分类的准确率。

基于以上3点,SqueezeNet提出了基础模块

Fire Module。图中输入特征尺寸为H×W,通道数为M,依次经过一个Squeeze层与Expand层,然后进行融合处理。

SqueezeNet层:首先使用1×1卷积进行降维,特征图的尺寸不变,这里的S1小于M,达到了压缩的目的。

- Expand层:并行地使用1×1卷积与3×3卷积获得不同感受野的特征图,类似Inception模块,达到扩展的目的。

- Concat合并:对得到的两个特征图进行通道拼接,作为最终输出。·模块中的S1、e1与e2都是可调的超参,Fire Module默认e1=e2=4×S1。激活函数使用了ReLU函数。

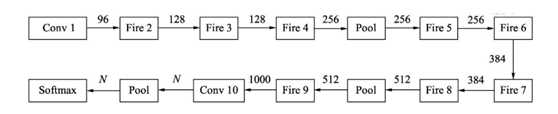

基于Fire

Module, SqueezeNet的网络结构如下图所示。

输入图像首先送入Conv 1,得到通道数为96的特征图,然后依次使用8个Fire Module,通道数也逐渐增加。图中横线上的值代表了通道数。最后一个卷积为Conv 10,输入通道数为N的特征图,N代表需要物体的类别数。

SqueezeNet是一个精心设计的轻量化网络,使用常见的模型压缩技术,如SVD、剪枝和量化等,可以进一步压缩该模型的大小。例如,使用Deep

Compresion技术对其进行压缩时,在几乎不损失性能的前提下,模型大小可以压缩到0.5MB。

基于其轻量化的特性,SqueezeNet可以广泛地应用到移动端,促进了目标检测技术在移动端的部署与应用。

2 MobileNet:深度可分离

2.1

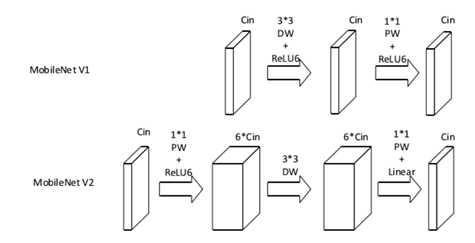

MobileNet V1

标准卷积在卷积时,同时考虑了图像的区域与通道信息,那么为什么不能分开考虑区域与通道呢?

基于此想法,诞生了深度可分离卷积(Depthwise Separable Convolution),将卷积的过程分为逐通道卷积与逐点1×1卷积两步。

逐通道卷积有如下几个特点:

1.卷积核参数量少。卷积核参数量为Ci×3×3,远少于标准卷积Ci×3×3×Co的数量。

2.通道之间相互独立,没有各通道间的特征融合,这也是逐通道卷积的核心思想,输出特征的每一个点只对应输入特征一个通道上的3×3大小的特征,而不是标准卷积中Ci×3×3大小。

3.由于只在通道间进行卷积,导致输入与输出特征图的通道数相同,无法改变通道数。

由于逐通道卷积通道间缺少特征的融合,并且通道数无法改变,因此后续还需要继续连接一个逐点的1×1的卷积,一方面可以融合不同通道间的特征,同时也可以改变特征图的通道数。

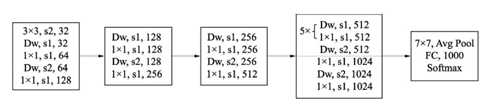

MobileNet

v1整体的网络是由上述深度可分离卷积基本单元组成的。与VGGNet类似,也是一个逐层堆叠式网络。

图中的Dw代表一个深度分解卷积,其后需要跟一个1×1卷积,s2代表步长为2的卷积,可以缩小特征图尺寸,起到与Pooling层一样的作用。

可以看到网络最后利用一个全局平均池化层,送入到全连接与Softmax进行分类预测。如果用于目标检测,只需要在之前的特征图上进行特征提取即可。

在基本的结构之外,MobileNet v1还设置了两个超参数,用来控制模型的大小与计算量,具体如下:

1. 宽度乘子:用于控制特征图的通道数,记做α,当α<1时,模型会变得更薄,可以将计算量减少为原来的α2。

2. 分辨率乘子:用于控制特征图的尺寸,记做ρ,在相应的特征图上应用该乘子,也可以有效降低每一层的计算量。

总体上,MobileNet

v1利用深度可分离的结构牺牲了较小的精度,带来了计算量与网络层参数的大幅降低,从而也减小了模型的大小,方便应用于移动端。

但MobileNet v1也有其自身结构带来的缺陷,主要有以下两点:

1.

模型结构较为复古,采用了与VGGNet类似的卷积简单堆叠,没有采用残差、特征融合等先进的结构。

2.

深度分解卷积中各通道相互独立,卷积核维度较小,输出特征中只有较少的输入特征,再加上ReLU激活函数,使得输出很容易变为0,难以恢复正常训练,因此在训练时部分卷积核容易被训练废掉。

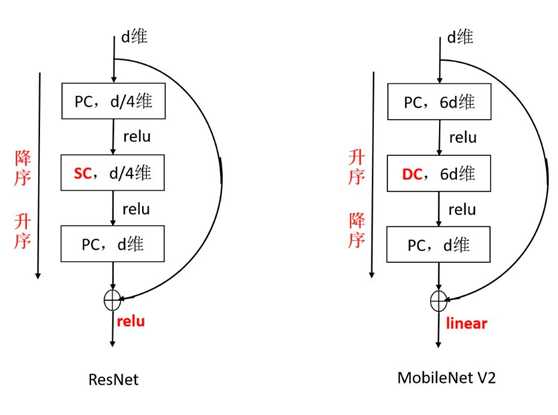

2.2 MobileNet V2

针对以上MobileNet

V1的缺点,2018年诞生的MobileNet

v2吸收了残差网络的思想,主要从两个方面改善了网络结构,提升了MobileNet的检测精度。

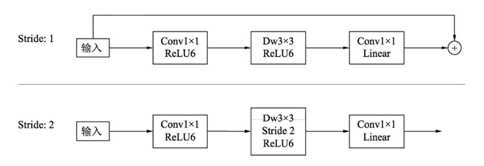

首先,MobileNet V2利用残差结构取代了原始的卷积堆叠方式,提出了一个Inverted ResidualBlock结构。

依据卷积的步长,该结构可分为两种情形,在步长为1时使用了残差连接,融合的方式为逐元素相加。

相比于MobileNet V1与原始的残差结构,这里有两点不同: 1. Inverted Residual Block结构

与 residuals block 相反,通常使用的 residuals block 是先经过 1×1 的卷积,降低 feature map 通道数,然后再通过3×3 卷积,最后重新经过 1×1 卷积将 feature map 通道数扩张回去,MobileNetV2 采用的方式是先对采用先升维,再降维的方法,这样做的理由是 MobileNetV2 将residuals block 的 bottleneck 替换为了 Depthwise Convolutions,因其参数少,提取的特征就会相对的少,如果再进行压缩的话,能提取的特征就更少了,因此MobileNetV2 就执行了扩张→卷积特征提取→压缩的过程。 2.

去掉ReLU6

深度可分离卷积得到的特征对应于低维空间,特征较少,如果后续接线性映射则能够保留大部分特征,而如果接非线性映射如ReLU,则会破坏特征,造成特征的损耗,从而使得模型效果变差。

针对此问题,MobileNetV2直接去掉了每一个Block中最后的ReLU6层,减少了特征的损耗,获得了更好的检测效果。

总体上,MobileNet V2在原结构的基础上进行了简单的修改,通过较少的计算量即可获得较高的精度,非常适合于移动端的部署。

主要特点

- 扩张(1x1 conv) -> 抽取特征(3x3 depthwise)-> 压缩(1x1 conv)

- 当且仅当输入输出具有相同的通道数时,才进行残余连接

- 在最后“压缩”完以后,没有接ReLU激活,作者认为这样会引起较大的信息损失

- 该结构在输入和输出处保持紧凑的表示,同时在内部扩展到更高维的特征空间,以增加非线性每通道变换的表现力。

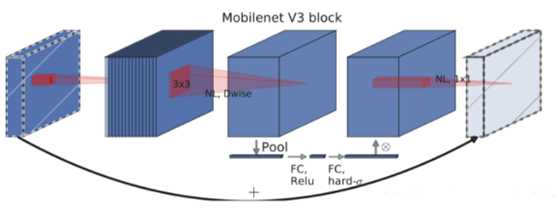

2.3 MobileNet V3

整体来说MobileNetV3有两大创新点:

1. 互补搜索技术组合:由资源受限的NAS执行模块级搜索,NetAdapt执行局部搜索。

资源受限的NAS(platform-aware NAS):计算和参数量受限的前提下搜索网络的各个模块,所以称之为模块级的搜索(Block-wise Search)。

NetAdapt:用于对各个模块确定之后网络层的微调。 对于模型结构的探索和优化来说,网络搜索是强大的工具。研究人员首先使用了神经网络搜索功能来构建全局的网络结构,随后利用了NetAdapt算法来对每层的核数量进行优化。

对于全局的网络结构搜索,研究人员使用了与Mnasnet中相同的,基于RNN的控制器和分级的搜索空间,并针对特定的硬件平台进行精度-延时平衡优化,在目标延时(~80ms)范围内进行搜索。随后利用NetAdapt方法来对每一层按照序列的方式进行调优。在尽量优化模型延时的同时保持精度,减小扩充层和每一层中瓶颈的大小。

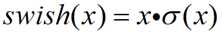

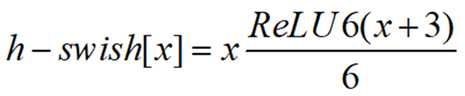

2. 网络结构改进:将最后一步的平均池化层前移并移除最后一个卷积层,引入h-swish激活函数。

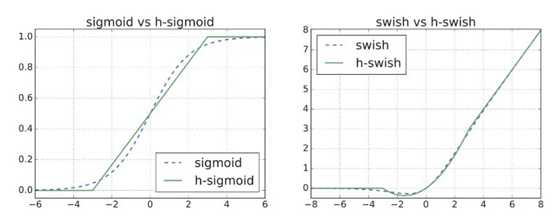

h-swish激活函数,计算公式如下:

作者发现swish激活函数能够有效提高网络的精度,然而,swish的计算量太大了。作者提出h-swish(hard version of swish)如下所示。

以下是平滑版本的Sigmoid/Swish和Hard版本的Sigmoid/Swish对比。

MobileNetV3是综合了以下三种模型的思想:

MobileNetV1的深度可分离卷积(depthwise separable convolutions)、MobileNetV2的具有线性瓶颈的逆残差结构(the inverted residual with linear bottleneck)和MnasNet的基于squeeze and excitation结构的轻量级注意力模型。

综合了以上三种结构的优点设计出了高效的MobileNetV3模块。

主要特点

swish非线性激活

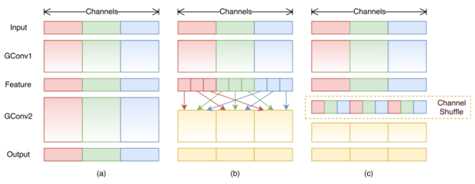

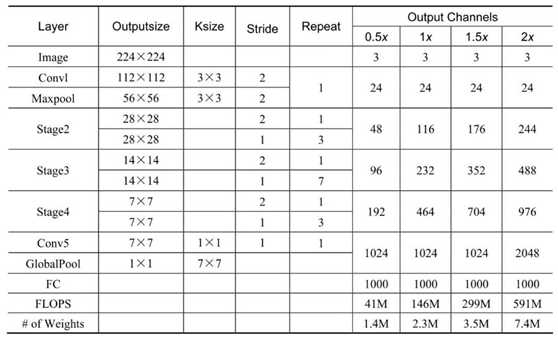

3 ShuffleNet:通道混洗

3.1 ShuffleNet V1

为了降低计算量,当前先进的卷积网络通常在3×3卷积之前增加一个1×1卷积,用于通道间的信息流通与降维。然而在ResNeXt、MobileNet等高性能的网络中,1×1卷积却占用了大量的计算资源。

2017年的ShuffleNet v1从优化网络结构的角度出发,利用组卷积与通道混洗(ChannelShuffle)的操作有效降低了1×1逐点卷积的计算量,是一个极为高效的轻量化网络。而2018年的ShuffleNet v2则在ShuffleNet v1版本的基础上实现了更为优越的性能。

当前先进的轻量化网络大都使用深度可分离卷积或者组卷积,以降低网络的计算量,但这两种操作都无法改变特征的通道数,因此还需要使用1×1卷积。

总体来讲,逐点的1×1卷积有如下两点特性:

1.

可以促进通道之间信息的融合,改变通道至指定维度。

2.

轻量化网络中1×1卷积占据了大量的计算,并且致使通道之间充满约束,一定程度上降低了模型的精度。

为了进一步降低计算量,ShuffleNet提出了通道混洗的操作,通过通道混洗也可以完成通道之间信息的融合。

如果没有逐点的1×1卷积或者通道混洗,最终输出的特征仅由一部分输入通道的特征计算得出,这种操作阻碍了信息的流通,进而降低了特征的表达能力。

因此,我们希望在一个组卷积之后,能够将特征图之间的通道信息进行融合,类似于下图中b的操作,将每一个组的特征分散到不同的组之后,再进行下一个组卷积,这样输出的特征就能够包含每一个组的特征,而通道混洗恰好可以实现这个过程。

通道混洗可以通过几个常规的张量操作巧妙地实现,主要有三个步骤:

- Reshape:首先将输入通道一个维度Reshape成两个维度,一个是卷积组数,一个是每个卷积组包含的通道数。

- Transpose:将扩展出的两维进行置换。

- Flatten:将置换后的通道Flatten平展后即可完成最后的通道混洗。

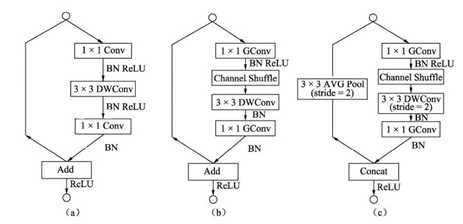

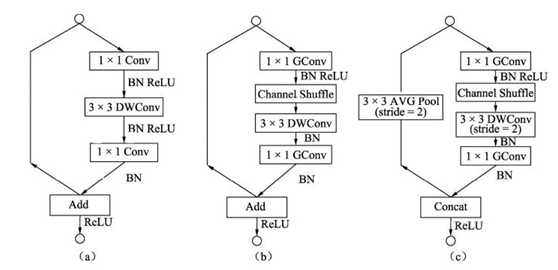

ShuffleNet基本结构单元

a图是一个带有深度可分离卷积的残差模块,这里的1×1是逐点的卷积。相比深度可分离卷积,1×1计算量较大。 b图则是基本的ShuffleNet基本单元,可以看到1×1卷积采用的是组卷积,然后进行通道的混洗,这两步可以取代1×1的逐点卷积,并且大大降低了计算量。3×3卷积仍然采用深度可分离的方式。 c图是带有降采样的ShuffleNet单元,在旁路中使用了步长为2的3×3平均池化进行降采样,在主路中3×3卷积步长为2实现降采样。另外,由于降采样时通常要伴有通道数的增加,ShuffleNet直接将两分支拼接在一起来实现了通道数的增加,而不是常规的逐点相加。 得益于组卷积与通道混洗,ShuffleNet的基本单元可以很高效地进行计算。

ShuffleNet V1整体结构

关于ShuffleNet V1的整体结构,有以下3点需要注意:

g代表组卷积的组数,以控制卷积连接的稀疏性。组数越多,计算量越少,因此在相同的计算资源,可以使用更多的卷积核以获取更多的通道数。

ShuffleNet在3个阶段内使用了其特殊的基本单元,这3个阶段的第一个Block的步长为2以完成降采样,下一个阶段的通道数是上一个的两倍。

深度可分离卷积虽然可以有效降低计算量,但其存储访问效率较差,因此第一个卷积并没有使用ShuffleNet基本单元,而是只在后续3个阶段使用。

总体上,ShuffleNet提出了一个巧妙的通道混洗模块,在几乎不影响准确率的前提下,进一步地降低了计算量,性能优于ResNet和Xception等网络,因此也更适合部署在移动设备上。

3.2 ShuffleNet V2

在2018年,旷视的团队进一步升级了ShuffleNet,提出了新的版本ShuffleNet v2。

相比于ShuffleNet v1, ShuffleNet v2进一步分析了影响模型速度的因素,提出了新的规则,并基于此规则,改善了原版本的不足。 原有的一些轻量化方法在衡量模型性能时,通常使用浮点运算量FLOP(s Floating PointOperations)作为主要指标。FLOPs是指模型在进行一次前向传播时所需的浮点计算次数,其单位为FLOP,可以用来衡量模型的复杂度。

然而,通过一系列实验发现ShuffleNet v2仅仅依赖FLOPs是有问题的,FLOPs近似的网络会存在不同的速度,还有另外两个重要的指标:内存访问时间(Memory Access Cost, MAC)与网络的并行度。 以此作为出发点,ShuffleNet v2做了大量的实验,分析影响网络运行速度的原因,提出了建立高性能网络的4个基本规则: (1)卷积层的输入特征与输出特征通道数相等时,MAC最小,此时模型速度最快。

(2)过多的组卷积会增加MAC,导致模型的速度变慢。

(3)网络的碎片化会降低可并行度,这表明模型中分支数量越少,模型速度会越快。

(4)逐元素(Element Wise)操作虽然FLOPs值较低,但其MAC较高,因此也应当尽可能减少逐元素操作。

以这4个规则为基础,可以看出ShuffleNet v1有3点违反了此规则:

- 在Bottleneck中使用了1×1组卷积与1×1的逐点卷积,导致输入输出通道数不同,违背了规则1与规则2。

- 整体网络中使用了大量的组卷积,造成了太多的分组,违背了规则3。

- 网络中存在大量的逐点相加操作,违背了规则4。

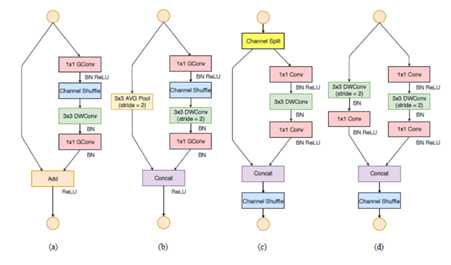

针对v1的问题,ShuffleNet v2提出了一种新的网络基本单元,具体如下图所示。图a与图b为v1版本的基础结构,图c与图d是v2提出的新结构。

ShuffleNet v2的基本单元有如下3点新特性: 1.

提出了一种新的Channel Split操作,将输入特征分成两部分,一部分进行真正的深度可分离计算,将计算结果与另一部分进行通道Concat,最后进行通道的混洗操作,完成信息的互通。 2.

整个过程没有使用到1×1组卷积,也避免了逐点相加的操作。

3.

在需要降采样与通道翻倍时,ShuffleNet v2去掉了Channel

Split操作,这样最后Concat时通道数会翻倍。

与ShuffleNet v1相比,ShuffleNet v2在全局平均池化之前增加了一个1×1卷积来融合特征。依据输出特征的通道数多少,ShuffleNet

v2也给出了多种配置,相应的模型精度、大小也会有所区别。

总体上,ShuffleNet

V2模型从更直接影响模型运行速度的角度出发,在速度与精度的平衡上达到了当前的最佳水平,非常适合于移动端模型的应用。

总结

SqueezeNet精心设计了一个压缩再扩展的模块,有效降低了卷积计算量;

MobileNet

系列则发挥了深度可分离卷积的优势,提升了卷积计算的效率。

ShuffleNet系列更进一步,在分组卷积的思想上提出了通道混洗操作,避免了大量1×1卷积的操作,可谓经典。

通常情况下,将这几种轻量化网络应用到检测框架中,在速度上均可以得到不同程度的提升。

以上是关于可见光遥感目标检测主要难点与研究方法概述的主要内容,如果未能解决你的问题,请参考以下文章