《爬取知网文献信息》中代码的一些优化

Posted edisonfish

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了《爬取知网文献信息》中代码的一些优化相关的知识,希望对你有一定的参考价值。

哈喽大家好,我是咸鱼

之前写了一篇关于文献爬虫的文章Python爬虫实战(5) | 爬取知网文献信息

文章发布之后有很多小伙伴给出了一些反馈和指正,在认真看了小伙伴们的留言之后,咸鱼对代码进行了一些优化

优化的代码在文末,欢迎各位小伙伴给出意见和指正

问题

-

pycharm 设置 Edge 驱动器的环境报错

“module \'selenium.webdriver\' has no attribute \'EdgeOptions”

如果浏览器驱动已经下载,而放在了合适的位置(比如添加到环境变量里,或者放在了 python.exe 同级目录中)

那就可能是因为你使用的是较老的版本,Edge的选项已经被更新了。 建议更新 selenium 包以获得最佳的Edge选项支持

可以通过以下命令更新 selenium,建议更新到 4.6 以上版本

pip install -U selenium

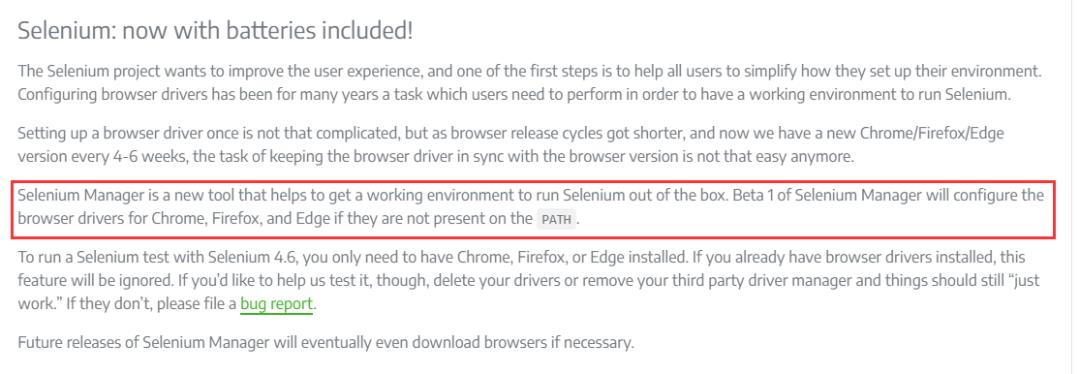

因为 selenium 4.6 版本之后内置了一个组件:Selenium Manager

根据官网介绍,这个 Selenium Manager 可以帮助你获得一个运行 Selenium 的开箱即用的环境

如果在 PATH 中没有找到 Chrome、Firefox 和 Edge 的驱动,Selenium Manager的 Beta 1版将为它们配置。不需要额外的配置

这就意味着自己不需要再去下载安装浏览器驱动

中文文档链接:

https://www.selenium.dev/zh-cn/documentation/webdriver/getting_started/install_drivers/

-

只能爬取20倍数的文献篇数

有位粉丝发现每次爬取都是爬取 20 倍数的文献篇数(20、40、60)。假设要爬取 21 篇,但是却爬到了 40 篇

排查的时候发现是代码中的逻辑有一些 bug ,已经优化

-

获取不到网页的 xpath 元素

第一种可能是网页中的 xpath 元素并不是一成不变的,要参考自己的浏览器上的 Xpath。在我这可能是div[3],在你那可能就不是这个了,所以说需要自己先定位一遍

第二种可能是网页加载太慢导致爬虫爬取不到,这种情况的话可以增加等待超时时间

-

关于网页加载太慢导致程序爬取不到元素报超时异常或者元素不存在异常

我的代码中用的都是显示等待 + 强制等待结合的方式。如果还是不行,小伙伴们可以自行设置超时时间

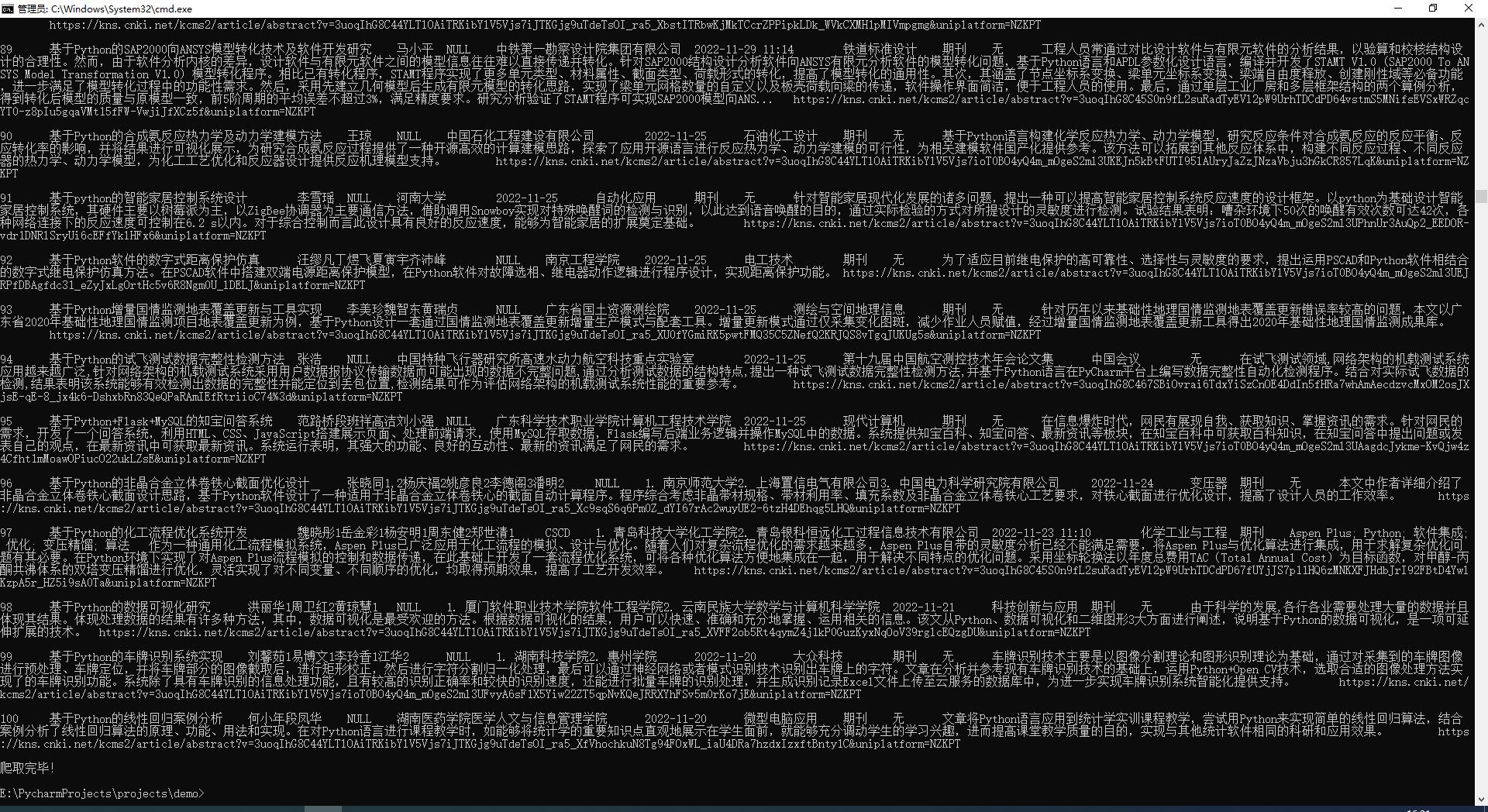

优化后代码

下面给出优化后的源码

import time from selenium import webdriver from selenium.webdriver.support.ui import WebDriverWait from selenium.webdriver.support import expected_conditions as EC from selenium.webdriver.common.by import By from selenium.webdriver.common.desired_capabilities import DesiredCapabilities from urllib.parse import urljoin def open_page(driver, theme): # 打开页面 driver.get("https://www.cnki.net") # 传入关键字 WebDriverWait(driver, 100).until( EC.presence_of_element_located((By.XPATH, \'\'\'//*[@id="txt_SearchText"]\'\'\'))).send_keys(theme) # 点击搜索 WebDriverWait(driver, 100).until( EC.presence_of_element_located((By.XPATH, "/html/body/div[2]/div[2]/div/div[1]/input[2]"))).click() time.sleep(3) # 点击切换中文文献 WebDriverWait(driver, 100).until( EC.presence_of_element_located((By.XPATH, "/html/body/div[3]/div[1]/div/div/div/a[1]"))).click() time.sleep(3) # 获取总文献数和页数 res_unm = WebDriverWait(driver, 100).until(EC.presence_of_element_located( (By.XPATH, "/html/body/div[3]/div[2]/div[2]/div[2]/form/div/div[1]/div[1]/span[1]/em"))).text # 去除千分位里的逗号 res_unm = int(res_unm.replace(",", \'\')) page_unm = int(res_unm / 20) + 1 print(f"共找到 res_unm 条结果, page_unm 页。") return res_unm def crawl(driver, papers_need, theme): # 赋值序号, 控制爬取的文章数量 count = 1 # 当爬取数量小于需求时,循环网页页码 while count <= papers_need: # 等待加载完全,休眠3S time.sleep(3) title_list = WebDriverWait(driver, 10).until(EC.presence_of_all_elements_located((By.CLASS_NAME, "fz14"))) # 循环网页一页中的条目 for i in range(len(title_list)): try: if (count % 20) != 0: term = count % 20 # 本页的第几个条目 else: term = 20 title_xpath = f"/html/body/div[3]/div[2]/div[2]/div[2]/form/div/table/tbody/tr[term]/td[2]" author_xpath = f"/html/body/div[3]/div[2]/div[2]/div[2]/form/div/table/tbody/tr[term]/td[3]" source_xpath = f"/html/body/div[3]/div[2]/div[2]/div[2]/form/div/table/tbody/tr[term]/td[4]" date_xpath = f"/html/body/div[3]/div[2]/div[2]/div[2]/form/div/table/tbody/tr[term]/td[5]" database_xpath = f"/html/body/div[3]/div[2]/div[2]/div[2]/form/div/table/tbody/tr[term]/td[6]" title = WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.XPATH, title_xpath))).text authors = WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.XPATH, author_xpath))).text source = WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.XPATH, source_xpath))).text date = WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.XPATH, date_xpath))).text database = WebDriverWait(driver, 10).until( EC.presence_of_element_located((By.XPATH, database_xpath))).text # 点击条目 title_list[i].click() # 获取driver的句柄 n = driver.window_handles # driver切换至最新生产的页面 driver.switch_to.window(n[-1]) time.sleep(3) # 开始获取页面信息 title = WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.XPATH ,"/html/body/div[2]/div[1]/div[3]/div/div/div[3]/div/h1"))).text authors = WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.XPATH ,"/html/body/div[2]/div[1]/div[3]/div/div/div[3]/div/h3[1]"))).text institute = WebDriverWait(driver, 10).until(EC.presence_of_element_located( (By.XPATH, "/html/body/div[2]/div[1]/div[3]/div/div/div[3]/div/h3[2]"))).text abstract = WebDriverWait(driver, 10).until( EC.presence_of_element_located((By.CLASS_NAME, "abstract-text"))).text try: keywords = WebDriverWait(driver, 10).until( EC.presence_of_element_located((By.CLASS_NAME, "keywords"))).text[:-1] cssci = WebDriverWait(driver, 10).until( EC.presence_of_element_located((By.XPATH, "/html/body/div[2]/div[1]/div[3]/div/div/div[1]/div[1]/a[2]"))).text except: keywords = \'无\' cssci = \'NULL\' url = driver.current_url res = f"count\\ttitle\\tauthors\\tcssci\\tinstitute\\tdate\\tsource\\tdatabase\\tkeywords\\tabstract\\turl".replace( "\\n", "") + "\\n" print(res) \'\'\'写入文件,有需要的小伙伴可以去掉注释\'\'\' # with open(f\'CNKI_theme.tsv\', \'a\', encoding=\'gbk\') as f: # f.write(res) except: print(f" 第count 条爬取失败\\n") # 跳过本条,接着下一个 continue finally: # 如果有多个窗口,关闭第二个窗口, 切换回主页 n2 = driver.window_handles if len(n2) > 1: driver.close() driver.switch_to.window(n2[0]) # 爬完一篇计数加 1 count += 1 if count > papers_need: break WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.XPATH, "//a[@id=\'PageNext\']"))).click() if __name__ == "__main__": print("开始爬取!") # get直接返回,不再等待界面加载完成 desired_capabilities = DesiredCapabilities.CHROME desired_capabilities["pageLoadStrategy"] = "none" # 设置驱动器的环境 options = webdriver.EdgeOptions() # 设置chrome不加载图片,提高速度 options.add_experimental_option("prefs", "profile.managed_default_content_settings.images": 2) # 设置不显示窗口 options.add_argument(\'--headless\') # 创建一个浏览器驱动器 driver = webdriver.Edge(options=options) # 输入需要搜索的主题 # theme = input("请输入你要搜索的期刊名称:") theme = "python" # 设置所需篇数 # papers_need = int(input("请输入你要爬取篇数:")) papers_need = 100 res_unm = int(open_page(driver, theme)) # 判断所需是否大于总篇数 papers_need = papers_need if (papers_need <= res_unm) else res_unm crawl(driver, papers_need, theme) print("爬取完毕!") # 关闭浏览器 driver.close()

知网的引文网络工具用法

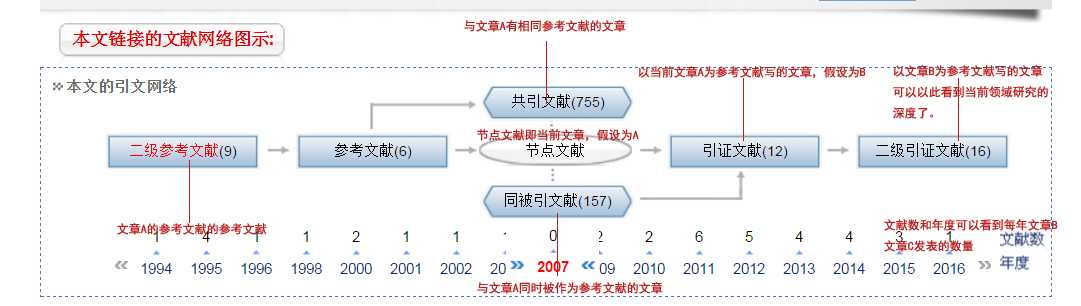

引文网络的构成

在知网的文献主页界面中,有一个本文的引文网络功能模块。

在这个模块中,所有的相关文献被按照发表时间顺序进行呈现,并显示了当年发表的文章数量。

以当前的文献为中心,称之为 节点文献,假设用

文献A表示,那么作为文献A,他的参考文献自然是在文献A发表之前的文献,称之为参考文献(文献A的参考文献);参考文献的参考文献则称之为

二级参考文献;目光回到当前的文献A,作为与其同一时期发表的文献,他们可能参考了同样的参考文献,因此这些文献被称之为

共引文献;文献A发表之后,可以作为后来的学者的参考文献,于是凡是参考了文献A的文献,就被叫做

引证文献;与之前一样,后面继续在引证文献上继续参考的文献,被叫做

二级印证文献;这里,作为与文献A同时期发表的文献,如果后来的文献即引用了文献A,又引用了这些文献,那么他们就被称之为

同被引文献。

总结

从整个引文网络的构成来看,知网利用其强大的数据库储备,为我们建立了文献之间的引用关系,从时间维度,关联程度方面做出了非常有价值的引文分析工作,为我们省去了大量的无意义的盲目查找文献工作。

从时间维度上,我们可以看到我们所检索的关键词相关领域的研究成果数量的变动情况,进而分析该领域的研究进展。

通过梳理出文献之间的引文关联网络,我们可以顺藤摸瓜,以当前文献为节点,在时间维度上,向前向后,以及纵向总共四个方向的文献探索,这样的关联分析,给我们带来了极大的便利。

知网是一个非常有用的文献检索工具,或许你现在还和我一样,仍然把它当作一个简单的类似于浏览器搜索工具,但请你在研究过程中,去深入思考,为什么知网会提供这么多附加的功能?活到老学到老,所谓不知者无畏,只有不断地发现自己的无知,才能获得新知识。共勉!

以上是关于《爬取知网文献信息》中代码的一些优化的主要内容,如果未能解决你的问题,请参考以下文章