Python3 爬虫06_robots.txt查看网站爬取限制情况

Posted 奔跑的金鱼

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Python3 爬虫06_robots.txt查看网站爬取限制情况相关的知识,希望对你有一定的参考价值。

大多数网站都会定义robots.txt文件来限制爬虫爬去信息,我们在爬去网站之前可以使用robots.txt来查看的相关限制信息

例如:

我们以【CSDN博客】的限制信息为例子

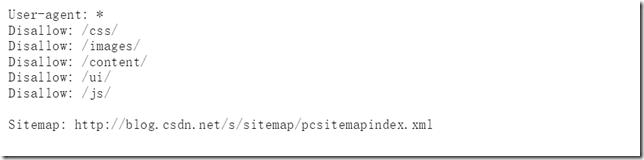

在浏览器输入:https://blog.csdn.net/robots.txt

获取到信息如下:

从上图我们可以看出:

①该网站无论用户使用哪种代理都允许爬取

②但是当爬取/css,/images…等链接的时候是禁止的

③我们可以看到还存在一个网址Sitemap,j具体解析如下:

网站提供的Sitemap文件(即网站地图)可以帮助网站定位最新的内容,则无须爬取每一个网页,虽然Sitemap文件提供了一种爬取网站的有效方式,但是我们仍然需要对其谨慎处理,因为该文件经常存在缺失,过期和不完整。

以上是关于Python3 爬虫06_robots.txt查看网站爬取限制情况的主要内容,如果未能解决你的问题,请参考以下文章