Python网络爬虫学习建议,初学者需要哪些准备

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Python网络爬虫学习建议,初学者需要哪些准备相关的知识,希望对你有一定的参考价值。

了解html和简单的js,只有了解你要抓取的页面,在获取后才能有效分析。建议系统学习html这个很简单;js较复杂不必多看,可以边分析边百度资料学习。

python方面,了解urllib和urllib2两个库,在抓取页面要用到。Cookielib这个库配合urllib2可以封装opener,在需要cookie时可以自动解决,建议了解一些,会封装opener即可。re正则表达式库可以帮助你高效的从页面中分离要的内容,正则表达式要略知一二。

学习一些抓包知识,有些网站防爬,需要人工浏览一些页面,抓取数据包分析防爬机制,然后做出应对措施。比如解决cookie问题,或者模拟设备等。

作为初学者,学会以上知识基本上爬取任何网站都没问题了,但更重要的是耐心和细心。毕竟爬取网站时并不知道网站已开始是怎么设计的,有哪些小坑,分析起来这些还是比较烧脑,但是分析成功很有成就感。

参考技术A 现在之所以有这么多的小伙伴热衷于爬虫技术,无外乎是因为爬虫可以帮我们做很多事情,比如搜索引擎、采集数据、广告过滤等,以Python为例,Python爬虫可以用于数据分析,在数据抓取方面发挥巨大的作用。但是这并不意味着单纯掌握一门Python语言,就对爬虫技术触类旁通,要学习的知识和规范还有喜很多,包括但不仅限于HTML 知识、HTTP/HTTPS 协议的基本知识、正则表达式、数据库知识,常用抓包工具的使用、爬虫框架的使用等。而且涉及到大规模爬虫,还需要了解分布式的概念、消息队列、常用的数据结构和算法、缓存,甚至还包括机器学习的应用,大规模的系统背后都是靠很多技术来支撑的。

零基础如何学爬虫技术?对于迷茫的初学者来说,爬虫技术起步学习阶段,最重要的就是明确学习路径,找准学习方法,唯有如此,在良好的学习习惯督促下,后期的系统学习才会事半功倍,游刃有余。

用Python写爬虫,首先需要会Python,把基础语法搞懂,知道怎么使用函数、类和常用的数据结构如list、dict中的常用方法就算基本入门。作为入门爬虫来说,需要了解 HTTP协议的基本原理,虽然 HTTP 规范用一本书都写不完,但深入的内容可以放以后慢慢去看,理论与实践相结合后期学习才会越来越轻松。关于爬虫学习的具体步骤,我大概罗列了以下几大部分,大家可以参考:

网络爬虫基础知识:

爬虫的定义

爬虫的作用

Http协议

基本抓包工具(Fiddler)使用

Python模块实现爬虫:

urllib3、requests、lxml、bs4 模块大体作用讲解

使用requests模块 get 方式获取静态页面数据

使用requests模块 post 方式获取静态页面数据

使用requests模块获取 ajax 动态页面数据

使用requests模块模拟登录网站

使用Tesseract进行验证码识别

Scrapy框架与Scrapy-Redis:

Scrapy 爬虫框架大体说明

Scrapy spider 类

Scrapy item 及 pipeline

Scrapy CrawlSpider 类

通过Scrapy-Redis 实现分布式爬虫

借助自动化测试工具和浏览器爬取数据:

Selenium + PhantomJS 说明及简单实例

Selenium + PhantomJS 实现网站登录

Selenium + PhantomJS 实现动态页面数据爬取

爬虫项目实战:

分布式爬虫+ Elasticsearch 打造搜索引擎

Python爬虫9大入门学习知识点

爬虫是一种技术实现的功能,大部分编程语言都可以实现爬虫,但是对于初学者来说,想要快速学习爬虫技术,建议大家学习Python爬虫。Python编程语言相对于Java要更简单入门更容易,同时相对PHP使用范围更广泛,有利于后期的学习拓展知识。对于零基础想学习Python爬虫的同学应该掌握哪些知识,遵循怎样的学习路线呢?

1、掌握Python编程能基础

想要学习爬虫,首先要充分掌握Python编程技术相关的基础知识。爬虫其实就是遵循一定的规则获取数据的过程,所以在学习Python知识的过程中一定要重点学习其中的数据类型、第三方库的应用以及正则表达式相关的知识内容。

2、了解爬虫的基本原理及过程

爬虫的工作原理其实就是模拟我们通过浏览器获取网页信息的过程,无外乎“发送请求—获得页面—解析页面—抽取并储存内容”从这个过程中,我们可以获取到的信息是,在爬虫工作中需要涉及到前端页面相关的知识,网络协议相关的知识,以及数据存储的相关知识。因此根据这个过程我还需要进一步掌握的技术包括。

3、前端和网络知识必不可少

使用爬虫接触到最多的就是前端页面、网络以及数据这三个关键词,其实关于前端知识并不需要掌握太多,只要了解HTML、CSS、JS即可。对于网络主要掌握http协议中的POST/GET相关的知识并且在分析目标网页时正常的使用。

4、学习Python包并实现基本的爬虫过程

Python中有非常多关于爬虫的包,这也是为什么大家都喜欢学习Python来实现爬虫的重要原因之一。Python爬虫包有urllib、requests、bs4、scrapy、pyspider 等。当你入门学习时,建议大家从最基本的建议你从requests+Xpath 开始,requests 负责连接网站,返回网页,Xpath 用于解析网页,便于抽取数据。此外 BeautifulSoup相比Xpath会更加简单。

5、了解非结构化数据存储

通过爬虫抓取到的数据可以直接用文档的形式存在本地,也可以存入数据库中,对于少量数据,可以直接通过Python语法或者pandas将数据存在text、csv文件中。当然一般抓取到的数据有时并非自己理想中的数据,可能会有确实,错误等。如果想要进一步处理数据,可以通过学习pandas包实现数据的处理,更深层次的数据处理则属于数据分析领域的知识了。

6、掌握各种技巧应对特殊网站的反爬措施

虽然爬虫可以直接实现静态页面的抓取,但是爬虫过程中难免会遇到一些网站设置有反爬虫措施,例如被网站封IP、UserAgent访问限制、各种动态加载等等,此时就必须学习一些反反爬虫那个的技巧来应对,常见的技巧设置访问频率控制、使用代理IP池、抓包、验证码的OCR处理等等。

7、学习爬虫框架搭建工程化的爬虫

scrapy 是一个功能非常强大的爬虫框架,它不仅能便捷地构建request,还有强大的 selector 能够方便地解析 response,然而它最让人惊喜的还是它超高的性能,让你可以将爬虫工程化、模块化。

8、学习数据库基础,应用大规模的数据存储

当爬虫抓取数据量非常大的时候,用上文提到的文档存储形式已经不能够应对了,因此大家需要掌握相应的数据库知识。可以使用MongoDB、MySQL等等。MongoDB 可以方便你去存储一些非结构化的数据,比如各种评论的文本,图片的链接等等。

9、分布式爬虫实现大规模并发采集

分布式爬虫主要是用来应对爬取海量数据的问题。其实就是利用多线程的原理让多个爬虫同时工作,你需要掌握Scrapy + MongoDB + Redis 这三种工具。Redis主要是用来存储要爬取的网页队列即任务队列。

关于Python技术储备

学好 Python 不论是就业还是做副业赚钱都不错,但要学会 Python 还是要有一个学习规划。最后大家分享一份全套的 Python 学习资料,给那些想学习 Python 的小伙伴们一点帮助!

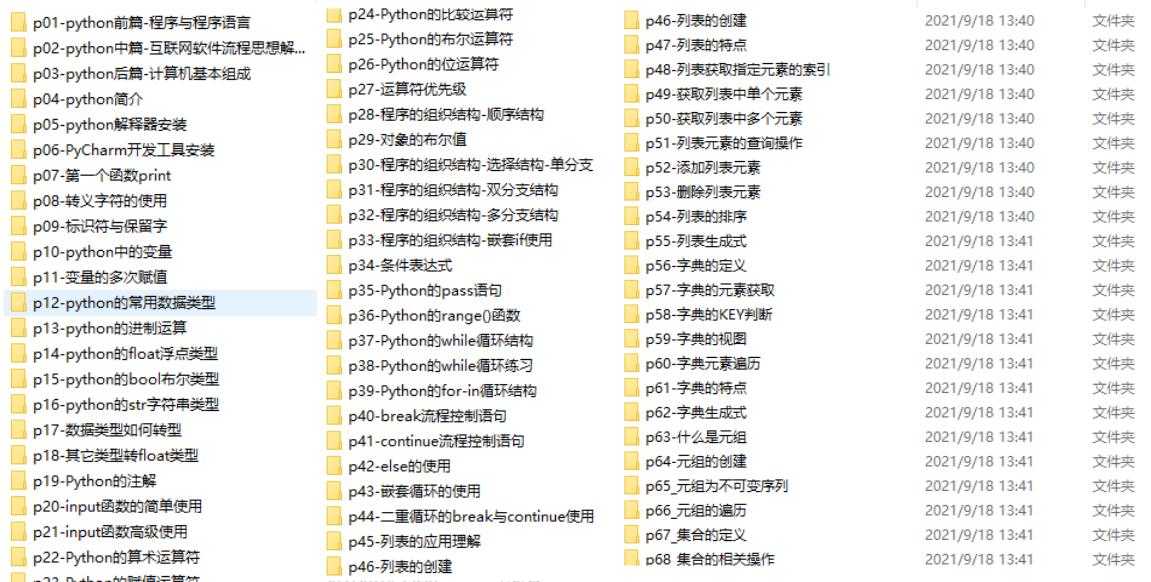

一、Python所有方向的学习路线

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、学习软件

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,给大家节省了很多时间。

三、入门学习视频

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

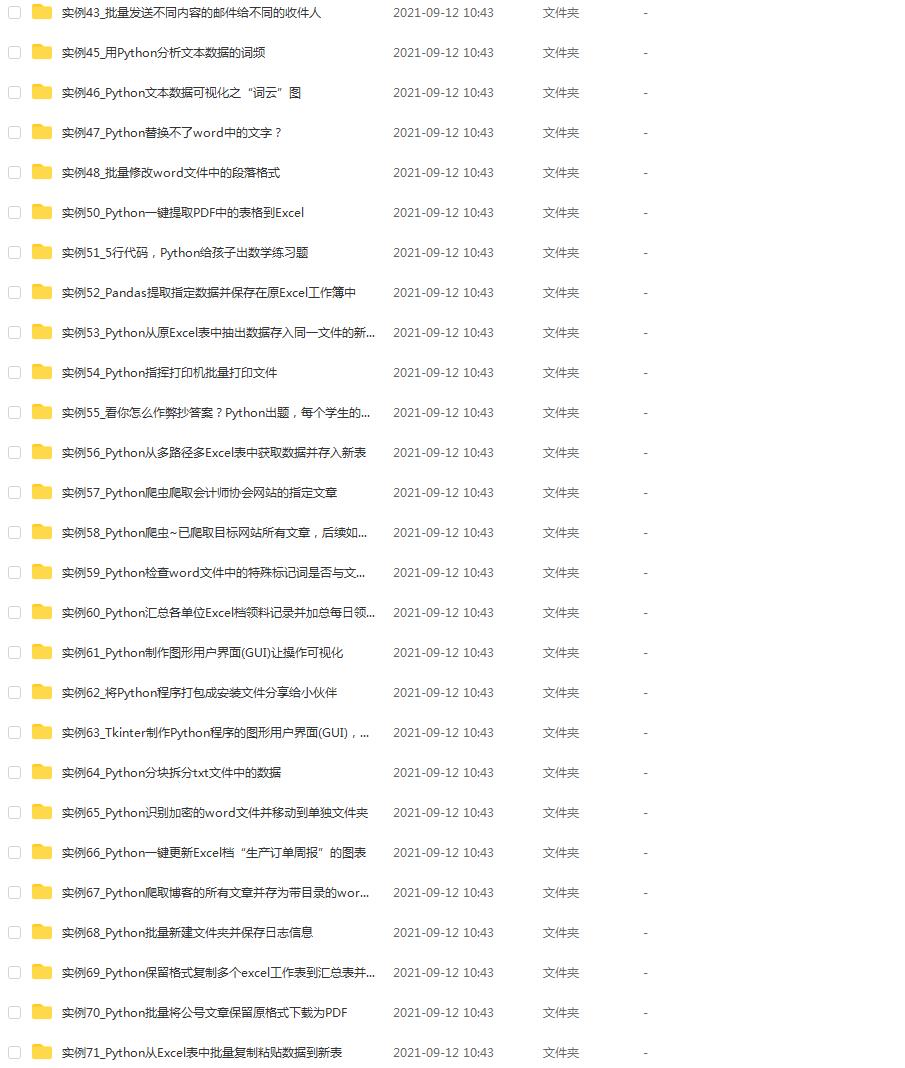

四、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

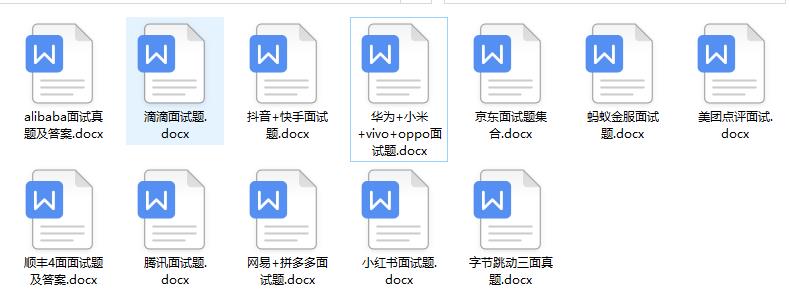

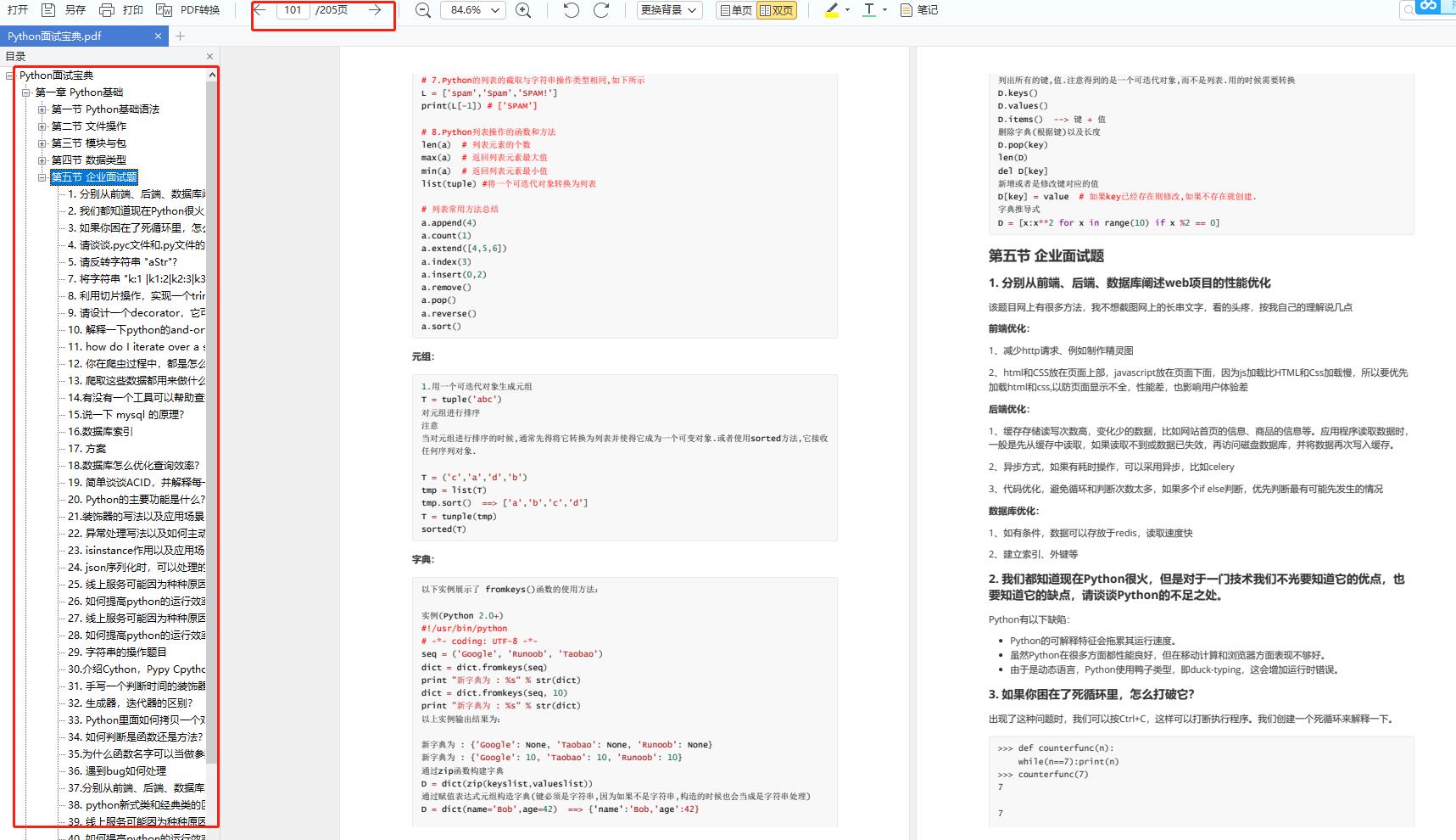

五、面试资料

我们学习Python必然是为了找到高薪的工作,下面这些面试题是来自阿里、腾讯、字节等一线互联网大厂最新的面试资料,并且有阿里大佬给出了权威的解答,刷完这一套面试资料相信大家都能找到满意的工作。

这份完整版的Python全套学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

以上是关于Python网络爬虫学习建议,初学者需要哪些准备的主要内容,如果未能解决你的问题,请参考以下文章