网站有两个死链,在站长后台如何提交?

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了网站有两个死链,在站长后台如何提交?相关的知识,希望对你有一定的参考价值。

我按照站长工具要求,在服务器上上传死链文件,silian.txt,

然后在站长后台提交的站点域名/silian.txt文件,最终提示验证失败。

请大神们指点一下。那个环节出现了错误,能上传截图详解的话就更好了,谢谢!

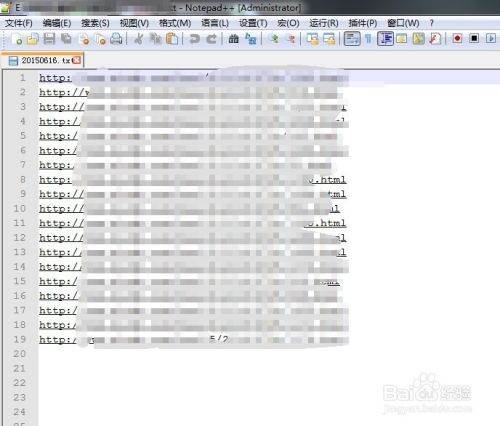

首先,我们需要将自己收集到的网站死链,用一个TXT保存好,注意保存的时候,要一行一个连接,并且不能有空行。收集好死链之后,我们还需要将死链上传到服务器的根目录。

请点击输入图片描述

然后,我们需要打开百度站长平台页面,输入自己的账号密码,并且登录。

请点击输入图片描述

进入到百度站长平台后台之后,我们会发现在左边有一个【死链提交】项目。找到这个【死链提交】之后,我们就可以点进去进入到下一步。

请点击输入图片描述

到了死链提交这一步,我们会看到有一个添加新数据的按钮。我们可以点击这个按钮,添加我们新的死链数据,也就是前面准备好的死链。

请点击输入图片描述

点击添加数据按钮,我们就会进来这一步,这个时候,我们只要按照提示的,将死链的更新周期、死链的文件地址填进去即可。

请点击输入图片描述

6

最后,我们可以点击【提交】按钮,当出现这个页面的时候,一切就大功告成了。

请点击输入图片描述

注意事项

死链的文件地址,是填写上传到服务器之后形成的文件地址。

谢谢,我试试

参考技术A 最近百度站长工具有些卡顿,或许是自己网速的问题,也或许是百度后台的问题提交错误的话,别着急,多提交几次试一试追问

谢谢

php如何防止网站内容被采集

1、限制IP地址单位时间的访问次数分析:没有哪个常人一秒钟内能访问相同网站5次,除非是程序访问,而有这种喜好的,就剩下搜索引擎爬虫和讨厌的采集器了。

弊端:一刀切,这同样会阻止搜索引擎对网站的收录

适用网站:不太依靠搜索引擎的网站

采集器会怎么做:减少单位时间的访问次数,减低采集效率

2、屏蔽ip

分析:通过后台计数器,记录来访者ip和访问频率,人为分析来访记录,屏蔽可疑Ip。

弊端:似乎没什么弊端,就是站长忙了点

适用网站:所有网站,且站长能够知道哪些是google或者百度的机器人

采集器会怎么做:打游击战呗!利用ip代理采集一次换一次,不过会降低采集器的效率和网速(用代理嘛)。

3、利用js加密网页内容

Note:这个方法我没接触过,只是从别处看来

分析:不用分析了,搜索引擎爬虫和采集器通杀

适用网站:极度讨厌搜索引擎和采集器的网站

采集器会这么做:你那么牛,都豁出去了,他就不来采你了

4、网页里隐藏网站版权或者一些随机垃圾文字,这些文字风格写在css文件中

分析:虽然不能防止采集,但是会让采集后的内容充满了你网站的版权说明或者一些垃圾文字,因为一般采集器不会同时采集你的css文件,那些文字没了风格,就显示出来了。

适用网站:所有网站

采集器会怎么做:对于版权文字,好办,替换掉。对于随机的垃圾文字,没办法,勤快点了。

5、用户登录才能访问网站内容

分析:搜索引擎爬虫不会对每个这样类型的网站设计登录程序。听说采集器可以针对某个网站设计模拟用户登录提交表单行为。

适用网站:极度讨厌搜索引擎,且想阻止大部分采集器的网站

采集器会怎么做:制作拟用户登录提交表单行为的模块 参考技术A 1,robots

2,用iframe嵌套,js生成具体数据

3,内容标注不可转载,用法律维权

以上是关于网站有两个死链,在站长后台如何提交?的主要内容,如果未能解决你的问题,请参考以下文章