python2.7 爬虫_爬取小说盗墓笔记章节及URL并导入MySQL数据库_20161201

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了python2.7 爬虫_爬取小说盗墓笔记章节及URL并导入MySQL数据库_20161201相关的知识,希望对你有一定的参考价值。

1、爬取页面 http://www.quanshu.net/book/9/9055/

2、用到模块urllib(网页下载),re正则匹配取得title及titleurl,urlparse(拼接完整url),MySQLdb(导入MySQL) 数据库

3、for 循环遍历列表 取得盗墓笔记章节title 和 titleurl

4、try except 异常处理

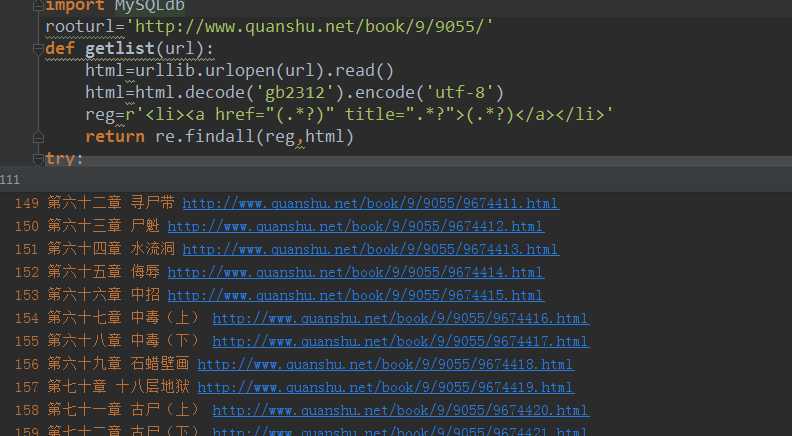

5、python 代码

#-*-coding: utf-8 -*-

import urllib

import re

import urlparse

import MySQLdb

rooturl=‘http://www.quanshu.net/book/9/9055/‘

def getlist(url):

html=urllib.urlopen(url).read()

html=html.decode(‘gb2312‘).encode(‘utf-8‘)

reg=r‘<li><a href="(.*?)" title=".*?">(.*?)</a></li>‘

return re.findall(reg,html)

try:

conn = MySQLdb.connect(host=‘localhost‘, user=‘root‘, passwd=‘123456‘, db=‘local_db‘, port=3306, charset=‘utf8‘)

with conn:

cursor = conn.cursor()

drop_table_sql=‘DROP TABLE IF EXISTS daomubiji‘

cursor.execute(drop_table_sql)

conn.commit()

create_table_sql = ‘‘‘

CREATE TABLE daomubiji (

ID INT(11),

title VARCHAR(255),

titleurl VARCHAR(255)

)ENGINE=INNODB DEFAULT CHARSET=utf8

‘‘‘

cursor.execute(create_table_sql)

conn.commit()

urllist = getlist(rooturl)

#href属性取得的url不完整 仅取出了完整url的右半段 因此下面for循环变量名起名righturl

ID=0

for righturl in urllist:

title = righturl[1]

newurl = righturl[0]

#urlparse 模块的urlparse.urljoin方法将righturl 按照rooturl格式拼接成完整url

titleurl = urlparse.urljoin(rooturl, newurl)

ID+=1

print ID,title, titleurl

cursor.execute("INSERT INTO daomubiji values(%s,%s,%s)", (ID,title, titleurl))

conn.commit()

print "输入了"+ str(ID) +"条数据"

except MySQLdb.Error:

print "连接失败!"

代码执行情况:

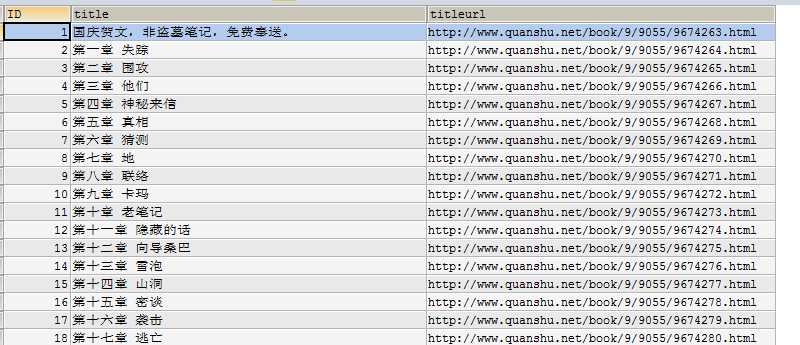

6、MySQL数据库查询是否导入成功

SELECT * FROM daomubiji

7、执行成功

以上是关于python2.7 爬虫_爬取小说盗墓笔记章节及URL并导入MySQL数据库_20161201的主要内容,如果未能解决你的问题,请参考以下文章