机器学习-吴恩达课程笔记

Posted 薛定谔的小冰

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了机器学习-吴恩达课程笔记相关的知识,希望对你有一定的参考价值。

- z-score归一化 通过正态分布来放缩范围,

- 注意任何放缩 在x缩小完范围以后都要改变原先的公式即y,不能只改变x的范围。

- 缩放基本没有副作用。

- 多项式回归 表明 特征值的数量不一定等于曲线公式中x的数量,如上图,有两个x但是特征值只有一个,其实之所以会产生这个疑问还是在于x没有加下标,其实这两个x下标是一样的。另外要强调的的事特征值是x的维度不是w,w只是参数。对于x的每个维度采用的曲线或直线模型也不一定相同。所以并不是什么时候都可以向量化,只有在模型(这里指公式)对于所有维度都一样时才可以。

- 对于一个成熟分类算法来说,不能在增加一个同类数据(或者说一个无关紧要,本来我们认为不会改变结果的数据)后改变原有数据的分类状况,例如原先a-d,ab是1类,cd是2类,同样的算法,当我们增加一个同类的e时,如果此时c被移出2类进入1类,那么这个算法就是不成熟的或者说不成功的;再举个例子,当判断猫狗的算法学习以后,我们在数据集中再添加一直很标准的猫以后,这只猫被分配到了猫,这个是对的,但是之前的一只猫被分到了狗,那这就是不对的。这也是线性回归不能用于分类算法的愿意。

- 逻辑回归 g(z)这个公式是可以把它理解为一个函数,形参是z也就是wx+b值域的值,输出是种类,因为逻辑回归是归类算法,需要根据给定的一堆数值(特征值组合),把这些数值归类成不同的种类,其实我们回头去看逻辑回归的公式再结合老师上节课尝试用线性回归拟合数据的操作,会发现其实我们只是在用这个新的公式拟合数据,你可以会问为什么不用g(z)直接去拟合,因为g(z)本身并不带可变的参数,而老师之所以把结果的f(x)公式拆成z=wx+b和g(z)就是方便我们理解f(x)这个模型是哪里来的,而且更重要的是并不是所有的z都可以由x线性回归拟合得到,所以有可能是其他回归方式,z和x的公式是未知的,但是这与f(z)无关,f(z)才是实现分类的关键,而f(z)加上z和x的公式是为了让sigmod这个函数模型(和线性回归一样都是模型)变形成更精确的函数以更好的拟合数据。其实分类算法的逻辑回归和回归算法的线性回归都在一个一件事,用更好的曲线拟合数据,逻辑回归也只是换了另一个更好的模型而已。这个用f(z)加上z和x的公式这种有别于之前我们学习的算法时模式,一个是因为z和x的公式不确定但是由于种类就两种所以最后概率的函数样子是基本确定的,二是为了更好解释。

- 逻辑回归中f(x)等于0-1间的数如0.7 ,他代表了具有x特征值的物体有70%的概率属于1类,也可以说有30%的概率属于0类。也就说f(x)的值域实际上就是概率。而sigmod函数本身是个概率函数(不是概率分布)

- P()实际上表示的是概率论中的概率,这个分号表示w,b是计算相关的参数,在给定输入样例x时 输出种类y=1的概率

- 逻辑回归的sigmod函数和线性回归一样,本身都有适用范围,他只适合随着特征值增大,种类变化这种情况,也可以说是决策边界单一,虽然只有两种分类但是边界不一定只有一个,如0-0.2是0类,0.2-0.8是1类,0.8-1是0类这种就不适合用sigmod函数拟合。

机器学习- 吴恩达Andrew Ng Coursera学习总结合集,编程作业技巧合集

Coursera课程地址

因为Coursera的课程还有考试和论坛,后续的笔记是基于Coursera

https://www.coursera.org/learn/machine-learning/home/welcome

课程总结

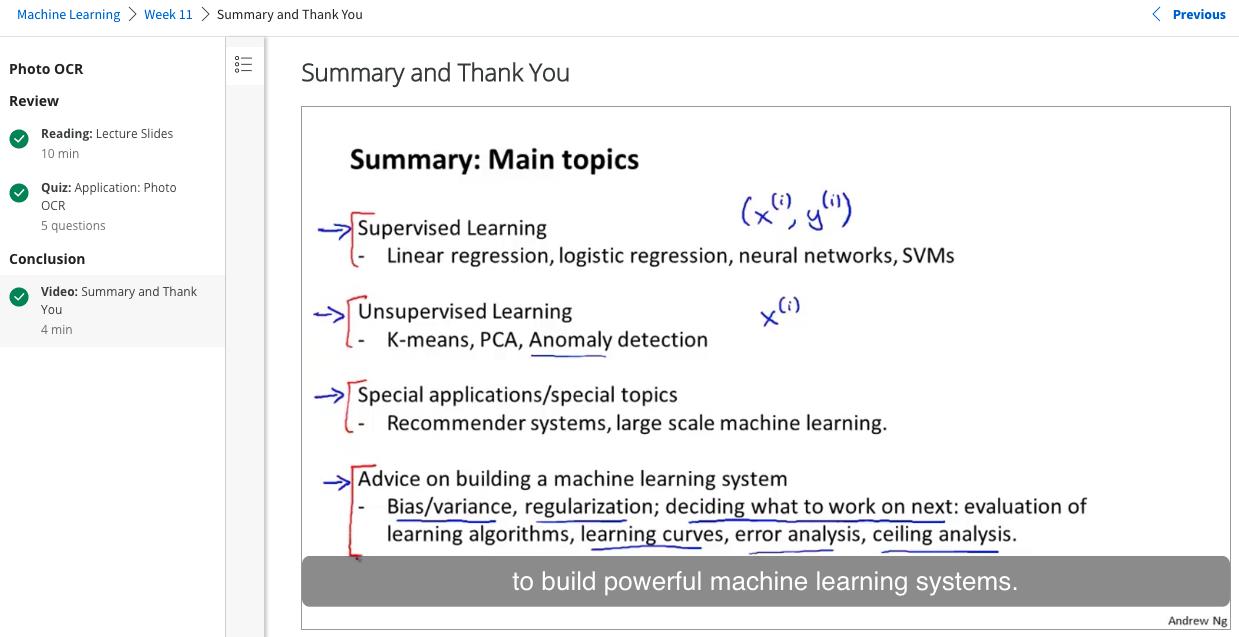

- 机器学习 Machine Learning- 吴恩达Andrew Ng 第1~5课总结

- 机器学习 Machine Learning- 吴恩达Andrew Ng 第6~10课总结

- 机器学习 Machine Learning- 吴恩达Andrew Ng 第11~15课总结

- 翻译: Octave 入门教程

- 机器学习 Machine Learning- 吴恩达Andrew Ng 第16~20课总结

- 机器学习 Machine Learning- 吴恩达Andrew Ng 第21~25课总结

- 机器学习 Machine Learning- 吴恩达Andrew Ng Week2-Octave

- 机器学习- 吴恩达Andrew Ng - week3-1 Classification

- 机器学习- 吴恩达Andrew Ng - week3-2 Logistic Regression Model

- 机器学习- 吴恩达Andrew Ng - week3-3 Multiclass Classification

- 机器学习- 吴恩达Andrew Ng - week3-4 solve overfitting

- 机器学习- 吴恩达Andrew Ng Week4 神经网络Neural Networks知识总结

- 机器学习- 吴恩达Andrew Ng Week5 神经网络学习Neural Networks Learning知识总结

- 机器学习- 吴恩达Andrew Ng Week6 Regularized Linear Regression and Bias/Variance知识总结

- 机器学习- 吴恩达Andrew Ng Week6 知识总结 Machine Learning System Design

- 机器学习- 吴恩达Andrew Ng Week7 知识总结Support Vector Machines

- 机器学习- 吴恩达Andrew Ng Week8 知识总结 Clustering

- 机器学习- 吴恩达Andrew Ng Week8 知识总结 Dimensionality Reduction

- 机器学习- 吴恩达Andrew Ng Week9 知识总结 Anomaly Detection

- 机器学习- 吴恩达Andrew Ng Week9 知识总结 Recommender Systems

- 机器学习- 吴恩达Andrew Ng Week10 知识总结 Large scale machine learning

- 机器学习- 吴恩达Andrew Ng Week11 知识总结 Photo OCR

编程技巧

- 机器学习- 吴恩达Andrew Ng 编程作业技巧

- 机器学习- 吴恩达Andrew Ng 编程作业技巧 for Week3

- 机器学习- 吴恩达Andrew Ng 编程作业技巧 for Week4 Neural Networks

- 机器学习- 吴恩达Andrew Ng 编程作业技巧 for Week5 Neural Networks Learning

- 机器学习- 吴恩达Andrew Ng 编程作业技巧 for Week6 Advice for Applying Machine Learning

- 机器学习- 吴恩达Andrew Ng 编程作业技巧 for Week7 Support Vector Machines

- 机器学习- 吴恩达Andrew Ng 编程作业技巧 for Week8 K-Means Clustering and PCA

- 机器学习- 吴恩达Andrew Ng 编程作业技巧 for Week9 Anomaly Detection

以上是关于机器学习-吴恩达课程笔记的主要内容,如果未能解决你的问题,请参考以下文章