在python获取网页的代码中添加头信息模拟浏览器

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了在python获取网页的代码中添加头信息模拟浏览器相关的知识,希望对你有一定的参考价值。

为什么要添加头部信息,因为有时候有些网页会有反爬虫的设置,导致无法获取正常的网页,在这里,在代码的头部添加一个headers信息,模拟成浏览器去访问网页。

没有添加头部信息的代码

import urllib2

url = "http://blog.51cto.com/lsfandlinux/2046467"

file = urllib2.urlopen(url)

html = file.read()

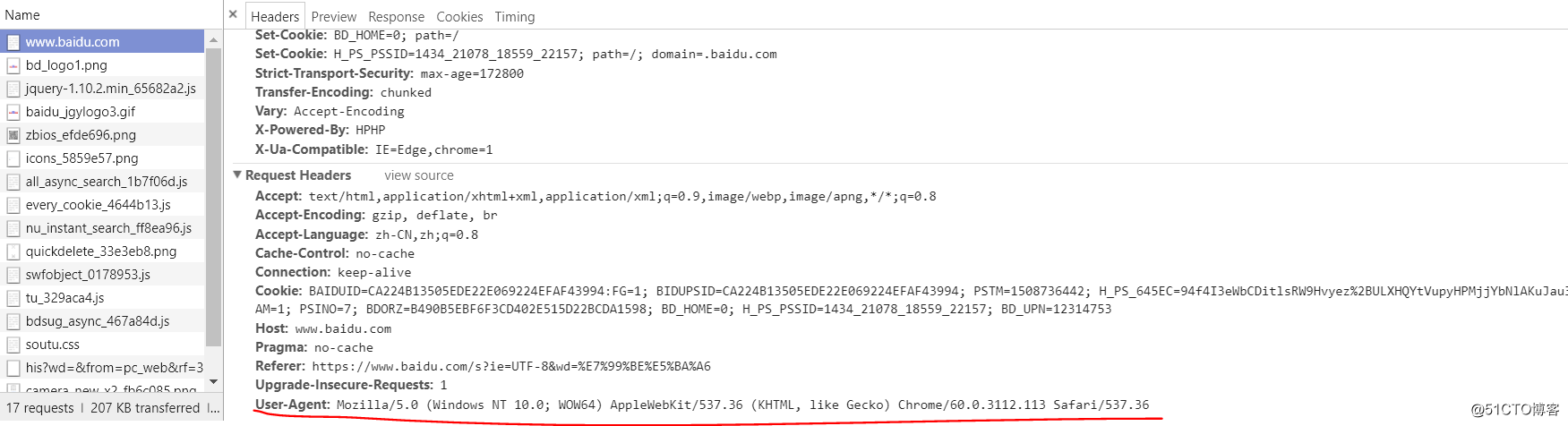

print html接下来添加头部信息,首先在浏览器打开百度一下,然后检查网页的头部信息,找到User-Agent,这就是我们用来模拟浏览器要用到的信息,把他复制下来。

然后在代码里面添加头部信息的变量存储对应的headers信息,定义的格式为(“User-Agent”,具体信息)。

在代码中添加头部信息的方法有两种:

方法1:使用build_opener()来添加

import urllib2

url = "http://blog.51cto.com/lsfandlinux/2046467"

headers = ("User-Agent","Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/60.0.3112.113 Safari/537.36")

opener = urllib2.build_opener()

opener.addheaders = [headers]

file = opener.open(url)

html = file.read()

print html我们利用opener.open(url)就是打开网页,这个opener就是具有头部信息的操作了。

方法2:利用add_header()来添加

import urllib2

url = "http://blog.51cto.com/lsfandlinux/2046467"

req = urllib2.Request(url)

req.add_header("User-Agent","Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/60.0.3112.113 Safari/537.36")

file = urllib2.urlopen(req)

html = file.read()

print html该方法是通过urllib2里的Request来创建一个Request对象赋值给变量req,然后使用add_header添加头部信息。

以上是关于在python获取网页的代码中添加头信息模拟浏览器的主要内容,如果未能解决你的问题,请参考以下文章