Serverless冷启动:如何让函数计算更快更强?

Posted 华为云开发者社区

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Serverless冷启动:如何让函数计算更快更强?相关的知识,希望对你有一定的参考价值。

摘要:借助Serverless计算,开发者仅需上传业务代码并进行简单的资源配置便可实现服务的快速构建部署,云服务商则按照函数服务调用量和实际资源使用收费,从而帮助用户实现业务的快速交付和低成本运行。

本文分享自华为云社区《Serverless冷启动:如何让函数计算更快更强?》,作者:DevAI 。

问题背景

Serverless计算也称服务器无感知计算或函数计算,是近年来一种新兴的云计算编程模式。其致力于大幅简化云业务开发流程,使得应用开发者从繁杂的服务器运维工作中解放出来(例如自动伸缩、日志和监控等)。借助Serverless计算,开发者仅需上传业务代码并进行简单的资源配置便可实现服务的快速构建部署,云服务商则按照函数服务调用量和实际资源使用收费,从而帮助用户实现业务的快速交付 (fast built & Relia. Deliv.)和低成本运行。

然而,Serverless计算的无状态函数编程在带来高度弹性和灵活性的同时,也导致了不可避免的冷启动问题。由于函数通常在执行完请求后被释放,当请求到达时,如果没有可用实例则需要从零开始启动新的实例处理请求(即冷启动)。当冷启动发生时,Serverless平台需要执行实例调度、镜像分发、实例创建、资源配置、运行环境初始化以及代码加载等一系列操作,这一过程引发的时延通常可达请求实际执行时间的数倍。相对于冷启动调用,热调用(即请求到达时有可用实例)的准备时间可以控制在亚毫秒级。在特定领域例如AI推理场景,冷启动调用导致的高时延问题则更为突出,例如,使用TensorFlow框架的启动以及读取和加载模型可能需要消耗数秒或数十秒。

因此,如何缓解Serverless函数的冷启动问题,改善函数性能是当前Serverless领域面临的主要挑战之一。

解决方案

从研究思路上看,目前工业界和学术界主要从两个方面入手解决冷启动问题:

(1)加快实例启动速度:当冷启动调用发生时,通过加速实例的初始化过程来减少启动时延;

当冷启动发生时,Serverless平台内部实例的初始化过程可以划分为准备和加载两个阶段。其中,准备阶段主要包括控制面决策调度/镜像获取、Runtime运行时初始化、应用数据/代码传输几个部分。而加载阶段位于实例内部,包括用户应用框架和代码的初始化过程。在工业界和学术界公开的研究成果中,针对实例启动过程中的每个阶段都有大量的技术手段和优化方法。如下图所示,经过优化,实例冷启动的准备阶段和加载阶段时间可被极大得缩短。

下面列举了一些近年来发表在计算机系统领域知名会议的相关工作,主要可以分为五个方面:

- 调度优化/镜像快速分发/本地池化:例如基于树结构的跨节点快速镜像分发 FaasNet [ATC\'21];Pod池+特化实例跳过镜像传输 [华为FunctionGraph]。其中,快速镜像分发依赖于VM节点的上/下行网络带宽,Pod池特化技术则是典型的以空间换时间的做法。

- 轻量级虚拟化/安全容器:例如针对传统容器Docker的精简优化工作SOCK [ATC\'21];更侧重安全性的轻量级虚拟化技术(Kata Containers, gVisor等);基于安全容器的进一步的精简优化工作 (Catalyzer [ASPLOS\'20], REAP[ASPLOS\'21])。通过裁剪优化,安全容器的启动时延最快可以被压缩至亚毫秒级。

- 数据共享/跨节点传输优化:例如基于RDMA共享内存减少跨节点启动过程的数据拷贝 RemoteFork [OSDI\'23];或者利用本地代码缓存跳过代码传输 [华为FunctionGraph, 字节ByteFaaS等]。基于RDMA技术的跨节点数据传输时延可降低至微妙级。

- 用户代码精简/快速加载:例如针对Java语言的JVM(Java Virtual Machine)运行时优化技术 [FunctionGraph];以及针对Python运行时库的裁剪优化工作FaasLight [arxiv\'23]。通过特定的优化,JVM启动时间可由数秒降低至数十毫秒,而Python代码的启动加载时延可降低约1/3。

- 其它非容器运行时技术:例如WASM(即WebAssembly)技术以及针对WASM的内存隔离方面的优化工作Faasm [ATC\'20]。相比容器化技术,直接以进程和线程方式组织运行函数,可在保证低开销函数运行的同时具备高度灵活性。

(2)降低冷启动发生率:通过函数预热、复用或实例共享等方法提高实例的利用效率,减少冷启动调用的发生

尽管已有的一些实例启动加速方法已经可以将运行时环境的初始化时间压缩至数十毫秒甚至是数毫秒,然而用户侧的延迟却仍然存在,例如程序状态的恢复,变量或者配置文件的重新初始化,相关库和框架的启动。具体来讲,在机器学习应用中,TensorFlow框架的启动过程往往需要花费数秒,即使实例运行时环境的启动时间再短,应用整体的冷启动时延对用户而言依然是无法接受的(注:通常大于200ms的时延可被用户察觉)。在这种情况下,可以从另一个角度入手解决冷启动问题,即降低冷启动调用的发生率。例如,通过缓存完整的函数实例,请求到达时可以快速恢复并处理请求,从而实现近乎零的初始化时延(例如Docker unpause操作时延小于0.5ms)。

降低冷启动发生率的相关研究可以分为如下几个方面:

- 实例保活/实例预留:例如基于Time-to-Live的keepalive保活机制 [AWS Lambda, OpenWhisk];或者通过并发配置接口预留一定数量的实例 [AWS Labmda等];这些方法原理简单,易于实现,但是在面对负载变化时缓存效率较低。

- 基于负载特征学习的动态缓存:例如基于请求到达间隔预测的动态缓存方案 Serverless in the Wild [ASPLOS\'20];学习长短期负载变化特征的动态缓存方案 INFless [ASPLOS\'22];基于优先级的可替换缓存策略FaasCache [ATC\'21];面向异构服务器集群的低成本缓存方案 IceBreaker [ASPLOS\'22]。这些动态缓存方案根据负载特征学习决定实例缓存数量或时长,从而在降低冷启动调用率的同时改善缓存资源消耗。

- 优化请求分发提高命中率:例如兼顾节点负载和本地化执行的请求调度算法 CH-RLU [HPDC\'22]。通过权衡节点负载压力和缓存实例的命中率来对请求的分发规则进行优化设计,避免节点负载过高导致性能下降,同时兼顾冷启动率。

- 改善并发/实例共享或复用:例如允许同一函数工作流的多个函数共享Sandbox环境 SAND [ATC\'18];使用进程或线程编排多个函数到单个实例中运行 Faastlane [ATC\'21];提高实例并发处理能力减少实例创建 Fifer [Middle\'20]; 允许租户复用其它函数的空闲实例减少冷启动时间 Pagurus [ATC\'22]。这些实例共享或者复用技术可以同缓存方案结合使用,降低冷启动带来的性能影响。

总结

Serverless的无状态设计赋予了函数计算高度弹性化的扩展能力,然而也带来了难以避免的冷启动问题。消除Serverless函数的冷启动开销还是从降低函数冷启动率和加速实例启动过程两个角度综合入手。对于冷启动开销比较大的函数,在函数计算框架的设计机制中进行优化,尽量避免冷启动发生;当冷启动发生时,采用一系列启动加速技术来缩短整个过程进行补救。在Serverless平台的内部,冷启动的管理在实践中可以做进一步精细的划分,例如针对VIP大客户,针对有规律负载的,或是针对冷启动开销小的函数,通过分类做定制化、有目的的管理可以进一步改善系统效率。

文章来自:PaaS技术创新Lab,PaaS技术创新Lab隶属于华为云,致力于综合利用软件分析、数据挖掘、机器学习等技术,为软件研发人员提供下一代智能研发工具服务的核心引擎和智慧大脑。我们将聚焦软件工程领域硬核能力,不断构筑研发利器,持续交付高价值商业特性!加入我们,一起开创研发新“境界”!

PaaS技术创新Lab主页链接:https://www.huaweicloud.com/lab/paas/home.html

参考文献

[1] 刘方明, 李林峰, 王磊. 华为Serverless核心技术与实践[M]. 北京: 电子工业出版社, 2021.11.

[2] Zijun Li, Linsong Guo, Jiagan Cheng, Quan Chen, Bingsheng He, Minyi Guo: The Serverless Computing Survey: A Technical Primer for Design Architecture. ACM Comput. Surv. 54(10s): 220:1-220:34 (2022).

Serverless 场景排查问题利器 : 函数实例命令行操作

简介:实例命令行功能的推出希望能消除用户使用 Serverless 的“最后一公里”,直接将真实的函数运行环境展现给用户。

背景介绍

全托管的 Serverless 计算平台能给用户带来更少的运维代价、更强的稳定性和更快的弹性能力,在 Serverless 落地的过程中,遇到的一个很大的挑战是 Serverless 平台如何给予开发者足够的安全感。让开发者们无负担地使用并信任 Serverless,是我们一直追求的目标。

全托管的初衷是为了减小开发者的使用和运维复杂度,但这一定程度上削减了用户对自身服务的控制权力。比如在很多场景中,用户会想知道,如何能够掌握自己应用的实际运行情况?应用出现问题时如何能快速确认是自身问题还是云平台问题?如果是云平台的问题,如何能快速恢复服务,及时止损?这些问题的根本原因,都是用户对云平台无法做到完全的信任,这也进一步阻碍了他们迁移应用和扩展业务场景。所以我们也在思考,如何打破这种不信任局面,让用户拥有更多资源层面上的掌控力,但又能远离资源层的复杂运维。

在这样的背景和需求下,阿里云函数计算创新推出了 Serverless 场景下的函数实例命令行操作功能,支持用户在控制台界面登录进函数实例内部,或者使用工具对实例执行指定的命令。本文具体介绍这个功能的使用方式和使用场景。

实例 Exec 功能定位及使用方式

实例命令行操作功能提供和 K8S Pod Exec 与 Docker Container Exec 一致的使用体验,支持在函数实例的真实运行环境中执行具体命令。

同时,由于 Serverless 极致弹性、按量收费等特性,在 Serverless 场景下的实例 Exec 功能又与 K8S 和 Docker 有着一些本质的区别:

- 只能对还存活着的实例(包括预留常驻实例和按量活跃实例)执行 Exec 操作,如果按量实例空闲超时被释放,则无法再执行;

- InstanceExec 请求不占用实例的并发度。因此即使函数的实例并发度设置为 1,也可以同时执行 InvokeFunction 和 InstanceExec 操作

- InstanceExec 的一次操作被视作一次 InvokeFunction 请求调用。只要 InstanceExec 请求建立的 websocket 连接没有和函数实例断开,那么函数实例将一直处于活跃状态,和 Invoke Function 采用同样的计费规则。用户可以设置 InstantceExec 的 idleTimeout 参数让客户端在空闲指定时间后主动断开连接

实例命令行操作功能支持在控制台上登录实例、使用 Serverless Dev 工具执行命令,或者 SDK 调用接口,执行命令。

控制台登录实例

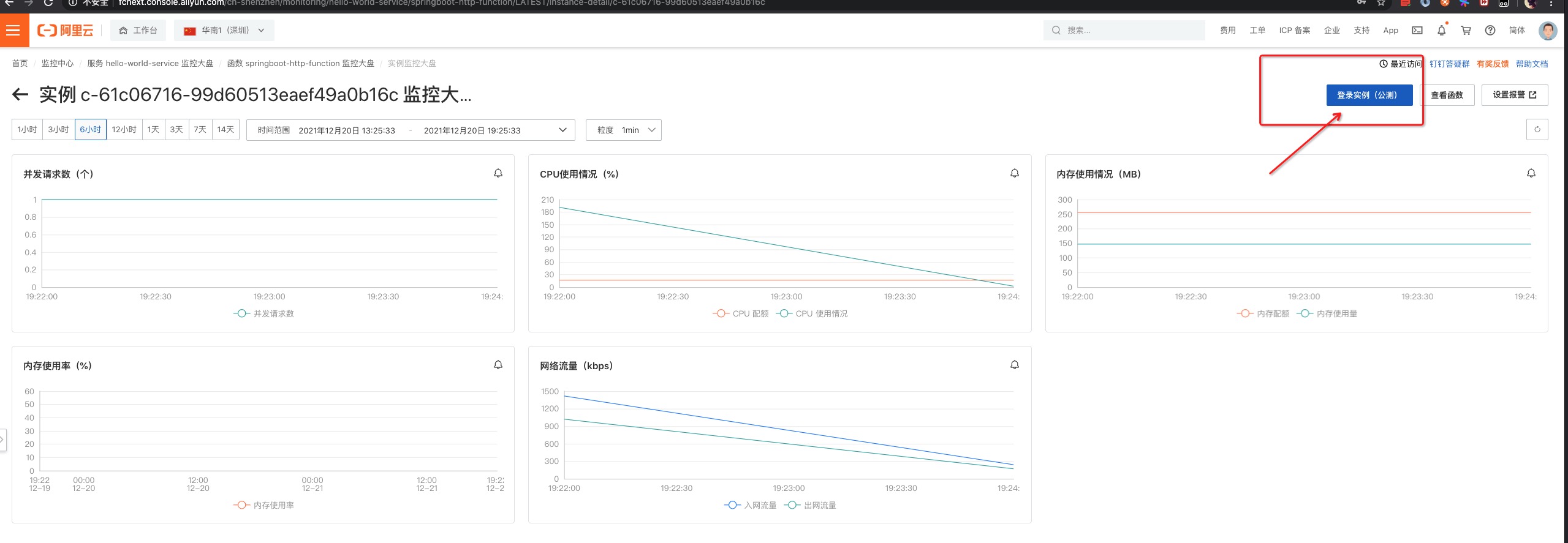

在函数计算官网控制台上在函数详情-监控指标-实例指标页面,在最右侧可以对实例执行登陆操作。

点击“登录实例”,界面将会调到一个终端界面,即可马上登录进实例,执行命令进行问题排查。

在函数详情-监控指标-实例指标页面,点击实例 ID 可以进入到函数的实例详情页面,界面右上方有登录实例的按钮,点击即可进入实例。

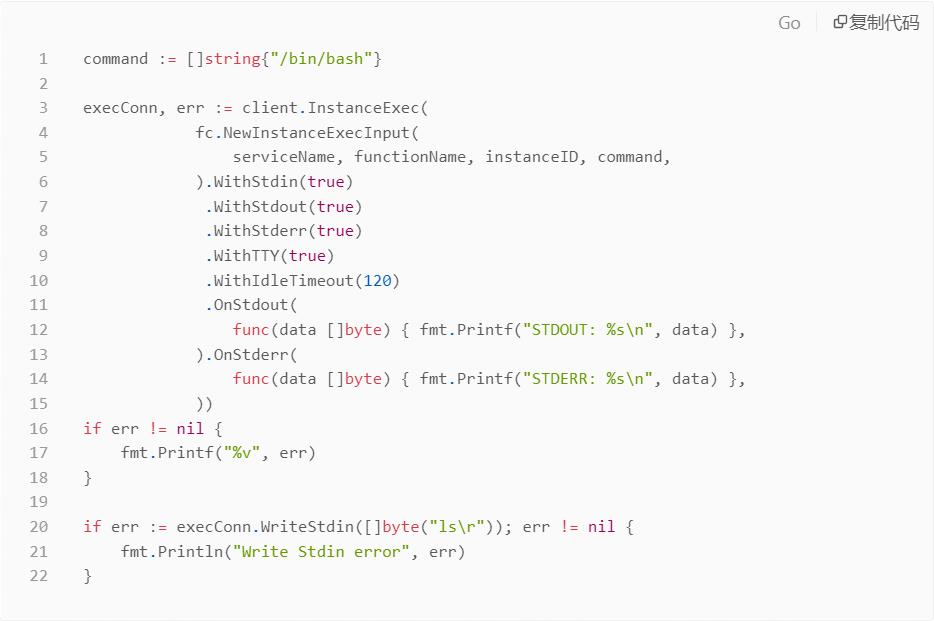

SDK 调用

以 golang SDK 为例,其它 SDK 的调用方式大都类似。

SDK 对 InstanceExec API 进行了封装,在调用接口的时候需要使用 OnStdout 、OnStderr 传入两个回调函数,回调函数定义了处理 Exec 通道返回数据的具体逻辑 ;同时可以使用返回的 execConn 输入 stdin 消息以传输给远端的 Exec 通道。

适用场景

1. 排查线上问题

在一些日常的场景下,实例命令行操作会带来更符合用户习惯、更高效便捷的排查问题方式。

用户小王是 Serverless 小白用户,写完一个程序部署到函数计算后,发现函数中设置的环境变量不生效,如果进一步排查,则需要修改代码,打印日志,重新部署,查看日志,使用这样繁琐的排查方式。现在借助实例命令行操作,小王可以直接一个命令:s exec instance_id ENV 便可以一步定位问题。

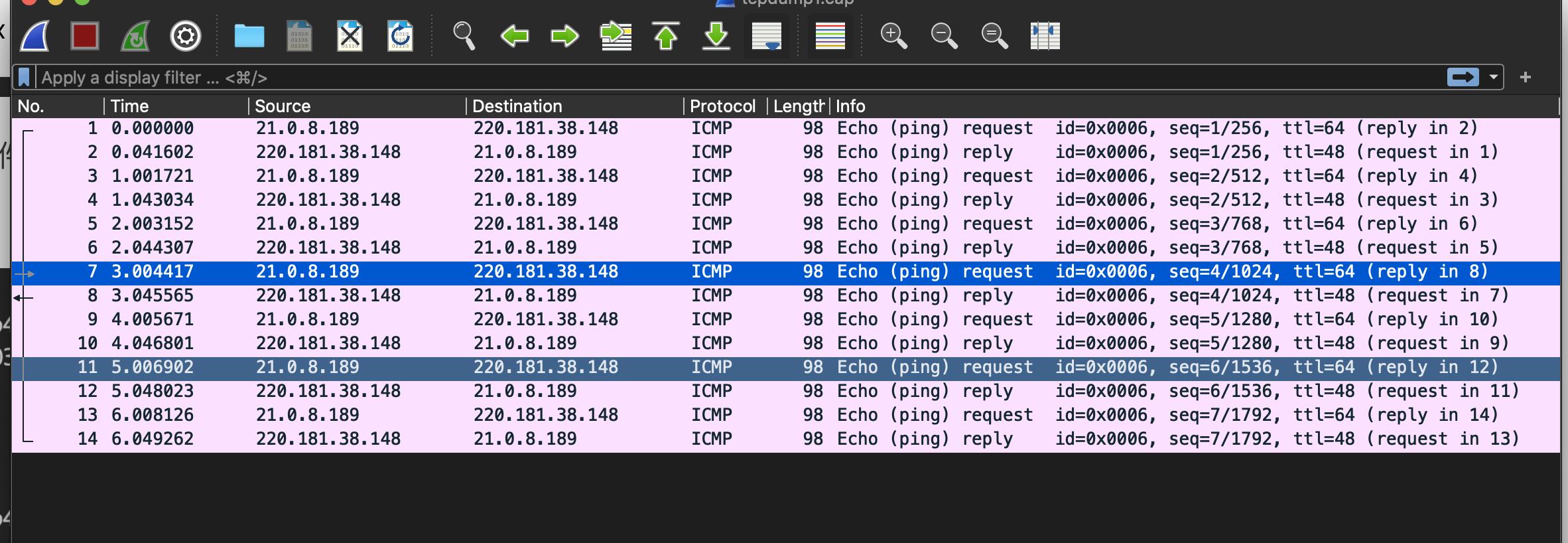

实例命令行操作提供了便捷的登录体验,能帮助用户解决复杂场景下的应用问题。一些情况下,用户已经无法通过函数日志、监控指标来具体定位问题,需要借助比如 coredump 、tcpdump、jmap 等工具进行深入排查。

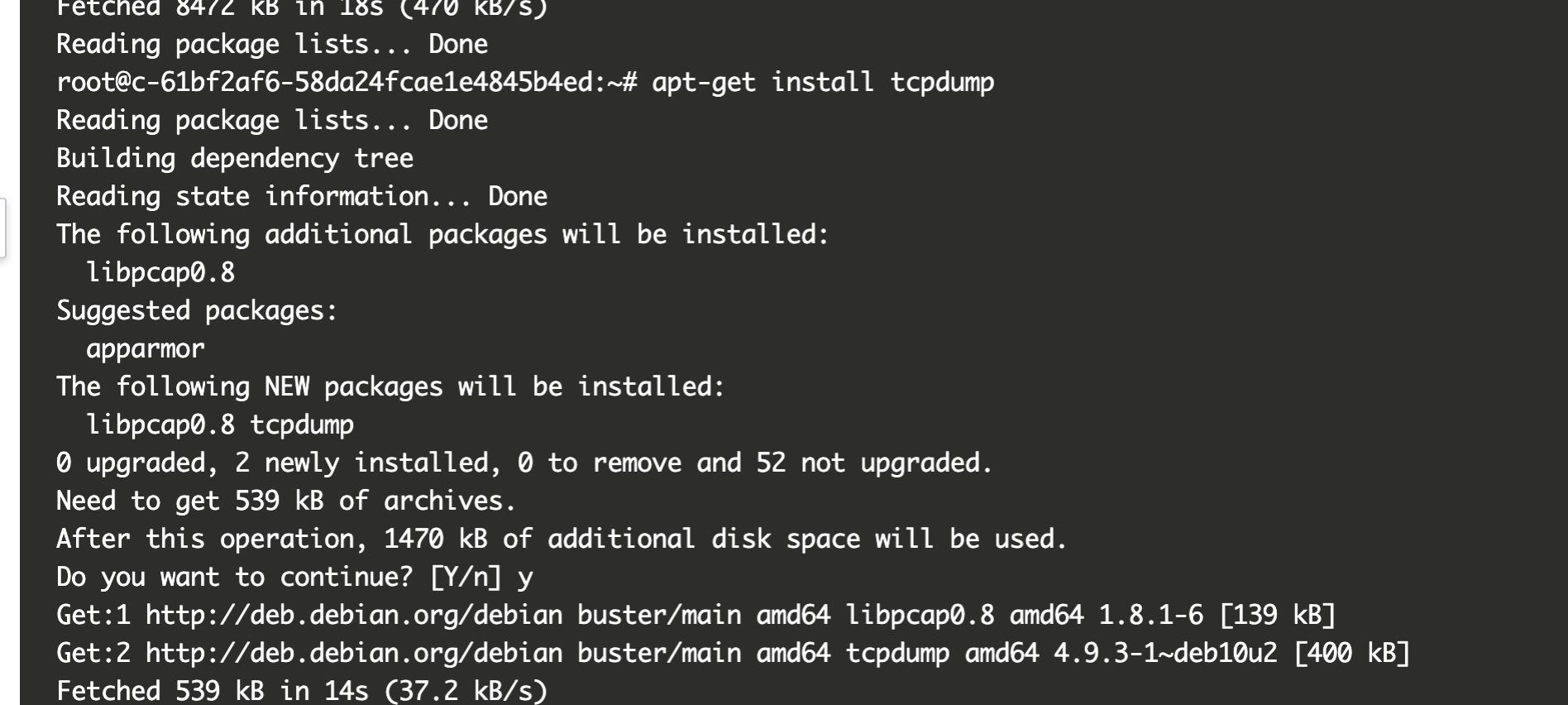

比如,用户小李发现自己的线上程序最近会出现一些函数错误,报错内容都是连接远程某服务超时。小李怀疑是函数实例与远端服务的网络链接不稳定,想进入实例内部,调查分析下实例与远端服务的网络情况。他可以按照这样的步骤进行:

- 登录进实例内部后,先安装 tcpdump 工具,需要执行 apt-get update 和 apt-get install tcpdump 两条命令:

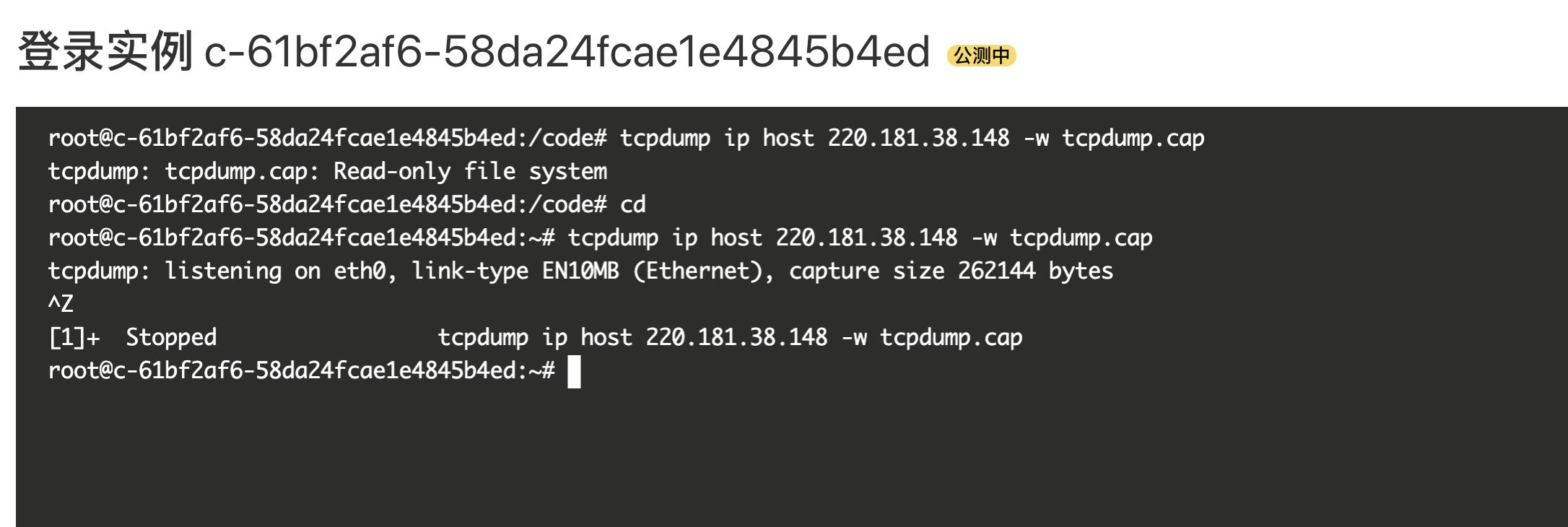

- 安装完毕后,执行 tcpdump 命令,对远端服务 IP 的请求进行抓包,并将抓包结果保存在 tcpdump.cap 文件中:

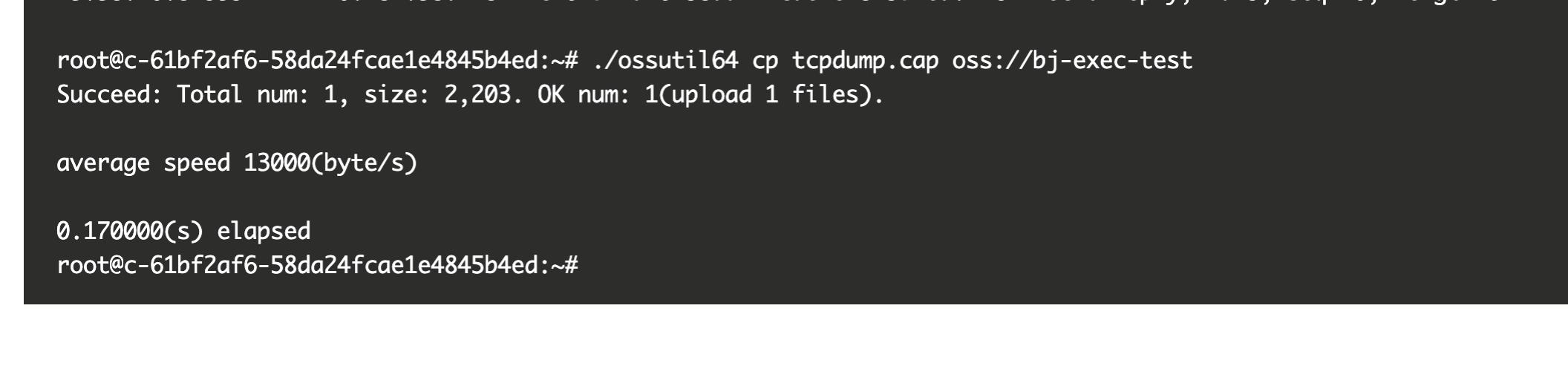

- 抓包完毕,借助 OSS 命令行工具 ossutil64 ,将 tcpdump.cap 文件上传到自己的 OSS ,然后下载到本地借助分析工具 wireshark 可以进行分析。

2. 程序性能优化

很多时候,开发者需要通过各种 profiling 工具来分析性能、资源使用等问题。比如应用实例CPU、内存等资源使用不符合预期;应用性能低于预期,通过 profiling 工具找到瓶颈等等。通过实例命令行操作,开发者能够方便的运行语言、框架提供的各种 profiling 工具,优化程序性能和资源使用。

以运行在函数计算上的高德自主出行为例,其峰值 TPS 会达到数十万级别,作为实时在线应用,服务能接受的请求延迟在几十毫秒级别。考虑到成本压力,在上线前他们期望压测出单实例最高能承受的 TPS 和对应的调用延迟,以此评估需要的实例数量。

但是高德在压测中发现单实例的平均/长尾延时不符合预期,当单实例 TPS 达到 300 TPS 的时候,请求延迟会直线上升。他们想确定,是否是自己的应用程序哪里存在性能瓶颈,或者是函数计算运行时的性能存在问题?借助实例命令行操作,他们可以登录进实例内部,通过 profiling 深入分析后发现了性能问题,最后优化了程序性能达到了上线标准。

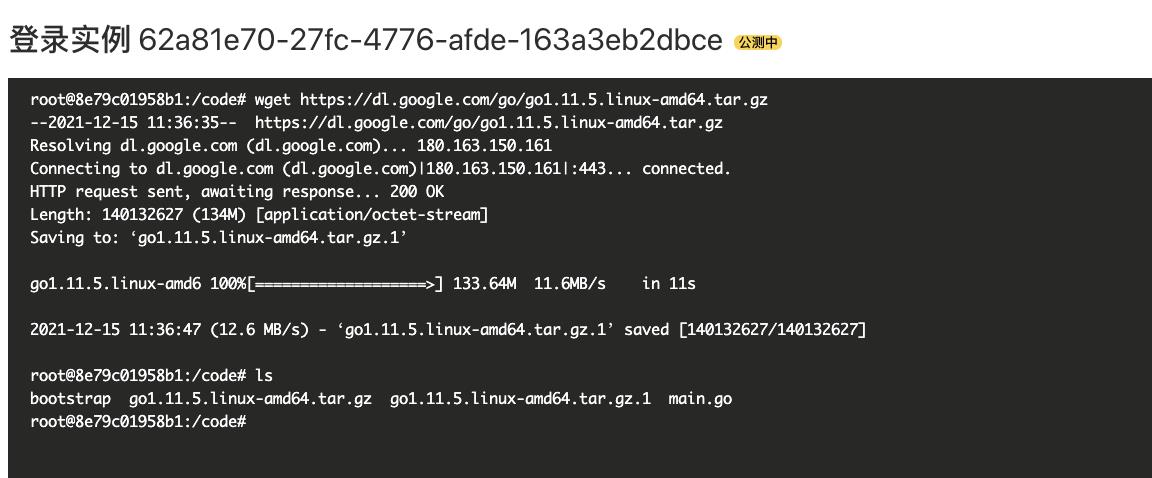

下面以 custom runtime 为例:demo 示例程序使用 golang 编写并部署到函数计算上。

- 登录进入实例后,下载 golang 安装包 :

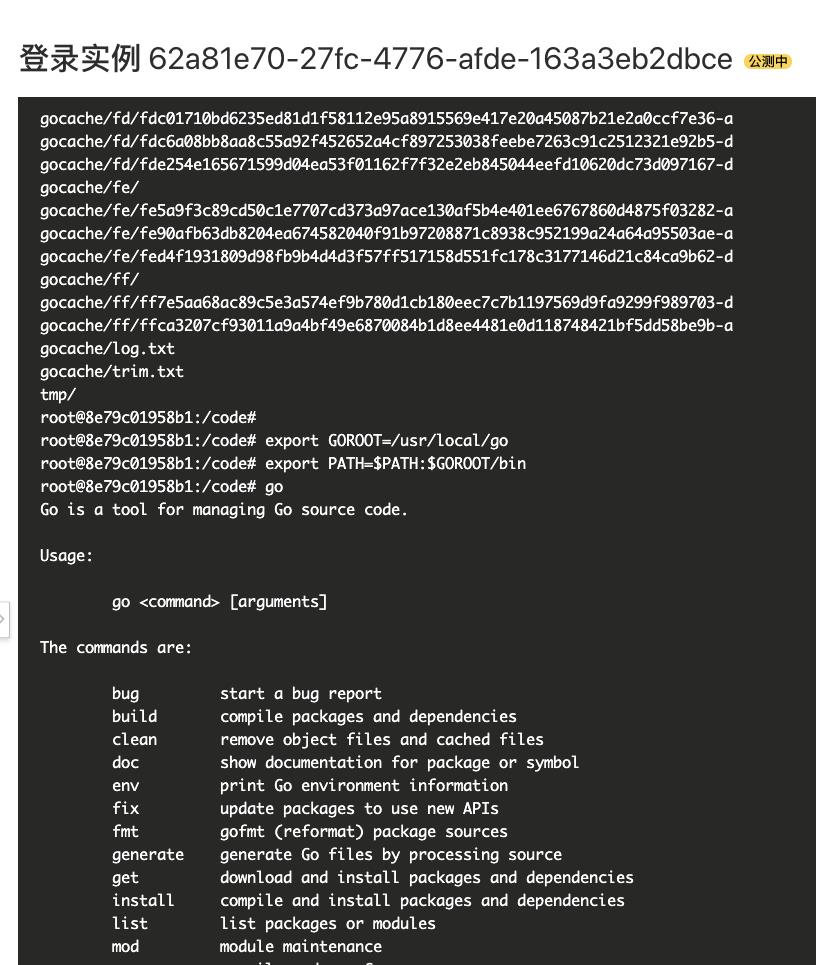

- 并解压安装 go :

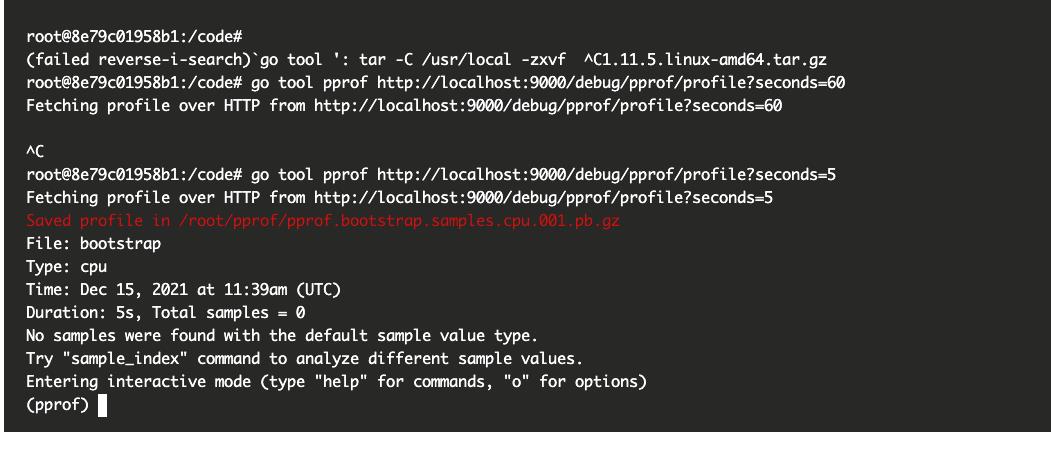

- 执行 go tool pprof 命令,并产生分析文件:

/root/pprof/pprof.bootstrap.samples.cpu.001.pb.gz

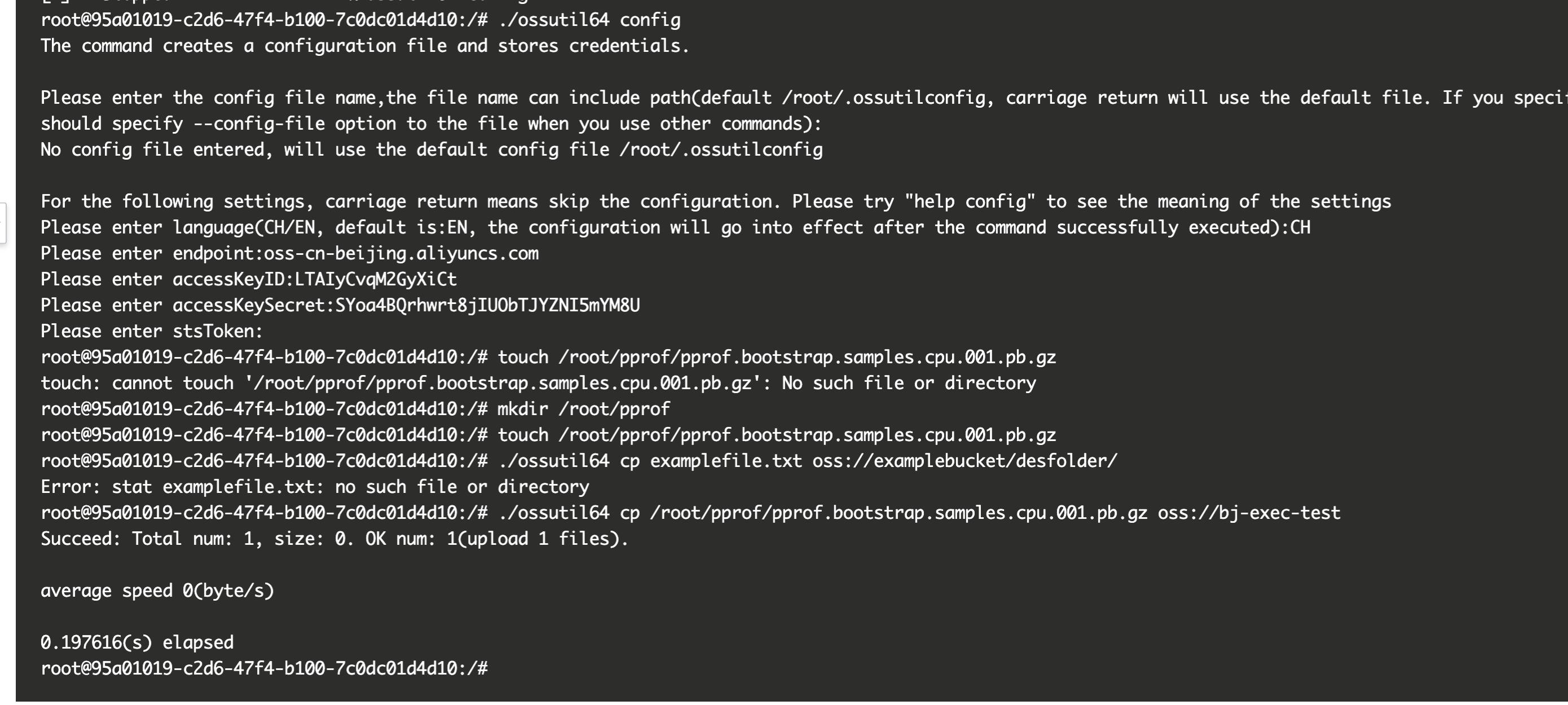

- 最后借助 OSS 命令行工具 ossutil64, 运行 ./ossutil64 cp 命令,将分析文件上传到自己的 OSS Bukcet 中 ,便可以下载到用户本地进行可视化分析。

总结

实例命令行功能的推出希望能消除用户使用 Serverless 的“最后一公里”,直接将真实的函数运行环境展现给用户,此后 Serverless 将不再是一个“黑盒”,用户可以更加信任和依赖 Serverless 平台来扩展更多的业务场景和规模。

本文为阿里云原创内容,未经允许不得转载。

以上是关于Serverless冷启动:如何让函数计算更快更强?的主要内容,如果未能解决你的问题,请参考以下文章

Serverless 场景排查问题利器 : 函数实例命令行操作

华为云发布冷启动加速解决方案:助力Serverless计算速度提升90%+