STM32CubeMX生产代码一直卡在copy libraries files的原因

Posted Chaclin

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了STM32CubeMX生产代码一直卡在copy libraries files的原因相关的知识,希望对你有一定的参考价值。

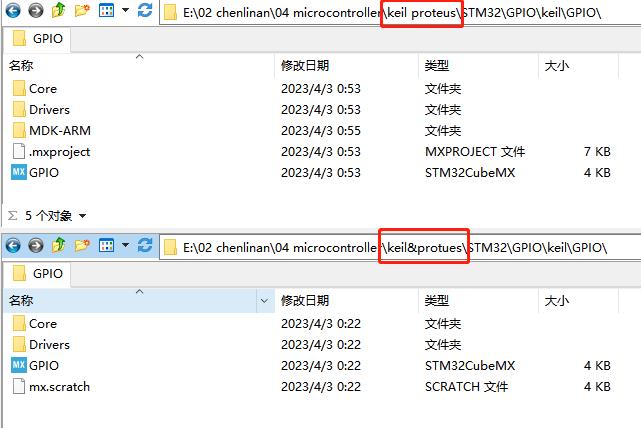

工程保存路径名字的差别,出现空格没事,用了个&特殊字符会创建不出MDK工程。。人傻了

现在最新版本的STMCubeMX不需要自己下载JRE环境了,,直接下载就能使用(STM32CubeMX 6.8.0)

如果我的生产者生产,那么为啥消费者不能消费?它卡在@poll()

【中文标题】如果我的生产者生产,那么为啥消费者不能消费?它卡在@poll()【英文标题】:If my producer producing, then why the consumer couldn't consume? it stuck @ poll()如果我的生产者生产,那么为什么消费者不能消费?它卡在@poll() 【发布时间】:2016-07-23 11:25:30 【问题描述】:我正在发布到远程 kafka 服务器并尝试使用来自该远程服务器的消息。 (卡夫卡 v 0.90.1) 发布工作正常,但也不消耗。

出版商

package org.test;

import java.io.IOException;

import java.util.Properties;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.ProducerRecord;

public class Producer

private void generateMessgaes() throws IOException

String topic = "MY_TOPIC";

Properties props = new Properties();

props.put("bootstrap.servers", "kafka.xx.com:9092");

props.put("acks", "all");

props.put("retries", 0);

props.put("batch.size", 16384);

props.put("linger.ms", 1);

props.put("buffer.memory", 33554432);

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("serializer.class", "org.apache.kafka.common.serialization.StringSerializer");

KafkaProducer<String, String> producer = null;

try

producer = new KafkaProducer<>(props);

for (int i = 0; i < 10; i++)

producer.send(new ProducerRecord<String, String>(topic, "test msg"));

System.out.println("producing---");

catch (Throwable e)

e.printStackTrace();

System.out.println("Error in publishing messages to the topic : " + topic);

finally

producer.close();

public static void main(String[] args) throws IOException

Producer producer = new Producer();

producer.generateMessgaes();

System.out.println("$$$$$");

我可以看到“生产--- 和 $$$$ 打印。但是当我尝试消费时,我没有看到“轮询”打印消息。它卡在 poll(timeout) 处。

有什么线索吗?

消费者

package org.test;

import java.util.Arrays;

import java.util.List;

import java.util.Properties;

import org.apache.kafka.clients.consumer.ConsumerRecord;

import org.apache.kafka.clients.consumer.ConsumerRecords;

import org.apache.kafka.clients.consumer.KafkaConsumer;

public class Listener

public void start() throws CoreException

String topic = "MY_TOPIC";

List<String> topics = Arrays.asList(topic);

Properties props = new Properties();

props.put("bootstrap.servers", "kafka.xx.com:9092");

props.put("enable.auto.commit", true);

props.put("receive.buffer.bytes", 262144);

props.put("consumer.timeout.ms", 10000);

props.put("session.timeout.ms", 7000);

props.put("heartbeat.interval.ms", 1000);

props.put("auto.offset.reset", "earliest");

props.put("group.id", "test");

props.put("fetch.min.bytes", 1);

props.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.put("serializer.class", "org.apache.kafka.common.serialization.StringDeserializer");

KafkaConsumer<String, String> consumer = new KafkaConsumer<String, String>(props);

consumer.subscribe(topics);

try

while (true)

ConsumerRecords<String, String> records = consumer.poll(100);

System.out.println("polling msges : " + records.count());

for (ConsumerRecord<String, String> record : records)

System.out.println("kafka record : " + record.value());

catch (Throwable e)

e.printStackTrace();

System.out.println("eror in polling");

finally

consumer.close();

public static void main(String args[]) throws CoreException

Listener listener = new Listener();

listener.start();

【问题讨论】:

如果你做 kafka-console-consumer.sh --new-consumer --bootstrap-server kafka.xx.com:9092 --topic MY_TOPIC 会得到什么? @LucianoAfranllie 我收到持续警告; 2016-04-06 08:44:21,664] WARN 获取相关 ID 为 1 的元数据时出错:MY_TOPIC?=INVALID_TOPIC_EXCEPTION (org.apache.kafka.clients.NetworkClient) [2016-04-06 08:44:21,889] WARN 获取关联 ID 为 3 的元数据时出错:MY_TOPIC?=INVALID_TOPIC_EXCEPTION (org.apache.kafka.clients.NetworkClient) @LucianoAfranllie 我试过没有“?” ,就像 // kafka-console-consumer.sh --new-consumer --bootstrap-server kafka.xx.com:9092 --topic MY_TOPIC // 它卡住了..SO,我在这里看到了我原来的行为,那是新的消费者 API,poll() 卡住了 尝试使用参数--from-beginning: kafka-console-consumer.sh --new-consumer --bootstrap-server kafka.xx.com:9092 --topic MY_TOPIC --from-beginning跨度>

在你的Java代码中,我猜应该是:props.put("auto.offset.reset", "smallest"); (而不是“最早”)

【参考方案1】:

免责声明:我不了解 Kafka,但我知道消息传递。

关于主题的第一件事:默认情况下,订阅不是持久的,因此如果生产者向主题发送消息并且没有人在监听,则消息将被丢弃。

第二件事是轮询:轮询 100 毫秒,然后如果没有任何异常,则会引发异常,让你退出循环。

如果消费者启动时没有消息——因为正如我所描述的,生产者的消息进入了比特桶——然后消费者失败了,因为没有任何东西可以消费。所以我想说一切都按您的预期工作。

两个选项: - 添加更大的初始轮询,让消费者有机会看到消息(假设您知道生产者将在时间范围内生产) - 更改您的逻辑,以便异常导致您停留在 while 循环中并继续消费,并找出另一种方法来阻止消费者。

【讨论】:

第一件事:> 我首先开始了听众,然后是制作人..SO 认为这不是问题。第二件事:>没有例外..我会进一步尝试看看。事情是,同样的消费者,生产者在本地 kafka 服务器上工作得很好。不适用于远程 kafka 服务器。最令人沮丧的是,它没有向消费者抛出任何异常。 你最初并没有说它在本地工作,改变了我的想法。此外,首先启动侦听器会遇到我描述的问题,即轮询超时并在生产者开始之前引发异常。我唯一能想到的其他一点是,远程访问时存在时间差异,这会加剧问题,或者在使用本地服务器时会改变行为。 网络连接稳定。(生产者生产者消息很快)我的运气不好..这不起作用..无能为力 这句话是错误的:“关于主题的第一件事:默认情况下,订阅不是持久的,所以如果生产者向主题发送消息并且没有人监听,则消息将被丢弃。” -> Kafka 是一个持久的消息队列并可靠地存储数据(使用可配置的删除策略,例如,通过保留时间或最大存储大小)。 这也是错误的:“第二件事是轮询:你轮询 100 毫秒,然后如果没有任何异常,就会抛出异常,让你退出循环。” -> 在 Kafka 中,如果没有可用的消息,则 poll 只返回一个空的迭代器。以上是关于STM32CubeMX生产代码一直卡在copy libraries files的原因的主要内容,如果未能解决你的问题,请参考以下文章