Python爬虫之爬取煎蛋网妹子图

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Python爬虫之爬取煎蛋网妹子图相关的知识,希望对你有一定的参考价值。

这篇文章通过简单的Python爬虫(未使用框架,仅供娱乐)获取并下载煎蛋网妹子图指定页面或全部图片,并将图片下载到磁盘。

首先导入模块:urllib.request、re、os

import urllib.request

import re

import os

urllib.request模块用于获取HTML页面数据

re模块用于通过正则表达式解析并截取HTML页面图片url

os模块用于文件夹相关操作

代码不多,直接贴出来,代码解释在注释中:

def crawl_jiandan(page, path):

"""

:param page:获取指定页面数据,值为0或超过最大值则爬取全部数据

:param path:文件存储路径,没有目录则创建目录

"""

if page < 0:

return

# 路径是否存在,不存在则创建目录

if not os.path.exists(path):

os.mkdir(path)

# 切换到目录

os.chdir(path)

# 煎蛋网妹子图首页

url = ‘http://jandan.net/ooxx/page-%d#comments‘ % page

while True:

request = urllib.request.Request(url)

request.add_header(‘User-Agent‘,

‘Mozilla/5.0 (Macintosh; Intel Mac OS X 10.11; rv:54.0) Gecko/20100101 Firefox/54.0‘)

with urllib.request.urlopen(request) as response:

html = response.read().decode(‘utf-8‘)

# print(html)

items = re.findall(re.compile(r‘<div class="text"><span class="righttext"><a ‘

r‘href="http://.+">[0-9]+</a></span><p><a ‘

r‘href="//(.+\\.jpg)" target="_blank" class="view_img_link">‘),

html)

next_url = re.findall(re.compile(r‘<a title="Older Comments" href="(‘

r‘http://jandan.net/ooxx/page-[0-9]+#comments)" ‘

r‘class="previous-comment-page">‘), html)

for item in items:

filename = item.split(‘/‘)[-1]

# 目录下是否已存在相同文件名,不存在则下载

if not os.path.exists(filename):

print(item)

urllib.request.urlretrieve(‘http://‘ + item, filename)

if not len(next_url):

return

else:

url = next_url[0]

crawl_jiandan(1, ‘/Volumes/KE/IT源码/Python3/Python爬虫/煎蛋网妹子图‘)

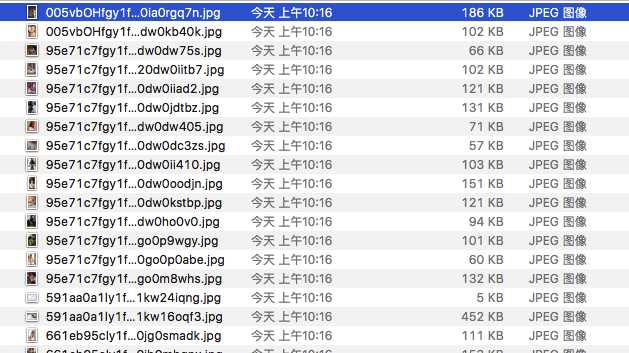

打开本次磁盘,效果如下:

这里只显示了部分图像,有兴趣的可以下载煎蛋网所有妹子图,只需在上述函数中第一个参数传0即可

注意:此文仅供参考和娱乐,代码还不够严谨。

以上是关于Python爬虫之爬取煎蛋网妹子图的主要内容,如果未能解决你的问题,请参考以下文章