Python爬虫是啥?

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Python爬虫是啥?相关的知识,希望对你有一定的参考价值。

爬虫一般指网络资源的抓取,通过编程语言撰写爬虫工具,抓取自己想要的数据以及内容。而在众多编程语言之中,Python有丰富的网络抓取模块,因此成为撰写爬虫的首选语言,并引起了学习热潮。Python作为一门编程语言而纯粹的自由软件,以简洁清晰的语法和强制使用空白符号进行语句缩进的特点受到程序员的喜爱。用不同编程语言完成一个任务,C语言一共要写1000行代码,Java要写100行代码,而Python只需要20行,用Python来完成编程任务代码量更少,代码简洁简短而且可读性强。

Python非常适合开发网络爬虫,因为对比其他静态编程语言,Python抓取网页文档的接口更简洁;对比其他脚本语言,Python的urllib2包提供了较为完整的访问网页文档的API。

Python爬虫的工作流程是什么?

Python爬虫通过URL管理器,判断是否有待爬URL,如果有待爬URL,通过调度器进行传递给下载器,下载URL内容,通过调度器传送给解释器,解析URL内容,将有价值数据和新的URL列表通过调度器传递给应用程序,输出价值信息的过程。

Python是一门非常适合开发网络爬虫的语言,提供了urllib、re、json、pyquery等模块,同时还有很多成型框架,比如说Scrapy框架、PySpider爬虫系统等,代码十分简洁方便,是新手学习网络爬虫的首选语言。 参考技术A 网络爬虫(bai又称为网页蜘蛛,网络机器人,在FOAF社区中间,更经常的称为网页追逐者),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。另外一些不常使用的名字还有蚂蚁、自动索引、模拟程序或者蠕虫。

随着网络的迅速发展,万维网成为大量信息的载体,如何有效地提取并利用这些信息成为一个巨大的挑战。搜索引擎(Search Engine),例如传统的通用搜索引擎AltaVista,Yahoo!和Google等,作为一个辅助人们检索信息的工具成为用户访问万维网的入口和指南。但是,这些通用性搜索引擎也存在着一定的局限性,如:

(1)不同领域、不同背景的用户往往具有不同的检索目的和需求,通过搜索引擎所返回的结果包含大量用户不关心的网页。

(2)通用搜索引擎的目标是尽可能大的网络覆盖率,有限的搜索引擎服务器资源与无限的网络数据资源之间的矛盾将进一步加深。

(3)万维网数据形式的丰富和网络技术的不断发展,图片、数据库、音频、视频多媒体等不同数据大量出现,通用搜索引擎往往对这些信息含量密集且具有一定结构的数据无能为力,不能很好地发现和获取。

(4)通用搜索引擎大多提供基于关键字的检索,难以支持根据语义信息提出的查询。 参考技术B 网络爬虫(又被称为网页蜘蛛,网络机器人),是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本。另外一些不常使用的名字还有蚂蚁、自动索引、模拟程序或者蠕虫。

通俗地讲,我们把互联网比作一张大蜘蛛网,每个站点资源比作蜘蛛网上的一个结点,爬虫就像一只蜘蛛,按照设计好的路线和规则在这张蜘蛛网上找到目标结点,获取资源。 参考技术C Python爬虫也叫做网络机器人,可以代替人们自动地在互联网中进行数据信息的采集与整理。在大数据时代,信息的采集是一项重要的工作,如果单纯靠人力进行信息采集,不仅低效繁琐,搜集的成本也会提高。 参考技术D 网络爬虫又称网络蜘蛛、网络蚂蚁、网络机器人等,可以自动化浏览网络中的信息,当然浏览信息的时候需要按照我们制定的规则进行,这些规则我们称之为网络爬虫算法。使用Python可以很方便地编写出爬虫程序,进行互联网信息的自动化检索。

python爬虫是啥

参考技术A Python爬虫是指在某种原因进行互联网请求获取信息 参考技术B首先要知道python爬虫是一个程序,这个程序的目的就是为了抓取万维网信息资源,比如你日常使用的谷歌等搜索引擎,搜索结果就全都依赖爬虫来定时获取

了解一个python爬虫离不开了解一下爬虫的基本原理,接下来我们来讲解一下这个原理。

网页请求的过程分为两个环节:

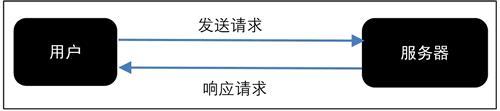

1. Request (请求):每一个展示在用户面前的网页都必须经过这一步,也就是向服务器发送访问请求。

2. Response(响应):服务器在接收到用户的请求后,会验证请求的有效性,然后向用户(客户端)发送响应的内容,客户端接收服务器响应的内容,将内容展示出来,就是我们所熟悉的网页请求,如图 所示。

网页请求的方式也分为两种:

1. GET:最常见的方式,一般用于获取或者查询资源信息,也是大多数网站使用的方式,响应速度快。

2. POST:相比 GET 方式,多了以表单形式上传参数的功能,因此除查询信息外,还可以修改信息。

所以,在写爬虫前要先确定向谁发送请求,用什么方式发送。

爬虫的目标对象也很丰富,不论是文字、图片、视频,任何结构化非结构化的数据爬虫都可以爬取,爬虫经过发展,也衍生出了各种爬虫类型:

通用网络爬虫:爬取对象从一些种子 URL 扩充到整个 Web,搜索引擎干的就是这些事

垂直网络爬虫:针对特定领域主题进行爬取,比如专门爬取小说目录以及章节的垂直爬虫

增量网络爬虫:对已经抓取的网页进行实时更新

深层网络爬虫:爬取一些需要用户提交关键词才能获得的 Web 页面

不想说这些大方向的概念,让我们以一个获取网页内容为例,从爬虫技术本身出发,来说说网页爬虫,步骤如下:

模拟请求网页资源

从HTML提取目标元素

数据持久化

什么是爬虫,这就是爬虫:

"""让我们根据上面说的步骤来完成一个简单的爬虫程序"""

import requests

from bs4 import BeautifulSoup

target_url = 'http://www.baidu.com/s?wd=爬虫'

# 第一步 发起一个GET请求

res = requests.get(target_url)

# 第二步 提取HTML并解析想获取的数据 比如获取 title

soup = BeautifulSoup(res.text, "lxml")

# 输出 soup.title.text

title = soup.title.text

# 第三步 持久化 比如保存到本地

with open('title.txt', 'w') as fp:

fp.write(title)

加上注释不到20行代码,你就完成了一个爬虫,简单吧

你就能精通 Python,成为未来抢手的人才。

python新手入门知识

python交流圈

以上是关于Python爬虫是啥?的主要内容,如果未能解决你的问题,请参考以下文章