Python爬虫模拟登录遇到的问题——CSRF防御

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Python爬虫模拟登录遇到的问题——CSRF防御相关的知识,希望对你有一定的参考价值。

参考技术A去年在公司写过一个爬虫工具,用于抓取自动化报告通过率、自动发送报告。由于当时是第一次接触爬虫,难免会遇到各种问题,解决方案全都是按照网上的一些爬虫文章示例,照猫画虎写的。虽然能正常使用,但其实很多地方都没弄明白。最近学习了一些前端和后台的原理,了解了cookie与session的机制,总算弄明白了爬虫登录过程中的一个疑问。

编写爬虫第一步,在登录公司的自动化平台时就遇到了一个难题,登录请求中必须包含一个authenticity_token字段。令人头大的是,完全不知道这个字段从何而来,而且该字段还每次都不一样,参考的爬虫登录示例也没教啊!真是急坏苯宝宝了😭

后来翻了好多CSDN的爬虫贴,了解到 知乎 的登录请求中也包含这样一个字段,而作者的处理方式就是先访问一次登录页,然后从登录页中查找一个隐藏的authenticity_token字段。

借助F12发现,公司的自动化平台登录页中也包含了这样一个隐藏字段,试之,果然成功了......

"多年后的一个平静的下午,当我无意间浏览了一片CSRF攻击的帖子,突然眼前一亮......老衲终于明白了这个authenticity_token的含义了!!!终于彻底理解了当年困扰我两小时的难题了!!!"

其实,该token的作用就是防御CSRF攻击,关于什么是CSRF,还得先了解下Session id。

HTTP请求的一大特点就是无状态,这也就导致服务端无法区分请求来自哪个客户端。为了记录每个用户的状态,跟踪用户的整个会话,web程序普遍采用了cookie与session技术。(由于cookie与session的内容过多,在此不表,详细原理可以参考一片文章: Cookie与Session机制 )

关于cookie与session,最需要了解的几点是:

根据session机制以上特点,就引申出了一个问题:CSRF攻击。

用户每次点击一个链接、提交一个表单,其本质就是对服务端发起一次请求。而CSRF攻击的原理就是:攻击者诱导用户点击一个链接,用户在不知情的情况下提交了一次表单请求。而表单的内容则是攻击者事先准备好的。

简单举个栗子🌰:

备注: 以上攻击成功实施的关键在于,小明已经登录论坛A,并且点击跳转后的浏览器子窗体是可以访问父窗体的session id的。

假如小明复制该链接,然后手动打开一个新的浏览器粘贴访问该链接,则会提示用户处于非登录状态,该发帖请求会被拒绝。原因是新打开的浏览器无法获取前一个浏览器中的session id,服务端会将该请求当成一个新的会话,需要重新登录后才能成功执行发帖请求。

既然大家都了解CRSF攻击,自然有相应的防御措施,其中比较常用的就是采用token验证。

工作机制就是: 用户在发送表单时还需要携带一个token值 。该token一般是填写表单页中的一个隐藏字段,每次访问都不同。通过该token的验证,服务端就能知道用户的表单请求是否从表单填写页面跳转而来了。

简单举例:

简单来说,服务端每次通过请求数据中的token来验证表单请求是否由用户主动发送的,从而有效防御了CRSF攻击。

至此,也就明白了为什么登录页面时需要携带一个authenticity_token参数了,同时也理解了为什么需要访问登录页面获取该token。😄

Python爬虫模拟登录带验证码网站

问题分析:

1、爬取网站时经常会遇到需要登录的问题,这是就需要用到模拟登录的相关方法。python提供了强大的url库,想做到这个并不难。这里以登录学校教务系统为例,做一个简单的例子。

2、首先得明白cookie的作用,cookie是某些网站为了辨别用户身份、进行session跟踪而储存在用户本地终端上的数据。因此我们需要用Cookielib模块来保持网站的cookie。

3、这个是要登陆的地址 http://202.115.80.153/ 和验证码地址 http://202.115.80.153/CheckCode.aspx

4、可以发现这个验证码是动态更新的每次打开都不一样,一般这种验证码和cookie是同步的。其次想识别验证码肯定是吃力不讨好的事,因此我们的思路是首先访问验证码页面,保存验证码、获取cookie用于登录,然后再直接向登录地址post数据。

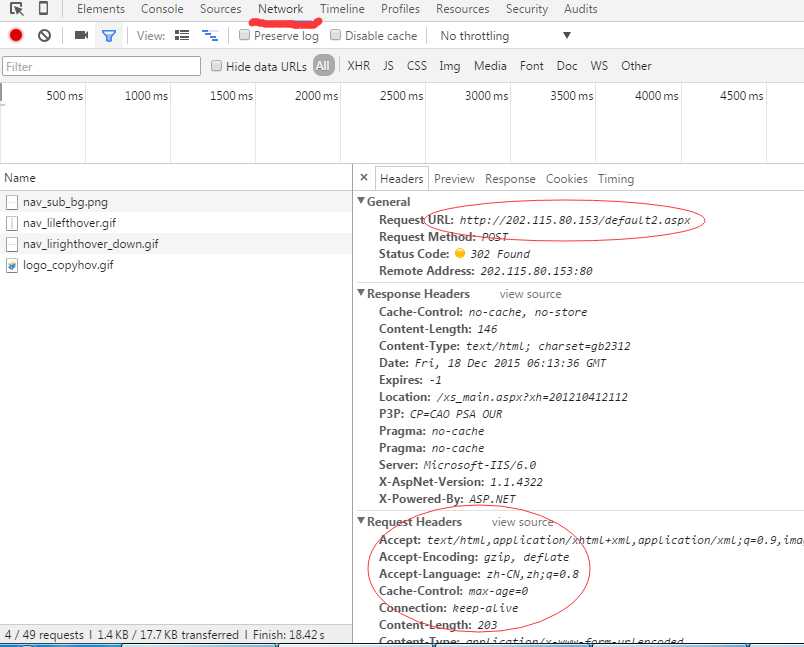

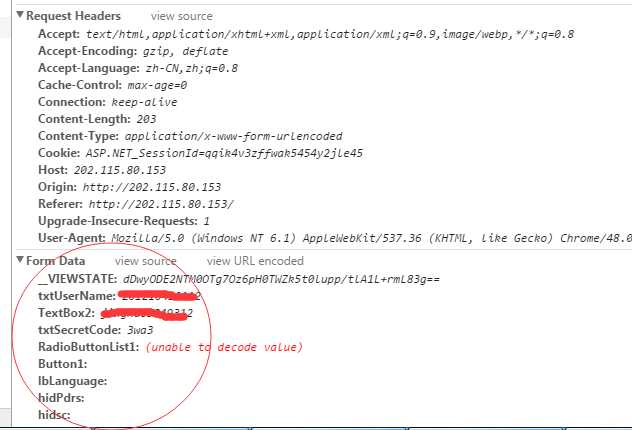

5、首先通过抓包工具或者火狐或者谷歌浏览器分析登录页面需要post的request和header信息。以谷歌浏览器为例。

从中可以看出需要post的url并不是访问的页面,而是http://202.115.80.153/default2.aspx,

其中需要提交的表单数据中txtUserName和TextBox2分别用户名和密码。

现在直接到关键部分 上代码!!

1 import urllib2 2 import cookielib 3 import urllib 4 import re 5 import sys 6 ‘‘‘模拟登录‘‘‘ 7 reload(sys) 8 sys.setdefaultencoding("utf-8") 9 # 防止中文报错 10 CaptchaUrl = "http://202.115.80.153/CheckCode.aspx" 11 PostUrl = "http://202.115.80.153/default2.aspx" 12 # 验证码地址和post地址 13 cookie = cookielib.CookieJar() 14 handler = urllib2.HTTPCookieProcessor(cookie) 15 opener = urllib2.build_opener(handler) 16 # 将cookies绑定到一个opener cookie由cookielib自动管理 17 username = ‘username‘ 18 password = ‘password123‘ 19 # 用户名和密码 20 picture = opener.open(CaptchaUrl).read() 21 # 用openr访问验证码地址,获取cookie 22 local = open(‘e:/image.jpg‘, ‘wb‘) 23 local.write(picture) 24 local.close() 25 # 保存验证码到本地 26 SecretCode = raw_input(‘输入验证码: ‘) 27 # 打开保存的验证码图片 输入 28 postData = { 29 ‘__VIEWSTATE‘: ‘dDwyODE2NTM0OTg7Oz6pH0TWZk5t0lupp/tlA1L+rmL83g==‘, 30 ‘txtUserName‘: username, 31 ‘TextBox2‘: password, 32 ‘txtSecretCode‘: SecretCode, 33 ‘RadioButtonList1‘: ‘学生‘, 34 ‘Button1‘: ‘‘, 35 ‘lbLanguage‘: ‘‘, 36 ‘hidPdrs‘: ‘‘, 37 ‘hidsc‘: ‘‘, 38 } 39 # 根据抓包信息 构造表单 40 headers = { 41 ‘Accept‘: ‘text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,*/*;q=0.8‘, 42 ‘Accept-Language‘: ‘zh-CN,zh;q=0.8‘, 43 ‘Connection‘: ‘keep-alive‘, 44 ‘Content-Type‘: ‘application/x-www-form-urlencoded‘, 45 ‘User-Agent‘: ‘Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/46.0.2490.86 Safari/537.36‘, 46 } 47 # 根据抓包信息 构造headers 48 data = urllib.urlencode(postData) 49 # 生成post数据 ?key1=value1&key2=value2的形式 50 request = urllib2.Request(PostUrl, data, headers) 51 # 构造request请求 52 try: 53 response = opener.open(request) 54 result = response.read().decode(‘gb2312‘) 55 # 由于该网页是gb2312的编码,所以需要解码 56 print result 57 # 打印登录后的页面 58 except urllib2.HTTPError, e: 59 print e.code 60 # 利用之前存有cookie的opener登录页面

登录成功后便可以利用该openr访问其他需要登录才能访问的页面。

以上是关于Python爬虫模拟登录遇到的问题——CSRF防御的主要内容,如果未能解决你的问题,请参考以下文章