EfficientNet算法笔记

Posted AI之路

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了EfficientNet算法笔记相关的知识,希望对你有一定的参考价值。

论文:EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks

论文链接:https://arxiv.org/abs/1905.11946

代码链接:https://github.com/tensorflow/tpu/tree/master/models/official/efficientnet

第三方实现的PyTorch代码:https://github.com/lukemelas/EfficientNet-PyTorch

这篇ICML2019的论文对目前分类网络的优化提出更加泛化的思想,认为目前常用的加宽网络、加深网络和增加分辨率这3种常用的提升网络指标的方式之间不应该是相互独立的。因此提出了compound model scaling算法,通过综合优化网络宽度、网络深度和分辨率达到指标提升的目的,能够达到准确率指标和现有分类网络相似的情况下,大大减少模型参数量和计算量。

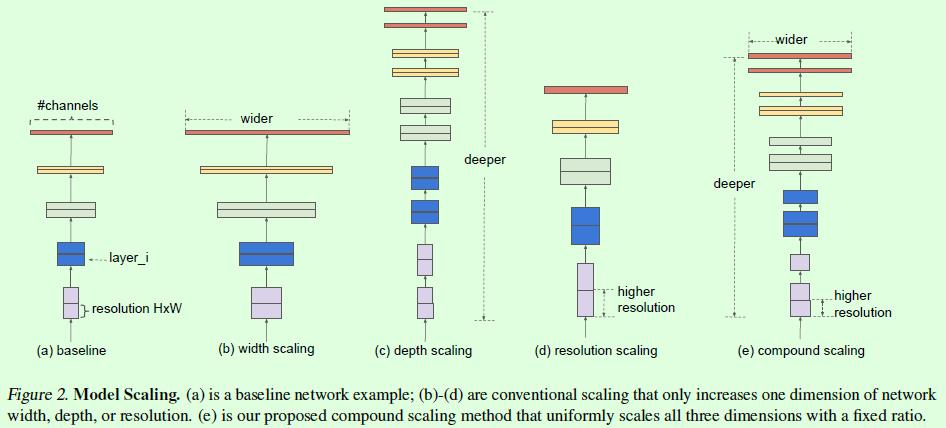

首先通过Figure2了解下model scaleing的含义。作者将目前分类网络的model scaling大致分为:加宽网络、加深网络和增大分辨率,也就是分别对应Figure2中的(b)、(c)、(d),这3个分别从不同的维度来做model scaling,举个例子,对ResNet网络做深度方面的model scaling可以得到ResNet50、ResNet101等不同深度的网络结构。而这篇论文要做的是将这3者结合起来一起优化,也就是(e)。

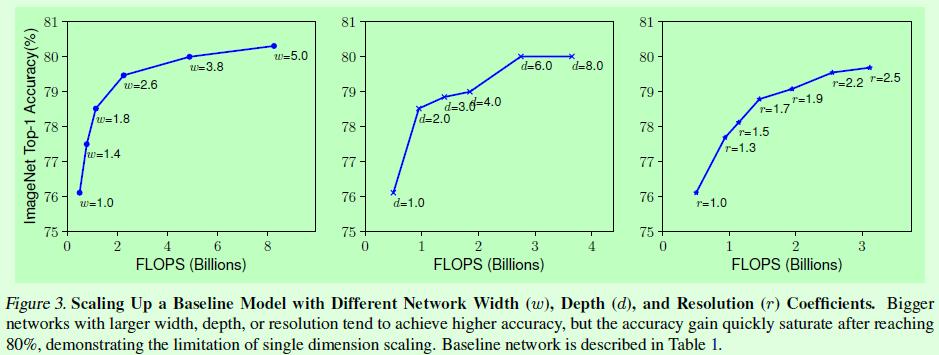

那么第一个问题就是:单个维度做scaling存在什么问题吗?针对这个问题,作者做了Figure3这个实验,也就是针对某个分类网络的3个维度(宽度、深度和分辨率)分别做model scaling的结果对比。显然,单独优化这3个维度都能提升模型效果,但上限也比较明显,基本上在Acc达到80后提升就很小了。

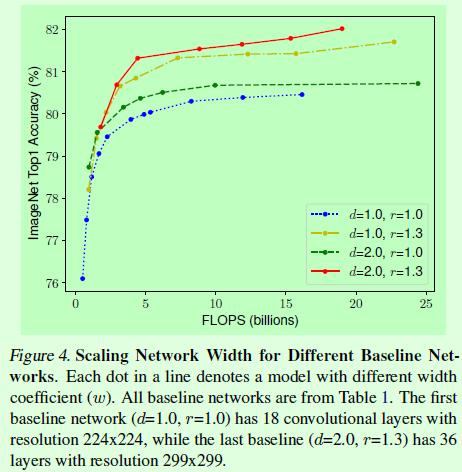

既然如此,假如多个维度结合做scaling效果如何?针对这个问题,作者做了Figure4这个实验,相当于手动设置3个维度的model scaling参数。蓝色线表示的是只对宽度做model scaling的实验结果,上面的每个点表示不同宽度的网络,因此不同线条上相同顺序的点表示的网络宽度设置是一样的。可以看到,通过手动设置3个维度的model scaling参数就能有效提升模型的效果(突破80),这就说明多维度融合是有效的。

那么接下来的问题就是,怎么找到最优的3个维度的scaling参数?这就是这篇文章提出的compound model scaling算法要解决的问题。

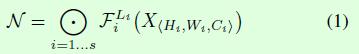

首先看看一些符号定义,在公式1中,N表示分类网络,X表示输入,Fi表示基础网络层,i表示stage,Li表示Fi结构在第i个stage中的重复数量。公式1这样的定义方式对应的最直观例子就是ResNet系列网络,我们知道ResNet系列网络有多个stage,每个stage包含不同数量的block结构。

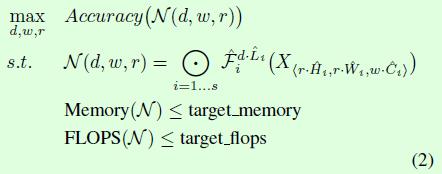

那么model scaling的目标就是在模型参数和计算量满足限制条件的情况下最大化网络的准确率,也就是公式2所表达的内容,待优化的参数就是网络深度(d)、网络宽度(w)和分辨率(r)。

为了找到满足公式2的3个维度参数,这篇论文引入Φ参数,并将3个待优化参数都用Φ指数表示,如公式3所示,同时对底做了数值限制,做限制可以减少网格搜索时的计算量,而具体的限制公式确定是为了方便计算FLOPS。这里需要说明一下d、w和r参数对FLOPS计算的影响,以卷积层为例,假如d变成原来的2倍,那么FLOPS也会变成原来的2倍;假如w变成原来的2倍,那么FLOPS就变成原来的4倍,因为输入输出通道都变成原来的2倍了,所以在计算量方面相当于4倍;r和w同理。

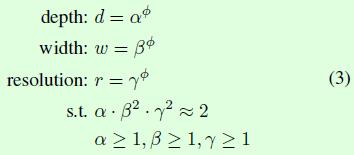

准备好优化公式后,作者还通过网络结构搜索设计了一个baseline网络,也就是EfficientNet-B0,如Table1所示,网络结构比较简单,方便后续测试compound model scaling算法的效果。

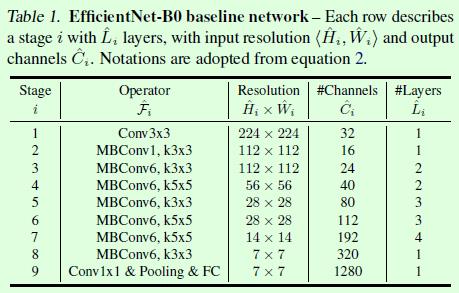

在优化求解方面,作者提出2步优化,第一步是固定Φ=1,然后通过网格搜索找到满足公式3的最优α、β、γ,比如对于EfficientNet-B0网络而言,最佳的参数分别是α=1.2、β=1.1、γ=1.15(此时得到的也就是EfficientNet-B1)。第二步是固定第一步求得的α、β、γ参数,然后用不同的Φ参数得到EfficientNet-B1到EfficientNet-B7网络,最后的实验结果如Table2所示,可以看到EfficientNet系列网络在取得和其他分类网络差不多的准确率时,参数量和计算量都很减少很多。

理论上,假如EfficientNet-B0网络是全卷积,且做scale操作过程中没有小数的取整操作,那么从EfficientNet-B0到EfficientNet-B7网络的FLOPS应该是严格的2^Φ关系,但从Table2来看显然没有,主要是因为scale过程中的取整操作以及EfficientNet-B0网络并非全卷积结构。

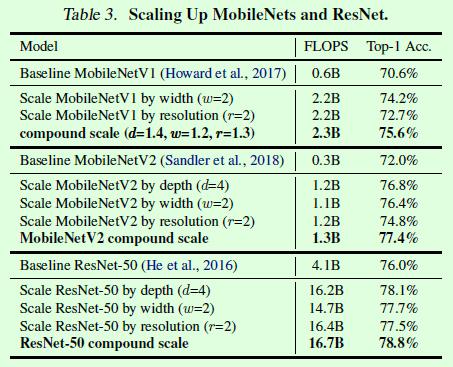

在最后的实验中,作者将compound model scaling算法应用在其他现有的分类模型中,发现同样有效,说明泛化效果还不错,如Table3所示。

以上是关于EfficientNet算法笔记的主要内容,如果未能解决你的问题,请参考以下文章