pytorch学习-4:快速搭建+保存提取

Posted Paul-Huang

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了pytorch学习-4:快速搭建+保存提取相关的知识,希望对你有一定的参考价值。

快速搭建+保存提取

1. 快速搭建

- 上一讲神经网络时用到的步骤. 我们用

net1代表这种方式搭建的神经网络。 - 用 class 继承了一个 torch 中的神经网络结构, 然后对其进行了修改。

class Net(torch.nn.Module):

def __init__(self, n_feature, n_hidden, n_output):

super(Net, self).__init__()

self.hidden = torch.nn.Linear(n_feature, n_hidden)

self.predict = torch.nn.Linear(n_hidden, n_output)

def forward(self, x):

x = F.relu(self.hidden(x))

x = self.predict(x)

return x

net1 = Net(1, 10, 1) # 这是我们用这种方式搭建的 net1

- 有更快的一招, 用一句话就概括了上面所有的内容!

net2 = torch.nn.Sequential(

torch.nn.Linear(1, 10),

torch.nn.ReLU(),

torch.nn.Linear(10, 1)

)

1.1 对比

print(net1)

"""

Net (

(hidden): Linear (1 -> 10)

(predict): Linear (10 -> 1)

)

"""

print(net2)

"""

Sequential (

(0): Linear (1 -> 10)

(1): ReLU ()

(2): Linear (10 -> 1)

)

"""

net2多显示了一些内容, 它把激励函数也一同纳入进去了;net1中, 激励函数实际上是在forward()功能中才被调用的。- 相比

net2,net1的好处就是, 你可以根据你的个人需要更加个性化你自己的前向传播过程, 比如(RNN)。

2. 模型保存、提取

2.1 模型保存

- 快速地建造数据, 搭建网络:

torch.manual_seed(1) # reproducible

# 假数据

x = torch.unsqueeze(torch.linspace(-1, 1, 100), dim=1) # x data (tensor), shape=(100, 1)

y = x.pow(2) + 0.2*torch.rand(x.size()) # noisy y data (tensor), shape=(100, 1)

def save():

# 建网络

net1 = torch.nn.Sequential(

torch.nn.Linear(1, 10),

torch.nn.ReLU(),

torch.nn.Linear(10, 1)

)

optimizer = torch.optim.SGD(net1.parameters(), lr=0.5)

loss_func = torch.nn.MSELoss()

# 训练

for t in range(100):

prediction = net1(x)

loss = loss_func(prediction, y)

optimizer.zero_grad()

loss.backward()

optimizer.step()

- 保存模型:

torch.save(net1, 'net.pkl') # 保存整个网络

torch.save(net1.state_dict(), 'net_params.pkl') # 只保存网络中的参数 (速度快, 占内存少)

2.2 提取网络

- 方法1:提取网络

def restore_net():

# restore entire net1 to net2

net2 = torch.load('net.pkl')

prediction = net2(x)

- 方法2:只提取网络参数

def restore_params():

# 新建 net3

net3 = torch.nn.Sequential(

torch.nn.Linear(1, 10),

torch.nn.ReLU(),

torch.nn.Linear(10, 1)

)

# 将保存的参数复制到 net3

net3.load_state_dict(torch.load('net_params.pkl'))

prediction = net3(x)

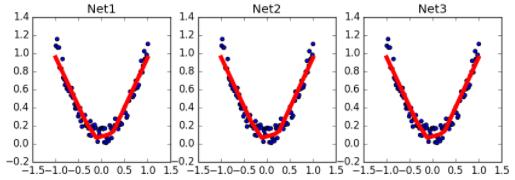

2.3 显示结果

调用上面建立的几个功能, 然后出图。

# 保存 net1 (1. 整个网络, 2. 只有参数)

save()

# 提取整个网络

restore_net()

# 提取网络参数, 复制到新网络

restore_params()

参考

以上是关于pytorch学习-4:快速搭建+保存提取的主要内容,如果未能解决你的问题,请参考以下文章