Azure Data PlatformETL工具(22)——Azure Databricks与ADF整合

Posted 發糞塗牆

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Azure Data PlatformETL工具(22)——Azure Databricks与ADF整合相关的知识,希望对你有一定的参考价值。

本文属于【Azure Data Platform】系列。

接上文:【Azure Data Platform】ETL工具(21)——Azure Databricks使用(1)——访问Azure Blob

本文演示如何整合ADF和Azure Databricks

环境准备

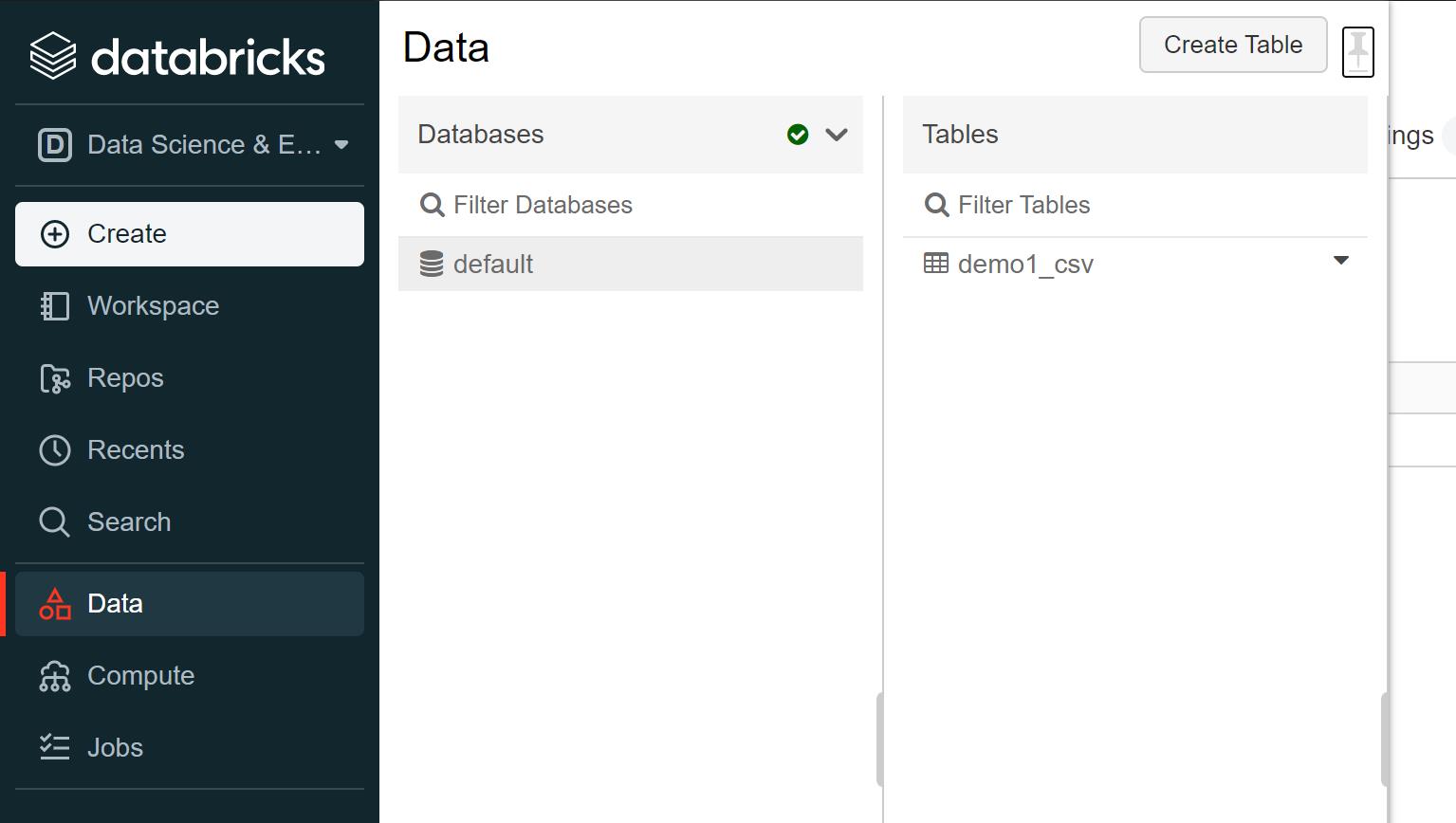

前面已经演示过如何创建ADF和Azure Databricks,下面来演示如何整合它们。首先对于Azure Databricks,先要创建集群(集群是基础),然后创建一个表。

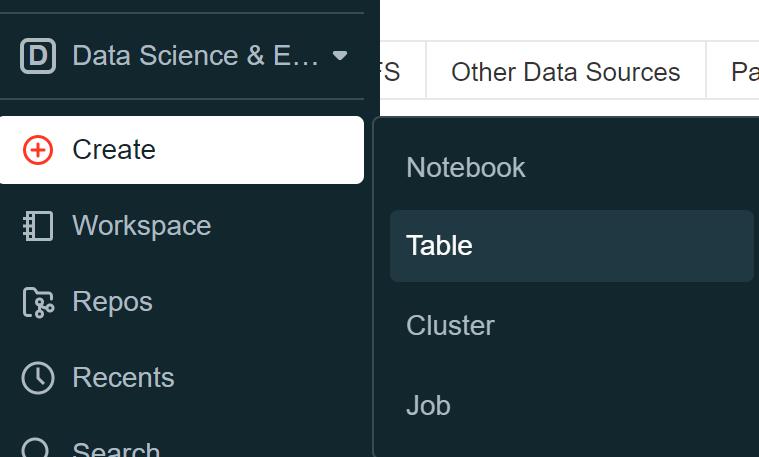

如下图导航:

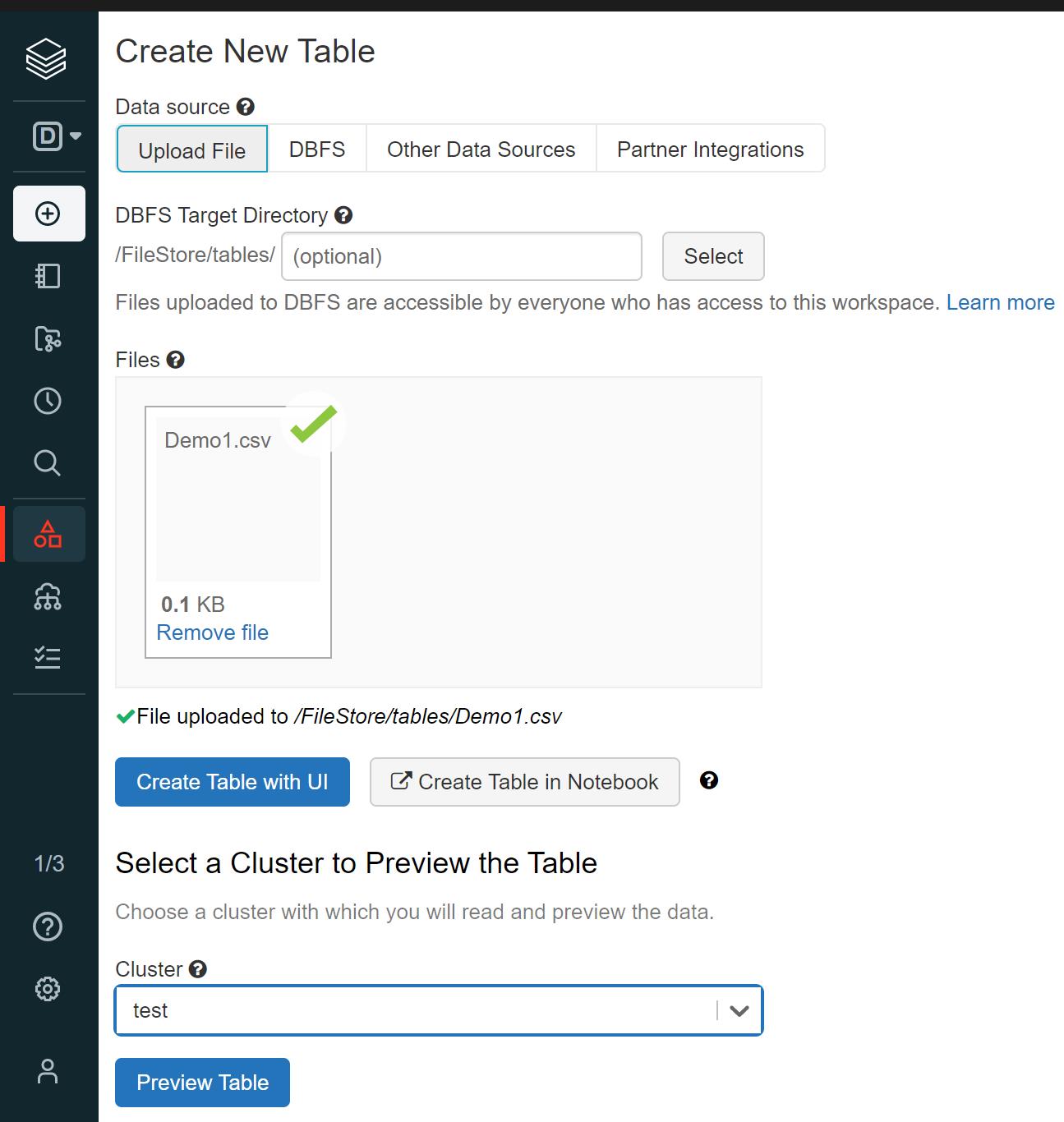

会出现一个新界面,提示创建新表的配置。可以通过上传文件,也可以通过其他数据源。这里先用前面用过的文件作为数据源上传,上传完毕后,可以选择集群:

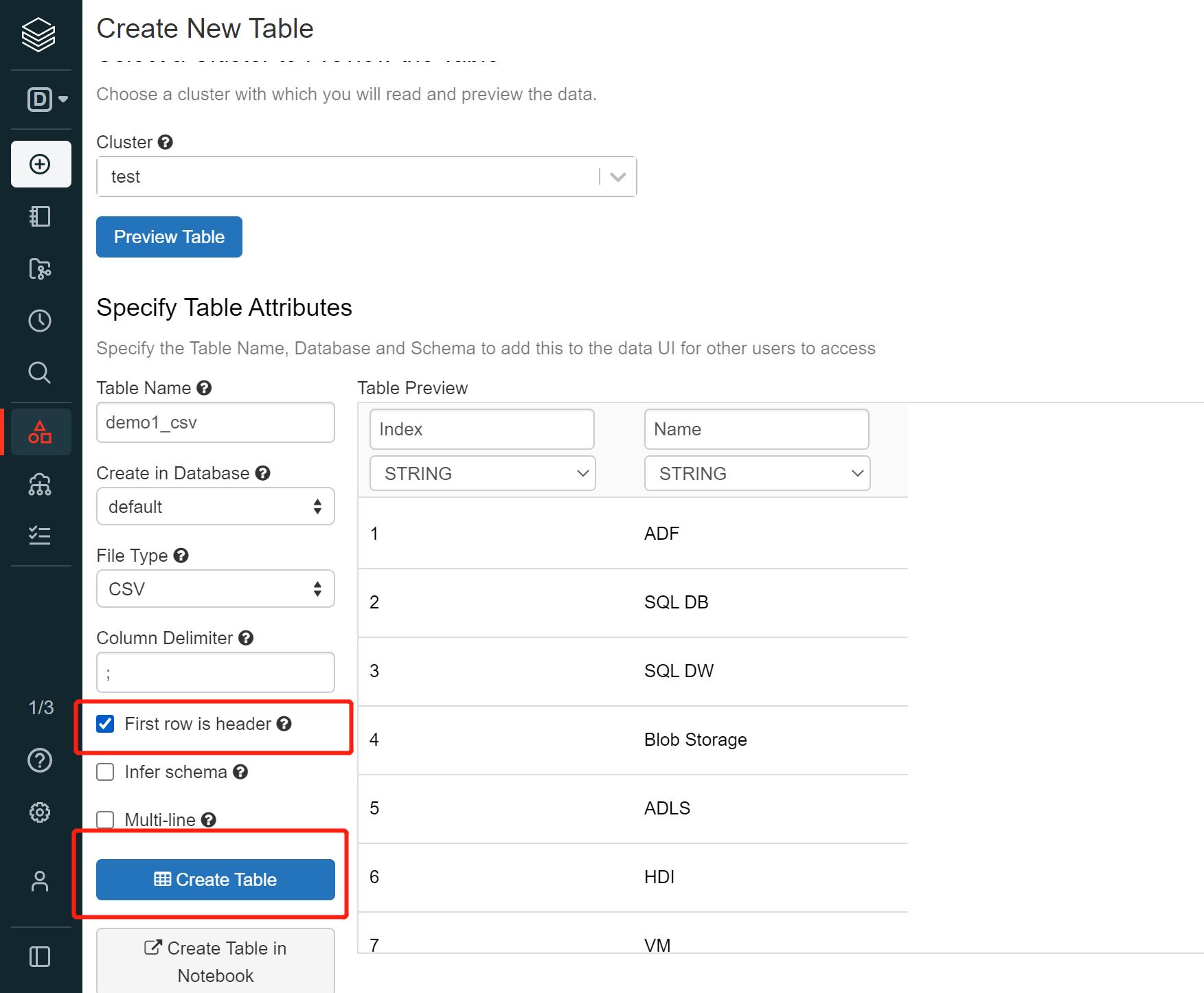

然后点击【preview table】可以看到下图所示,同时因为文件的第一行是表头,所以勾选“First row is header”,点击【create table】创建Databricks的表。

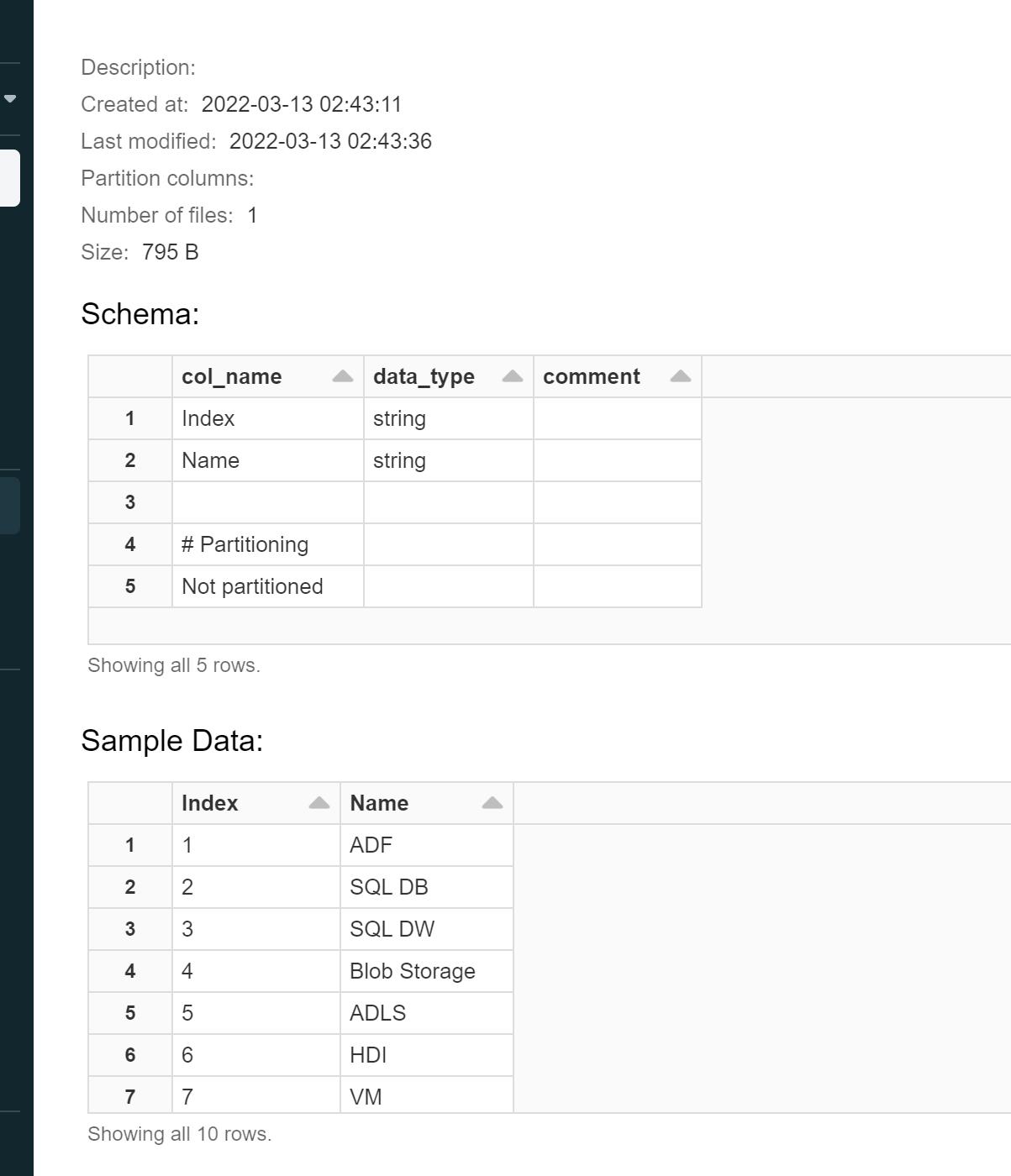

创建成功后会看到如下信息:

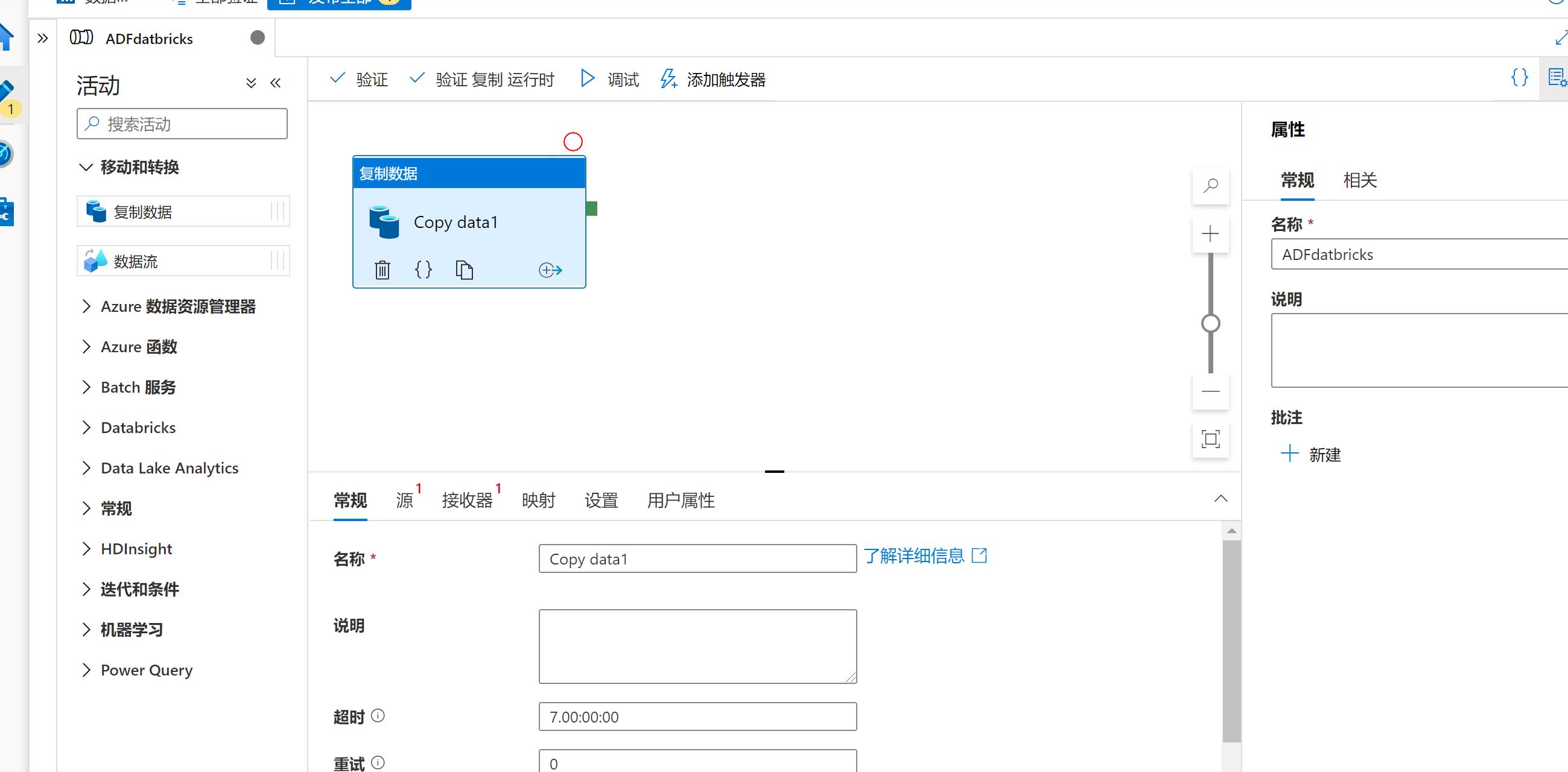

配置ADF

配置好Databricks之后,就可以开始配置ADF, 本文主要演示集成,所以不打算花太多功能,这里用copy data来做演示,只打算打通ADF和Databricks的连接即可。

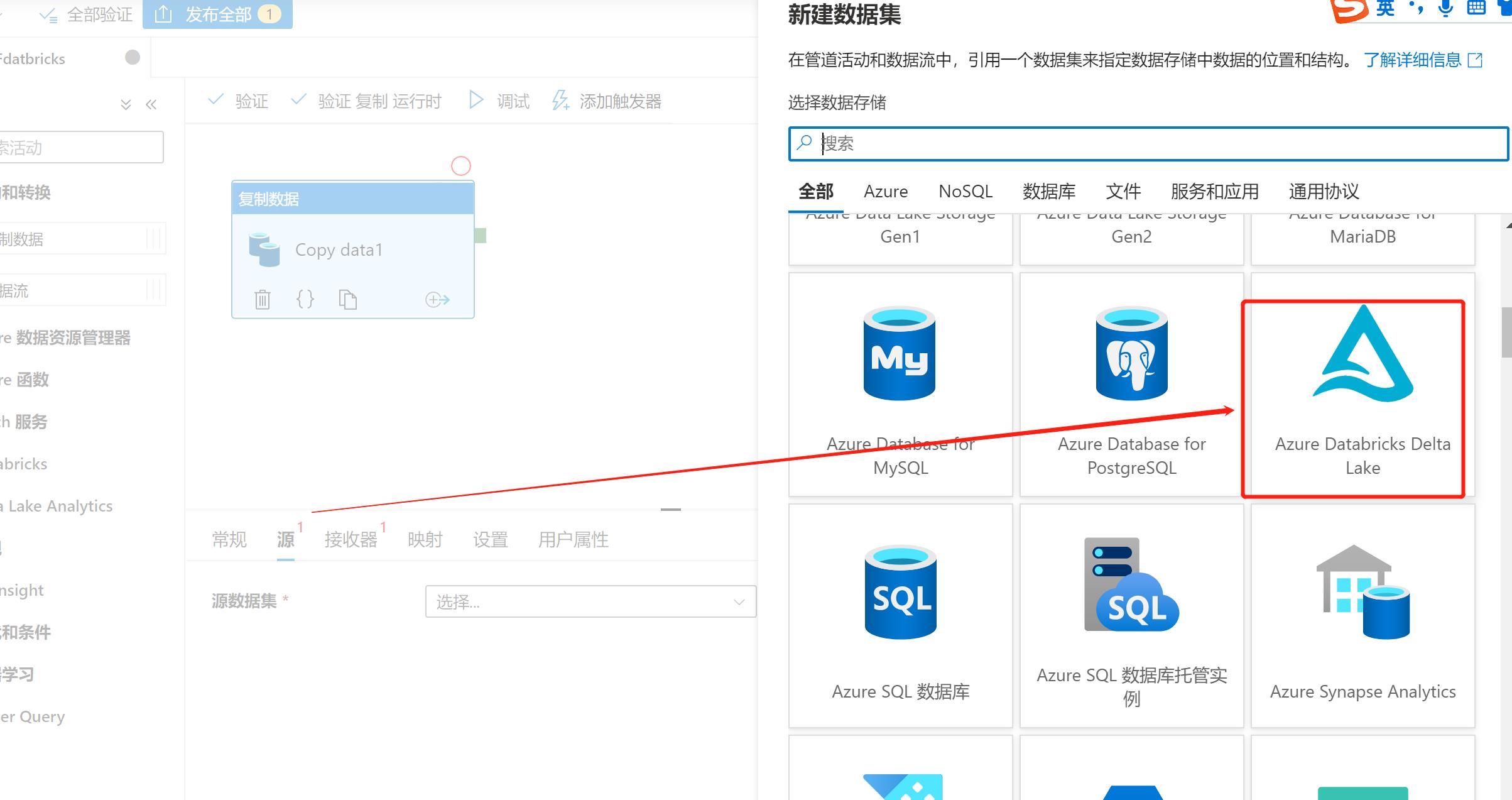

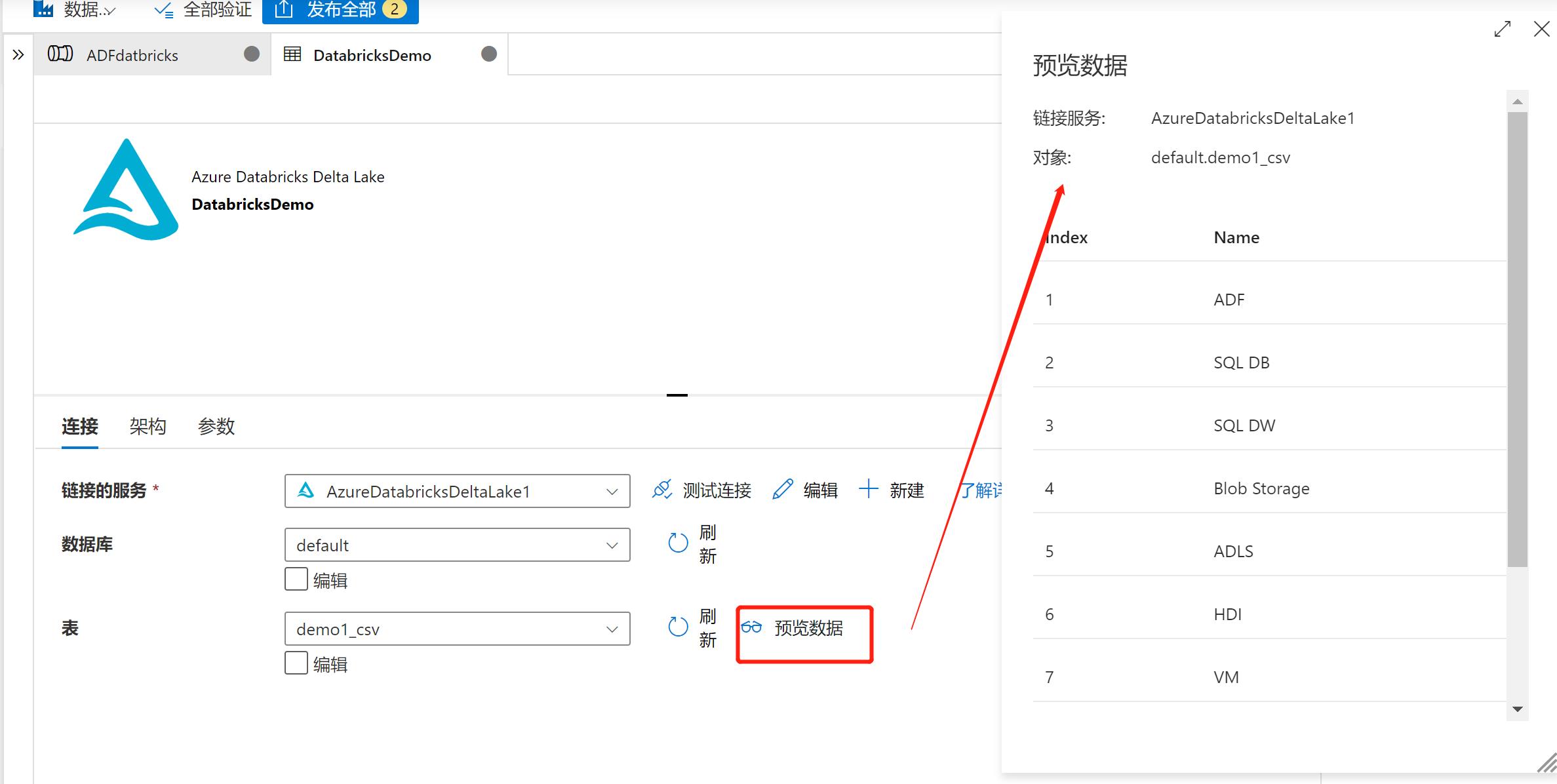

在源中,选择新建数据集,这个数据集来自于Azure Databricks Delta Lake。

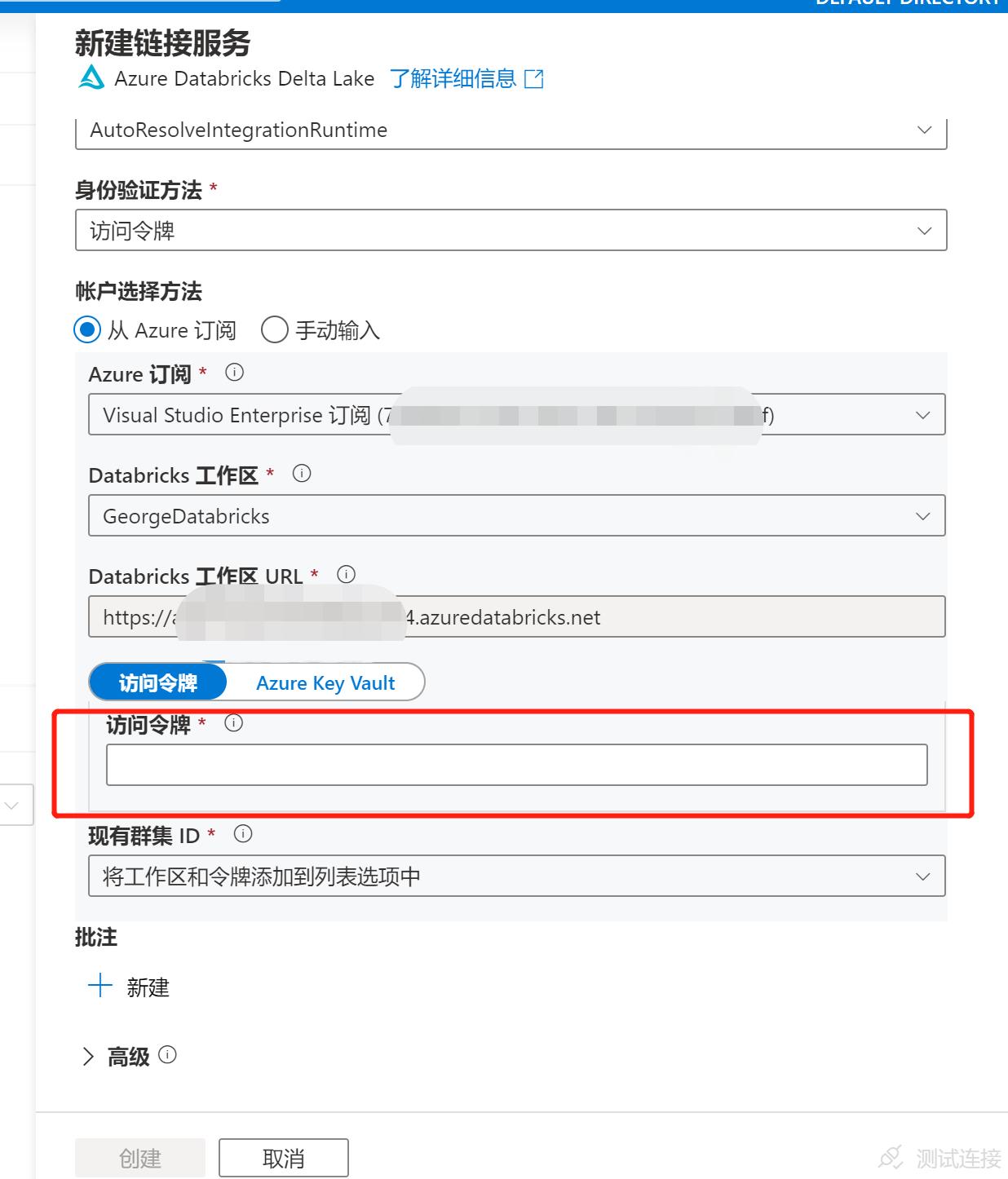

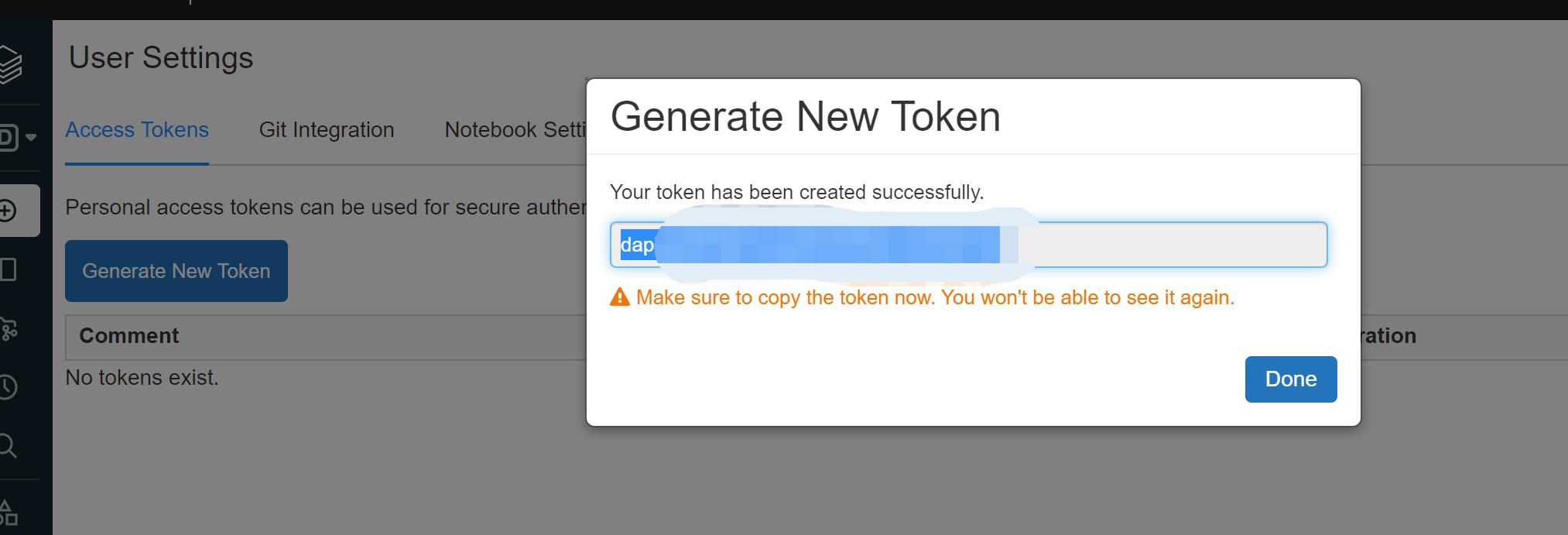

创建期间需要输入一些信息,特别注意访问令牌。这个访问令牌需要从Databricks中获取:

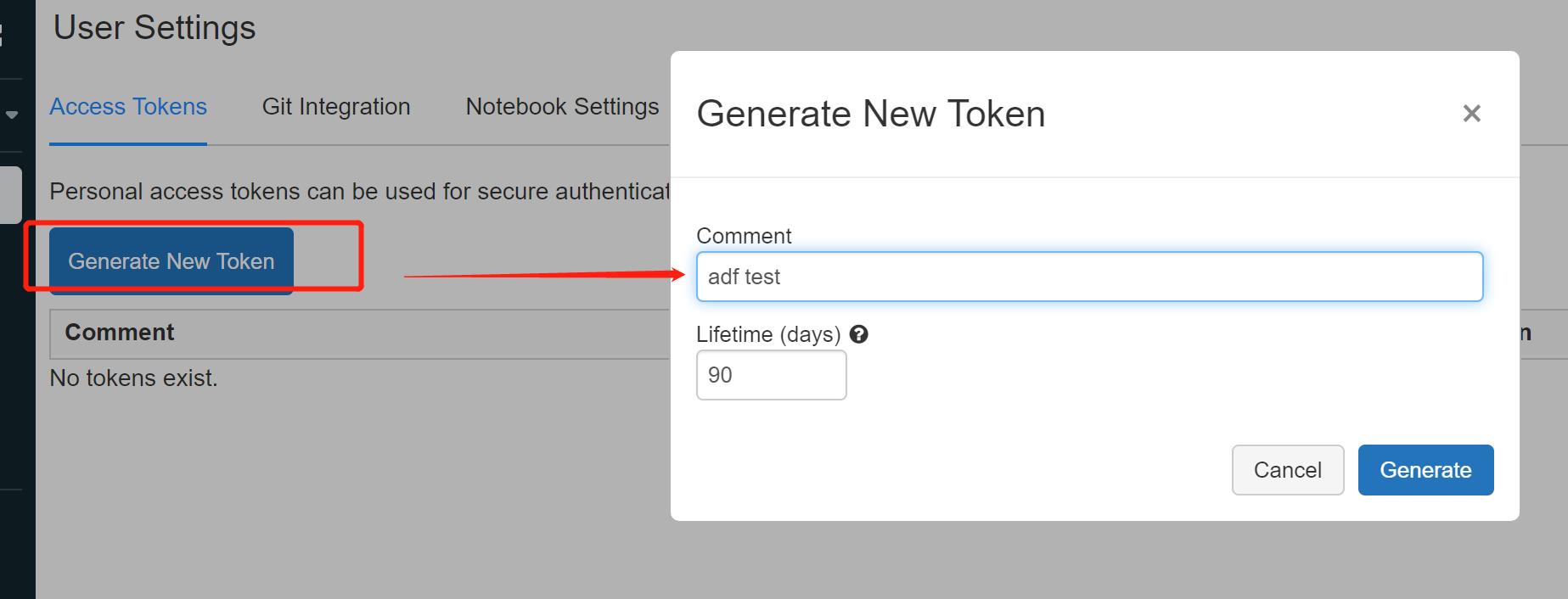

回到Databricks工作区,选择settings→User Settings

就可以看到生成Token的地方。

注意下面红字,要确保你的token已经复制成功,否则只能重新生成:

把token贴进去ADF 数据集的配置中,接下来可以配置数据库,这里的数据库是Databricks的数据库:

选择对应的数据库和表:

可成功预览数据。

到此为止,ADF已经可以与Databricks连通。

使用这种方式,可以对数据源的数据先进行定制处理,然后借助ADF抽取数据。这样做的其中一个好处就是借助Databricks的能力和集群的计算力,把ETL过程的T先处理。然后让ADF只负责自己擅长的E和L即可。对于复杂应用,是比较好的方式,毕竟ADF并不擅长复杂的T(转换)工作。

以上是关于Azure Data PlatformETL工具(22)——Azure Databricks与ADF整合的主要内容,如果未能解决你的问题,请参考以下文章