基于mediapipe的动作捕捉和Unity的球棍模型同步

Posted maxindemaxinde

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了基于mediapipe的动作捕捉和Unity的球棍模型同步相关的知识,希望对你有一定的参考价值。

基于mediapipe的动作捕捉和Unity的球棍模型同步

所需环境

这是我所使用的环境

python3.9 安装mediapipe和opencv-python包

python和Unity通信使用socket

Unity2021.3

python端

如何安装那两个包我就不说了,大家有不明白可以去百度

mediapipe和opencv-python

1.把我们要使用的mediapipe的功能封装成一个module

这个module返回一个列表,列表中存放mediapipe识别到的特征点

import cv2

import mediapipe as mp

import time

class poseDetector():

def __init__(self, mode=False, upBody=False, smooth=True, detectionCon=0.5, trackCon=0.5):

self.mode = mode

self.upBody = upBody

self.smooth = smooth

self.detectionCon = detectionCon

self.trackCon = trackCon

self.mpDraw = mp.solutions.drawing_utils

self.mpPose = mp.solutions.pose

self.pose = self.mpPose.Pose(self.mode, self.upBody, self.smooth, False, True, # 这里的False 和True为默认

self.detectionCon, self.trackCon) # pose对象 1、是否检测静态图片,2、姿态模型的复杂度,3、结果看起来平滑(用于video有效),4、是否分割,5、减少抖动,6、检测阈值,7、跟踪阈值

'''

STATIC_IMAGE_MODE:如果设置为 false,该解决方案会将输入图像视为视频流。它将尝试在第一张图像中检测最突出的人,并在成功检测后进一步定位姿势地标。在随后的图像中,它只是简单地跟踪那些地标,而不会调用另一个检测,直到它失去跟踪,以减少计算和延迟。如果设置为 true,则人员检测会运行每个输入图像,非常适合处理一批静态的、可能不相关的图像。默认为false。

MODEL_COMPLEXITY:姿势地标模型的复杂度:0、1 或 2。地标准确度和推理延迟通常随着模型复杂度的增加而增加。默认为 1。

SMOOTH_LANDMARKS:如果设置为true,解决方案过滤不同的输入图像上的姿势地标以减少抖动,但如果static_image_mode也设置为true则忽略。默认为true。

UPPER_BODY_ONLY:是要追踪33个地标的全部姿势地标还是只有25个上半身的姿势地标。

ENABLE_SEGMENTATION:如果设置为 true,除了姿势地标之外,该解决方案还会生成分割掩码。默认为false。

SMOOTH_SEGMENTATION:如果设置为true,解决方案过滤不同的输入图像上的分割掩码以减少抖动,但如果 enable_segmentation设置为false或者static_image_mode设置为true则忽略。默认为true。

MIN_DETECTION_CONFIDENCE:来自人员检测模型的最小置信值 ([0.0, 1.0]),用于将检测视为成功。默认为 0.5。

MIN_TRACKING_CONFIDENCE:来自地标跟踪模型的最小置信值 ([0.0, 1.0]),用于将被视为成功跟踪的姿势地标,否则将在下一个输入图像上自动调用人物检测。将其设置为更高的值可以提高解决方案的稳健性,但代价是更高的延迟。如果 static_image_mode 为 true,则忽略,人员检测在每个图像上运行。默认为 0.5。

'''

def findPose(self, img, draw=True):

imgRGB = cv2.cvtColor(img, cv2.COLOR_BGR2RGB) # 将BGR格式转换成灰度图片

self.results = self.pose.process(imgRGB) # 处理 RGB 图像并返回检测到的最突出人物的姿势特征点。

if self.results.pose_landmarks:

if draw:

self.mpDraw.draw_landmarks(img, self.results.pose_landmarks, self.mpPose.POSE_CONNECTIONS)

# results.pose_landmarks画点 mpPose.POSE_CONNECTIONS连线

return img

def findPosition(self, img, draw = True):

#print(results.pose_landmarks)

lmList = []

if self.results.pose_landmarks:

for id, lm in enumerate(self.results.pose_landmarks.landmark): # enumerate()函数用于将一个可遍历的数据对象(如列表、元组或字符串)组合为一个索引序列,同时列出数据和数据下标

h, w, c = img.shape # 返回图片的(高,宽,位深)

cx, cy, cz = int(lm.x * w), int(lm.y * h), int(lm.z * w) # lm.x lm.y是比例 乘上总长度就是像素点位置

lmList.append([id, cx, cy, cz])

if draw:

cv2.circle(img, (cx, cy), 5, (255, 0, 0), cv2.FILLED) # 画蓝色圆圈

return lmList

def main():

# cap = cv2.VideoCapture(0) # 调用电脑摄像头

# cap = cv2.VideoCapture('video/2.mp4') # 视频

# cap = cv2.VideoCapture('video/3.png')

cap = cv2.VideoCapture('video/ASOUL.mp4')

pTime = 0

detector = poseDetector()

while True:

success, img = cap.read() # 第一个参数代表有没有读取到图片True/False 第二个参数frame表示截取到一帧的图片 读进来直接是BGR 格式数据格式

img = detector.findPose(img)

lmList = detector.findPosition(img)

if len(lmList) != 0:

print(lmList) # print(lmList[n]) 可以打印第n个

# 计算帧率

cTime = time.time()

fps = 1 / (cTime - pTime)

pTime = cTime

cv2.putText(img, str(int(fps)), (70, 50), cv2.FONT_HERSHEY_PLAIN, 3,

(255, 0, 0), 3) # 图片上添加文字 参数:图片 要添加的文字 文字添加到图片上的位置 字体的类型 字体大小 字体颜色 字体粗细

cv2.imshow("Image", img) # 显示图片

cv2.waitKey(3) # 等待按键

if __name__ == "__main__":

main()

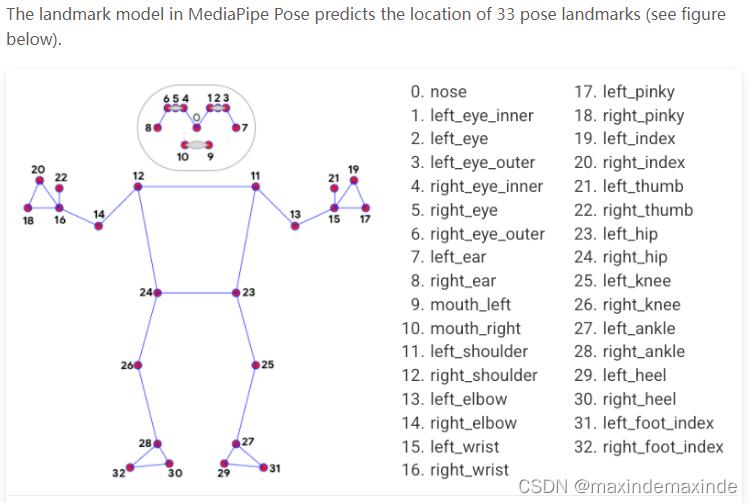

2.把一帧图像的33个特征点的信息变成一个字符串,以 “,”隔开

通过socket构建一个客户端client,把包含特征点信息的字符串发送到unity的服务端

import cv2

import time

import PoseModule as pm

import socket

pTime = 0

def computeFPS():

global pTime

cTime = time.time()

fps = 1 / (cTime - pTime)

pTime = cTime

cv2.putText(img, str(int(fps)), (70, 50), cv2.FONT_HERSHEY_PLAIN, 3,

(255, 0, 0), 3) # 图片上添加文字 参数:图片 要添加的文字 文字添加到图片上的位置 字体的类型 字体大小 字体颜色 字体粗细

# cap = cv2.VideoCapture(0) # 调用电脑摄像头

cap = cv2.VideoCapture('video/2.mp4') # 视频

# 构建一个实例,去连接服务端的监听端口。

client = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

client.connect(('127.0.0.1', 1234))

# msg=client.recv(1024)

# print('New message from server: %s' % msg.decode('utf-8'))

detector = pm.poseDetector()

strdata = "" # 定义字符串变量

while True:

success, img = cap.read() # 第一个参数代表有没有读取到图片True/False 第二个参数frame表示截取到一帧的图片 读进来直接是BGR 格式数据格式

img = detector.findPose(img)

lmList = detector.findPosition(img)

# if len(lmList) != 0:

# print(lmList)

if len(lmList) != 0:

for data in lmList:

print(data) # print(lmList[n]) 可以打印第n个

for i in range(1, 4):

if i == 2:

strdata = strdata + str(img.shape[0] - data[i]) + ','

else:

strdata = strdata + str(data[i]) + ','

print(strdata)

client.send(strdata.encode('utf-8'))

strdata = ""

computeFPS() # 计算帧率

cv2.imshow("Image", img) # 显示图片

cv2.waitKey(10) # 等待按键

unity端

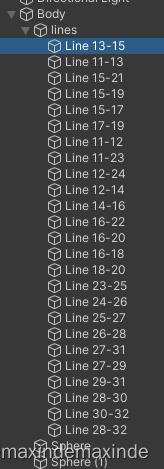

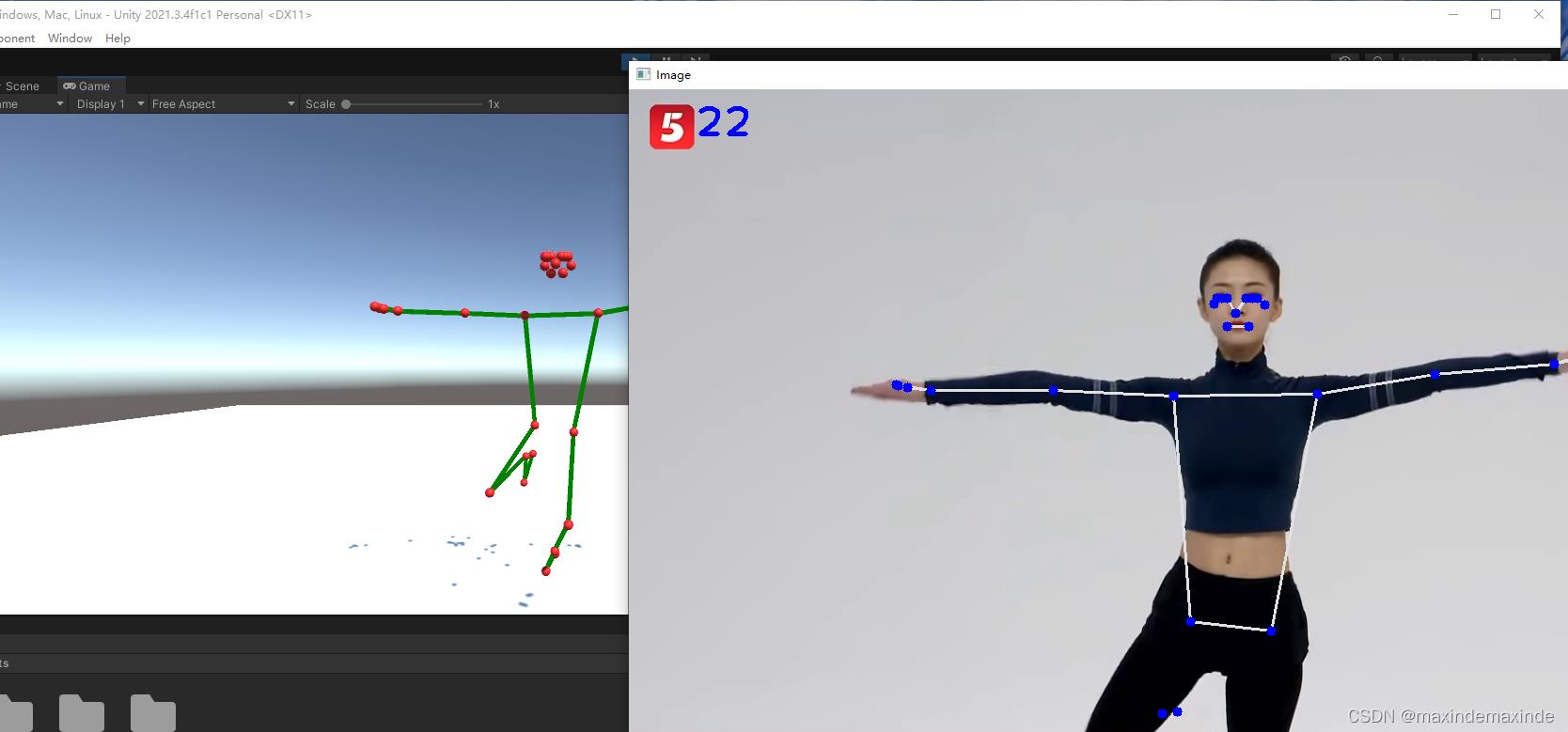

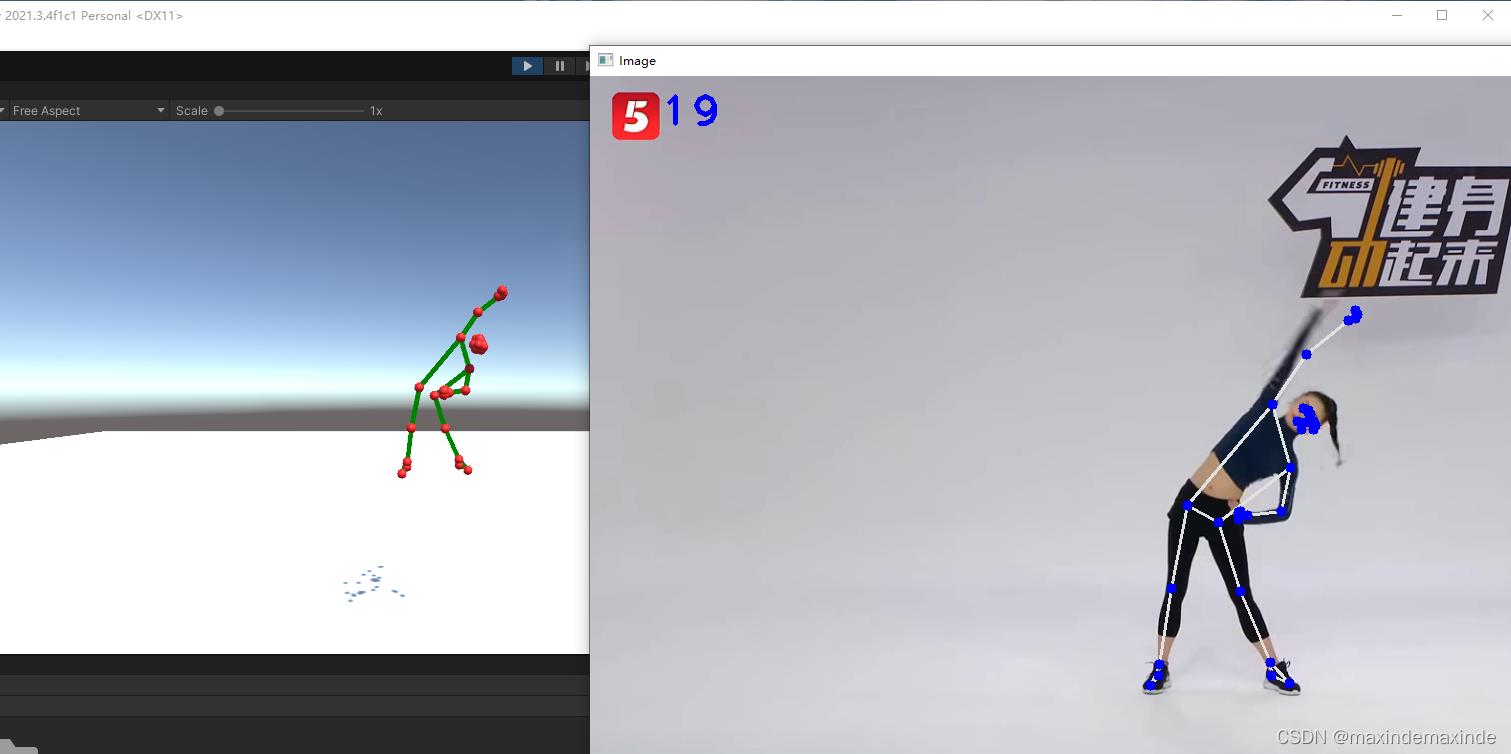

1.在场景中构建出人的球棍模型,不需要在意他们的位置,通过代码给他们赋值,场景中的层级结构如图

场景中33个红色的球表示特征点,绿色的线表示骨架

具体需要多少骨架可以自己决定,我没有弄头上的

2.通过socket创建一个服务端(server),接收python客户端传来的特征点坐标数据,赋值给unity场景中的特征点

using System;

using System.Collections;

using System.Collections.Generic;

using System.Net;

using System.Net.Sockets;

using System.Text;

using System.Threading;

using UnityEngine;

public class Server : MonoBehaviour

//public GameObject leftshoulder;

public GameObject[] Body;

private static int myProt = 9999; //端口

static Socket serverSocket;

Thread myThread;

string str;

Dictionary<string, Thread> threadDic = new Dictionary<string, Thread>();//存储线程,程序结束后关闭线程

private void Start()

//服务器IP地址 ,127.0.0.1 为本机IP地址

IPAddress ip = IPAddress.Parse("127.0.0.1");

//IPAddress ip = IPAddress.Any; //本机地址

Debug.Log(ip.ToString());

serverSocket = new Socket(AddressFamily.InterNetwork, SocketType.Stream, ProtocolType.Tcp);

IPEndPoint iPEndPoint = new IPEndPoint(ip, myProt);

//serverSocket.Bind(new IPEndPoint(ip, myProt)); //绑定IP地址:端口

serverSocket.Bind(iPEndPoint); //绑定IP地址:端口

serverSocket.Listen(10); //最多10个连接请求

//Console.WriteLine("creat service 0 success",

// serverSocket.LocalEndPoint.ToString());

myThread = new Thread(ListenClientConnect);

myThread.Start();

//Console.ReadLine();

Debug.Log("服务器启动...........");

public void Update()

if (str != null)

Debug.Log(str);//接受的数据

string[] points = str.Split(',');

Debug.Log(points.Length);

for (int i = 0; i <= 32; i++)

float x = float.Parse(points[0 + (i * 3)]) / 100;

float y = float.Parse(points[1 + (i * 3)]) / 100;

float z = float.Parse(points[2 + (i * 3)]) / 300;

Body[i].transform.localPosition = new Vector3(x, y, z);

// 监听客户端是否连接

private void ListenClientConnect()

while (true)

Socket clientSocket = serverSocket.Accept(); //1.创建一个Socket 接收客户端发来的请求信息 没有消息时堵塞

clientSocket.Send(Encoding.ASCII.GetBytes("Server Say Hello")); //2.向客户端发送 连接成功 消息

Thread receiveThread = new Thread(ReceiveMessage); //3.为已经连接的客户端创建一个线程 此线程用来处理客户端发送的消息

receiveThread.Start(clientSocket); //4.开启线程

//添加到字典中

string clientIp = ((IPEndPoint)clientSocket.RemoteEndPoint).Address.ToString();

//Debug.Log( clientSocket.LocalEndPoint.ToString()); //获取ip:端口号

if (!threadDic.ContainsKey(clientIp))

threadDic.Add(clientIp, receiveThread);

private byte[] result = new byte[1024]; //1.存入的byte值 最大数量1024

//开启线程接收数据 (将Socket作为值传入)

private void ReceiveMessage(object clientSocket)

Socket myClientSocket = (Socket)clientSocket; //2.转换传入的客户端Socket

while (true)

try

//接收数据

int receiveNumber = myClientSocket.Receive(result); //3.将客户端得到的byte值写入

//Debug.Log(receiveNumber);//子节数量

if (receiveNumber > 0)

str = Encoding.UTF8.GetString(result, 0, receiveNumber);//将接受的数据存到str变量中

// Debug.Log(str);

else

Debug.Log("client: " + ((IPEndPoint)myClientSocket.RemoteEndPoint).Address.ToString() + "断开连接");

threadDic[((IPEndPoint)myClientSocket.RemoteEndPoint).Address.ToString()].Abort(); //清除线程

catch (Exception ex)

//myClientSocket.Shutdown(SocketShutdown.Both); //出现错误 关闭Socket

Debug.Log(" 错误信息" + ex); //打印错误信息

break;

void OnApplicationQuit()

//结束线程必须关闭 否则下次开启会出现错误 (如果出现的话 只能重启unity了)

myThread.Abort();

//关闭开启的线程

foreach (string item in threadDic.Keys)

Debug.Log(item);//de.Key对应于key/value键值对key

//item.Value.GetType()

threadDic[item].Abort();

3.让骨架连接对应的特征点

using System.Collections;

using System.Collections.Generic;

using UnityEngine;

public class linecode : MonoBehaviour

LineRenderer lineRenderer;

public Transform oringin;

public Transform destination;

// Start is called before the first frame update

void Start()

lineRenderer = GetComponent<LineRenderer>();

lineRenderer.startWidth = 0.1f;

lineRenderer.endWidth = 0.1f;

// Update is called once per frame

void Update()

lineRenderer.SetPosition(0, oringin.position);

lineRenderer.SetPosition(1, destination.position);

具体场景中的脚本挂载情况可以下载工程查看

效果

资源下载:

链接:https://pan.baidu.com/s/1XBBWV1wCxyW0FyRTOtorkw?pwd=sbyq

提取码:sbyq

参考:https://www.youtube.com/watch?v=BtMs0ysTdkM

OpenCV+Mediapipe手势动作捕捉与Unity引擎的结合

OpenCV+Mediapipe手势动作捕捉与Unity引擎的结合

前言

本篇文章将介绍如何使用Python利用OpenCV图像捕捉,配合强大的Mediapipe库来实现手势动作检测与识别;将识别结果实时同步至Unity中,实现手势模型在Unity中运动身体结构识别

Demo演示

Demo展示:https://hackathon2022.juejin.cn/#/works/detail?unique=WJoYomLPg0JOYs8GazDVrw

本篇文章所用的技术会整理后开源,后续可以持续关注:

GitHub:https://github.com/BIGBOSS-dedsec

项目下载地址:https://github.com/BIGBOSS-dedsec/OpenCV-Unity-To-Build-3DHands

CSDN: https://blog.csdn.net/weixin_50679163?type=edu

同时本篇文章实现的技术参加了稀土掘金2022编程挑战赛-游戏赛道-优秀奖

作品展示:https://hackathon2022.juejin.cn/#/works/detail?unique=WJoYomLPg0JOYs8GazDVrw

认识Mediapipe

项目的实现,核心是强大的Mediapipe ,它是google的一个开源项目:

| 功能 | 详细 |

|---|---|

| 人脸检测 FaceMesh | 从图像/视频中重建出人脸的3D Mesh |

| 人像分离 | 从图像/视频中把人分离出来 |

| 手势跟踪 | 21个关键点的3D坐标 |

| 人体3D识别 | 33个关键点的3D坐标 |

| 物体颜色识别 | 可以把头发检测出来,并图上颜色 |

Mediapipe Dev

以上是Mediapipe的几个常用功能 ,这几个功能我们会在后续一一讲解实现

Python安装Mediapipe

pip install mediapipe==0.8.9.1

也可以用 setup.py 安装

https://github.com/google/mediapipe

项目环境

Python 3.7

Mediapipe 0.8.9.1

Numpy 1.21.6

OpenCV-Python 4.5.5.64

OpenCV-contrib-Python 4.5.5.64

实测也支持Python3.8-3.9

手势动作捕捉部分

手势特征点图

实时动作捕捉

本项目在Unity中实现实时动作捕捉的核心是通过本地UDP与socket 进行通信

关于数据文件部分,详细可以查看OpenCV+Mediapipe人物动作捕捉与Unity引擎的结合中对数据文件部分的讲解和使用

核心代码

摄像头捕捉部分:

import cv2

cap = cv2.VideoCapture(0) #OpenCV摄像头调用:0=内置摄像头(笔记本) 1=USB摄像头-1 2=USB摄像头-2

while True:

success, img = cap.read()

imgRGB = cv2.cvtColor(img, cv2.COLOR_BGR2RGB) #cv2图像初始化

cv2.imshow("HandsImage", img) #CV2窗体

cv2.waitKey(1) #关闭窗体

视频帧率计算

import time

#帧率时间计算

pTime = 0

cTime = 0

while True

cTime = time.time()

fps = 1 / (cTime - pTime)

pTime = cTime

cv2.putText(img, str(int(fps)), (10, 70), cv2.FONT_HERSHEY_PLAIN, 3,

(255, 0, 255), 3) #FPS的字号,颜色等设置

Socket通信:

定义Localhost和post端口地址

sock = socket.socket(socket.AF_INET, socket.SOCK_DGRAM)

serverAddressPort = ("127.0.0.1", 5052) # 定义IP和端口

# 发送数据

sock.sendto(str.encode(str(data)), serverAddressPort)

手势动作捕捉:

if hands:

# Hand 1

hand = hands[0]

lmList = hand["lmList"]

for lm in lmList:

data.extend([lm[0], h - lm[1], lm[2]])

完整代码

Hands.py

from cvzone.HandTrackingModule import HandDetector

import cv2

import socket

cap = cv2.VideoCapture(0)

cap.set(3, 1280)

cap.set(4, 720)

success, img = cap.read()

h, w, _ = img.shape

detector = HandDetector(detectionCon=0.8, maxHands=2)

sock = socket.socket(socket.AF_INET, socket.SOCK_DGRAM)

serverAddressPort = ("127.0.0.1", 5052)

while True:

success, img = cap.read()

hands, img = detector.findHands(img)

data = []

if hands:

# Hand 1

hand = hands[0]

lmList = hand["lmList"]

for lm in lmList:

data.extend([lm[0], h - lm[1], lm[2]])

sock.sendto(str.encode(str(data)), serverAddressPort)

cv2.imshow("Image", img)

cv2.waitKey(1)

py代码效果

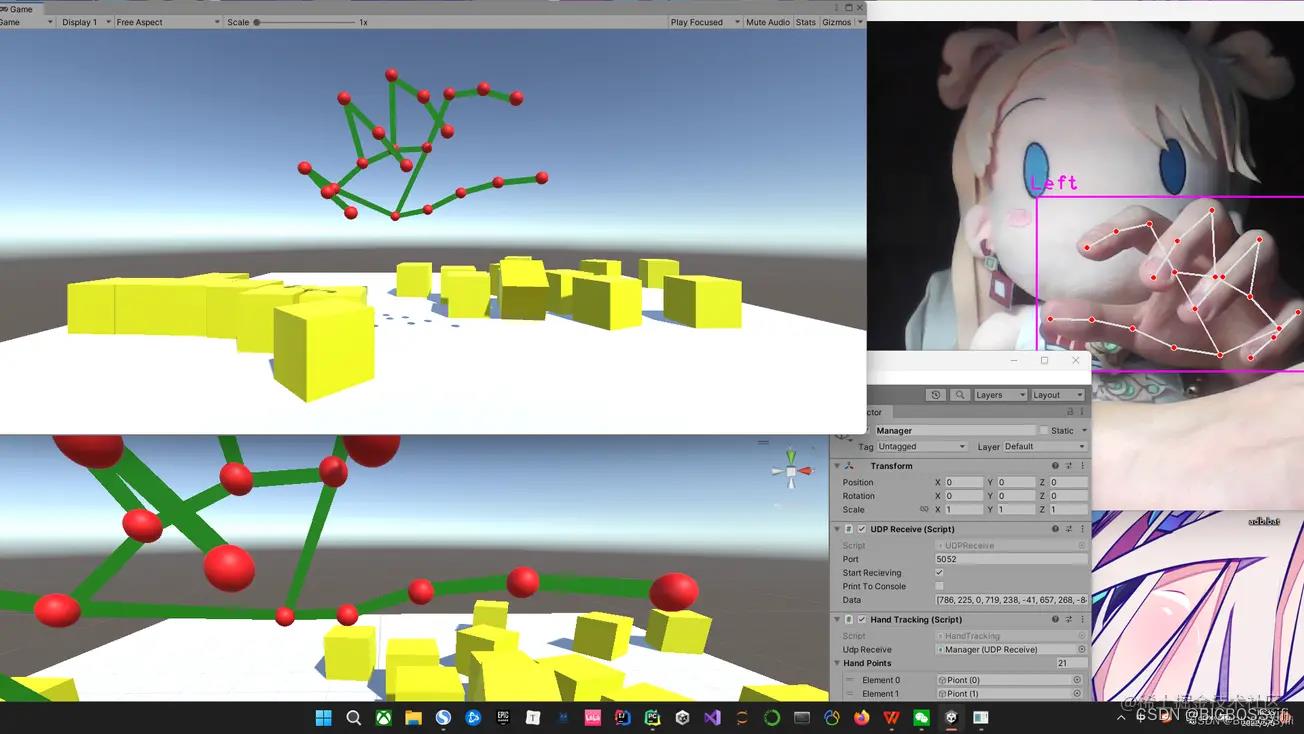

Unity 部分

建模

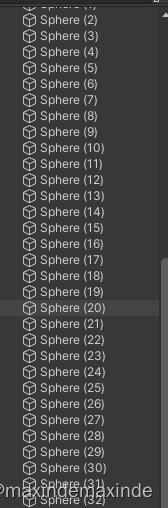

在Unity中,我们需要搭建一个人物的模型,这里需要一个21个Sphere作为手势的特征点和21个Cube作为中间的支架

具体文件目录如下:

Line的编号对应手势模型特征点

Unity代码

UDP.cs

本代码功能将Socket发送的数据进行接收

using UnityEngine;

using System;

using System.Text;

using System.Net;

using System.Net.Sockets;

using System.Threading;

public class UDPReceive : MonoBehaviour

Thread receiveThread;

UdpClient client;

public int port = 5052;

public bool startRecieving = true;

public bool printToConsole = false;

public string data;

public void Start()

receiveThread = new Thread(

new ThreadStart(ReceiveData));

receiveThread.IsBackground = true;

receiveThread.Start();

private void ReceiveData()

client = new UdpClient(port);

while (startRecieving)

try

IPEndPoint anyIP = new IPEndPoint(IPAddress.Any, 0);

byte[] dataByte = client.Receive(ref anyIP);

data = Encoding.UTF8.GetString(dataByte);

if (printToConsole) print(data);

catch (Exception err)

print(err.ToString());

UDP.cs接收效果图

无数据接收下:

数据通信接收下

Line.cs

这里是每个Line对应cs文件,实现功能:使特征点和Line连接在一起

using System.Collections;

using System.Collections.Generic;

using UnityEngine;

public class LineCode : MonoBehaviour

LineRenderer lineRenderer;

public Transform origin;

public Transform destination;

void Start()

lineRenderer = GetComponent<LineRenderer>();

lineRenderer.startWidth = 0.1f;

lineRenderer.endWidth = 0.1f;

// 连接两个点

void Update()

lineRenderer.SetPosition(0, origin.position);

lineRenderer.SetPosition(1, destination.position);

Hands.cs

这里是读取上文识别并保存的手势动作数据,并将每个子数据循环遍历到每个Sphere点,使特征点随着摄像头的捕捉进行运动

using System.Collections;

using System.Collections.Generic;

using UnityEngine;

public class HandTracking : MonoBehaviour

public UDPReceive udpReceive;

public GameObject[] handPoints;

void Start()

void Update()

string data = udpReceive.data;

data = data.Remove(0, 1);

data = data.Remove(data.Length - 1, 1);

print(data);

string[] points = data.Split(',');

print(points[0]);

for (int i = 0; i < 21; i++)

float x = 7-float.Parse(points[i * 3]) / 100;

float y = float.Parse(points[i * 3 + 1]) / 100;

float z = float.Parse(points[i * 3 + 2]) / 100;

handPoints[i].transform.localPosition = new Vector3(x, y, z);

最终实现效果

Good Luck,Have Fun and Happy Coding!!!

以上是关于基于mediapipe的动作捕捉和Unity的球棍模型同步的主要内容,如果未能解决你的问题,请参考以下文章