机器学习15 逻辑回归与交叉熵

Posted 狂奔的CD

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了机器学习15 逻辑回归与交叉熵相关的知识,希望对你有一定的参考价值。

正文

参考:https://zhuanlan.zhihu.com/p/126272731

逻辑回归是分类问题,解决是与不是的问题。推理结果为0和1.

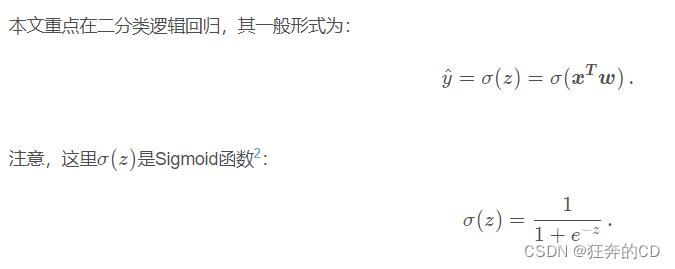

LR的公式

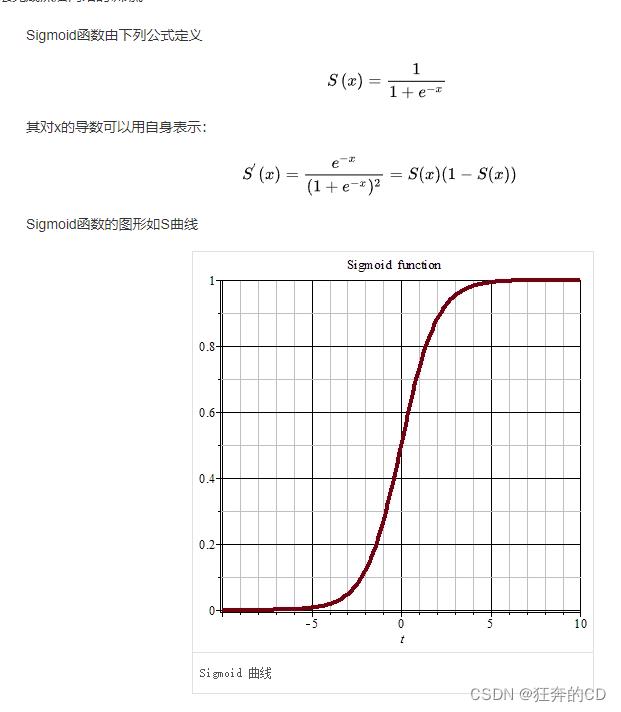

sigmoid函数具备让线性函数转化为0<y<1范围的非线性函数的能力

使用该函数可以得到一个0-1间的概率

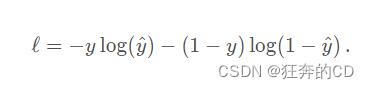

LR的损失函数(简化交叉熵)

该损失函数直接定义出来

一波解释:

y的值为0或者1, 代表是否属于该分类

y^的值为0-1, 代表的是其概率

当为正样本时,l=-log(y^), 此时概率越大,l越小。概率为1时,损失l为0

当为负样本时,l=-log(1-y^), 此时概率越大,l越大

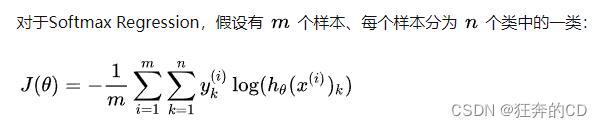

交叉熵推导

一波解释:

模型的目标是使得输入x,输出刚好为对应的y

P(y|x)代表样本为x是输出为y的概率,直接定义出来

P(Y|X)代表所有样本都推理正确的概率,所以是所有概率的乘积,这个值越大越好,最大为1

转换为最小问题即可得到loss,取对数,加负号,当P为1时,loss=0

一波解释:

每个样本只属于某一类

以上是关于机器学习15 逻辑回归与交叉熵的主要内容,如果未能解决你的问题,请参考以下文章