全球首颗!RISC-V处理器大飞跃,模拟AI芯片问世

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了全球首颗!RISC-V处理器大飞跃,模拟AI芯片问世相关的知识,希望对你有一定的参考价值。

参考技术A近日,据外媒披露,全球首款集成了RISC-V指令集的模拟AI芯片——Mythic AMP在美国奥斯汀问世。

这是一款单芯片模拟计算设备,并采用Mythic的模拟计算引擎,而不是利用传统的数字来创建处理器,以便于将内存集成到处理器中,耗电量比传统模拟处理器低 10 倍。

熟悉传统计算原理的都知道,在常规计算机中,数据会定期从 DRAM 内存传输到 CPU。

内存保存程序和数据。计算机中的处理器和内存是分开的,数据在两者之间移动。处理器无论速度有多快,在从内存中获取数据时都必须处于空闲状态,并且取决于传输速率——这就是所谓的冯诺依曼限制。因此,将计算和内存合并到单个设备中就成为了大家 探索 的解决方法,而模拟 AI 就消除了冯诺依曼瓶颈,从而显着提高了性能。

目前关于AI 芯片并没有一个严格的定义。比较宽泛的定义是面向人工智能应用的芯片都可以称为AI 芯片。

AI 芯片主要包括三类:

在AI应用还没有得到市场验证之前,通常使用已有的通用芯片进行并行加速计算,可以避免专门研发ASIC芯片的高投入和高风险。但是这类通用芯片设计初衷并非专门针对深度学习,因而存在性能、功耗等方面的局限性。随着人工智能应用规模持续扩大,这类问题日益突显,待深度学习算法稳定后,AI 芯片可采用 ASIC 设计方法进行全定制,使性能、功耗和面积等指标面向深度学习算法做到最优。

提高AI 芯片性能和能效的关键之一在于支持高效的数据访问。在传统冯·诺伊曼体系结构中,数据从处理单元外的存储器提取,处理完之后再写回存储器。在AI 芯片实现中,基于冯·诺伊曼体系结构,提供运算能力相对是比较简单易行的,但由于运算部件和存储部件存在速度差异,当运算能力达到一定程度,由于访问存储器的速度无法跟上运算部件消耗数据的速度,再增加运算部件也无法得到充分利用,即形成所谓的冯·诺伊曼“瓶颈”,或“内存墙”问题,是长期困扰计算机体系结构的难题。目前常见的方法是利用高速缓存(Cache)等层次化存储技术尽量缓解运算和存储的速度差异。

AI简报20220114期AI for Science催生科研新范式华为诺亚Transformer后量化技术...

AI芯片

1. 海信发布中国首颗自研 8K AI芯片:支持3300+万像素重构

1月11日,海信在北京发布了中国首颗全自研的8K AI画质芯片,也是海信第五代画质芯片,也代表了国内单颗画质芯片的最高处理能力。

据介绍,目前海信8K AI画质芯片已经用于整机,今年将全面覆盖海信、东芝两大品牌在内的多系列显示产品。今年海信还将推出8K广播级专业监视器和Micro LED电视。

8K通常指分辨率达到7680×4320像素,是传统1920全高清视频的16倍,4K视频的4倍。

据介绍,该芯片首次实现了从4K到8K的跨越式发展,更突破AI感知画质算法等核心技术,通过配备具有“深度神经网络”技术的人工智能,实现高精度的图像处理,支持3300+万像素的精确重构,能够展现画面中丰富的隐藏细节;26880个分区控制,通过对比度提升,画面的细节和色彩更接近真实。

AI热点

2. 达摩院发布2022十大科技趋势:AI for Science催生科研新范式,大模型参数竞赛进入冷静期

原文:

https://mp.weixin.qq.com/s/kSB_WSmpU4BszPDHrLBw7g

12月28日,阿里达摩院重磅发布《达摩院 2022 十大科技趋势》,从范式重置、场景变革和未来互联三大维度提出最新十大科技趋势。据悉,这也是达摩院连续第四年发布前沿科技趋势预测。

据介绍,《达摩院 2022 十大科技趋势》采用了“定量发散,定性收敛”的分析方法,整个分析流程分为两部分:

“定量发散”是对科学领域做广泛而全面的定量分析,抽取其中的热点领域并挖掘重点突破的技术;

“定性收敛”是对突破的技术点进行梳理,通过与领域专家充分的论证,找出多个技术点代表的趋势,总结对未来的预判。

达摩院分析了 159 个领域近三年 770 万篇公开论文、8.5 万份专利,挖掘其中热点领域及重点技术突破,深度访谈近 100 位科学家,提出了 2022 年可能照进现实的十大科技趋势,覆盖人工智能、芯片、计算和通信等领域。

具体而言,这十大科技趋势分别是:AI for Science、大小模型协同进化、硅光芯片、绿色能源 AI、柔性感知机器人、高精度医疗导航、全域隐私计算、星地计算、云网端融合、XR 互联网。

近年,人工智能被证明能做科学规律发现,不仅在应用科学领域,也能在基础科学领域发挥作用,如 DeepMind 使用人工智能来帮助证明或提出新的数学定理,辅助数学家形成对复杂数学的直觉。

达摩院预测,在未来的三年内,人工智能技术在应用科学中将得到普遍应用,在部分基础科学中开始成为研究工具。

阿里达摩院城市大脑实验室负责人华先胜在接受 InfoQ 采访时表示,用 AI 去助力科研主要基于数据和计算这两点,在数据和算力的基础上形成 AI 能力。

3. Jeff Dean长文展望:2021年之后,机器学习领域的五大潜力趋势

原文:

https://mp.weixin.qq.com/s/c1ejcqPZyr98jY2QyeadOA

在过去的数年,见证了机器学习(ML)和计算机科学领域的许多变化。按照这种长弧形的进步模式,人们或许将在接下来的几年中看到许多令人兴奋的进展,这些进步最终将造福数十亿人的生活,并产生比以往更深远的影响。

2021 年之后,机器学习将会对哪些领域产生前所未有的影响?

在一篇总结文章中,谷歌 AI 负责人、知名学者 Jeff Dean 重点介绍了 2021 年之后机器学习最具潜力的五个领域:

趋势 1:能力、通用性更强的机器学习模型

趋势 2:机器学习持续的效率提升

趋势 3:机器学习变得更个性化,对社区也更有益

趋势 4:机器学习对科学、健康和可持续发展的影响越来越大

趋势 5:对机器学习更深入和更广泛的理解

Jeff Dean 提到:随着机器学习模型变得更有能力并在许多领域产生影响,保护机器学习中使用的私人信息仍然是研究的重点。沿着这些思路,我们最近的一些工作解决了大型模型中的隐私问题,既能从大型模型中提取训练数据,又指出如何在大型模型中包含隐私。除了联邦学习和分析方面的工作之外,谷歌还一直在使用其他有原则和实用的机器学习技术来强化工具箱。

4. 安波福宣布收购智能边缘软件解决方案领先提供商风河公司

原文:

https://mp.weixin.qq.com/s/_sldJIakf0G0vqCGjvWOJA

风河公司是为智能边缘提供软件的全球领导者。其软件已在全球1700多家客户的20多亿台边缘设备上使用,可实现关键智能系统的安全开发、部署、运营和服务。这种边缘到云的软件组合以Wind River Studio为基础,应用涵盖航空航天、国防、电信、工业及汽车市场。Wind River Studio是一个通用、全面的云原生智能系统软件平台,可为边缘到云应用项目提供完整的产品生命周期管理。风河在2021年创造了4亿美元的收入。

TPG Capital的联合管理合伙人Nehal Raj和负责人Art Heidrich表示:“很荣幸能与Kevin Dallas及风河管理团队合作,使风河成长为智能系统市场的领导者。他们所服务的关键行业正在快速进行数字化转型,越来越多的公司期望应用创新的软件解决方案,使自己能够借助数据做出更好、更快的决策,由此,我们看到了巨大的机遇。我们对风河与安波福联手将取得的成就充满期待。”

AI前沿

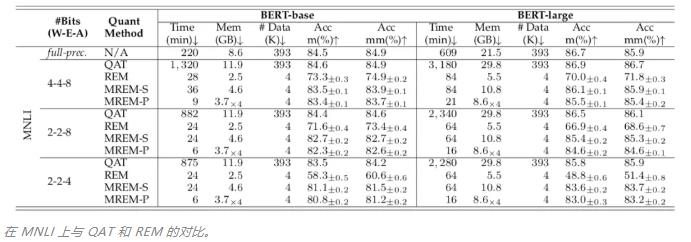

5. 华为诺亚Transformer后量化技术:效率百倍提升,视觉&NLP性能不减

原文:

https://mp.weixin.qq.com/s/Ngauf9ZJilM0uM9mwYGjrg

大型预训练模型在计算机视觉和自然语言处理中展现了巨大的潜力,但是模型大、参数多的问题也给它们的商业化落地带来了很大挑战。模型压缩技术是当前的研究热点,模型量化是其中的一个重要分支。

当下预训练模型的量化为了保证性能,大多采用量化感知训练(Quantization-aware Training, QAT)。而模型后量化(Post-training Quantization, PTQ)作为另一类常用量化方法,在预训练大模型领域却鲜有探索。诺亚方舟实验室的研究者从以下四个方面对 QAT 与 PTQ 进行了详细对比:

训练时间:QAT 由于模拟量化算子等操作,训练耗时远远超出全精度训练(FP),而 PTQ 仅仅需要几十分钟,大大缩短量化流程;

显存开销:QAT 显存消耗大于全精度训练(FP),使得在显存有限的设备上难以进行量化训练。而 PTQ 通过逐层回归训练,无需载入整个模型到显存中,从而减小显存开销;

数据依赖:QAT 需要获取整个训练数据集,而 PTQ 只需要随机采样少量校准数据,通常 1K~4K 张 / 条图像或者标注即可;

性能:鉴于 QAT 在整个训练集上充分训练,其性能在不同的量化 bit 上均领先 PTQ。因此性能是 PTQ 的主要瓶颈。

基于以上观测,研究者提出了针对视觉和 NLP 任务的 PTQ 方法,在保持其训练时间、显存开销、数据依赖上优势的同时,大大改善其性能,使其逼近量化感知训练的精度。具体而言,仅使用 1% 的训练数据和 1/150 的训练时间,即可达到 SOTA 量化方法的精度。

6. Nature子刊:未经训练的神经网络也可以进行人脸检测

原文:

https://mp.weixin.qq.com/s/ryNaQPvC0HvOSeplWJU-1w

论文:

https://www.nature.com/articles/s41467-021-27606-9.pdf

对于动物的社会行为(群体中不同成员分工合作,共同维持群体生活的行为)来说,检测和识别面孔的能力至关重要。这种能力被认为起源于单神经元或多神经元水平的神经元调谐(神经元有选择地表示一种感觉、协同、运动、认知等信息的特性)。

科学家已经在不同物种的幼小动物身上观察到对面孔有选择性反应的神经元,这引起了激烈的争论:面孔选择性神经元是大脑天生的,还是需要依赖视觉体验?

最近发表在《自然 · 通讯》上的一项新研究表明,高级的视觉认知功能可以在未经训练的神经网络中自发产生,面部图像的视觉选择性甚至可以在完全未经训练的深度神经网络中产生。它为生物和人工神经网络认知功能发展的潜在机制提供了具有启发性的见解,也对我们理解早期大脑功能(感官体验之前)的起源产生了重大影响。

7. AI正在模仿人类大脑!2021年10篇顶会论文:大脑也在「无监督」学习

原文:

https://mp.weixin.qq.com/s/0DoAb1zX-v7hU7RmO-ELTw

神经科学会成为人工智能「超进化」的关键吗?只要模拟大脑,神经网络就可以获得相似或相同的智能。近日,神经科学家Patrick Mineault就2021年无监督学习的大脑模型做了总结回顾。

神经人工智能(neuro-AI)研究中最有说服力的发现之一是,训练人工神经网络执行匹配大脑中单个神经元和集合信号的相关任务。一个典型的例子就是腹侧流(ventral stream),DNNs在ImageNet上训练进行对象识别。监督和任务优化网络连接两个重要的解释形式: 生态相关性和神经活动可解释性。

AI 开源项目

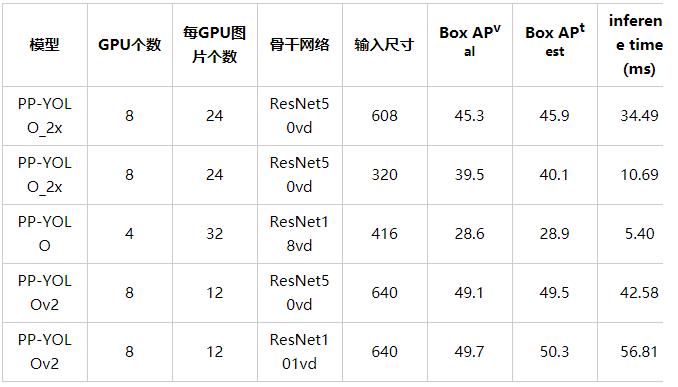

8. 工业级SOTA模型PP-YOLOv2的Pytorch实现

原文:

https://mp.weixin.qq.com/s/j-oWTUbmjGBDGnl9aTLOOA

Github:

https://github.com/miemie2013/miemiedetection

miemiedetection 是 Github 开源作者 miemie2013 (https://github.com/miemie2013)基于 YOLOX (https://github.com/Megvii-BaseDetection/YOLOX)进行二次开发的个人检测库(使用的深度学习框架为pytorch),支持 Windows、Linux 系统,以咩酱的名字命名。miemiedetection 是一个不需要安装的检测库用户可以直接更改其代码改变执行逻辑,所见即所得!所以往miemiedetection里加入新的算法是一件很容易的事情(可以参考 PPYOLO 的写法往 miemiedetection 里加入新的算法)。得益于 YOLOX 的优秀架构,miemiedetection 里的算法训练速度都非常快,数据读取不再是训练速度的瓶颈!目前 miemiedetection 支持 YOLOX、PPYOLO、PPYOLOv2 等算法,预计未来会加入更多算法。

本仓库包含以下模型:

文末福利

9. 爆火的深度学习面试书现可白嫖!GitHub上线2周1.5K Star,之前售价146元

原文:

https://mp.weixin.qq.com/s/_pkkNs6hgQ_Mxd-shk8u1Q

Github:

https://github.com/BoltzmannEntropy/interviews.ai

👇👇👇 点击阅读原文进入官网

以上是关于全球首颗!RISC-V处理器大飞跃,模拟AI芯片问世的主要内容,如果未能解决你的问题,请参考以下文章

AI简报20211029期YOLOv5-Lite 树莓派实时 超过1000个RISC-V核心的AI芯片

5月14日 日报:苹果强势入局云计算/瑞幸咖啡仍在快速开店/全球首个远程超声机器人获批/索尼开发出首颗AI图像传感器

AI简报20220114期AI for Science催生科研新范式华为诺亚Transformer后量化技术...