树莓派4B 摄像头采集

Posted rabbit0206

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了树莓派4B 摄像头采集相关的知识,希望对你有一定的参考价值。

最近在使用声网Agora的RTSA,想着把自己的树莓派使用起来,做个远程图传之类的功能。

RTSA不支持音视频的采集编码,仅提供通道能力,所以树莓派上的音视频采集和编码工作需要自己完成。

调研了市面上的两种摄像头的采集和编码,一种是从csdn上看到有介绍进行调研的,也就是camkit开源工程(由于项目过于久远中间太多坑);另一种是目前树莓派官方推荐的,功能更强大,通过libcamera;两种方式在软件处理上也有一些区别:

第一种:Legacy stack

Legacy stack是raspberry OS Bullseye之前的版本支持的摄像头的方式,网上很多基于python的库都是基于Legacy stack,可以通过raspi-config配置打开

raspi-config

Select [ 3 Interface Options] --> [I1 Legacy Camera] --> [Yes]

Legacy stack支持的三方库,有比较全的camkit。

下载camkit

camkit的功能介绍这里就不做过多介绍了,csdn上有一堆科普的文章,本文尽量干货,介绍整个使用过程。

下载地址:

https://gitee.com/daiyinger/Camkit.git

该项目包含了视频的采集和编码,但是由于项目比较老,依赖的ffmpeg的库≤ffmpeg-4.4.1,ffmpeg-5.x 部分接口找不到。

ffmpeg-4.4.1编译

参考文章FFMPEG编译编译。

wget http://www.ffmpeg.org/releases/ffmpeg-4.4.1.tar.bz2

tar zxvf ffmpeg-4.4.1.tar.bz2

./configure --prefix=/your/install/path \\

--enable-gpl\\

--enable-nonfree\\

--enable-libfdk-aac\\

--enable-libx264\\

--enable-libx265\\

--enable-filter=delogo\\

--enable-debug\\

--disable-optimizations\\

--enable-libspeex\\

--enable-shared\\

--enable-pthreads

make -j4

make install

export LD_LIBRARY_PATH=/your/install/path/lib:$LD_LIBRARY_PATH

export PKG_CONFIG_PATH=/your/install/path/lib/pkgconfig:$PKG_CONFIG_PATH

编译camkit

在安装了上述的ffmpeg-4.4.1之后,编译camkit通过

cmake -S . -B build

cmake --build build -j4

编译成功:

vcpkg

上述ffmpeg-4.4.1编译需要依赖很多第三方库,比如libx264,所以本文顺便介绍下通过vcpkg安装ffmpeg-4.4.1,vcpkg官方默认支持的x86-linux下的最新版本就是ffmpeg-4.4.1,直接安装就行。

vcpkg search ffmpeg

vcpkg install ffmpeg[x264]

vcpkg安装ffmpeg-4.4.1

github:https://github.com/microsoft/vcpkg/blob/master/README_zh_CN.md

官网地址:https://vcpkg.io/en/getting-started.html

在线文档:https://vcpkg.readthedocs.io/en/latest/README/

package搜索:https://vcpkg.io/en/packages.html

git clone https://github.com/microsoft/vcpkg

./bootstrap-vcpkg.sh -disableMetrics

./vcpkg install ffmpeg[x264]

如何通过vcpkg安装老版本ffmpeg-3.3.1

有些场景下需要更好版本的软件,vcpkg支持版本

git log --color=always --pretty='%Cred%h%Creset -%C(auto)%d%Creset %s %Cgreen(%ad)' --date=short | grep --color=never ffmpeg

git checkout 779307a10

vcpkg install ffmpeg

非常不幸,ffmpeg-3.3.3版本vcpkg并不支持

root@locakhost# vcpkg install ffmpeg

Error: invalid triplet: x64-linux

Available architecture triplets

VCPKG built-in triplets:

x64-windows-static

x86-windows-static

x86-uwp

x64-uwp

x64-windows

arm-uwp

x86-windows

VCPKG community triplets:

看来还得自己编译,留个记录,记录vcpkg的工具的使用。

cmake编译

如果可以的话:

cmake -B [build directory] -S . -DCMAKE_TOOLCHAIN_FILE=[path to vcpkg]/scripts/buildsystems/vcpkg.cmake

将 vcpkg 作为一个子模块

当您希望将 vcpkg 作为一个子模块加入到您的工程中时, 您可以在第一个 project() 调用之前将以下内容添加到 CMakeLists.txt 中, 而无需将 CMAKE_TOOLCHAIN_FILE 传递给 CMake 调用。

set(CMAKE_TOOLCHAIN_FILE "$CMAKE_CURRENT_SOURCE_DIR/vcpkg/scripts/buildsystems/vcpkg.cmake"

CACHE STRING "Vcpkg toolchain file")

使用此种方式可无需设置 CMAKE_TOOLCHAIN_FILE 即可使用 vcpkg,且更容易完成配置工作。

camkit学习

学习从cktool.c开始。

capture

camkit通过cmake的PLAT参数设置目标平台,本文使用参数PLAT=PC,同时基于linux进行测试,linux采集使用v4l2框架,v4l2de 初始化流程可以参考:linux调用v4l2获取视频,嵌入式Linux:V4L2视频采集操作流程和接口说明。

第二种:libcamera

树莓派默认支持3个版本的摄像头,即1)OV5647 or V1 camera;2)IMX219 or V2 camera;3)IMX477 or HQ camera。当然除了这三种sensor,还支持 IMX290, IMX327, OV9281, IMX378。

libcamera 提供了一些列的C++ API用于应用程序可以配置摄像头,以及获取摄像头的帧数据。获取的图像数据可以直接用于图像编码或者视频编码。但是不包括编码和渲染相关的工作。

所有树莓派官方提供了一组基于libcamera的应用层的工具包libcamera-apps,并且模拟了legacy stack的基于Broadcom的GPU的一组接口(raspstill和raspivid):

libcamera-hello: 一个简单的 “hello world” 应用,提供一个camera的流获取以及在屏幕上进行渲染。

libcamera-jpeg:一个小的应用程序用来抓取高清图像。

libcamera-still:一个更加复杂的图像抓取应用,并且拥有和raspistill类似的功能。

libcamera-vid: 视频抓取程序。

libcamera-raw: 用来直接抓取raw 帧(Bayer格式)的应用。

libcamera-detect:该应用默认没有,但是当在树莓派上安装了TensorFlow Lite后就可以用这个库来触发当检测到某个物体时抓取JPEG格式的图像。

libcamera-apps除了具有命令行,用户也可以作为参考示例来创建用户自己的应用程序,可以参考github库,https://github.com/raspberrypi/libcamera-apps。

libcamera

git clone https://git.libcamera.org/libcamera/libcamera.git

cd libcamera

pip3 install --user meson==0.63.3 # libcamera need version>0.56

meson build --prefix /your/path/to/install

ninja -C build install

更详细的编译参考building-libcamera

libcamera-hello

libcamera-hello -qt-preview -t 0 # 正常不需要加入-qt-preview,由于我使用的vnc,加入-qt-preview参数显示摄像头stream窗口

libcamera-jpeg

libcamera-jpeg -o test.jpg

libcamera-still

libcamera-still -o test.jpg

#Encoders

libcamera-still -e png -o test.png

libcamera-still -e bmp -o test.bmp

libcamera-still -e rgb -o test.data

libcamera-still -e yuv420 -o test.data

#Raw Image Capture

libcamera-still -r -o test.jpg

#Very long exposures

libcamera-still -o long_exposure.jpg --shutter 100000000 --gain 1 --awbgains 1,1 --immediate

libcamera-vid

# basic

libcamera-vid -t 10000 -o test.h264

vlc test.h264

# Encoders

libcamera-vid -t 10000 --codec mjpeg -o test.mjpeg

libcamera-vid -t 10000 --codec yuv420 -o test.yuv

# Network Streaming

# UDP

libcamera-vid -t 0 --inline -o udp://<ip-addr>:<port>

# paly

vlc udp://@:<port> :demux=h264

ffplay udp://<ip-addr-of-server>:<port> -fflags nobuffer -flags low_delay -framedrop

# TCP

libcamera-vid -t 0 --inline --listen -o tcp://0.0.0.0:<port>

# play

vlc tcp/h264://<ip-addr-of-server>:<port>

ffplay tcp://<ip-addr-of-server>:<port> -vf "setpts=N/30" -fflags nobuffer -flags low_delay -framedrop

# RTSP

libcamera-vid -t 0 --inline -o - | cvlc stream:///dev/stdin --sout

'#rtpsdp=rtsp://:8554/stream1' :demux=h264

# play

vlc rtsp://<ip-addr-of-server>:8554/stream1

ffplay rtsp://<ip-addr-of-server>:8554/stream1 -vf "setpts=N/30" -fflags nobuffer -flags low_delay -framedrop

# libcamera-vid 可以配合ffmpeg libav,但是测试没有通过

# 参考 https://www.raspberrypi.com/documentation/accessories/camera.html#libav-integration-with-libcamera-vid

libcamera-raw

用得不多,获取bayer帧。

libcamera-detect

依赖TensorFlowLite,感兴趣可以参考libcamera-detect,本文不做讲解。

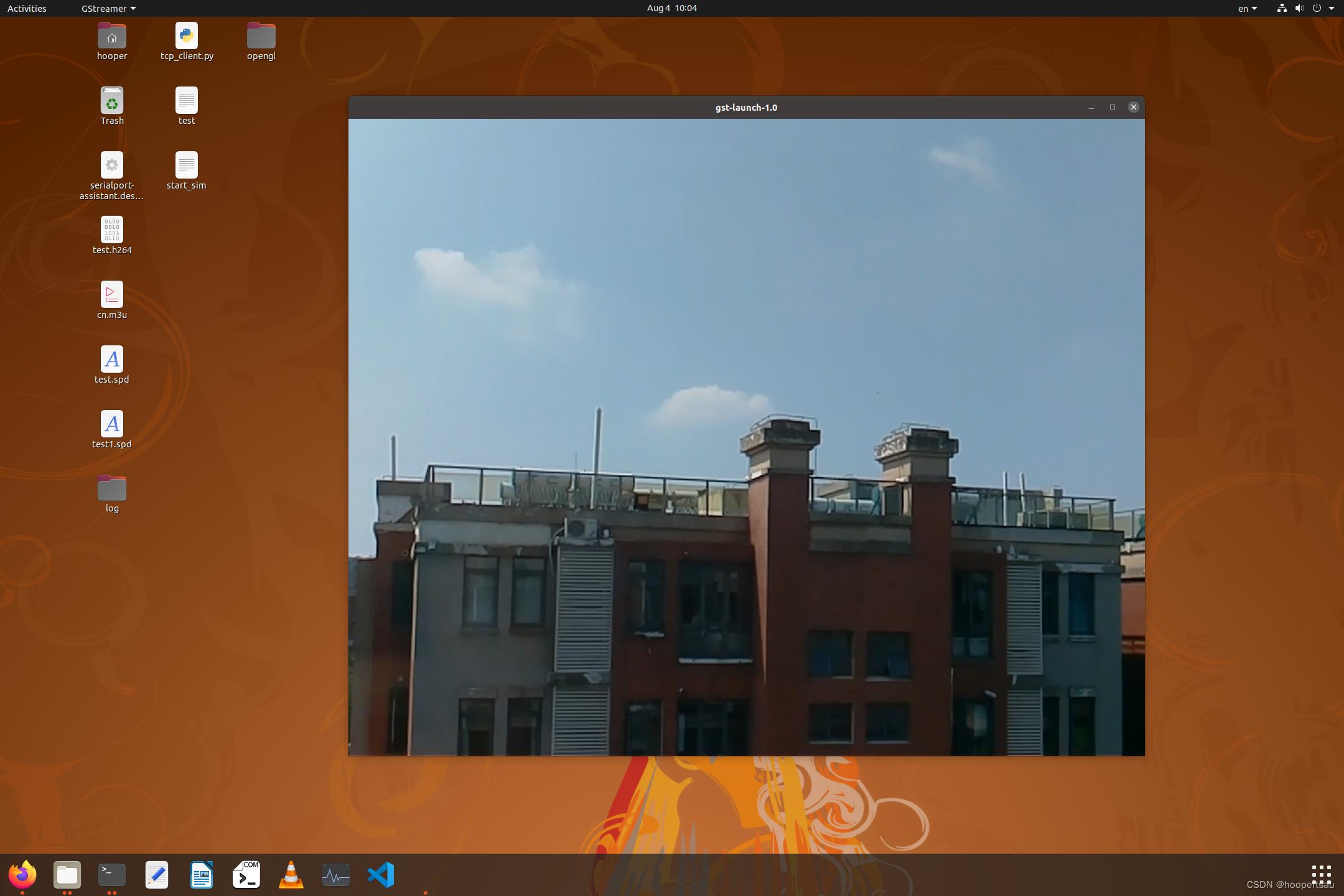

OpenHD改造实现廉价高清数字图传(树莓派+PC)—gstreamer视频采集传输和显示

图传的一个重要功能就是可以看视频。主要是采集树莓派zero摄像头的数据,经过编码打包,通过wifibroadcast发送到地面端的PC上,然后再通过解码显示出来。

这里用到了视频采集和编解码相关的软件。

在树莓派上,有自带的软件可以直接采集视频,很方便;地面端的解码可以使用gstreamer来做,因为涉及到显示窗口的问题,可能还需要跟X Window相关的库。

- 使用wifibroadcast作为数据传输的通道;

- 发送端:树莓派的摄像头使用raspivid命令行即可实现视频数据的采集和编码;

- 接收端:使用gstreamer进行解码和显示。

一、摄像头视频采集

树莓派摄像头还是比较便宜的,使用自带的raspivid程序就可以采集视频,直接编码成H.264流。

发送端的命令行:

raspivid -n -ex fixedfps -w 1920 -h 1080 -b 4000000 -fps 30 -vf -hf -t 0 -o – | sudo ./tx_my.sh wlan1-o 表示输出,最后的 - 表示输出到标准输出流,可以在后面接上wbf的发送命令,直接将流发出去;

-n 表示不进行视频的预览

-w -h 表示视频的宽度和高度

-b 表示视频码率,单位时bps

-fps 表示设置fsp帧速率

-vf -hf 表示纵向和横向视频反向

-t 表示采集时间,单位ms,0表示一直采集

后面的tx_my.sh脚本看上一篇文章的介绍。

OpenHD改造实现廉价高清数字图传(树莓派zero + ubuntu PC )——(二)Wifibroadcast Wifi广播通信_hoopertsau的博客-CSDN博客_openhd

通过这个就可以将视频流通过WiFibroadcast发出去了。

二、视频接收解码和显示

视频的接收端使用gstreamer相关的库去做。

安装相关的库命令行

sudo apt-get install libgstreamer1.0-dev libgstreamer-plugins-base1.0-dev libgstreamer-plugins-bad1.0-dev gstreamer1.0-plugins-base gstreamer1.0-plugins-good gstreamer1.0-plugins-bad gstreamer1.0-plugins-ugly gstreamer1.0-libav gstreamer1.0-doc gstreamer1.0-tools gstreamer1.0-x gstreamer1.0-alsa gstreamer1.0-gl gstreamer1.0-gtk3 gstreamer1.0-qt5 gstreamer1.0-pulseaudio

内容比较多,要安装一会的。

gstreamer可以先用命令行工具进行解码测试,如果没什么问题可以对照相关命令行的内容,编写成C++代码和单独的应用程序。

接收端的命令行:

sudo ./rx_my.sh wlan0| gst-launch-1.0 -v fdsrc fd=0 ! h264parse ! avdec_h264 ! videoconvert ! xvimagesink 这里首先用rx_my.sh接收数据,通过管道输入给gsteamer工具;

然后使用gst-launch-1.0工具,这里的fdsrc就是从fd文件读取数据,fd=0 中的0 就是标准输入的fd编号,也就是从管道上过来的数据,接收到的视频数据。

这样就能直接在PC上自动开启一个窗口进行显示了。通过这个命令行可以测试一下通信和编解码是否正常。

三、使用gstreamer API开发GUI显示程序

但是这个工具是个单独的软件,如果要根据我们的OSD叠加就不好弄了,因此还是要用gstreamer的API进行开发,后面还要将OSD的显示整合进来。

可以参考官方的这篇文章进行GUI的开发。Basic tutorial 5: GUI toolkit integration

但我准备用的就是直接使用XWindow,略微有些不一样,但总体上的思路是相同的。

使用streamer开发视频显示应用软件,主要就是创建合适的窗口,初始化gstreamer管道并连接相关插件,然后将gstreamer显示绑定到窗口上,就可以显示了。

直接上一个最简单的代码看看。

#include<X11/Xlib.h>

#include <glib.h>

#include <gst/gst.h>

#include <gst/video/videooverlay.h>

#include <stdio.h>

// 定义一个窗口

Window win;

void initGst()

// 创建视频处理的管道,这里和使用命令行类似

GstElement *pipeline = gst_pipeline_new ("xvoverlay");

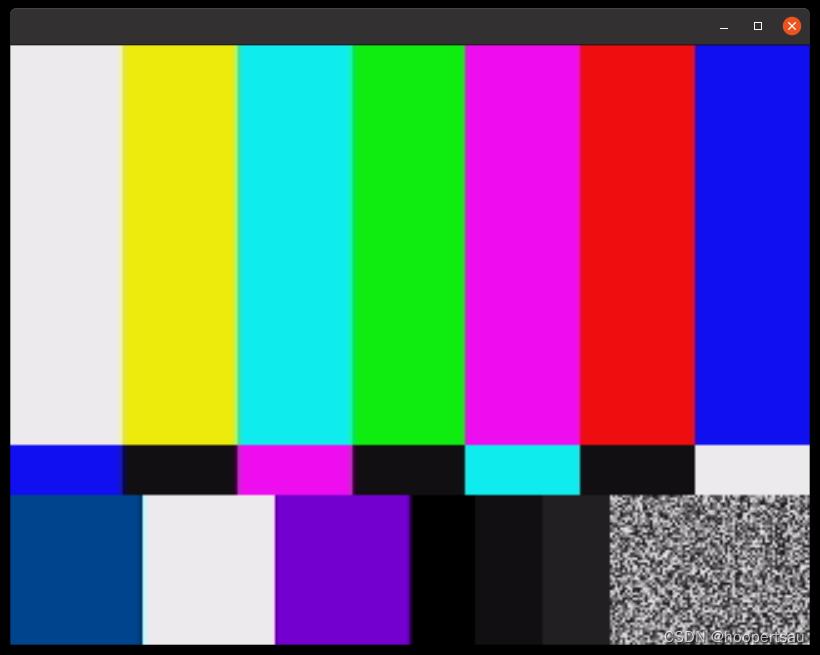

GstElement *src = gst_element_factory_make ("videotestsrc", NULL);

GstElement *sink = gst_element_factory_make ("xvimagesink", NULL);

gst_bin_add_many (GST_BIN (pipeline), src, sink, NULL);

gst_element_link (src, sink);

// 绑定UI界面,这里的win就是我们创建的X Window

gst_video_overlay_set_window_handle (GST_VIDEO_OVERLAY (sink), win);

// 将状态设置为运行

GstStateChangeReturn sret = gst_element_set_state (pipeline, GST_STATE_PLAYING);

int main(int argc, char *argv[])

/* 初始化GStreamer库 */

gst_init (&argc, &argv);

// 打开一个显示

Display *dsp = XOpenDisplay( NULL );

if( !dsp ) return 1;

// 设置屏幕

int screenNumber = DefaultScreen(dsp);

unsigned long white = WhitePixel(dsp,screenNumber);

unsigned long black = BlackPixel(dsp,screenNumber);

// 创建窗体

win = XCreateSimpleWindow(dsp,

DefaultRootWindow(dsp),

50, 50, // origin

800, 600, // size

0, black, // border

white ); // backgd

XMapWindow( dsp, win );

long eventMask = StructureNotifyMask;

XSelectInput( dsp, win, eventMask );

XEvent evt;

do

XNextEvent( dsp, &evt ); // calls XFlush

while( evt.type != MapNotify );

// 创建具体的视频处理管道,并绑定刚才的创建的窗口

initGst();

do

XNextEvent( dsp, &evt ); // calls XFlush()

while( evt.type != ButtonRelease );

XDestroyWindow( dsp, win );

XCloseDisplay( dsp );

return 0;

这个代码就是一个最简单的gstreamer的GUI程序,保存成x11_gst_demo.cpp

编译一下:

g++ x11_gst_demo.cpp -o x11_gst_demo `pkg-config --cflags --libs gstreamer-video-1.0 gstreamer-1.0 x11`这是一个简单的程序,使用videotestsrc显示一个测试画面

接下来就可以在这个基础上,将视频处理的部分进行变化,使用不同的插件组合使用,来接收显示我们摄像头传过来的画面。

主要是实现这句话:

gst-launch-1.0 -v fdsrc fd=0 ! h264parse ! avdec_h264 ! videoconvert ! xvimagesink

主要是该initGst函数,将上面这条语句用C++代码来实现,代码不难,看一下就应该能看懂。如果有些不清楚可以上网查询相关的函数的定义。

void initGst2()

GstElement *gst_pipeline;

GstElement *gst_src;

GstElement *gst_parser;

GstElement *gst_decoder;

GstElement *gst_conv;

GstElement *gst_sink;

// 以下的效果与这条语句等同

// gst-launch-1gst-launch-1.0 -v fdsrc fd=0 ! h264parse ! avdec_h264 ! videoconvert ! xvimagesink

// 创建管道

gst_pipeline = gst_pipeline_new ("xvoverlay");

// 创建fdsrc,用来从标准输入接收视频流

gst_src = gst_element_factory_make ("fdsrc", "source");

// 设置属性fd=0

g_object_set(G_OBJECT(gst_src), "fd", 0, NULL);

// 创建h264解码器

gst_parser = gst_element_factory_make("h264parse", NULL);

gst_decoder = gst_element_factory_make("avdec_h264", NULL);

// 创建视频转换插件

gst_conv = gst_element_factory_make("videoconvert", NULL );

// 创建sink显示插件

gst_sink = gst_element_factory_make ("xvimagesink", "sink");

// 将多个插件连接起来

gst_bin_add_many(GST_BIN(gst_pipeline), gst_src, gst_parser,gst_decoder, gst_conv, gst_sink, NULL);

if(gst_element_link_many(gst_src, gst_parser, gst_decoder, gst_conv, gst_sink, NULL) == 0 )

printf("gst_element_link_many error!\\r\\n");

// 绑定UI界面,这里的win就是我们创建的X

gst_video_overlay_set_window_handle (GST_VIDEO_OVERLAY (gst_sink), win);

// 将状态设置为运行

GstStateChangeReturn sret = gst_element_set_state (gst_pipeline, GST_STATE_PLAYING);

printf("set gst playing. sret=%d\\r\\n",sret);

重新编译运行,就可以实现从标准输入显示视频了

用这个软件直接替换刚才的gstreamer自带的工具即可

四、小结

使用wifibroadcast作为底层通信,使用gstreamer来解码,使用X11窗口来进行显示。

发送端:

raspivid -n -ex fixedfps -w 1920 -h 1080 -b 4000000 -fps 30 -vf -hf -t 0 -o – | sudo ./tx_my.sh wlan1

接收端:

使用gstreamer自带工具:

sudo ./rx_my.sh wlan0| gst-launch-1.0 -v fdsrc fd=0 ! h264parse ! avdec_h264 ! videoconvert ! xvimagesink

使用自己开发的GUI程序

sudo ./rx_my.sh wlan0 | x11_gst_demo

以上是关于树莓派4B 摄像头采集的主要内容,如果未能解决你的问题,请参考以下文章