C++/Qt音视频通话开发MetaRTC源码解读,视频推流和拉流

Posted 架相

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了C++/Qt音视频通话开发MetaRTC源码解读,视频推流和拉流相关的知识,希望对你有一定的参考价值。

本章内容解读MetaRTC开源代码,无任何二次开发,用于学习交流。

MetaRTC是国人开发的开源项目,适用各种场景音视频二次开发,可以去git阅读README,我们使用相对成熟的版本测试: Release v5.0-b4。

目录

视频推流步骤:视频数据采集、编码、发送,分别在三个线程内完成;

视频拉流步骤:视频数据接收、解码、播放,分别在三个线程内完成;

注意,音频和视频数据的接收和发送都在同一个udp线程内完成。

视频推流1,视频数据采集

本例是ubuntu操作系统,视频采集使用V4L2框架,打开的摄像头设备名在配置文件配置,默认是/dev/video0,在YangVideoCaptureLinux线程内while循环采集视频数据,采集到的视频数据经初步处理放到buffer里,根据情况推送到不同地方;

本例分两路,一路推到UI界面预览,这一路不需要编码直接播放,另一路推到编码器,经编码发送给对方。

视频推流2,视频数据编码

采集到视频数据后,视频数据buffer经过指针传递(认真读代码即可),传给视频编码线程YangVideoEncoderHandle,编码后(H264)通过回调函数拿到已编码的视频数据,再把已编码的视频数据传递给发送线程发给对端。

视频推流3,视频数据udp发送

编码后的视频数据传递给YangP2pRtc发送线程,通过udp发送给对方。

视频拉流1,udp接收视频数据

使用和视频发送同一个udp接收,while循环接收视频数据,通过回调函数g_session_receive处理数据,把接收到的视频数据传递给YangP2pRtc(和上面视频数据发送在同一个类)。

视频拉流2,视频数据解码

接收的视频数据buffer指针传递到解码线程YangVideoDecoderHandles,解码以后再把视频数据推到UI界面播放。

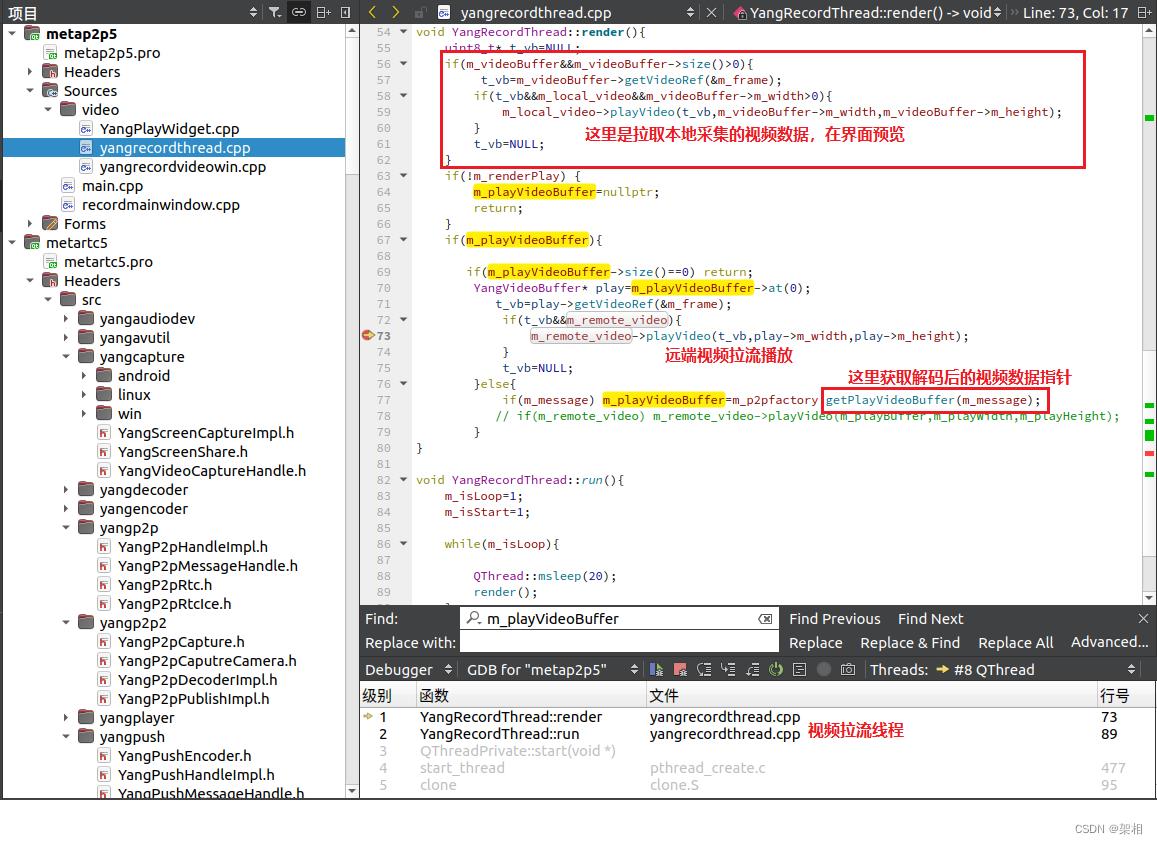

视频拉流3,视频数据播放

子线程拉取解码后视频数据,通过opengl渲染,在QT的UI主线程播放视频,本地采集视频预览也是在这里实现,这里注意opengl渲染是通过几个虚函数实现,是在UI主线程进行的,拉流播放的playVideo是在子线程,子线程刷新界面会有偶发问题。

metaRTC4.0集成ffmpeg编译

概述

ffmpeg是一个强大的音视频处理软件,处理各种音视频的编解码和传输等,里面还集成有ffplay播放器等。metaRTC4.0新版本支持静态编译集成到ffmpeg,实现 ffmpeg从流媒体服务器SRS和ZLM的webrtc推拉流,实现ffmpeg的p2p拉流。

下载源码

GitHub - metartc/ffmpeg-metartc: 集成到ffmpeg的metaRTC集成到ffmpeg的metaRTC. Contribute to metartc/ffmpeg-metartc development by creating an account on GitHub. https://github.com/metartc/ffmpeg-metartcffmpeg-metartc: 集成到ffmpeg里的metaRTC

https://github.com/metartc/ffmpeg-metartcffmpeg-metartc: 集成到ffmpeg里的metaRTC https://gitee.com/metartc/ffmpeg-metartc

https://gitee.com/metartc/ffmpeg-metartc

编译参数设置

metaRTC4.0编译

修改配置文件include/yang_config.h中

将Yang_HaveDatachannel设为0

//是否编译datachannel支持 1:是 0:否

#define Yang_HaveDatachannel 1ffmpeg编译

编译参考下面链接

以上是关于C++/Qt音视频通话开发MetaRTC源码解读,视频推流和拉流的主要内容,如果未能解决你的问题,请参考以下文章

metaRTC集成到ffmpeg实现srs的webrtc拉流播放

https://blog.csdn.net/m0_56595685/article/details/124366760

https://blog.csdn.net/m0_56595685/article/details/124366760