C++使用ffmpeg硬解码

Posted yaningli

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了C++使用ffmpeg硬解码相关的知识,希望对你有一定的参考价值。

转载:https://www.pudn.com/news/62bc096d405aad31f717648e.html

- 使用ffmpeg解码video模块,支持3种解码:cpu解码、amd64平台的cuda解码和NX平台的Nvmpi解码

- 封装库只依赖ffmpeg,测试程序中用到了OpenCV,可用于将帧送往opencv检测程序

ref:

- https://github.com/FFmpeg/FFmpeg/blob/master/doc/examples/hw_decode.c

- ref: https://github.com/chinahbcq/ffmpeg_hw_decode

概要

该库希望支持能在一份代码中支持CUDA GPU和CPU模式的切换,也可以选择是否只解码关键帧。主要设计思想如下:

判断是否支持CUDA GPU解码

bool support_hwdevice()

AVHWDeviceType type;

type = av_hwdevice_find_type_by_name(s_hwdevice_name);

if (type == AV_HWDEVICE_TYPE_NONE)

fprintf(stderr, "Device type %s is not supported.\\n", s_hwdevice_name);

fprintf(stderr, "Available device types:");

while ((type = av_hwdevice_iterate_types(type)) != AV_HWDEVICE_TYPE_NONE)

fprintf(stderr, " %s", av_hwdevice_get_type_name(type));

fprintf(stderr, "\\n");

return false;

return true;

该方法对有显卡,但不支持硬解加速的机器不适用,比如部分笔记本。

此时该函数也会返回true,但是解码时候会报 Hardware is lacking required capabilities这样的错误。

初始化

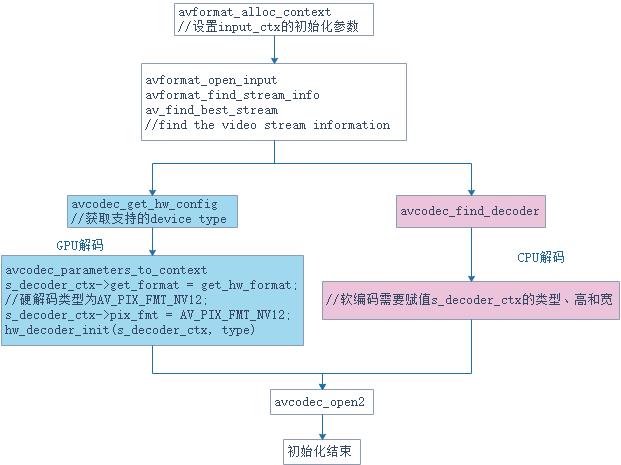

init_ctx初始化函数主要是对输入的input_ctx和用于解码的decoder_ctx初始化。

GPU解码初始化

说明:

-

深色框为硬件解码与软解解码不一样的地方。

-

av_hwdevice_find_type_by_name()的功能是根据名称查找对应的AVHWDeviceType。

-

AVHWDeviceType表示硬件加速API的类型,比如AV_HWDEVICE_TYPE_CUDA是nvidia提供的加速API.

-

av_hwdevice_find_type_by_name支持的名称如下所示。

static const char *const hw_type_names[] =

[AV_HWDEVICE_TYPE_CUDA] = "cuda",

[AV_HWDEVICE_TYPE_DRM] = "drm",

[AV_HWDEVICE_TYPE_DXVA2] = "dxva2",

[AV_HWDEVICE_TYPE_D3D11VA] = "d3d11va",

[AV_HWDEVICE_TYPE_OPENCL] = "opencl",

[AV_HWDEVICE_TYPE_QSV] = "qsv",

[AV_HWDEVICE_TYPE_VAAPI] = "vaapi",

[AV_HWDEVICE_TYPE_VDPAU] = "vdpau",

[AV_HWDEVICE_TYPE_VIDEOTOOLBOX] = "videotoolbox",

[AV_HWDEVICE_TYPE_MEDIACODEC] = "mediacodec",

;

- avcodec_get_hw_config:用于获取编解码器支持的硬件配置AVCodecHWConfig。这里用于获取硬件支持的像素格式。

- av_hwdevice_ctx_create:av_hwdevice_ctx_create创建硬件设备相关的上下文信息AVHWDeviceContext和对硬件设备进行初始化。

decoder_ctx->get_format = get_hw_format,get_hw_format是向AVCodecContext注册的一个函数,用于协商支持的像素格式。

CPU解码初始化

- cpu解码初始化与GPU不一样的是,调用avcodec_find_decoder寻找合适的decoder,并给decoder context设置类型、高和宽。

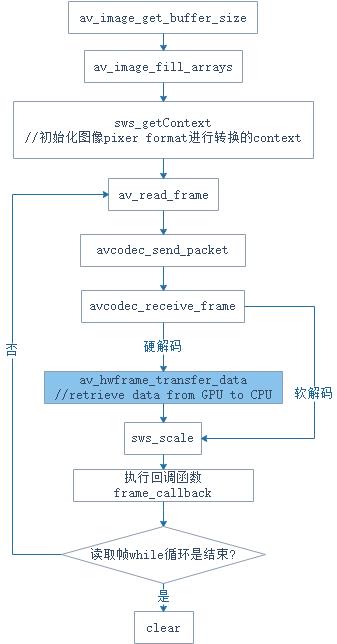

解码

- GPU解码与CPU解码的一个区别是,GPU需要调用av_hwframe_transfer_data,该函数拷贝GPU到CPU。

- av_hwframe_transfer_data:拷贝数据到一个硬件的surface,或者从一个硬件surface拷贝数据,也就是GPU和CPU之间数据拷贝。这里用于GPU拷贝到CPU。

格式

- GPU解码后数据格式默认类型是从硬件读取,CUDA可能是AV_PIX_FMT_NV12;而CPU解码后的数据一般是YUV数据,比如AV_PIX_FMT_YUV420P。

参考

// ref:https://github.com/FFmpeg/FFmpeg/blob/master/doc/examples/hw_decode.c

// ref: https://github.com/chinahbcq/ffmpeg_hw_decode

// ref: https://www.jianshu.com/p/3ea9ef713211FFmpeg 调用 Android MediaCodec 进行硬解码(附源码)

好文推荐:

作者:glumes

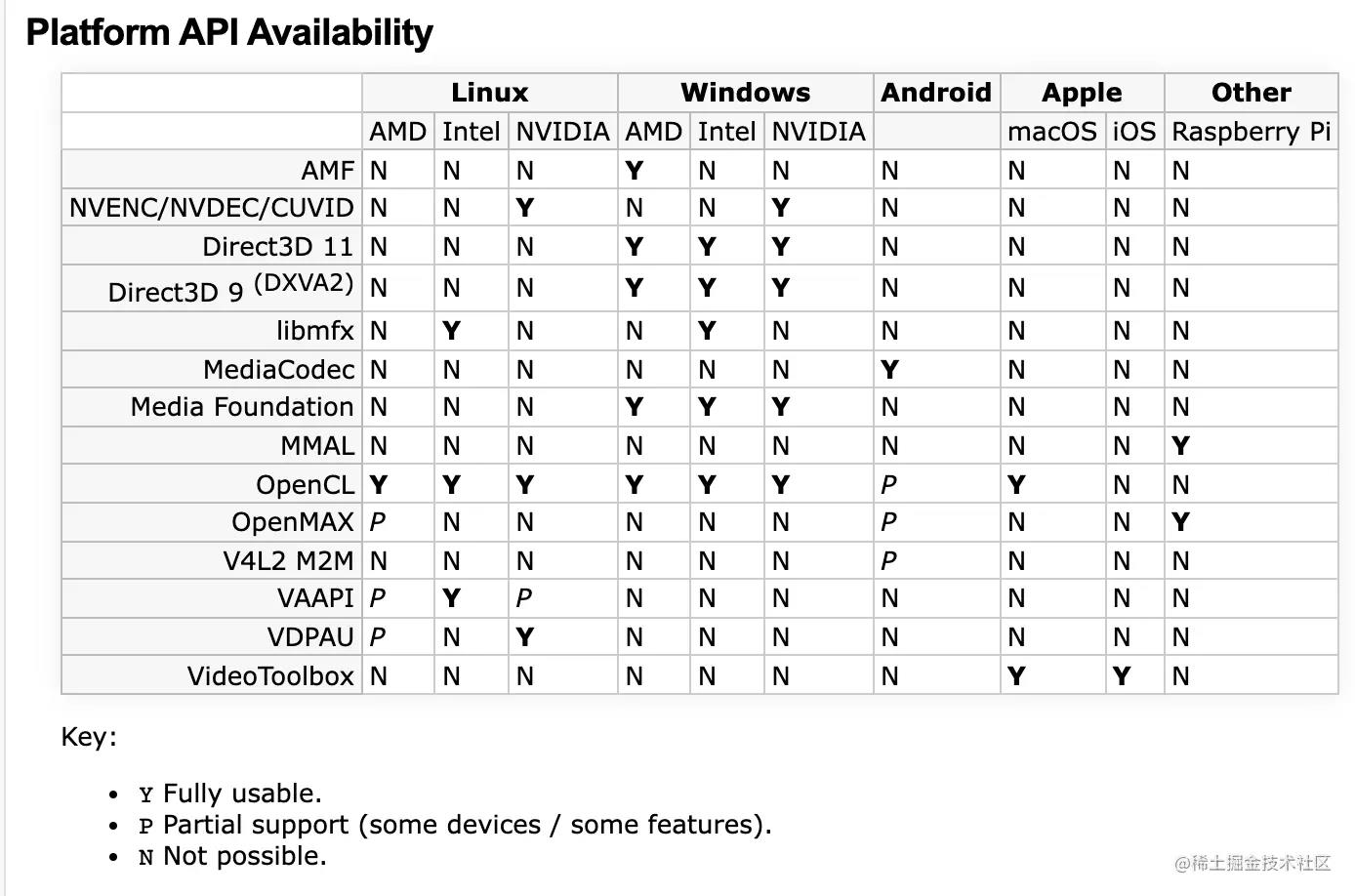

FFmpeg 在 3.1 版本之后支持调用平台硬件进行解码,也就是说可以通过 FFmpeg 的 C 代码去调用 Android 上的 MediaCodec 了。

在官网上有对应说明,地址如下:

从图中可以看到,不仅仅是 Android 上支持 MediaCodec,iOS 上也支持 VideoToolbox,连 Windows 上的 Direct3D 11 都有支持了。

注意:Android MediaCodec 目前仅支持解码,还不支持编码呢。

不过,为了验证是否可行,做个简单的演示,最后会有完整的的代码给出。

首先是 FFmpeg 的编译。它的编译有很多开关选项,要确保打开了 mediacodec 相关的选项,具体如下:

--enable-mediacodec

--enable-decoder=h264_mediacodec

--enable-decoder=hevc_mediacodec

--enable-decoder=mpeg4_mediacodec

--enable-hwaccel=h264_mediacodec

可以看出 mediacodec 支持的编码格式有 h264、hevc、mpeg4 三种可选,不在范围内的就还是考虑软解吧。

关于如何编译,就不详细阐述了,后面再专门写一篇来介绍。

编译出对应的 so 之后,可以打印一下 AVCodec 支持的格式列表,看看有没有 mediacodec 。

具体代码如下:

char info[40000] = 0;

AVCodec *c_temp = av_codec_next(NULL);

while (c_temp != NULL)

if (c_temp->decode != NULL)

sprintf(info, "%s[Dec]", info);

else

sprintf(info, "%s[Enc]", info);

switch (c_temp->type)

case AVMEDIA_TYPE_VIDEO:

sprintf(info, "%s[Video]", info);

break;

case AVMEDIA_TYPE_AUDIO:

sprintf(info, "%s[Audio]", info);

break;

default:

sprintf(info, "%s[Other]", info);

break;

sprintf(info, "%s %10s\\n", info, c_temp->name);

c_temp = c_temp->next;

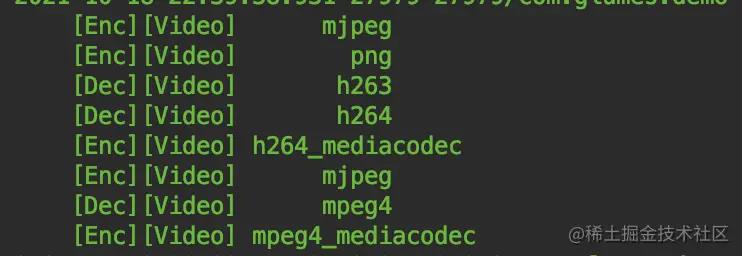

通过 AVCodec 的 next 指针进行遍历,然后打印出结果,看到下面的内容说明编译成功了。

支持的格式里面已经有了 h264_mediacodec 和 mpeg4_mediacodec 了。

接下来就进行解码了。关于 FFmpeg 解码的 API 调用,在公众号以前发布的文章中说过多次,就不详细讲解流程了,简单概况一下:

-

首先通过 avformat_open_input 方法打开文件,得到 AVFormatContext 。

-

然后通过 avformat_find_stream_info 查找文件的视频流信息。

-

得到文件相关信息和视频流信息,主要还是为了得到编码格式信息,然后好找到对应的解码器。也可以通过 avcodec_find_decoder_by_name 方法直接找具体的解码器。

-

有了解码器就可以创建解码上下文 AVCodecContext,并通过 avcodec_open2 方法打开解码器

-

然后通过 av_read_frame 读取文件的内容好进行下一步的解码。

-

接下来就是熟悉的 avcodec_send_packet 发送给解码器,avcodec_receive_frame 从解码器取回解码后的数据。

重点讲解一下调用硬件解码和普通解码的一些区别:

第一步是要在 so 加载的 JNI_OnLoad 方法中将 JavaVM 设置给 FFmpeg 。

jint JNI_OnLoad(JavaVM *vm, void *res)

av_jni_set_java_vm(vm, 0);

return JNI_VERSION_1_4;

缺少这一步就不能反射调用 Java 方法了。

接下来还是判断硬件解码类型支不支持,上面是通过 AVCodec 来判断的,实际上 FFmpeg 都给出了硬件类型的定义,在 AVHWDeviceType 枚举变量中。

enum AVHWDeviceType

AV_HWDEVICE_TYPE_NONE,

AV_HWDEVICE_TYPE_VDPAU,

AV_HWDEVICE_TYPE_CUDA,

AV_HWDEVICE_TYPE_VAAPI,

AV_HWDEVICE_TYPE_DXVA2,

AV_HWDEVICE_TYPE_QSV,

AV_HWDEVICE_TYPE_VIDEOTOOLBOX,

AV_HWDEVICE_TYPE_D3D11VA,

AV_HWDEVICE_TYPE_DRM,

AV_HWDEVICE_TYPE_OPENCL,

AV_HWDEVICE_TYPE_MEDIACODEC,

AV_HWDEVICE_TYPE_VULKAN,

;

通过 av_hwdevice_get_type_name 方法可以将这些枚举值转换成对应的字符串,比如 AV_HWDEVICE_TYPE_MEDIACODEC 对应的字符串就是 mediacodec ,其实在源码里面也是有的:

static const char *const hw_type_names[] =

[AV_HWDEVICE_TYPE_CUDA] = "cuda",

[AV_HWDEVICE_TYPE_DRM] = "drm",

[AV_HWDEVICE_TYPE_DXVA2] = "dxva2",

[AV_HWDEVICE_TYPE_D3D11VA] = "d3d11va",

[AV_HWDEVICE_TYPE_OPENCL] = "opencl",

[AV_HWDEVICE_TYPE_QSV] = "qsv",

[AV_HWDEVICE_TYPE_VAAPI] = "vaapi",

[AV_HWDEVICE_TYPE_VDPAU] = "vdpau",

[AV_HWDEVICE_TYPE_VIDEOTOOLBOX] = "videotoolbox",

[AV_HWDEVICE_TYPE_MEDIACODEC] = "mediacodec",

[AV_HWDEVICE_TYPE_VULKAN] = "vulkan",

;

和遍历 AVCodec 一样,也要遍历 FFmpeg 是否支持 mediacodec 。

type = av_hwdevice_find_type_by_name(mediacodec);

if (type == AV_HWDEVICE_TYPE_NONE)

LOGE("Device type %s is not supported.\\n", mediacodec);

LOGE("Available device types:");

while((type = av_hwdevice_iterate_types(type)) != AV_HWDEVICE_TYPE_NONE)

LOGE(" %s", av_hwdevice_get_type_name(type));

LOGE("\\n");

return -1;

确定支持 mediacodec ,那么解码就可以用了。前面提到,获取文件信息主要是为了打开解码器的,但比如文件编码格式的 H.264 ,而支持 H.264 的解码器除了软解,还有 mediacodec 要怎么选择呢?

为了方便,直接 avcodec_find_decoder_by_name 找到 mediacodec 的解码器就行。

if (!(decoder = avcodec_find_decoder_by_name("h264_mediacodec")))

LOGE("avcodec_find_decoder_by_name failed.\\n");

return -1;

找到解码器之后,还要得到该解码器的一些配置信息,比如解码出的格式是什么样子的?mediacodec 解码就是 NV21 这种。

for (i = 0;; i++)

// 解码器的配置

const AVCodecHWConfig *config = avcodec_get_hw_config(decoder, i);

if (!config)

LOGE("Decoder %s does not support device type %s.\\n",

decoder->name, av_hwdevice_get_type_name(type));

return -1;

if (config->methods & AV_CODEC_HW_CONFIG_METHOD_HW_DEVICE_CTX &&

config->device_type == type)

// 硬解的格式

hw_pix_fmt = config->pix_fmt;

break;

目前 mediacodec 解码还只有 buffer 模式,没有直接解纹理的那种。

接下来就是给解码上下文 AVCodecContext 添加一些硬件解码的上下文。

static int hw_decoder_init(AVCodecContext *ctx, const enum AVHWDeviceType type)

int err = 0;

if ((err = av_hwdevice_ctx_create(&hw_device_ctx, type,

NULL, NULL, 0)) < 0)

LOGE("Failed to create specified HW device.\\n");

return err;

// 硬解解码的上下文

ctx->hw_device_ctx = av_buffer_ref(hw_device_ctx);

return err;

完成了这一系列操作之后,就是正常的解码了,拿到解码后的 AVFrame 内容。

如果 AVFrame 格式和硬件解码的配置格式一样,那么要用 av_hwframe_transfer_data 方法将它做一下转换,转成正常的 YUV 格式。

if (frame->format == hw_pix_fmt)

/* retrieve data from GPU to CPU */

if ((ret = av_hwframe_transfer_data(sw_frame, frame, 0)) < 0)

LOGE("Error transferring the data to system memory\\n");

goto fail;

tmp_frame = sw_frame;

else

tmp_frame = frame;

等完成这一些操作之后,就已经解码成功了,实际运行也是 OK 的。

以上是关于C++使用ffmpeg硬解码的主要内容,如果未能解决你的问题,请参考以下文章