第⑦讲:Ceph集群RGW对象存储核心概念及部署使用

Posted Jiangxl~

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了第⑦讲:Ceph集群RGW对象存储核心概念及部署使用相关的知识,希望对你有一定的参考价值。

文章目录

1.RadosGW对象存储核心概念

RADOSGW对象存储官方文档:https://docs.ceph.com/en/pacific/radosgw/

1.1.什么是RadosGW对象存储

Ceph RadosGW是对象存储的一种实现方式,简称RGW,Rados网关也被称为Ceph对象网关,RadosGW使客户端能够利用标准的对象存储API接口来访问Ceph集群进行存储数据。

RGW对象存储支持两种风格的对象存储API接口:

- AWS S3:与亚马逊云的S3对象存储API接口兼容。

- OpenStack Swift:与OpenStack的Swift的API接口兼容,提供对象存储功能。

RGW对象存储提供RESTful API类型的接口,如果有类似阿里云等对象存储的可视化接口,可以直接在图形化界面操作对象存储。

无论哪种类型的API接口,最终都会通过RadosGW服务奖数据写入到Ceph集群的OSD里,并且这些接口都会对应一个资源池,也就是说无论使用哪种类型的API接口,都可以读取到来自其他API接口写入的数据。

RadosGW在之前的版本中,是使用CIVETWEB提供的API访问。

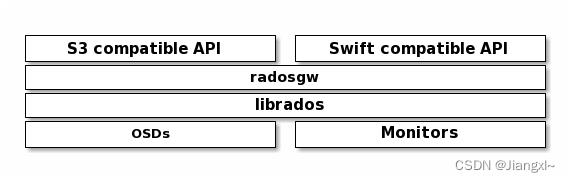

1.2.RGW对象存储架构

Ceph集群的对象存储功能主要是有RadosGW组件来实现的,支持S3和Swift两种风格的API接口,当然也支持自定义的API接口类型,用户在对象存储写入数据时,由RadosGW处理用户的请求,然后通过Librados库将数据写入到Ceph集群的OSD中。

客户端是基于HTTP或者HTTPS协议通过RESTful API与RGE进行通信,RGW则使用Librados库与Ceph集群进行通信,通过接口API的身份验证,最终将数据写入到OSD中。

1.3.RGW对象存储的特点

- 通过对象存储的方式在Ceph集群中存储数据,文件也会被拆分成多个对象,每个对象文件除了包含数据意外,还会包含数据自身的元数据信息,并且如果是大文件,在写入到Ceph集群时,还会被切片,写入到集群后再进行重组。

- 写入到对象存储的数据文件,无法使用文件的路径名称在服务器中找到,只能通过API来访问数据文件。

- 对象存储中的Object文件是存储在一种扁平的空间中,叫做Bucket,用于资源隔离。

- ceph使用Bucket作为对象存储的存储桶,Bucket需要被授权才能访问到,可以起到多用户对数据文件的访问隔离,数据都是存储在Bucket空间里的,用户的权限也是针对Bucket进行授权,用户可以对不同的Bucket拥有不同的权限。

- 不支持客户端挂载,客户端通过HTTP或者HTTPS访问对象文件。

- 不适用频繁修改和删除的场景,存储静态文件的场景居多。

1.4.对象存储中Bucket的特性

Bucket称为存储空间,所有对象存储中的文件必须隶属于某个Bucket存储空间,可以对存储空间设置控制地域、访问权限、生命周期等等。

每个用户可以拥有多个Bucket存储空间,一个存储空间内部是扁平的,没有文件系统的目录概念,所有的对象文件都直接隶属于对应的存储空间。

存储空间的名称在集群中必须是全局唯一,一旦创建无法修改。

存储空间中的对象条目没有限制。

Bucket存储空间的命名规范:只能包括大小写字母、数字和短横线,必须以小写字母或者数字开头和结尾,长度必须在3-63字节之间。

1.4.不同接口类型的对象存储访问对比

- Amazon S3:提供了user、bucket和object,分别表示为用户、存储桶和对象,其中bucket隶属于user,可以这对user设置不同bucket的名称空间访问权限,而且不用用户允许访问相同的bucket。

- OpenStack Swift:提供了user、container和object,分别对应于用户、存储桶和对象,不过它还额外为user提供了父级组件account,用于表示一个项目或租户,因此一个account中它包含一个到多个user,他们可共享使用同一组container,并为container提供名称空间。

- RadosGW:提供了user、subuser、bucket和object,其中的user对应S3的user,而subuser则对应于Swif的user,不过user和subuser都不支持为bucket提供名称空间,因此,不同用户的存储桶也不允许同名,不过自Jewel版本起,RadosGW引入了tenant(租户)用于为user和bucket提供名称空间,但它是个可选组件,RadosGW基于ACL为不同的用户设置不用的权限。

- Read 读加执行权限

- Write 写权限

- Readwrite 只读

- full-control 全部控制权限

2.在集群中部署RadosGW对象存储组件

2.1.部署RGW组件

1)安装RadosGW组件

[root@ceph-node-1 ceph-deploy]# yum -y install ceph-radosgw

2)将ceph-node-1节点配置成集群中的RGW节点

[root@ceph-node-1 ~]# cd /data/ceph-deploy/

[root@ceph-node-1 ceph-deploy]# ceph-deploy rgw create ceph-node-1

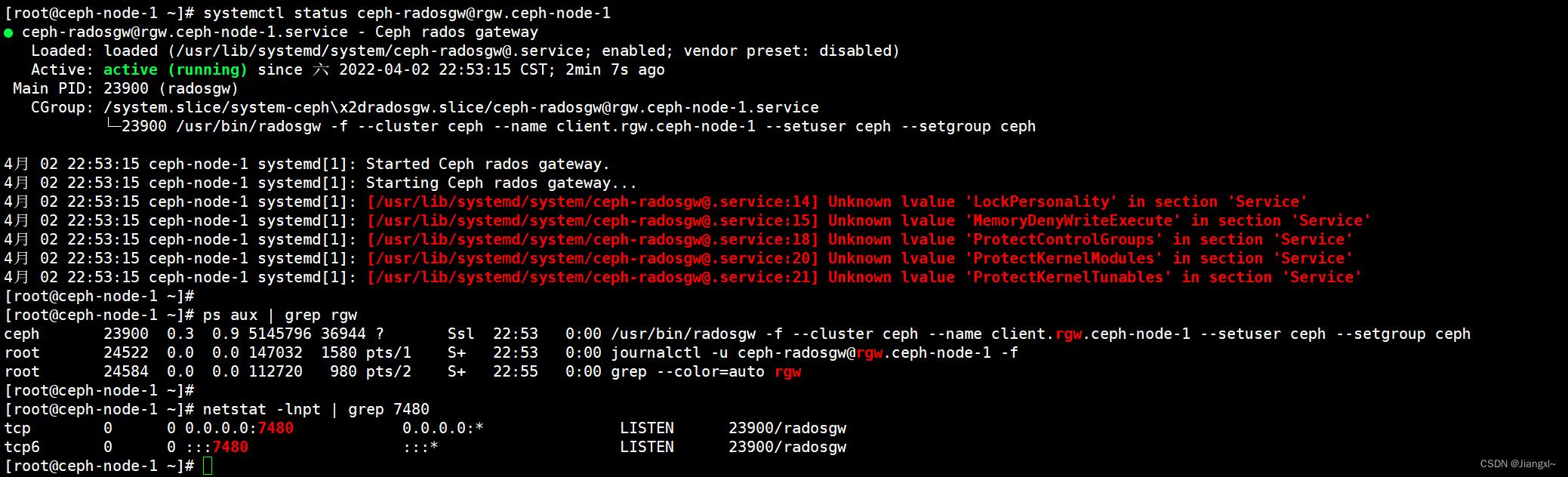

3)查看RGW组件启动的进程以及端口号

[root@ceph-node-1 ~]# systemctl status ceph-radosgw@rgw.ceph-node-1

[root@ceph-node-1 ~]# ps aux | grep rgw

ceph 23900 0.3 0.9 5145796 36944 ? Ssl 22:53 0:00 /usr/bin/radosgw -f --cluster ceph --name client.rgw.ceph-node-1 --setuser ceph --setgroup ceph

root 24522 0.0 0.0 147032 1580 pts/1 S+ 22:53 0:00 journalctl -u ceph-radosgw@rgw.ceph-node-1 -f

root 24584 0.0 0.0 112720 980 pts/2 S+ 22:55 0:00 grep --color=auto rgw

[root@ceph-node-1 ~]# netstat -lnpt | grep 7480

tcp 0 0 0.0.0.0:7480 0.0.0.0:* LISTEN 23900/radosgw

tcp6 0 0 :::7480 :::* LISTEN 23900/radosgw

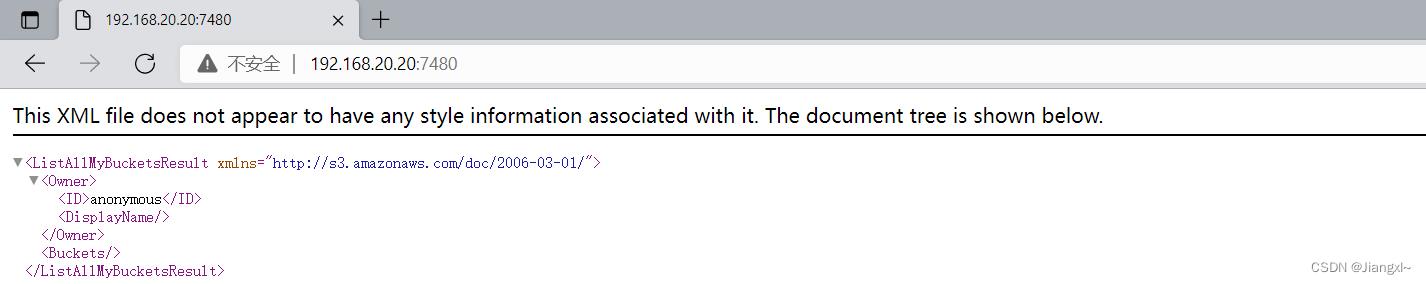

4)可以简单的访问下RGW提供的API接口

2.2.集群中部署完RGW组件后观察集群的信息状态

[root@ceph-node-1 ~]# ceph -s

cluster:

id: a5ec192a-8d13-4624-b253-5b350a616041

health: HEALTH_OK

services:

mon: 3 daemons, quorum ceph-node-1,ceph-node-2,ceph-node-3 (age 49m)

mgr: ceph-node-1(active, since 45m), standbys: ceph-node-2, ceph-node-3

osd: 6 osds: 6 up (since 6m), 6 in (since 6m)

rgw: 1 daemon active (ceph-node-1) #可以看到在这里多了一个RGW组件

task status:

data:

pools: 5 pools, 256 pgs

objects: 190 objects, 1.2 KiB

usage: 6.0 GiB used, 54 GiB / 60 GiB avail

pgs: 256 active+clean

2.3.修改RGW对象存储的默认监听端口

RGW的默认端口是7380,像这种通过WEB方式访问的程序,最好是使用80端口。

RGW的端口号在配置文件中进行指定,我们只需要修改ceph-deploy生成的ceph.conf文件就可以,然后推送给各个节点。

1.修改ceph的配置文件,指定rgw使用的端口号

[root@ceph-node-1 ~]# cd /data/ceph-deploy/

[root@ceph-node-1 ceph-deploy]# vim ceph.conf

[global]

fsid = a5ec192a-8d13-4624-b253-5b350a616041

public_network = 192.168.20.0/23

cluster_network = 192.168.30.0/23

mon_initial_members = ceph-node-1, ceph-node-2, ceph-node-3

mon_host = 192.168.20.20,192.168.20.21,192.168.20.22

auth_cluster_required = cephx

auth_service_required = cephx

auth_client_required = cephx

[client.rgw.ceph-node-1] #指定RGW节点的节点名称

rgw_frontends = "civetweb port=80" #port后面跟端口号

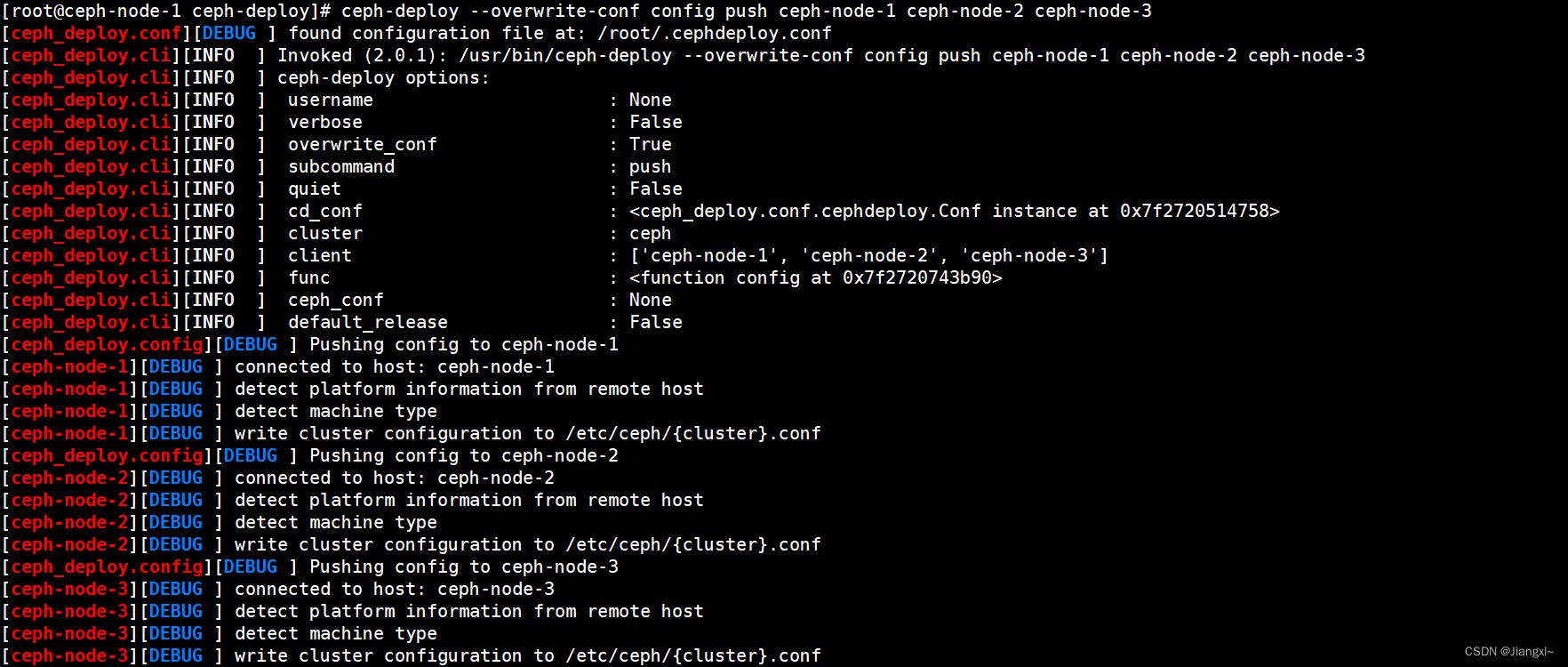

2.将配置文件推送到集群的所有节点中

[root@ceph-node-1 ceph-deploy]# ceph-deploy --overwrite-conf config push ceph-node-1 ceph-node-2 ceph-node-3

3.重启RGW组件

[root@ceph-node-1 ceph-deploy]# systemctl restart ceph-radosgw.target

4.查看RGW的端口号

[root@ceph-node-1 ceph-deploy]# netstat -lnpt | grep radosgw

tcp 0 0 0.0.0.0:80 0.0.0.0:* LISTEN 24837/radosgw

在浏览器中也可以访问。

CEPH的基本概念及通过Ceph-Deploy快速部署CEPH集群

基础概念

**OSD**:Object Storage Device,主要用于存储数据,处理数据,,恢复,回不,平衡数据,并提供数据给monitor。

**Monitor**:Ceph监视器,主要用于集群健康状态维护,提供策略,包含Monitor Map ,OSD Map,PG ma和CRUSH MAP

**MSD**:Cpeh Metadata Server,主要保存ceph文件系统的元数据,快存储,对象存储不需要MSD。Ceph的架构

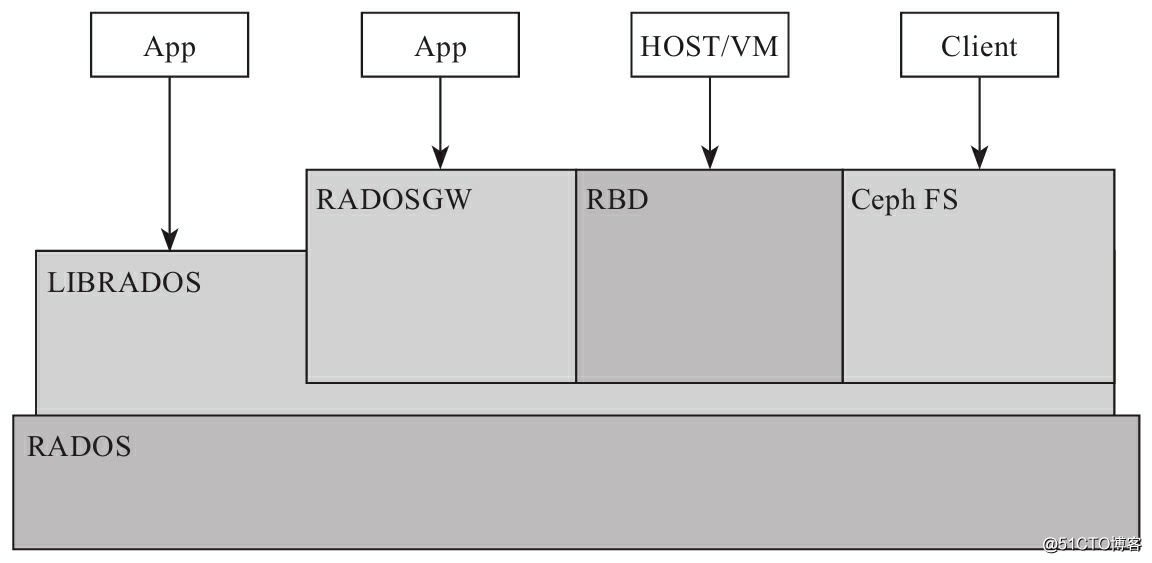

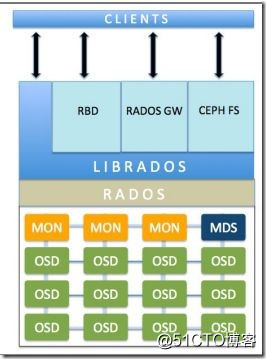

核心组件RADOS,如架构图

RADOS:具备自我修复的特性,提供一个可靠,自动,智能的分布式存储

LIBRADOS:库文件,支持应用程序直接访问

RADOSGW:基于当前流行的RESTful协议的网关,并且兼容S3和Swift

RDB:通过Linux内核客户端和qemu-kvm驱动,来提供一个完全分布式的块设备

Ceph FS:兼容POSIX的文件系统

Ceph组件和RADOS的关系

ceph存储逻辑上大致分为4个部分,RADOS基础存储系统,基于RADOS的cephFS,基于RADOS的LIBRADOS应用接口, 基于LIBRADOS的应用接口RBD。

- 基础存储系统RADOS:

本身是一个完整的对象文件系统,用户的数据由这一层来进行存储,物理上,由每一个节点组成。 - 基础库LIBRADOS:

这一层,将RADOS的功能进行抽象和封装,向上提供API。物理上,基于LIBRADOS开发的应用,与LIBRADOS位于同一台物理机上,应用通过调用本地的API,再有API通过SOCKET套接子与RADOS的节点进行通信,完成各种操作。 - 上层应用接口:

上层应用接口包括RADOSGW,RDB和ceph FS,其中除了CEPH FS,其余基于LIBRADOS库的基础上进一步进行抽象。 - 应用层:就是一些应用

- RADOS:主要有OSD和MOnitor组成

(1). Monitor:监控整个集群的运行状况,包括节点的状态,集群的配置信息等,如monitor map,osd map,MDS map和CRUSH map。

(a).Monitor Map:记录着monitor节点端到端的信息,其中包括集群ID,监控主机IP和端口等信息。

查看Monitor的map: # ceph mon dump

(b).OSD Map:记录一下信息,如集群ID,创建OSD Map的版本信息和修改信息,pool的信息(pool的名称,ID,类型,副本数目等),OSD的数量,权重,状态等信息。

查看OSD的MAP:# ceph osd dump

(c).PG Map:记录PG的版本,时间戳,最新的OSD Map版本信息,空间使用比例等,还有PF ID,对象数目,状态,等。

查看PG Map: # ceph pg dump

(d).CRUSH Map:集群存储设备信息,故障域层次结构和存储数据时定义,失败域规则信息。

查看CRUSH Map: # ceph osd crush dump

(e).MDS Map:存储当前MDS Map的版本信息、创建当前Map的信息、修改时间、数据和元数据POOL ID、集群MDS数目和MDS状态.

查看MDS Map: # ceph mds dump

注:monitor节点需要需要足够的磁盘来存储集群的日志文件

Monitor集群中,集群节点的数为奇数,其中一个节点为Leader,用作监视器节点,当Leader不可用时,剩余的节点都可以成为leader,保证集群中至少有N/2个监控节点高可用

(2).OSD:OSD将数据以对象的形式存储在集群中的每个节点的物理磁盘上。

客户端从monitor拿到CLUSTER Map信息之后,直接与OSD进行交互进行数据的读写。

在OSD的上的每个对象都有一个主副本和若干个从副本,每个OSD及是某个对象的主OSD,也可能是某个对象的从OSD,从OSD收到主OSD的控制,当主OSD故障时,从OSD 成为主OSD,从新生成副本。

ceph支持的文件系统:BTRFS,XFS,EXT4

journal的存在能够减缓缓存突发负载,ceph写入数据时首先写入日志,然后在写入后备文件系统。

Ceph的Ceph-Deploy部署

此工具通过ssh在远程上执行一系列脚本来完成部署,ceph为远程主机

配置YUM源:

- 创建yum源:

[Ceph]

name=Ceph packages for $basearch

baseurl=http://mirrors.aliyun.com/ceph/rpm-infernalis/el7/$basearch

enabled=1

gpgcheck=1

type=rpm-md

gpgkey=http://mirrors.aliyun.com/ceph/keys/release.asc

priority=1

[Ceph-noarch]

name=Ceph noarch packages

baseurl=http://mirrors.aliyun.com/ceph/rpm-infernalis/el7/noarch

enabled=1

gpgcheck=1

type=rpm-md

gpgkey=http://mirrors.aliyun.com/ceph/keys/release.asc

priority=1

[ceph-source]

name=Ceph source packages

baseurl=http://mirrors.aliyun.com/ceph/rpm-infernalis/el7/SRPMS

enabled=1

gpgcheck=1

type=rpm-md

gpgkey=http://mirrors.aliyun.com/ceph/keys/release.asc

priority=1

- 更新源并安装:

yum update &&yum install ceph-deploy -y

- 创建目录,存放部署过程中生成的配置文件

mkdir ceph

cd ceph - 创建集群,部署新的monitor:

ceph-deploy new {initial-monitor-node(s)}

如:ceph-deploy new hostname1 hostname2..... - 安装ceph到各个节点:

ceph-deploy install hostname1 hostname2.....

- 获取秘钥key,创建的目录下会生成key

ceph-deploy mon create-initial

- 初始化磁盘:

ceph-deploy disk zap node1:sdb

- 准备OSD:

ceph-deploy osd prepare node1:sdb1:....

- 激活OSD:

ceph-deploy osd activate node1:sdb1:......

- 分发KEY:

ceph-deploy admin node1 node2 node3

- adminkey赋权限

chmod +r etcceph/ceph.client.admin.keyri

- 查看集群状态:

ceph health

以上是关于第⑦讲:Ceph集群RGW对象存储核心概念及部署使用的主要内容,如果未能解决你的问题,请参考以下文章