数据预处理的方法有哪些?

Posted 我想去吃ya

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了数据预处理的方法有哪些?相关的知识,希望对你有一定的参考价值。

数据处理的工作时间占据了整个数据分析项目的70%以上。因此,数据的质量直接决定了分析模型的准确性。那么,数据预处理的方法有哪些呢?比如数据清洗、数据集成、数据规约、数据变换等,其中最常用到的是数据清洗与数据集成,下面小编将来详细介绍一下这2种方法。

1、数据清洗

数据清洗是通过填补缺失值,平滑或删除离群点,纠正数据的不一致来达到清洗的目的。简单来说,就是把数据里面哪些缺胳膊腿的数据、有问题的数据给处理掉。总的来讲,数据清洗是一项繁重的任务,需要根据数据的准确性、完整性、一致性、时效性、可信性和解释性来考察数据,从而得到标准的、干净的、连续的数据。

(1)缺失值处理

实际获取信息和数据的过程中,会存在各类的原因导致数据丢失和空缺。针对这些缺失值,会基于变量的分布特性和变量的重要性采用不同的方法。若变量的缺失率较高(大于80%),覆盖率较低,且重要性较低,可以直接将变量删除,这种方法被称为删除变量;若缺失率较低(小于95%)且重要性较低,则根据数据分布的情况用基本统计量填充(最大值、最小值、均值、中位数、众数)进行填充,这种方法被称为缺失值填充。对于缺失的数据,一般根据缺失率来决定“删”还是“补”。

(2)离群点处理

离群点(异常值)是数据分布的常态,处于特定分布区域或范围之外的数据通常被定义为异常或噪声。我们常用的方法是删除离群点。

(3)不一致数据处理

实际数据生产过程中,由于一些人为因素或者其他原因,记录的数据可能存在不一致的情况,需要对这些不一致数据在分析前进行清理。例如,数据输入时的错误可通过和原始记录对比进行更正,知识工程工具也可以用来检测违反规则的数据。

2、数据集成

随着大数据的出现,我们的数据源越来越多,数据分析任务多半涉及将多个数据源数据进行合并。数据集成是指将多个数据源中的数据结合、进行一致存放的数据存储,这些源可能包括多个数据库或数据文件。在数据集成的过程中,会遇到一些问题,比如表述不一致,数据冗余等,针对不同的问题,下面简单介绍一下该如何处理。

(1)实体识别问题

在匹配来自多个不同信息源的现实世界实体时,如果两个不同数据库中的不同字段名指向同一实体,数据分析者或计算机需要把两个字段名改为一致,避免模式集成时产生的错误。

(2)冗余问题

冗余是在数据集成中常见的一个问题,如果一个属性能由另一个或另一组属性“导出”,则此属性可能是冗余的。

(3)数据值的冲突和处理

不同数据源,在统一合并时,需要保持规范化,如果遇到有重复的,要去重。

本文介绍了两种最常见的数据预处理方法,实际操作中,我们拿到的数据可能包含了大量的缺失值、异常点等,非常不利于数据分析。这时需要我们对脏数据进行预处理,得到标准的、干净的、连续的数据,提供给数据分析、数据挖掘等使用。希望大家通过本文能对数据预处理有一个简单的了解,在数据处理时,能根据具体遇到的问题采取相应的方法。

猎聘大数据研究院发布了《2022未来人才就业趋势报告》

从排名来看,2022年1-4月各行业中高端人才平均年薪来看,人工智能行业中高端人才平均年薪最高,为31.04万元;金融行业中高端人才以27.69万元的平均年薪位居第二;通信、大数据行业中高端人才平均年薪分别为27.51万元、25.23万元,位列第三、第四;IT/互联网行业中高端人才平均年薪23.02万元,位列第七。

图表来源:《2022未来人才就业趋势报告》

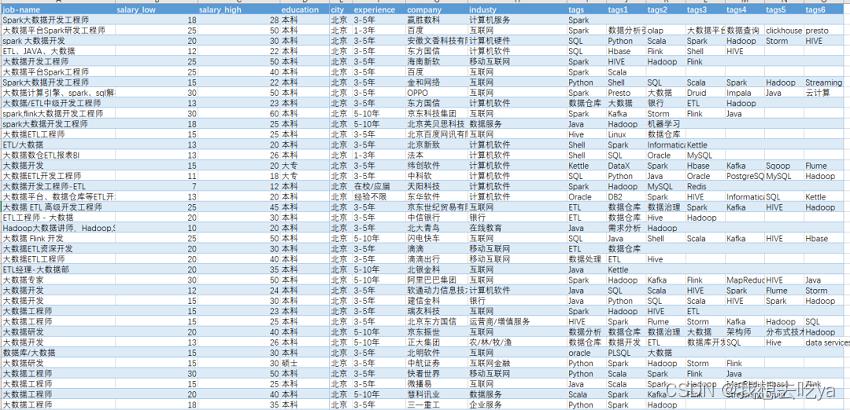

如果你觉得很高,被平均了这样?那么打开Boss直聘,搜大数据工程师:

我们来做下数据分析:

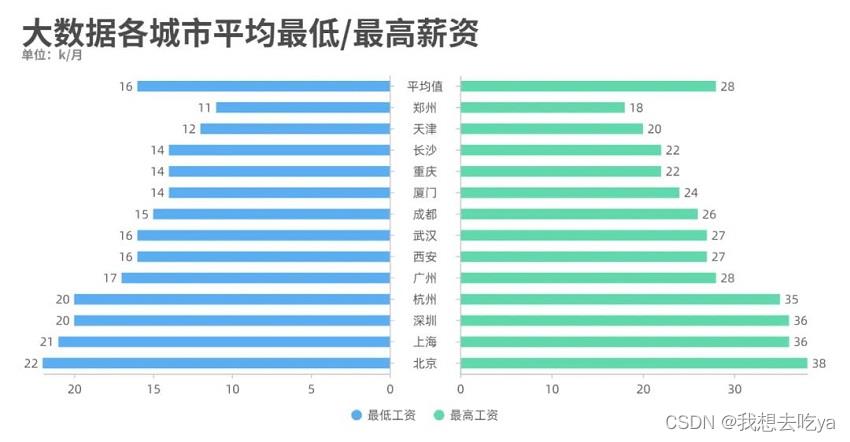

薪资那一列都有一个最低薪资和最高薪资,我们通过不同城市来对比分析一下,发现北京的工资水平最高,最低为22k,最高为38k。

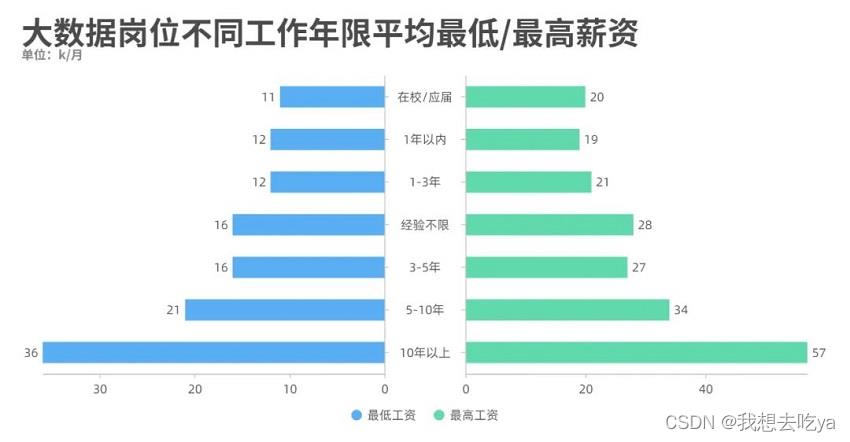

工作年限也是一个制约工资水平的很大因素,从图中可以看出,即使是刚毕业,也能达到一个11-20k的薪资范围。

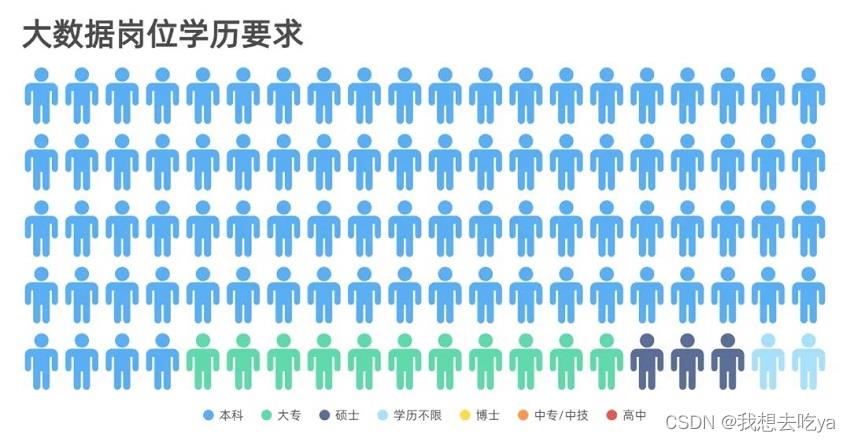

而学历要求来说,大部分为本科,其次为大专和硕士,其他比较少,以至于在图中并没有显示出来。

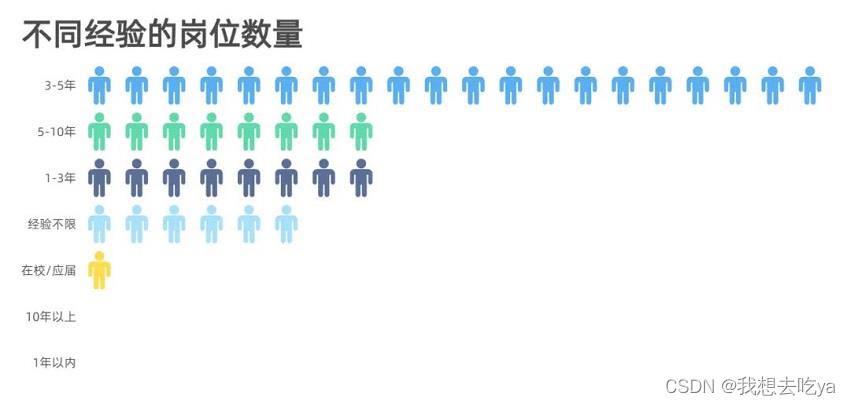

企业对不同岗位的要求以3-5年的居多,企业当然是需要有一定工作经验的员工,但是在实际招聘中,如果你有项目经验,且理论知识没问题,企业也会放宽条件。

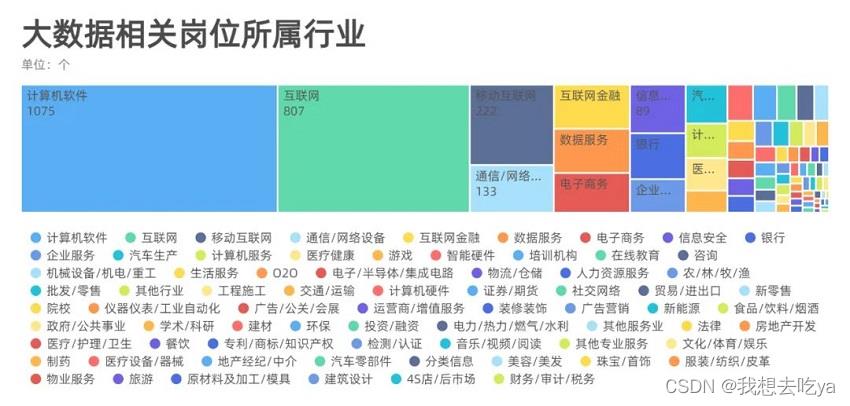

分析不同行业, 我们发现,大数据岗位需求分布在各行各业,主要还是在计算机软件和互联网最多,也有可能是这个招聘软件决定的,毕竟Boss直聘还是以互联网行业为主。

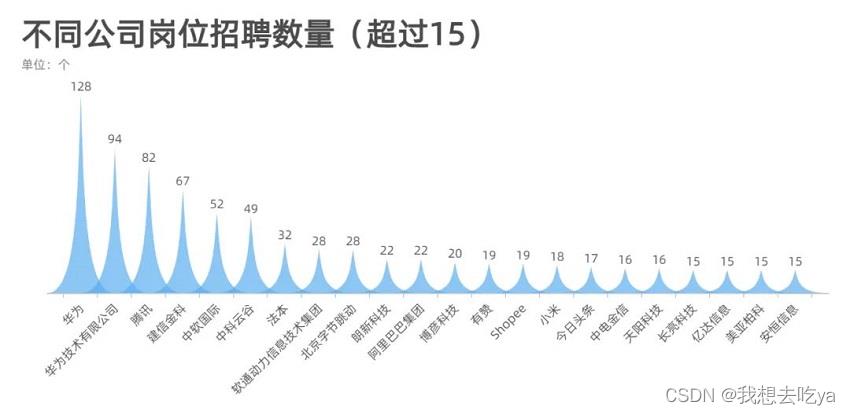

来看看哪些公司在招聘大数据相关岗位,从这个超过15的数量来看,华为,腾讯,阿里,字节,这些大厂对这个岗位的需求量还是很大的。

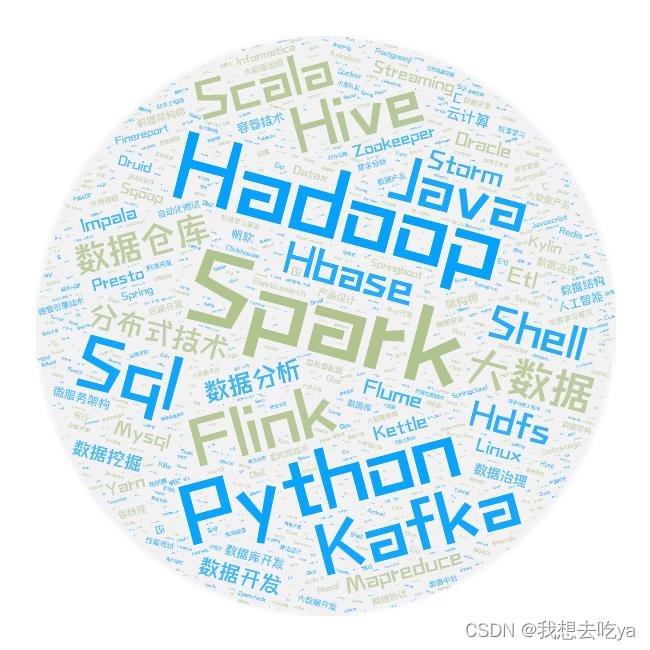

那么这些岗位都需要什么技能呢?Spark,Hadoop,数据仓库,Python,SQL,Mapreduce,Hbase等等

根据国内的发展形势,大数据未来的发展前景会非常好。自 2018 年企业纷纷开始数字化转型,一二线城市对大数据领域的人才需求非常强烈,未来几年,三四线城市的人才需求也会大增。

在大数据领域,国内发展的比较晚,从 2016 年开始,仅有 200 多所大学开设了大数据相关的专业,也就是说 2020 年第一批毕业生才刚刚步入社会,我国市场环境处于急需大数据人才但人才不足的阶段,所以未来大数据领域会有很多的就业机遇。

薪资高、缺口大,自然成为职场人的“薪”选择!

任何学习过程都需要一个科学合理的学习路线,才能够有条不紊的完成我们的学习目标。Python+大数据所需学习的内容纷繁复杂,难度较大,为大家整理了一个全面的Python+大数据学习路线图,帮大家理清思路,攻破难关!

Python+大数据学习路线图详细介绍

第一阶段 大数据开发入门

学前导读:从传统关系型数据库入手,掌握数据迁移工具、BI数据可视化工具、SQL,对后续学习打下坚实基础。

1.大数据数据开发基础MySQL8.0从入门到精通

mysql是整个IT基础课程,SQL贯穿整个IT人生,俗话说,SQL写的好,工作随便找。本课程从零到高阶全面讲解MySQL8.0,学习本课程之后可以具备基本开发所需的SQL水平。

2022最新MySQL知识精讲+mysql实战案例_零基础mysql数据库入门到高级全套教程

第二阶段 大数据核心基础

学前导读:学习Linux、Hadoop、Hive,掌握大数据基础技术。

2022版大数据Hadoop入门教程

Hadoop离线是大数据生态圈的核心与基石,是整个大数据开发的入门,是为后期的Spark、Flink打下坚实基础的课程。掌握课程三部分内容:Linux、Hadoop、Hive,就可以独立的基于数据仓库实现离线数据分析的可视化报表开发。

2022最新大数据Hadoop入门视频教程,最适合零基础自学的大数据Hadoop教程

第三阶段 千亿级数仓技术

学前导读:本阶段课程以真实项目为驱动,学习离线数仓技术。

数据离线数据仓库,企业级在线教育项目实战(Hive数仓项目完整流程)

本课程会、建立集团数据仓库,统一集团数据中心,把分散的业务数据集中存储和处理 ;目从需求调研、设计、版本控制、研发、测试到落地上线,涵盖了项目的完整工序 ;掘分析海量用户行为数据,定制多维数据集合,形成数据集市,供各个场景主题使用。

大数据项目实战教程_大数据企业级离线数据仓库,在线教育项目实战(Hive数仓项目完整流程)

第四阶段 PB内存计算

学前导读:Spark官方已经在自己首页中将Python作为第一语言,在3.2版本的更新中,高亮提示内置捆绑Pandas;课程完全顺应技术社区和招聘岗位需求的趋势,全网首家加入Python on Spark的内容。

1.python入门到精通(19天全)

python基础学习课程,从搭建环境。判断语句,再到基础的数据类型,之后对函数进行学习掌握,熟悉文件操作,初步构建面向对象的编程思想,最后以一个案例带领同学进入python的编程殿堂。

全套Python教程_Python基础入门视频教程,零基础小白自学Python必备教程

2.python编程进阶从零到搭建网站

学完本课程会掌握Python高级语法、多任务编程以及网络编程。

Python高级语法进阶教程_python多任务及网络编程,从零搭建网站全套教程

3.spark3.2从基础到精通

Spark是大数据体系的明星产品,是一款高性能的分布式内存迭代计算框架,可以处理海量规模的数据。本课程基于Python语言学习Spark3.2开发,课程的讲解注重理论联系实际,高效快捷,深入浅出,让初学者也能快速掌握。让有经验的工程师也能有所收获。

Spark全套视频教程,大数据spark3.2从基础到精通,全网首套基于Python语言的spark教程

4.大数据Hive+Spark离线数仓工业项目实战

通过大数据技术架构,解决工业物联网制造行业的数据存储和分析、可视化、个性化推荐问题。一站制造项目主要基于Hive数仓分层来存储各个业务指标数据,基于sparkSQL做数据分析。核心业务涉及运营商、呼叫中心、工单、油站、仓储物料。

全网首次披露大数据Spark离线数仓工业项目实战,Hive+Spark构建企业级大数据平台

数据预处理的方法有哪些

数据处理的工作时间占整个数据分析项目的70%以上,因此,数据的质量直接决定了分析模型的准确性。那么,数据预处理的方法是什么呢?例如数据清理、数据集成、数据规范、数据转换等,其中最常用的是数据清理和数据集成,下面中琛魔方将来详细介绍一下这2种方法。

数据预处理的方法

1、数据清洗

数据清洗是通过填补缺失值,平滑或删除离群点,纠正数据的不一致来达到清洗的目的。简单来说,就是把数据里面哪些缺胳膊腿的数据、有问题的数据给处理掉。总的来讲,数据清洗是一项繁重的任务,需要根据数据的准确性、完整性、一致性、时效性、可信性和解释性来考察数据,从而得到标准的、干净的、连续的数据。

(1)缺失值处理

实际获取信息和数据的过程中,会存在各类的原因导致数据丢失和空缺。针对这些缺失值,会基于变量的分布特性和变量的重要性采用不同的方法。若变量的缺失率较高(大于80%),覆盖率较低,且重要性较低,可以直接将变量删除,这种方法被称为删除变量;若缺失率较低(小于95%)且重要性较低,则根据数据分布的情况用基本统计量填充(最大值、最小值、均值、中位数、众数)进行填充,这种方法被称为缺失值填充。对于缺失的数据,一般根据缺失率来决定“删”还是“补”。

(2)离群点处理

离群点(异常值)是数据分布的常态,处于特定分布区域或范围之外的数据通常被定义为异常或噪声。我们常用的方法是删除离群点。

(3)不一致数据处理

实际数据生产过程中,由于一些人为因素或者其他原因,记录的数据可能存在不一致的情况,需要对这些不一致数据在分析前进行清理。例如,数据输入时的错误可通过和原始记录对比进行更正,知识工程工具也可以用来检测违反规则的数据。

2、数据集成

随着大数据的出现,我们的数据源越来越多,数据分析任务多半涉及将多个数据源数据进行合并。数据集成是指将多个数据源中的数据结合、进行一致存放的数据存储,这些源可能包括多个数据库或数据文件。在数据集成的过程中,会遇到一些问题,比如表述不一致,数据冗余等,针对不同的问题,下面简单介绍一下该如何处理。

(1)实体识别问题

在匹配来自多个不同信息源的现实世界实体时,如果两个不同数据库中的不同字段名指向同一实体,数据分析者或计算机需要把两个字段名改为一致,避免模式集成时产生的错误。

(2)冗余问题

冗余是在数据集成中常见的一个问题,如果一个属性能由另一个或另一组属性“导出”,则此属性可能是冗余的。

(3)数据值的冲突和处理

不同数据源,在统一合并时,需要保持规范化,如果遇到有重复的,要去重。

数据预处理的方法有哪些.中琛魔方大数据分析平台表示在实践中,我们得到的数据可能包含大量的缺失值、异常值等,这对数据分析是非常不利的。此时,我们需要对脏数据进行预处理,以获得标准、干净和连续的数据,这些数据可以用于数据分析、数据挖掘等。

以上是关于数据预处理的方法有哪些?的主要内容,如果未能解决你的问题,请参考以下文章