[SIGIR‘22]图对比推荐论文SimGCL/XSimGCL算法和代码简介

Posted 博一老狗

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了[SIGIR‘22]图对比推荐论文SimGCL/XSimGCL算法和代码简介相关的知识,希望对你有一定的参考价值。

Are Graph Augmentations Necessary? Simple Graph Contrastive Learning for Recommendation [SIGIR'22]

XSimGCL: Towards Extremely Simple Graph Contrastive Learning for Recommendation

论文链接:XSimGCL: Towards Extremely Simple Graph Contrastive Learning for Recommendation

背景/动机

基于对比学习的图推荐系统已经引起了广泛的关注,并且在收敛速度、推荐性能和鲁棒性等方面均占山出明显优势。以SGL为代表的图对比推荐方法采用基于抽样、dropout等方式的图数据增强策略来构造用户-物品交互图的不同视角,以此提供额外监督信号,该过程如下图所示:

虽然这些基于图数据增强的方法取得了令人瞩目的性能提升,但隐藏在提升背后的真正原因并未被挖掘,即对比学习为什么会提升推荐性能,以及数据增强是否真的必要?

回顾基于对比学习的图推荐系统

一般地,基于对比学习的图推荐系统通过构造两个不同的图视角,并计算跨视角的对比损失以向主推荐任务提供额外的监督信号,这样的对比损失定义如下:

其中 和

和 是在不同图视角里学习得到的嵌入表示,

是在不同图视角里学习得到的嵌入表示, 是温度系数。具体来说,对比损失鼓励同一节点的两个视角的一致性,同时让负样本节点在特征空间里远离正样本节点。不失一般性,在不同视角里的嵌入表示通常是利用LightGCN进行学习。

是温度系数。具体来说,对比损失鼓励同一节点的两个视角的一致性,同时让负样本节点在特征空间里远离正样本节点。不失一般性,在不同视角里的嵌入表示通常是利用LightGCN进行学习。

很显然,为了执行该对比损失,数据增强环节必不可少,这包含一系列复杂且耗时的矩阵运算。为了进一步分析对比损失,作者为SGL构造了一个变体,称为SGL-WA(WA代表without augmentation,即不进行数据增强),其对应的对比损失定义为:

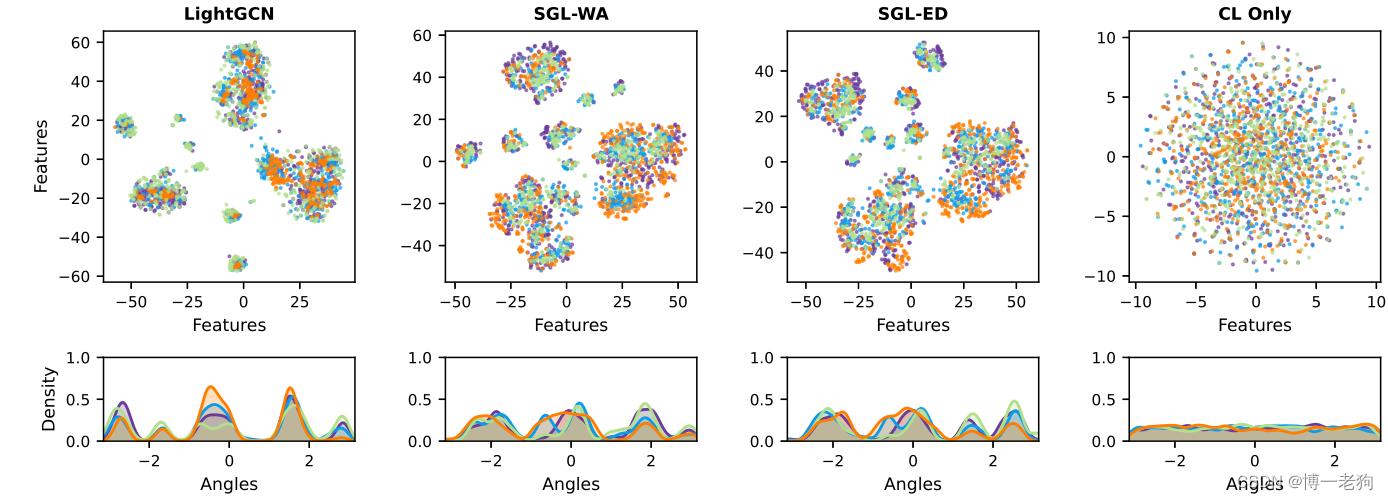

作者在Yelp2018和Amazon-Book数据集上将SGL-WA与LightGCN和SGL的三种数据增强方法(分别为SGL-ND,SGL-ED和SGL-WA)进行了对比实验,结果如下表所示:

其中CL Only代表只最小化SGL中的对比损失。实验结果表明所有SGL的变体均优于没有应用对比学习的LightGCN,这展示了对比学习的有效性。另一方面,移除数据增强后,SGL-WA的性能和SGL-ED仍然具有可比性,这一结果反映出一个结论:影响性能的核心是对比损失本身,而非数据增强。

基于此,作者进一步给出了将学习到的嵌入表示映射至超球面上的2维向量的t-SNE图 ,随后用非参数高斯核密度估计绘制特征分布 。简单来说,映射的嵌入表示在超球面越接近圆环,或者特征分布越平滑,则代表该分布越接近均匀分布。从上图可以清晰地看出LightGCN表现出明显的聚类效应,而后续几个利用对比学习的方法的分布则更接近于均匀分布。

LightGCN作为一种基于信息传播和信息聚合的图推荐范式,随着图卷积层的变多,节点之间的相似性开始变大,并且趋向于高度流行的物品,从而加剧流行度偏差问题(popularity bias),这一问题在使用基于BPR损失的优化措施的情况下变得更为严重,推荐模型的训练梯度会大幅偏向于热门物品。

在XSimGCL论文中,作者则给出更为清晰的分析。具体来说,随机选择用户绘制t-SNE图的策略转变为绘制流行/冷启动用户和物品的t-SNE图,如下所示:

一个清晰的发现是活跃用户和热门物品具有相似分布,同时冷启动用户同样贴近于热门物品,于此同时冷启动物品则“无人问津”,独自形成一种分布。这一结果更加凸显出LightGCN会倾向于推荐热门物品的偏向性,从而导致长尾物品无法被推荐。

对于SGL-WA,可将其对比损失进行改写:

可以看出优化对比损失的本质是最小化不同节点嵌入之间的相似性(通常通过内积计算),这会使节点在特征空间里相互远离,从而形成均匀分布。至此,可以得出结论:分布的均匀性(uniformity)是SGL的推荐性能得到提升的核心因素,而不是冗余的数据增强。至此,则又有一个新的问题,即如何在不进行数据增强的前提下进行高效的对比学习?

SimGCL

由于操纵图结构来实现均匀的表示分布是费时且棘手的,所以可以从嵌入空间的视角重新考虑。具体来说,可以向嵌入表示直接添加随机噪声以实现数据增强:

其中添加的噪声变量满足 ,并且有

,并且有

该过程如下图所示,通过向原始表示增加随机噪声向量,原始表示通过两个很小的角度进行旋转:

由于旋转足够小,增强后的嵌入表示依然保留着大部分原始信息。

与SGL一致,SimGCL同样采用LightGCN作为GNN模型。在每个图卷积层,不同的噪声向量均被加入目前的节点嵌入:

其中

XSimGCL

相比于SGL,SimGCL更为轻量级,因为其无需额外的数据增强操作。然而,SimGCL仍然受限于对比学习辅助任务,这使得其训练过程变得冗余。在每次迭代中,其都需要计算三次图卷积才能获得损失并反向传播。基于此,作者采用了跨层对比(cross-layer contrast)的思想,如下图所示:

可以看出XSimGCL将辅助的对比学习任务融于主推荐任务中,并且采用跨层对比来计算对比损失:

其中 表示与最终层进行对比的指定层数。

表示与最终层进行对比的指定层数。

时间复杂度

下表给出了LightGCN、SGL、SimGCL和XSimGCL的时间复杂度对比:

其中 是交互图的边数,

是交互图的边数, 是嵌入大小,

是嵌入大小, 是批大小,

是批大小, 表示每个批次中用户个数,

表示每个批次中用户个数, 表示GCN层数,

表示GCN层数, 表示SGL-ED的边保留比率。

表示SGL-ED的边保留比率。

从上表可以看出,在移除了数据增强操作后,SimGCL和XSimGCL的时间复杂度显著降低。由于SGL-ED和LightGCN需要分别完成主任务和辅助任务,这使得SGL-ED和SimGCL在图卷积过程中的时间复杂度为LightGCN的3倍,而XSimGCL与LightGCN的时间复杂度一致。

实验

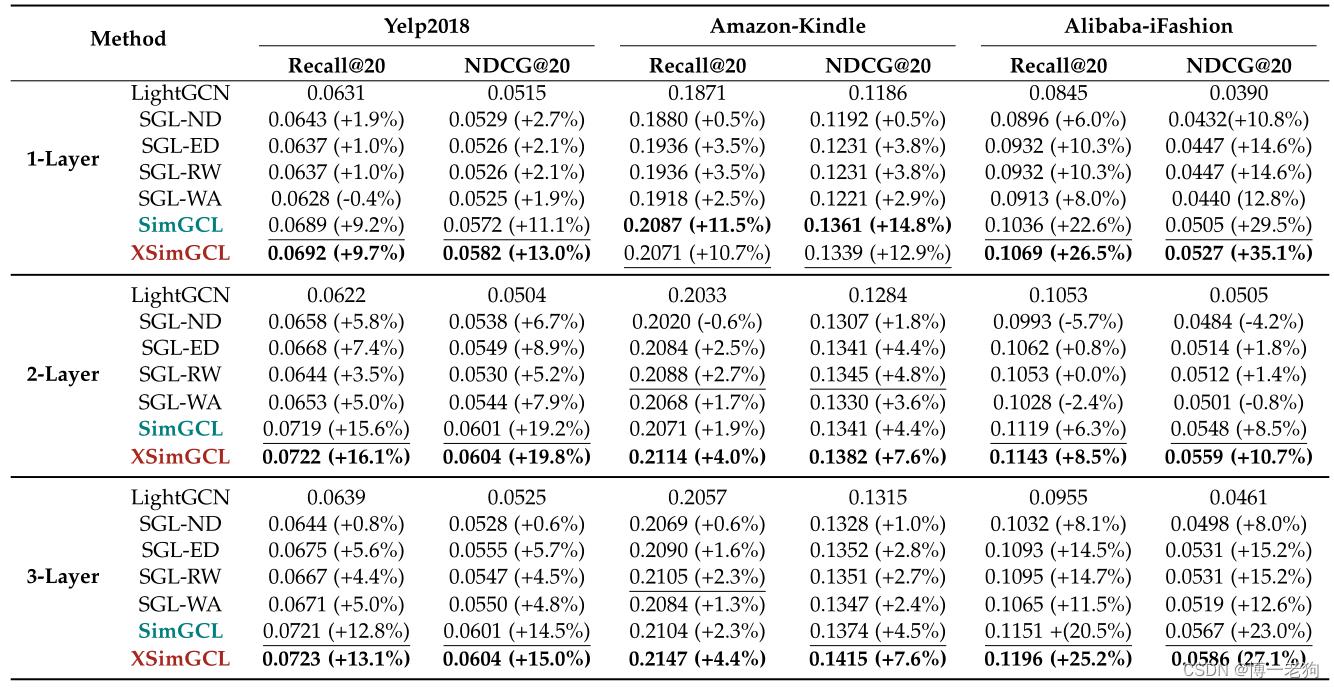

SimGCL和XSimGCL在推荐任务上的性能表现如下表所示:

除去性能方面,下图给出了LightGCN、SGL、SimGCL和XSimGCL的训练效率对比:

上图可以看出虽然基于对比学习的方法在每次迭代所需要的时间增加,但只需要非常少的epoch进行收敛,这使得基于对比学习的方法的总训练用时远低于LightGCN。XSimGCL通过融合推荐任务和对比任务,使得在保持良好性能的同时进一步降低了时间开销。

另一个值得关注的实验是XSimGCL中提出跨层对比的思想,用于对比的层数作为一个超参数。不同层数对于性能的影响如下图所示:

可以发现虽然不同数据集的层数选择不尽相同,但都不约而同地均是与最后一层的输出性能进行对比的性能最好。作者表示在3层LightGCN的基础上进行调整层数的调参次数是可以接受的。

SIGIR2020推荐系统论文聚焦

目录

-

前言 -

推荐论文列表

前言

第43届国际信息检索研究和发展大会(SIGIR)将于2020年7月25-30日在美丽的中国西安举行。此次大会共收到了555篇长文投稿,录用147篇,长文录取率26.4%;共收到了507篇短文投稿,录用153篇,短文录取率30%。

正因为推荐与搜索是解决信息过载的两种有效途径,因此虽然是关于检索的会议,但通过下图可以看出推荐(Recommendation)占据了很大比例,与搜索(Search+Retrieval)不相上下。另外,图与网络(Graph/Network)数据成为研究的主要对象,毕竟许多待研究的对象都可以表示为图。值得注意的是,神经网络(Neural)仍然排在前列;融合知识(Knowledge)的搜索/推荐系统也被许多研究者研究。除此之外,强化学习也出现在了排行榜中,可见利用强化学习的思想来迭代优化搜索/推荐逐渐成为流行。

推荐论文列表

本次只对大会的长文(Full Papers)进行梳理,因此共整理出63篇关于推荐系统的论文。为了方便查看与了解,我们主要将其分为了以下几类:Sequential RS,Graph-based RS,Cold-start in RS,Efficient RS,Knowledge-aware RS,Robust RS,Group RS,Conversational RS,RL for RS,Cross-domain RS,Explainable RS,POI RS。另外,对于有一些不包含在以上类别的文章,我们统一归为了Others。当然,以上分类仁者见仁,智者见智,目的是给大家一个相对清晰的结构。具体的各个类别所包含的论文数见下表。

| 分类 | 数量 |

|---|---|

| Sequential RS | 8 |

| Graph-based RS | 6 |

| Robust RS |

6 |

| Efficient RS | 5 |

| Knowledge-aware RS | 5 |

| Cold-start in RS |

4 |

| Group RS |

4 |

| Conversational RS |

4 |

| RL for RS |

3 |

| Cross-domain RS |

2 |

| Explainable RS |

2 |

| POI RS |

1 |

| Others |

13 |

可见,序列化推荐的文章占比较大;随后是基于图的推荐、鲁棒的推荐系统;其次是提升推荐效率的文章、基于知识的推荐以及解决冷启动问题的推荐文章、组推荐、对话推荐系统;最后是强化学习推荐、跨域推荐、可解释推荐以及兴趣点推荐。当然其他类别中也包含了许多有意思的研究,比如消除推荐偏置(Bias)的文章、分布式训练推荐系统的文章以及如何retrain推荐系统的文章等。

接下来是分类好的推荐论文列表,大家可以根据自己的研究子方向进行精读。

Sequential RS

Incorporating User Micro-behaviors and Item Knowledge into Multi-task Learning for Session-based Recommendation.

-

GAG: Global Attributed Graph Neural Network for Streaming Session-based Recommendation.

-

Sequential Recommendation with Self-attentive Multi-adversarial Network.

-

A General Network Compression Framework for Sequential Recommender Systems.

-

Next-item Recommendation with Sequential Hypergraphs.

-

KERL: A Knowledge-Guided Reinforcement Learning Model for Sequential Recommendation.

-

Time Matters: Sequential Recommendation with Complex Temporal Information.

-

Modeling Personalized Item Frequency Information for Next-basket Recommendation.

Graph-based RS

-

Learning to Transfer Graph Embeddings for Inductive Graph based Recommendation.

-

Joint Item Recommendation and Attribute Inference: An Adaptive Graph Convolutional Network Approach.

-

Multi-behavior Recommendation with Graph Convolution Networks.

-

Hierarchical Fashion Graph Network for Personalised Outfit Recommendation.

-

Neighbor Interaction Aware Graph Convolution Networks for Recommendation.

-

Disentangled Representations for Graph-based Collaborative Filtering.

Cold-start RS

-

Content-aware Neural Hashing for Cold-start Recommendation.

-

Recommending Podcasts for Cold-Start Users Based on Music Listening and Taste.

-

Recommendation for New Users and New Items via Randomized Training and Mixture-of-Experts Transformation.

-

AR-CF: Augmenting Virtual Users and Items in Collaborative Filtering for Addressing Cold-Start Problems.

Efficient RS

-

Lightening Graph Convolution Network for Recommendation.

-

A General Knowledge Distillation Framework for Counterfactual Recommendation via Uniform Data.

-

Beyond User Embedding Matrix: Learning to Hash for Modeling Large-Scale Users in Recommendation.

-

Parameter-Efficient Transfer from Sequential Behaviors for User Modeling and Recommendation.

-

Online Collective Matrix Factorization Hashing for Large-Scale Cross-Media Retrieval.

Knowledge-aware RS

-

Jointly Non-Sampling Learning for Knowledge Graph Enhanced Recommendation.

-

Fairness-Aware Explainable Recommendation over Knowledge Graphs.

-

Attentional Graph Convolutional Networks for Knowledge Concept Recommendation in MOOCs in a Heterogeneous View.

-

Make It a CHORUS: Context- and Knowledge-aware Item Modeling for Recommendation.

-

CKAN: Collaborative Knowledge-aware Attentive Network for Recommender Systems.

Robust RS

-

How Dataset Characteristics Affect the Robustness of Collaborative Recommendation Models.

-

GCN-Based User Representation Learning for Unifying Robust Recommendation and Fraudster Identification.

-

How Dataset Characteristics Affect the Robustness of Collaborative Recommendation Models.

-

Certifiable Robustness to Discrete Adversarial Perturbations for Factorization Machines.

-

DPLCF: Differentially Private Local Collaborative Filtering.

-

Data Poisoning Attacks against Differentially Private Recommender Systems.

Group RS

-

GAME: Learning Graphical and Attentive Multi-view Embeddings for Occasional Group Recommendation.

-

GroupIM: A Mutual Information Maximizing Framework for Neural Group Recommendation.

-

Group-Aware Long- and Short-Term Graph Representation Learning for Sequential Group Recommendation.

-

Global Context Enhanced Graph Nerual Networks for Session-based Recommendation.

Conversational RS

-

Deep Critiquing for VAE-based Recommender Systems.

-

Interactive Recommender System via Knowledge Graph-enhanced Reinforcement Learning.

-

Towards Question-based Recommender Systems.

-

Neural Interactive Collaborative Filtering.

RL for RS

-

Self-Supervised Reinforcement Learning for Recommender Systems.

-

MaHRL: Multi-goals Abstraction based Deep Hierarchical Reinforcement Learning for Recommendations.

-

Leveraging Demonstrations for Reinforcement Recommendation Reasoning over Knowledge Graphs.

Cross-domain RS

-

Transfer Learning via Contextual Invariants for One-to-Many Cross-Domain Recommendation.

-

CATN: Cross-Domain Recommendation for Cold-Start Users via Aspect Transfer Network.

Explainable RS

-

Measuring Recommendation Explanation Quality: The Conflicting Goals of Explanations.

-

Try This Instead: Personalized and Interpretable Substitute Recommendation.

POI RS

-

HME: A Hyperbolic Metric Embedding Approach for Next-POI Recommendation.

Others

-

Learning Personalized Risk Preferences for Recommendation.

-

Octopus: Comprehensive and Elastic User Representation for the Generation of Recommendation Candidates.

-

Spatial Object Recommendation with Hints: When Spatial Granularity Matters.

-

Agreement and Disagreement between True and False-Positive Metrics in Recommender Systems Evaluation.

-

Distributed Equivalent Substitution Training for Large-Scale Recommender Systems.

-

The Impact of More Transparent Interfaces on Behavior in Personalized Recommendation.

-

MVIN: Learning multiview items for recommendation.

-

How to Retrain a Recommender System?

-

Measuring and Mitigating Item Under-Recommendation Bias in Personalized Ranking Systems.

-

BiANE: Bipartite Attributed Network Embedding.

-

ASiNE: Adversarial Signed Network Embedding.

-

Learning Dynamic Node Representations with Graph Neural Networks.

-

Asymmetric Tri-training for Debiasing Missing-Not-At-Random Explicit Feedback.

以上是关于[SIGIR‘22]图对比推荐论文SimGCL/XSimGCL算法和代码简介的主要内容,如果未能解决你的问题,请参考以下文章