过年刷千言数据集:文本相似度比赛

Posted yealxxy

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了过年刷千言数据集:文本相似度比赛相关的知识,希望对你有一定的参考价值。

过年刷千言数据集:文本相似度数据集

1.比赛信息

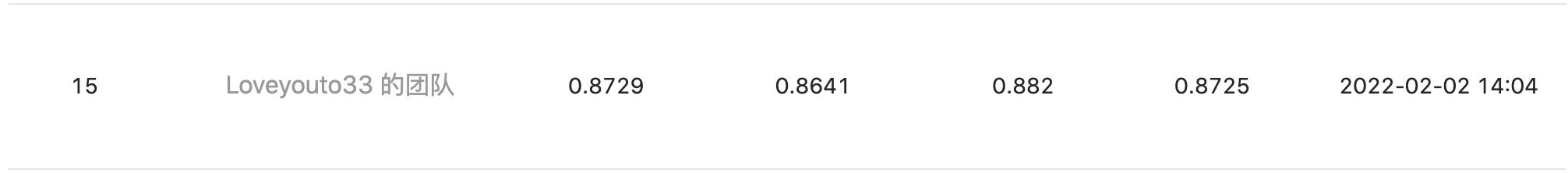

“千言数据集:文本相似度” 是网易易智在 CCF 和百度联合举办的行业测评任务,这个榜单在2021年出提出。刚好过年有时间刷一下这个任务,由于时间有限,且已经有相当多的提交,最后在假期结束取得15/2000的成绩。

代码地址:https://github.com/xxyliuyang/qianyan_similarity

依赖: allennlp2.0.1、transfomers4.1.0、torch==1.7.1

2. 数据集介绍

具体数据来源查看官网数据介绍,这里介绍三个数据比较大的问题:千言数据集:文本相似度述

- 问题一:领域数据:BQ Corpus是金融领域相关的数据。

- 问题二:文本质量: PAWS-X的输入文本质量不高,存在很多中英混合句子,英文大部分是英文实体词汇。

- 问题三:label质量:观察部分数据,标签存在标注错误的情况。

3. 模型细节

3.1 数据增强:

交换句子度,将训练数据翻倍。

3.2 模型:

bert构建句子对模型,使用[CLS]的输出的向量做二分类。

3.3 训练:

使用R-drop正则方法,其训练逻辑类似于对抗训练。

3.4 模型融合:

使用robert,albet,macbert分别训练,然后将输出的概率求平均。

其他:可以提高的点 或者 没有用尝试。

还有很多方法没有尝试,读者可以自行尝试,进入前十还是不难。

1.领域数据进一步预训练。

条件是可以获取或者爬取相关领域的文本。

2.半监督训练(self-training的思想):

条件是获取相关数据。

3. simCSE的训练:

尝试simCSE的训练,但是没有收益,猜测是因为simCSE提高句子embedding的方法,然而这个任务是句子对的任务,两个任务的出发点有区别。如果有更好的解释,欢迎评论。

4.stacking模型融合:

更好的融合模型可以提高效果

以上是关于过年刷千言数据集:文本相似度比赛的主要内容,如果未能解决你的问题,请参考以下文章