PyTroch笔记 - 多GPU分布式训练

Posted SpikeKing

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了PyTroch笔记 - 多GPU分布式训练相关的知识,希望对你有一定的参考价值。

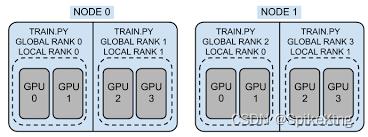

- Distributed Data-Parallel Training,DDP,分布式数据并行训练

- torch.nn.parallel.DistributedDataParallel

- RPC-Based Distributed Training,RPC,基于RPC的分布式训练

- Collective Communication,协同通信

不要把张量当入日志中输出,使用“.item()”转换为python的数据类型

logging.warning(f"epoch_index:

epoch_index, batch_index: 以上是关于PyTroch笔记 - 多GPU分布式训练的主要内容,如果未能解决你的问题,请参考以下文章

DistributedDataParallel多GPU分布式训练全过程总结 跟着做90%成功

『TensorFlow』分布式训练_其二_多GPU并行demo分析(待续)