nginx 的 负载均衡

Posted 风止雨歇

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了nginx 的 负载均衡相关的知识,希望对你有一定的参考价值。

一、正向代理和反向代理

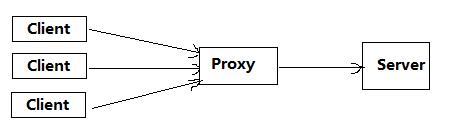

1、正向代理

正向代理类似一个跳板机,代理访问外部资源。

正向代理是客户端和目标服务器之间的代理服务器(中间服务器)。为了从指定的服务器取得内容,客户端向代理服务器发送一个请求,并且指定目标服务器,之后代理向目标服务器转交并且将获得的内容返回给客户端。正向代理的情况下客户端必须要进行一些特别的设置才能使用。

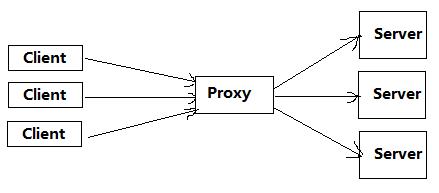

2、反向代理

反向代理(Reverse Proxy)实际运行方式是指以代理服务器来接受internet上的连接请求,然后将请求转发给内部网络上的服务器,并将从服务器上得到的结果返回给internet上请求连接的客户端,此时代理服务器对外就表现为一个服务器。

3、正向代理和反向代理的区别

正向代理是代理客户端,为客户端收发请求,使真实客户端对服务器不可见;而反向代理是代理服务器端,为服务器收发请求,使真实服务器对客户端不可见。

(1)从上面的描述也能看得出来正向代理和反向代理最关键的两点区别:

- 是否指定目标服务器

-

客户端是否要做设置

(2)从用途上来区分:

- 正向代理:正向代理用途是为了在防火墙内的局域网提供访问internet的途径。另外还可以使用缓冲特性减少网络使用率

- 反向代理:反向代理的用途是将防火墙后面的服务器提供给internet用户访问。同时还可以完成诸如负载均衡等功能

(3)从安全性来讲:

- 正向代理:正向代理允许客户端通过它访问任意网站并且隐蔽客户端自身,因此你必须采取安全措施来确保仅为经过授权的客户端提供服务

- 反向代理:对外是透明的,访问者并不知道自己访问的是代理。对访问者而言,他以为访问的就是原始服务器。

二、负载均衡(反向代理负载均衡)

1、负载均衡的介绍

通常通过负载均衡的方式来分担服务器的压力。那么什么是负载均衡呢?

我们可以建立很多个服务器,这些服务器组成一个服务器集群,然后,当用户访问我们网站的时候,先访问一个中间服务器,再让这个中间服务器在服务器集群中选择一个压力较小的服务器,然后将该访问请求引入该选择的服务器。这样用户的每次访问,都会保证服务器集群中的每个服务器的压力趋于平衡,分担了服务器压力,避免了服务器的崩溃。

nginx是一款可以通过反向代理实现负载均衡的服务器,使用Nginx服务实现负载均衡的时候,用户的访问首先会访问到Nginx服务器,

然后Nginx服务器再从服务器集群中选择压力较小的服务器,然后将该访问请求引向该服务器。若服务器集群中的某个服务器崩溃,那么从待选服务器列表中将该服务器删除,也就是说Nginx就肯定不会将访问请求引入该服务器了。

2、Nginx的属性

# 运行用户

user www-data;

# 启动进程,通常设置成和cpu的数量相等

worker_processes 1;

# 全局错误日志及PID文件

error_log /var/log/nginx/error.log;

pid /var/run/nginx.pid;

# 工作模式及连接数上限

events {

use epoll; #epoll是多路复用IO(I/O Multiplexing)中的一种方式,但是仅用于linux2.6以上内核,可以大大提高nginx的性能

worker_connections 1024; #单个后台worker process进程的最大并发链接数

# multi_accept on;

}

#设定http服务器,利用它的反向代理功能提供负载均衡支持

http {

#设定mime类型,类型由mime.type文件定义

include /etc/nginx/mime.types;

default_type application/octet-stream;

#设定日志格式

access_log /var/log/nginx/access.log;

#sendfile 指令指定 nginx 是否调用 sendfile 函数(zero copy 方式)来输出文件,对于普通应用,

#必须设为 on,如果用来进行下载等应用磁盘IO重负载应用,可设置为 off,以平衡磁盘与网络I/O处理速度,降低系统的uptime.

sendfile on;

#将tcp_nopush和tcp_nodelay两个指令设置为on用于防止网络阻塞

tcp_nopush on;

tcp_nodelay on;

#连接超时时间

keepalive_timeout 65;

#开启gzip压缩

gzip on;

gzip_disable "MSIE [1-6]\\.(?!.*SV1)";

#设定请求缓冲

client_header_buffer_size 1k;

large_client_header_buffers 4 4k;

include /etc/nginx/conf.d/*.conf;

include /etc/nginx/sites-enabled/*;

#设定负载均衡的服务器列表

upstream mysvr {

#weigth参数表示权值,权值越高被分配到的几率越大

#本机上的Squid开启3128端口

server 192.168.8.1:3128 weight=5;

server 192.168.8.2:80 weight=1;

server 192.168.8.3:80 weight=6;

}

server {

#侦听80端口

listen 80;

#定义使用www.xx.com访问

server_name www.xx.com;

#设定本虚拟主机的访问日志

access_log logs/www.xx.com.access.log main;

#默认请求

location / {

root /root; #定义服务器的默认网站根目录位置

index index.php index.html index.htm; #定义首页索引文件的名称

fastcgi_pass www.xx.com;

fastcgi_param SCRIPT_FILENAME $document_root/$fastcgi_script_name;

include /etc/nginx/fastcgi_params;

}

# 定义错误提示页面

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root /root;

}

#静态文件,nginx自己处理

location ~ ^/(images|javascript|js|css|flash|media|static)/ {

root /var/www/virtual/htdocs;

#过期30天,静态文件不怎么更新,过期可以设大一点,如果频繁更新,则可以设置得小一点。

expires 30d;

}

#PHP 脚本请求全部转发到 FastCGI处理. 使用FastCGI默认配置.

location ~ \\.php$ {

root /root;

fastcgi_pass 127.0.0.1:9000;

fastcgi_index index.php;

fastcgi_param SCRIPT_FILENAME /home/www/www$fastcgi_script_name;

include fastcgi_params;

}

#设定查看Nginx状态的地址

location /NginxStatus {

stub_status on;

access_log on;

auth_basic "NginxStatus";

auth_basic_user_file conf/htpasswd;

}

#禁止访问 .htxxx 文件

location ~ /\\.ht {

deny all;

}

}

#第一个虚拟服务器

server {

#侦听192.168.8.x的80端口

listen 80;

server_name 192.168.8.x;

#对aspx后缀的进行负载均衡请求

location ~ .*\\.aspx$ {

root /root;#定义服务器的默认网站根目录位置

index index.php index.html index.htm;#定义首页索引文件的名称

proxy_pass http://mysvr;#请求转向mysvr 定义的服务器列表

#以下是一些反向代理的配置可删除.

proxy_redirect off;

#后端的Web服务器可以通过X-Forwarded-For获取用户真实IP

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

client_max_body_size 10m; #允许客户端请求的最大单文件字节数

client_body_buffer_size 128k; #缓冲区代理缓冲用户端请求的最大字节数,

proxy_connect_timeout 90; #nginx跟后端服务器连接超时时间(代理连接超时)

proxy_send_timeout 90; #后端服务器数据回传时间(代理发送超时)

proxy_read_timeout 90; #连接成功后,后端服务器响应时间(代理接收超时)

proxy_buffer_size 4k; #设置代理服务器(nginx)保存用户头信息的缓冲区大小

proxy_buffers 4 32k; #proxy_buffers缓冲区,网页平均在32k以下的话,这样设置

proxy_busy_buffers_size 64k; #高负荷下缓冲大小(proxy_buffers*2)

proxy_temp_file_write_size 64k; #设定缓存文件夹大小,大于这个值,将从upstream服务器传

}

}

}

3、负载均衡的配置

(1)nginx的负载均衡----轮询策略配置(默认)

每个请求按时间顺序逐一分配到不同的后端服务器,如果后端服务器down掉,能自动剔除。

同样使用两个tomcat模拟两台应用服务器,端口号分别为8080 和8081(tomcat 的 conf/server.xml 文件中修改端口号);

为了区别两个tomcat,将 tomcat 的 webapps/ROOT/ 目录下的 index.html 或 index.jsp 内容分别修改为 tomcat-8080、tomcat-8081;

upstream myServer {

server 192.168.172.20:8080; #tomcat1

server 192.168.172.20:8081; #tomcat2

}

server {

listen 8100; #监听8100端口

server_name my_server1;

#charset koi8-r;

#access_log logs/host.access.log main;

location / {

proxy_pass http://myServer;

index index.html index.htm;

}

}

Nginx配置为以上信息,浏览器访问 http://192.168.172.20:8100(监听的8100端口),通过nginx反向代理服务器将请求转发给 192.168.172.20:8080 或 192.168.172.20:8081,默认为轮询策略,所以nginx将按照时间先后顺序逐一将请求转发到后端不同服务器。

(2)负载均衡----轮询策略配置

指定轮询几率,weight的值和访问对应服务的比率成正比,用于后端服务器性能不均的情况。

upstream myServer {

server 192.168.172.20:8080 weight=3;;

server 192.168.172.20:8081;

}

上述方式存在一个问题就是说,在负载均衡系统中,假如用户在某台服务器上登录了,那么该用户第二次请求的时候,因为我们是负载均衡系统,每次请求都会重新定位到服务器集群中的某一个,那么已经登录某一个服务器的用户再重新定位到另一个服务器,其登录信息将会丢失,这样显然是不妥的。

我们可以采用ip_hash指令解决这个问题,如果客户已经访问了某个服务器,当用户再次访问时,会将该请求通过哈希算法,自动定位到该服务器。

(3)负载均衡策略---- ip_hash

每个请求按访问ip的hash结果分配,这样每个访客固定访问一个后端服务器,可以解决session的问题。

upstream myServer {

ip_hash;

server 192.168.172.20:8080;

server 192.168.172.20:8081;

}

(4)负载均衡策略---- fair (第三方)

按后端服务器的响应时间来分配请求,响应时间短的优先分配。

upstream myServer {

fair;

server 192.168.172.20:8080;

server 192.168.172.20:8081;

}

(5)负载均衡策略---- url_hash (第三方)

按访问url的hash结果来分配请求,使每个url定向到同一个后端服务器,后端服务器为缓存时比较有效。

注意:在upstream中加入hash语句,server语句中不能写入weight等其他的参数,hash_method是使用的hash算法。

upstream myServer {

server 192.168.172.20:8080;

server 192.168.172.20:8081;

hash $request_uri;

hash_method crc32;

}

负载均衡的一些其他配置:

注意:在upstream中加入hash语句,server语句中不能写入weight等其他的参数。

upstream myServer {

server 192.168.172.20:8080 weight=2;;

server 192.168.172.20:8081 down;

server 192.168.172.20:8082;

server 192.168.172.20:8083 backup;

}

<1> down:表示当前的server暂时不参与负载;

<2> weight:默认为1.weight越大,负载的权重就越大;

<3> max_fails:许请求失败的次数默认为1.当超过最大次数时,返回proxy_next_upstream 模块定义的错误

<4> fail_timeout:max_fails 次失败后,暂停的时间。

<5> backup:其它所有的非backup机器down或者忙的时候,请求backup机器。所以这台机器压力会最轻。

以上是关于nginx 的 负载均衡的主要内容,如果未能解决你的问题,请参考以下文章