jieba库的使用

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了jieba库的使用相关的知识,希望对你有一定的参考价值。

参考技术A /jieba库是python中一个重要的第三方中文分词函数库.(这名字起的,我给作者满分)/jieba库的分词原理是利用一个中文词库,将待分词的内容与分词词库进行比对,通过 图结构 和 动态规划 方法找到最大的概率的词组.除了分词,jieba还提供了自定义中文单词的功能.(并不知道划线的两种方法是什么......)

/jieba库支持3种分词模式:

精确模式:将句子最精确的切开,适合文本分析.

全模式:把句子中所有可以成词的词语都扫描出来,速度快,但不能消除歧义.

搜索引擎模式:在精确模式的基础上,对长词再次切分,提高召回率,适合用于搜索引擎分词.

/jieba库常用的分词函数:

1. jieba.cut(s) :精确模式,返回一个可迭代的数据类型.

2. jieba.cut(s,cut_all=True) :全模式,输出文本s中所有可能的单词.

3. jieba.cut_for_search(s) :搜索引擎模式,适合搜索引擎建立索引的分词结果.

4. jieba.lcut(s) :精确模式,返回一个列表类型(建议使用).

5. jieba.lcut(s,cut_all=True) :全模式,返回一个列表类型(建议使用).

6. jieba.lcut_for_search(s) :搜索引擎模式,返回一个列表类型(建议使用).

7. jierba.add_word(w) :向分词词典中增加新词w.

jieba 库的使用和好玩的词云

jieba库的使用:

(1) jieba库是一款优秀的 Python 第三方中文分词库,jieba 支持三种分词模式:精确模式、全模式和搜索引擎模式,下面是三种模式的特点。

精确模式:试图将语句最精确的切分,不存在冗余数据,适合做文本分析

全模式:将语句中所有可能是词的词语都切分出来,速度很快,但是存在冗余数据

搜索引擎模式:在精确模式的基础上,对长词再次进行切分。

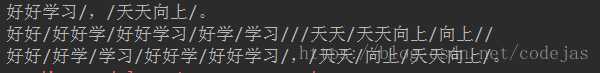

# -*- coding: utf-8 -*- import jieba seg_str = "好好学习,天天向上。" print("/".join(jieba.lcut(seg_str))) # 精简模式,返回一个列表类型的结果 print("/".join(jieba.lcut(seg_str, cut_all=True))) # 全模式,使用 ‘cut_all=True‘ 指定 print("/".join(jieba.lcut_for_search(seg_str))) # 搜索引擎模式

好玩的词云;

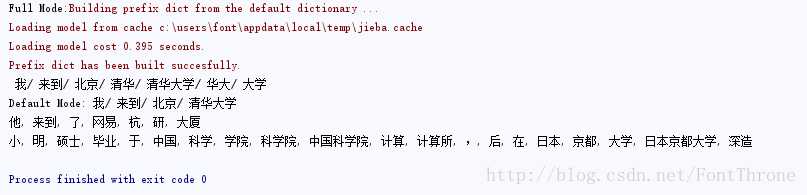

import jieba seg_list = jieba.cut("我来到北京清华大学", cut_all=True, HMM=False) print("Full Mode: " + "/ ".join(seg_list)) # 全模式 seg_list = jieba.cut("我来到北京清华大学", cut_all=False, HMM=True) print("Default Mode: " + "/ ".join(seg_list)) # 默认模式 seg_list = jieba.cut("他来到了网易杭研大厦", HMM=False) print(", ".join(seg_list)) seg_list = jieba.cut_for_search("小明硕士毕业于中国科学院计算所,后在日本京都大学深造", HMM=False) # 搜索引擎模式 print(", ".join(seg_list))

以上是关于jieba库的使用的主要内容,如果未能解决你的问题,请参考以下文章