flannel详解

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了flannel详解相关的知识,希望对你有一定的参考价值。

参考技术A 分flanneld和flannel cni两部分flanneld在k8s每个node上都运行一份

启动时创建本机的vxlan设备

负责监听k8s的node变化 并设置到其他node的路由。

flannel cni是个可执行文件,k8s配置好使用flannel,当k8s创建pod时就会调用flannel cni,flannel cni只是把配置翻译一下传给bridge cni。

bridge cni一样是个可执行文件,他主要工作是创建容器eth,并挂载cni0上,还可以设置容器网络空间的路由等功能,在flannel场景下,这些配置信息都来之flannel cni。

flanneld和flannel cni的分工不同,一个负责node之间的通信,一个负责容器在node内的通信(包括容器间和到vxlan设备的通信)。

或者按动态和静态的配置分也行,cni plugin负责静态配置,flanneld则需要监听配置变化,实现动态配置。

其余的k8s网络实现也是这么分工的,分cni plugin和node上运行的daemon,复杂点的自己再搞一套中控,配置些网络层面的功能,flannel的配置都是来自k8s,没有自己的中控。

Kubernetes二进制部署——Flannel网络

Kubernetes二进制部署——Flannel网络

一、Flannel简介

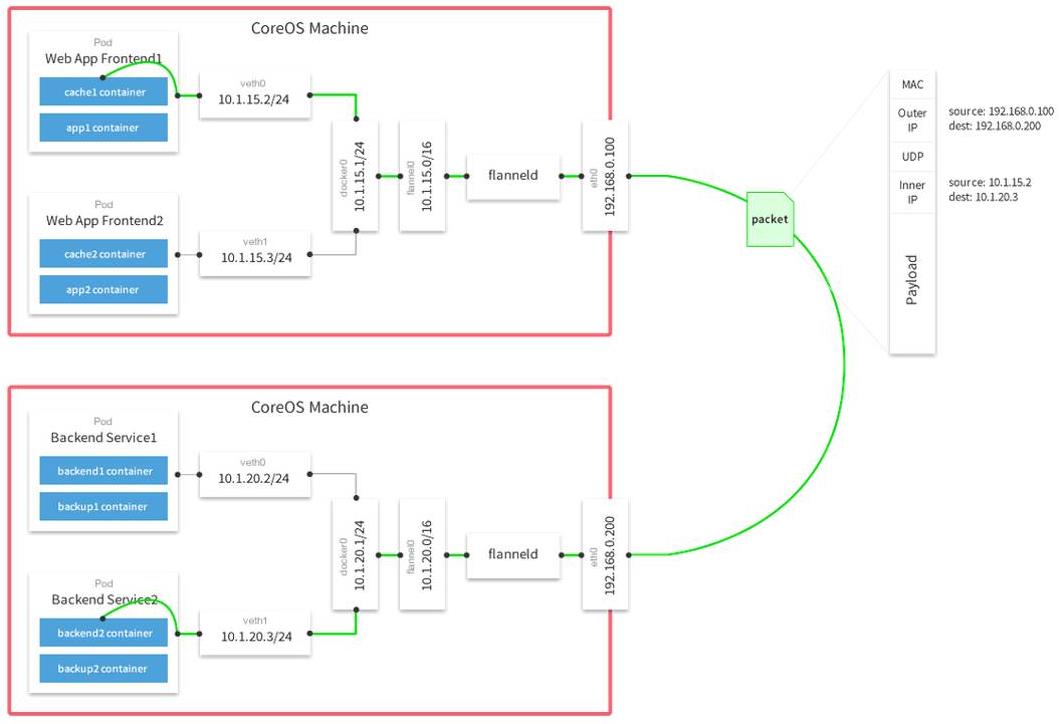

- Flannel是CoreOS团队针对Kubernetes设计的一个网络规划服务,简单来说,它的功能是让集群中的不同节点主机创建的Docker容器都具有全集群唯一的虚拟IP地址。

- 在默认的Docker配置中,每个节点上的Docker服务会分别负责所在节点容器的IP分配。这样导致的一个问题是,不同节点上容器可能获得相同的内外IP地址。并使这些容器之间能够之间通过IP地址相互找到,也就是相互ping通。

- Flannel的设计目的就是为集群中的所有节点重新规划IP地址的使用规则,从而使得不同节点上的容器能够获得同属一个内网且不重复的IP地址,并让属于不同节点上的容器能够直接通过内网IP通信。

- Flannel实质上是一种“覆盖网络(overlaynetwork)”,也就是将TCP数据包装在另一种网络包里面进行路由转发和通信,目前已经支持udp、vxlan、host-gw、aws-vpc、gce和alloc路由等数据转发方式,默认的节点间数据通信方式是UDP转发。

二、Flannel原理

- 首先,Flannel通过Kubernetes API把整个集群的网络配置存储在Etcd中,其中最主要的内容为设置集群的网络地址空间。例如,指定整个集群内所有容器的IP都取自“10.1.0.0/16”网段。

- 接着,Flannel在每个主机中运行flanneld作为agent,它会为所在主机从集群的网络地址空间中,获取一个小的网段subnet(子网),本主机内所有容器的IP地址都将从中分配。

- 然后,Flanneld再将本主机获取的subnet以及用于主机间通信的Public IP,同样通过Kubernetes API存储在Etcd中。

- 最后,Flannel利用各种数据转发方式,例如udp、vxlan、AWS、VPC和GCE路由等等,跨主机转发容器间的网络流量,完成容器间的跨主机通信。

- 首先,定义两个节点主机A POD-A 主机B POD-B

- POD-A首先会发送给docker 0网桥

docker 0会转发给flannel0网桥 - flannel0会转发给flanneld(后台进程),flanned会到ETCD中查看ETCD维护的路由表条目/信息,确认往哪去发送

- flanned 会在转发给宿主机的物理网卡

- 物理网卡会以UDP的方式转发数据包(数据包中除了主机A和主机B的源TP和目标IP之外,还会封装POD-A和POD-B的源/目标Ip)

- 主机B接收到

- 首先解封装,发现源IP地址是找自己的(主机IP地址)

- UDP 转发过来,解封装之后,发现了封装在UDP内部的POD IP(源/目标)

- 主机B的物理网卡就会发送给flanned进行处理

- 而flanned会查询ETCD中维护的路由表信息,发现是自己的pod (也能查询到找的docker-ip网段是什么网段)

- flanned会发送给自己的flannel0网桥,flannel网桥再发送给对应的docker (0)网桥

- docker 网桥(网关),会把这个数据包发送给对应的POD-B

三、Flannel的作用

- 使集群中的不同Node主机创建的Docker容器都具有全集群唯一的虚拟IP地址。

- 建立一个覆盖网络(overlay network),通过这个覆盖网络,将数据包原封不动的传递到目标容器。覆盖网络是建立在另一个网络之上并由其基础设施支持的虚拟网络。覆盖网络通过将一个分组封装在另一个分组内来将网络服务与底层基础设施分离。在将封装的数据包转发到端点后,将其解封装。

- 创建一个新的虚拟网卡flannel0接收docker网桥的数据,通过维护路由表,对接收到的数据进行封包和转发(vxlan)。

- etcd保证了所有node上flanned所看到的配置是一致的。同时每个node上的flanned监听etcd上的数据变化,实时感知集群中node的变化

- Overlay Network:覆盖网络,在基础网络上叠加的一种虚拟网络技术模式,该网络中的主机通过虚拟链路连接起来

- VXLAN:将源数据包封装到UDP中,并使用基础网络的IP/MAC作外层报文头进行封装,然后再以太网上传输,到达目的地后由隧道端点解封并将数据转发到目标地址

四、Flannel 网络配置

1.node 节点安装 docker

systemctl stop firewalld

systemctl disable firewalld

setenforce 0

yum install -y yum-utils device-mapper-persistent-data lvm2

yum-config-manager \\

--add-repo \\

https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

yum install -y docker-ce docker-ce-cli containerd.io

systemctl enable docker

systemctl start docker

'不要忘记配置镜像加速和优化网络'

vim /etc/sysctl.conf

net.ipv4.ip_forward= 1

service network restart

systemctl restart docker

2.master配置

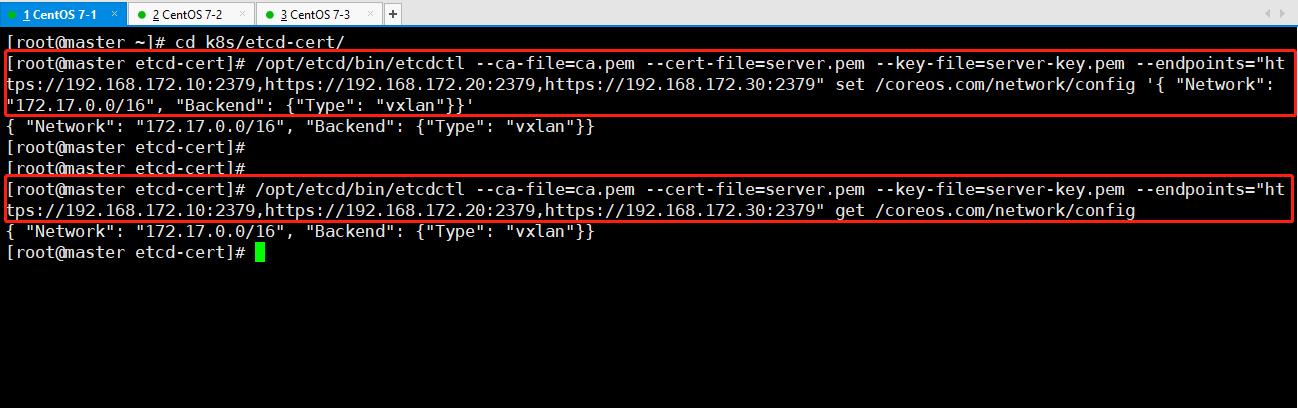

1、 写入分配的子网段到ETCD中,供flannel使用(master主机)

需要在有证书的目录下使用此命令

写入分配的子网段到ETCD中,供flannel使用

cd k8s/etcd-cert/

/opt/etcd/bin/etcdctl --ca-file=ca.pem --cert-file=server.pem --key-file=server-key.pem --endpoints="https://192.168.172.10:2379,https://192.168.172.20:2379,https://192.168.172.30:2379" set /coreos.com/network/config '{ "Network": "172.17.0.0/16", "Backend": {"Type": "vxlan"}}'

/opt/etcd/bin/etcdctl --ca-file=ca.pem --cert-file=server.pem --key-file=server-key.pem --endpoints="https://192.168.172.10:2379,https://192.168.172.20:2379,https://192.168.172.30:2379" get /coreos.com/network/config

get表示为查看,以下为反馈结果

命令简介:

#使用etcdctl命令,借助ca证书,目标端点为三个ETCD节点IP,端口为2379

# set /coreos.com/network/config 设置网段信息

#"Network": "172.17.0.0/16" 此网段必须是集合网段(B类地址),而Pod分配的资源必须在此网段中的子网段(C类地址)

#"Backend": {"Type": "vxlan"}} 外部通讯的类型是VXLAN

3、node节点操作

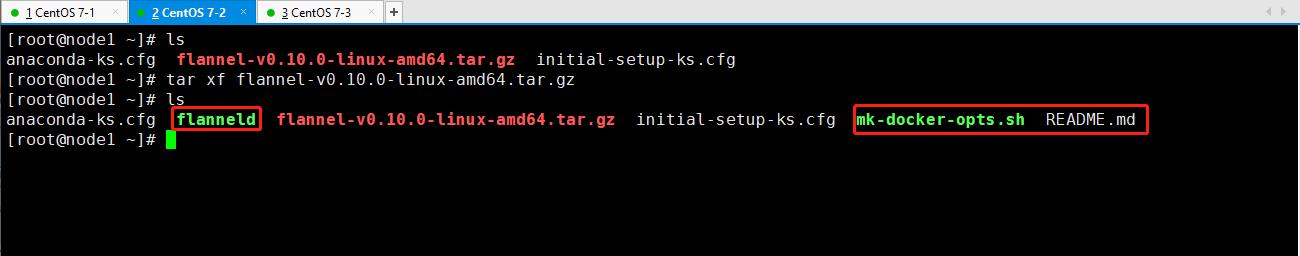

1、上传flannel软件包到所有的 node 节点并解压

拖入软件包并解压

--node1、2--

上传flannel-v0.10.0-linux-amd64.tar软件包至/opt目录下'

tar xf flannel-v0.10.0-linux-amd64.tar.gz

flanneld 服务启动脚本'

mk-docker-opts.sh 配合docker配置脚本'

README.md 说明文档'

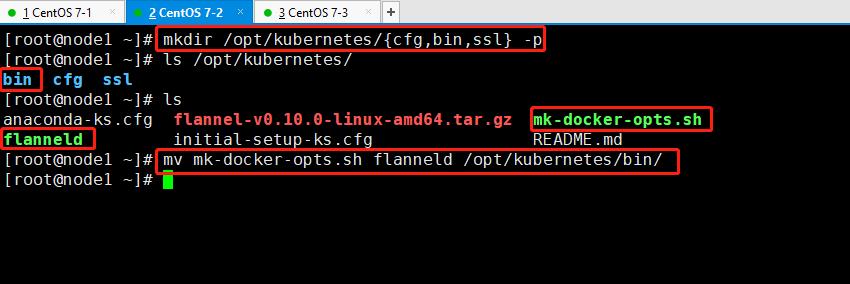

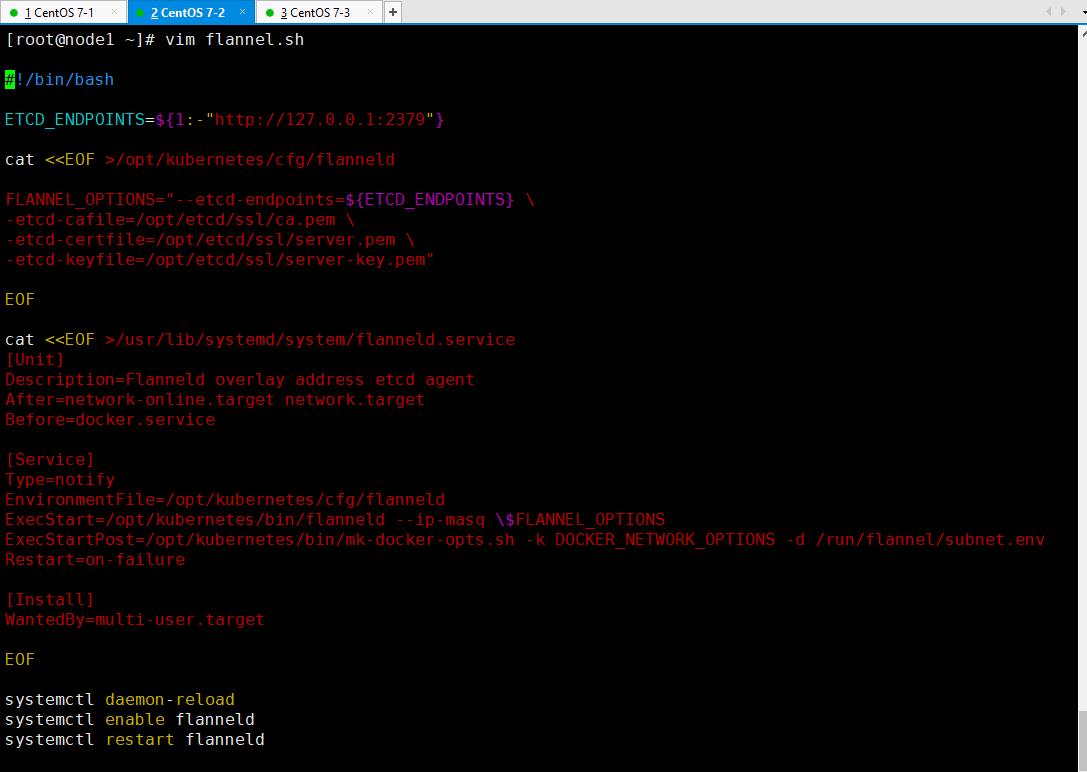

2、建立 K8S 工作目录并撰写 flannel.sh 服务启动脚本

--node1、2--

'//建立K8S工作目录,与前文ETCD同理,两个node节点同步操作'

mkdir /opt/kubernetes/{cfg,bin,ssl} -p

mv /opt/mk-docker-opts.sh /opt/flanneld /opt/kubernetes/bin/

'//撰写一个服务启动脚本'

vim /root/flannel.sh

#!/bin/bash

ETCD_ENDPOINTS=${1:-"http://127.0.0.1:2379"} '//定义访问地址(etcd)'

cat <<EOF >/opt/kubernetes/cfg/flanneld '//配置文件'

FLANNEL_OPTIONS="--etcd-endpoints=${ETCD_ENDPOINTS} \\ '//指向etcd的集群地址'

-etcd-cafile=/opt/etcd/ssl/ca.pem \\ '//etcd用到的证书(变量)'

-etcd-certfile=/opt/etcd/ssl/server.pem \\

-etcd-keyfile=/opt/etcd/ssl/server-key.pem"

EOF

cat <<EOF >/usr/lib/systemd/system/flanneld.service '//启动脚本'

[Unit]

Description=Flanneld overlay address etcd agent

After=network-online.target network.target '//借助于flanneld启动之前network网络功能必须具备'

Before=docker.service '//还依赖于docker'

[Service]

Type=notify '//触发调用'

EnvironmentFile=/opt/kubernetes/cfg/flanneld '//定义变量,指向配置文件'

ExecStart=/opt/kubernetes/bin/flanneld --ip-masq \\$FLANNEL_OPTIONS '//启动文件指定启动脚本,并指定集群变量IP'

ExecStartPost=/opt/kubernetes/bin/mk-docker-opts.sh -k DOCKER_NETWORK_OPTIONS -d /run/flannel/subnet.env

Restart=on-failure

[Install]

WantedBy=multi-user.target '//多用户登录模式'

EOF

systemctl daemon-reload

systemctl enable flanneld

systemctl restart flanneld

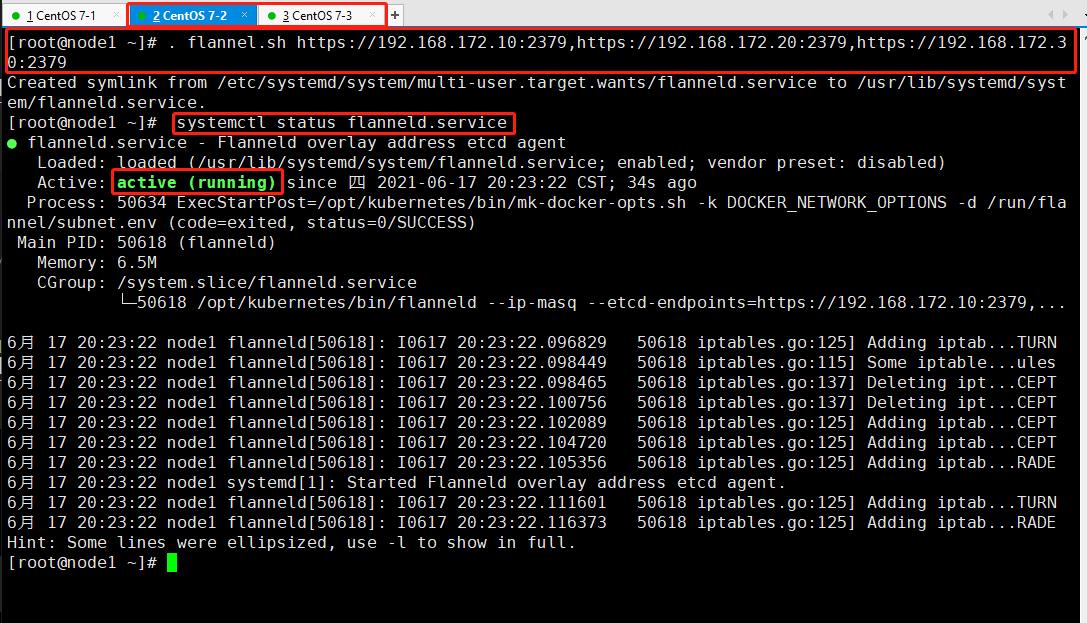

3、指定集群启动脚本并检查IP地址

--node1、2--

在/opt/目录下启动

. flannel.sh https://192.168.172.10:2379,https://192.168.172.20:2379,https://192.168.172.30:2379

systemctl status flanneld.service

'//服务启动成功'

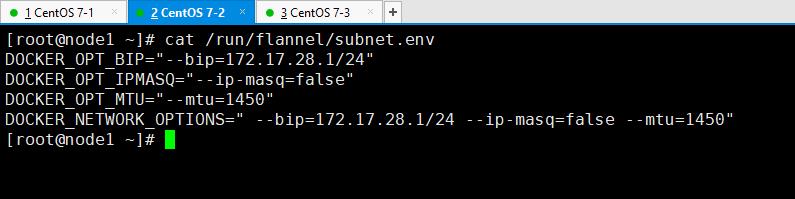

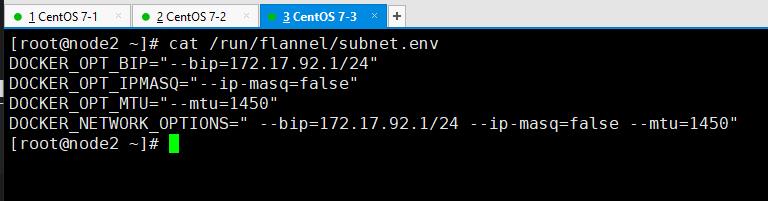

cat /run/flannel/subnet.env '//执行完flanneld启动脚本后会生成此文件:网段环境变量'

4、配置 docker 以能连接上 flannel

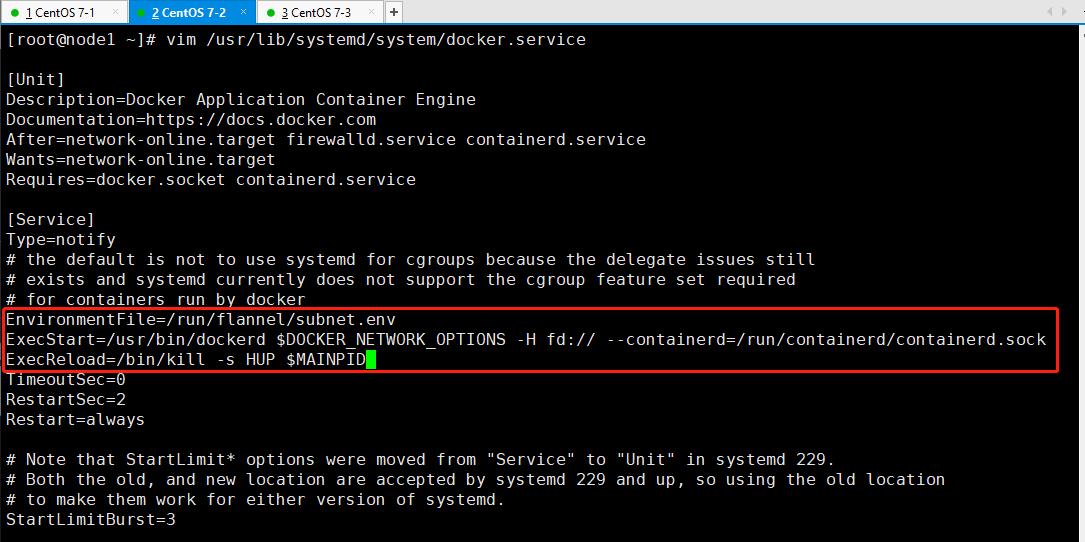

vim /usr/lib/systemd/system/docker.service

[Service]

Type=notify

# the default is not to use systemd for cgroups because the delegate issues still

# exists and systemd currently does not support the cgroup feature set required

# for containers run by docker

EnvironmentFile=/run/flannel/subnet.env

ExecStart=/usr/bin/dockerd $DOCKER_NETWORK_OPTIONS -H fd:// --containerd=/run/containerd/containerd.sock

ExecReload=/bin/kill -s HUP $MAINPID

TimeoutSec=0

RestartSec=2

Restart=always

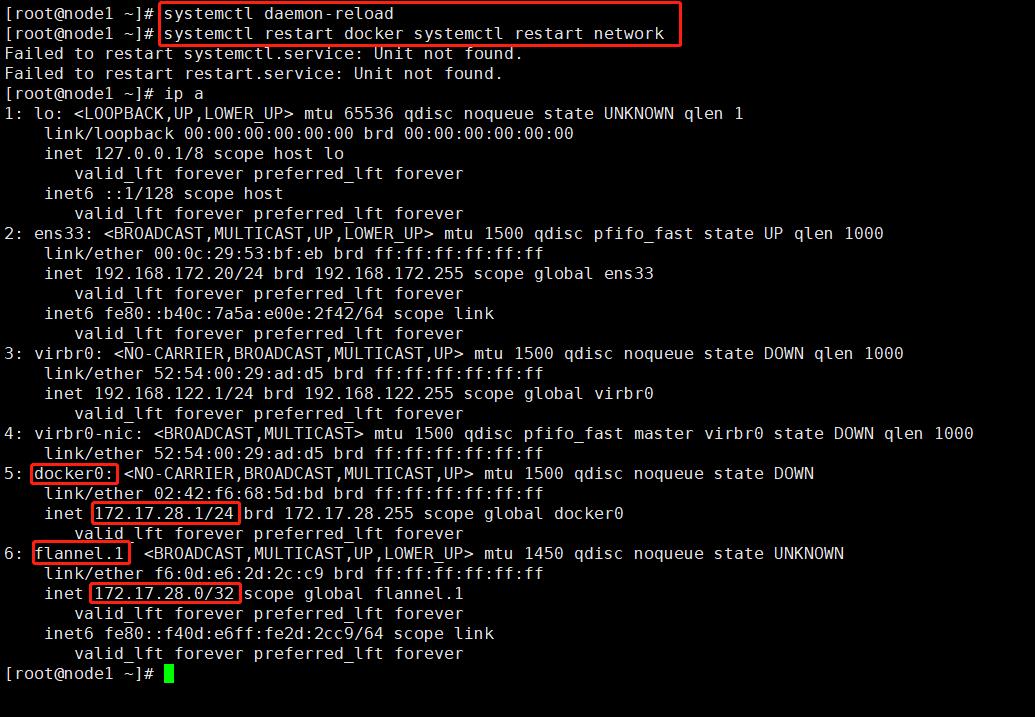

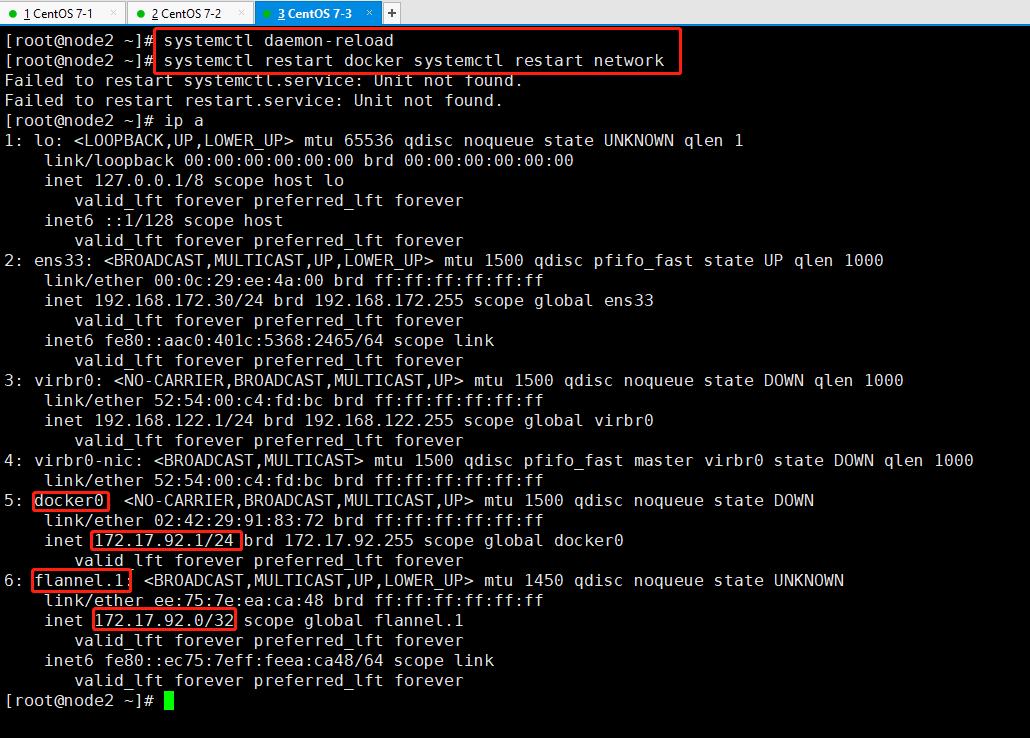

systemctl daemon-reload

systemctl restart docker systemctl restart network

'//更改完后两台node节点需重载配置文件、重启docker和网络服务,否则仍有可能docker和flannel连接不成功'

ip -a '//现在可以看到dokcer与flannel同一网段了'

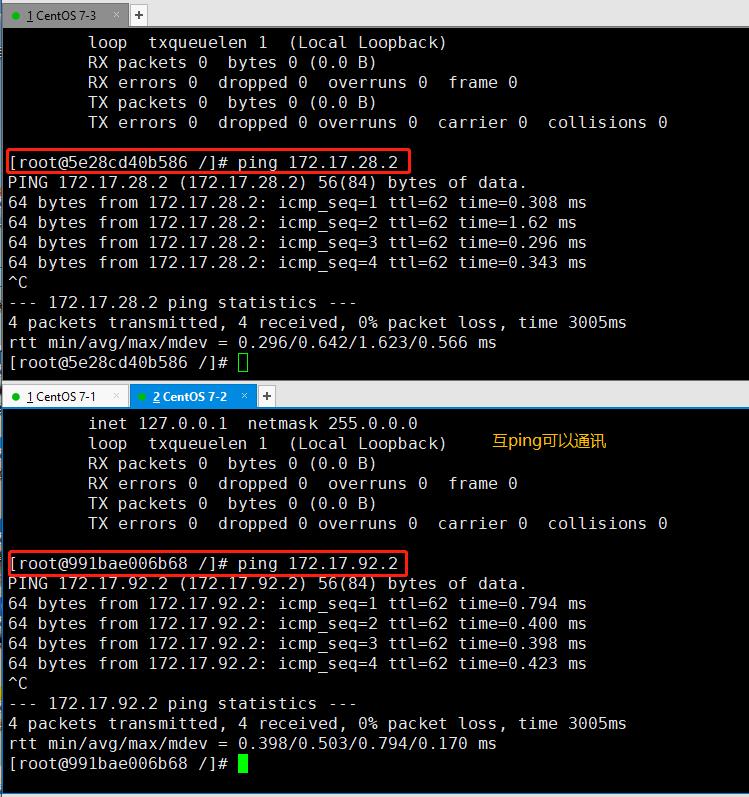

5、在两个 node 节点中创建容器互相 ping 以验证网络互通

--node1、2--

docker run -it centos:7 /bin/bash

'//运行一个centos容器,下一步互ping对方docker0网卡,以证明flannel起到路由作用'

yum install net-tools -y '//使用ifconfg需先安装网络工具'

ifconfig

docker run -it centos:7 /bin/bash

yum install net-tools -y

ifconfig

以上是关于flannel详解的主要内容,如果未能解决你的问题,请参考以下文章