学习任务单卡的代码怎么弄

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了学习任务单卡的代码怎么弄相关的知识,希望对你有一定的参考价值。

先F5存档2.输入“ ' ” (这个进入控制台的按键,有的人是按键1左边那个“~”,有的人可能是回车键左边那个,可能跟输入法有关)

3, 进入控制台后,输入 sqt,然后出现如下图代码,

根据我的观察这个任务号是和你任务列表里的顺序是一样的,找到任务代码(看current quest 前面的一串代码就是),埃默金的是MS09Mission02

4.任务代码找到后,就是确定任务完成度,需要输入player.sqs MS09Mission02 (player.sqs+空格+任务码),控制台就会跳出如下图任务进度情况,done表示任务进度完成, not set 表示任务进度没有完成;我的卡在了70 ,

备注:同时发现10阶段也没有完成(是不是因为10没完成所以后面卡任务了,但是没触发10任务阶段)

5,任务码和任务进度码都确定后,在控制台输入 setstage MS09Mission02 70( setstage+空格+任务码+空格+任务进度码),任务完成,你的 任务栏也会显示任务完成; 参考技术A 学习任务单卡的代码怎么弄?使用单卡 importosos.environ["CUDA_VISIBLE_DEVICES"]="2"PyTorch默认使用从0开始的GPU,且默认只使用0号GPU。如果要使用其他编号的GPU或者使用多块GPU,则要设置。

pytorch并行后,假设batchsize设置为64,表示每张并行使用的GPU都使用batchsize=64来计算(单张卡使用时,使用batchsize=64比较合适时,多张卡并行时,batchsize仍为64比较合适,而不是64*并行卡数)。

DataParallel 会自动拆分数据,并将作业订单发送到多个GPU上的多个模型。 在每个模型完成它们的工作之后,DataParallel 在将结果返回给你之前收集和合并结果。 参考技术B 目前流行的用于行人ReID的深度卷积神经网络(deep convolutional neural network, CNNs),通常是建立在ResNet或VGG的BackBone上的,这些BackBone原本是为了分类Classification而设计的。因为ReID任务不同于分类,所以体系结构应该进行相应的修改。我们建议自动搜索一个特别适合ReID任务的CNN架构。有三个方面需要处理。

第一,身体结构信息在ReID中起着重要的作用,但它并不能在BackBone中被Encode编码。

第二,神经架构搜索(Neural Architecture Search, NAS)在不需要人工干预的情况下,实现了架构设计过程的自动化,但是目前还没有一种NAS方法将输入图像的结构信息纳入其中。

第三,ReID本质上是一个检索任务,而目前的NAS算法仅仅是为了分类而设计的。

为了解决这些问题,我们提出了一种基于检索的搜索算法。我们的Auto-ReID使自动化方法能够为ReID找到一个高效、有效的CNN架构。大量的实验表明,搜索的架构在减少50%参数和53%失败的同时,达到了最先进的性能 参考技术C 学习任务单卡的代码怎么弄?学习任务的卡单可以在学习里面进行领取,也可以找老师索要,因为他这种代码一般都是在学习任务单里面就可以找到他的代码,因为他这种任务卡单的话也不至于任务单卡的话,他的代码就可以进学习任务里面进行领取 参考技术D 第一,身体结构信息在ReID中起着重要的作用,但它并不能在BackBone中被Encode编码。第二,神经架构搜索(Neural Architecture Search,...

百度知道

TensorFlow分布式部署多机多卡

让TensorFlow们飞一会儿

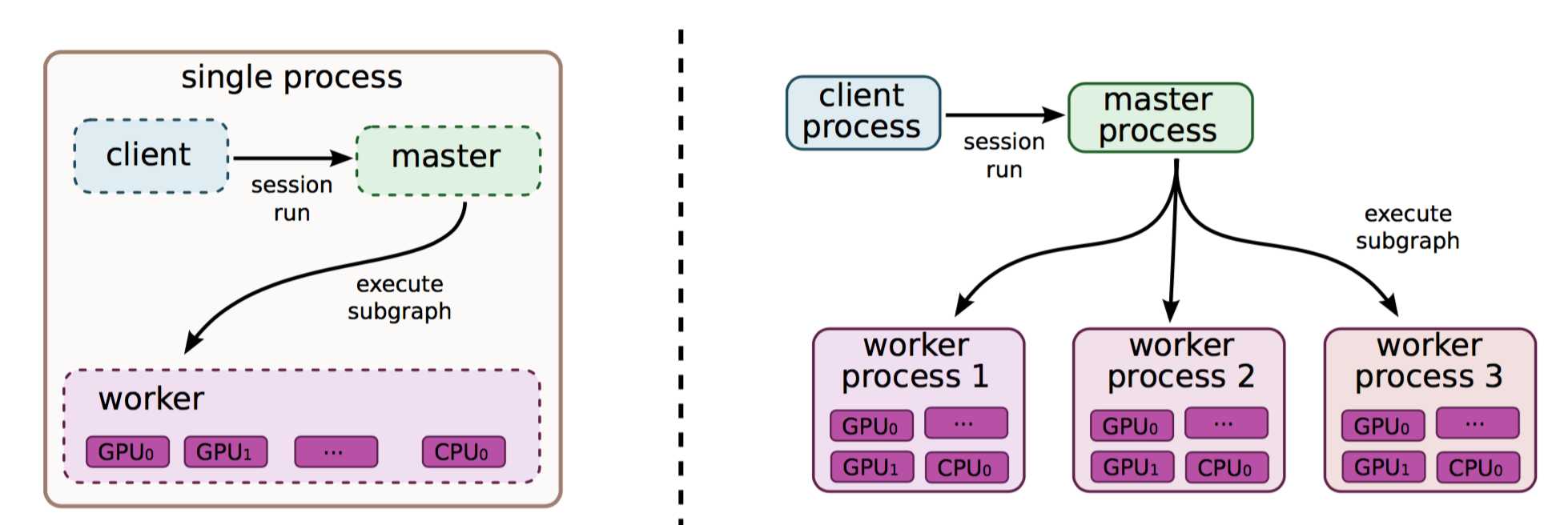

前一篇文章说过了TensorFlow单机多卡情况下的分布式部署,毕竟,一台机器势单力薄,想叫兄弟们一起来算神经网络怎么办?我们这次来介绍一下多机多卡的分布式部署。

其实多机多卡分布式部署在我看来相较于单机多卡分布式更容易一些,因为一台机器下需要考虑我需要把给每个device分配哪些操作,这个过程很繁琐。多台机器虽然看起来更繁琐,然而我们可以把每一台机器看作是一个单卡的机器,并且谷歌爸爸已经把相对复杂的函数都给封装好了,我们直接拿来用就行。为什么这么说呢?我们首先介绍两个概念In-graph模式和Between-graph模式:

In-graph模式: 这个模式跟单机单卡是差不多的,我们需要把不同的节点分配给不同的设备,比如说我让某台机器的某个GPU做一部分卷积,另外某台机器的某个GPU做另外一部分卷积,这样大家都有活干。想象总是美好的,在实际情况中会出现什么问题呢?数据搬移量太大,会有相当一部分时间耗费再数据搬移之下,Tensor翻山越岭,穿过网线,来到一个设备中,凳子还没坐热,有出发去另外一个设备。在大量训练数据的情况下,这种方法往往是不可取的。

Between-graph模式: 这个模式下每一个设备都相当于独立的完成整个卷积神经网络的操作,只是在开始时从参数服务器中取到参数,然后结束的时候送回参数。所以除了chief节点以外,所有人都可以在训练过程中随时退出,随时加入,但是刚开始时,大家都要响应一下chief节点的号召。这样显然更合理一点,在大量数据的情况下我们会选用这个方法,下面的代码也会以Between-graph模式作为例子。

上文提到在Between-graph模式下我们需要在训练过程中从参数服务器中获取参数,那么问题来了,什么是参数服务器?接下来我们再引入两个概念(忍一下忍一下,很简单):

参数服务器:顾名思义,参数服务器嘛,保存参数用的服务器,简称ps(paramEter severs)。参数服务器可以不止一个,如果参数量过大的话,我们可以多叫几台计算机过来充当参数服务器,用来更新参数。

工作服务器: 顾名思义,工作服务器嘛,干活的,简称worker。一般为GPU们,能够进行快速并行计算的设备,它可以从参数服务器中把参数荡下来,然后计算出来以后在传上去。

基础的介绍完了,同样的每个工作模式下都会有参数同步更新和异步更新,下面放张就是那么个意思的图(现在没图都不好写博客了…)。

好,总结一下,我们可以设置多个参数服务器(ps)用来存储更新参数,同时我们也可以设置多个工作服务器(worker)用来进行计算。这样就组成了一个多机多卡分布式的Tensorflow开发环境。

以上是关于学习任务单卡的代码怎么弄的主要内容,如果未能解决你的问题,请参考以下文章