如何破解Web3的“存力”难题

Posted 蚂蚁链

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了如何破解Web3的“存力”难题相关的知识,希望对你有一定的参考价值。

写在前面

文字产生以前,结绳记事是人类用来存储知识和信息的主要方式。此后,从竹简、纸张的发明,到工业时代的磁盘存储,再到信息时代的数据库,存储方式不断革新,“存力”不断提高。

11月3日,在2022云栖大会上,蚂蚁链历经4年技术攻关与测试验证的区块链存储引擎LETUS(Log-structured Efficient Trusted Universal Storage)正式发布。

这一款面向区块链可信数据存储的技术产品,不仅用来解决当前蚂蚁链及区块链产业的规模化发展问题,也面向Web3时代提供“可信存力”支撑。

我们认为,随着大量的数据和数字资产在数字化世界里流转,可信数据的“存力”将如同电力网络的承载力一样重要。

本文希望通过对LETUS的深入技术解读,回答读者们普遍关心的关键问题:LETUS是什么?主要解决哪些问题?为什么坚持用“可验证结构”?为什么要自研?以及未来要走向何处?

01 背景是什么?

从2009年序号为0的创世块诞生至今已过去十多年,“中本聪”依然神秘,但区块链技术的发展却因为公链、token、开源的推动,没有丝毫神秘感。

经过几代技术演进,在比特币的UTXO模型基础上诞生了应用更为广泛、支持可编程智能合约的区块链技术:通过密码学、共识算法、虚拟机、可信存储等技术,多个参与方执行相同的“指令”,来完成同一个业务逻辑,如账户转账,或者合约调用,维护不可篡改和不可伪造的业务数据。

简单讲,可将这类账本数据库,看作一个去中心化防作恶、防篡改的复制状态机,所执行的是智能合约描述的业务逻辑,而状态机通过日志 (区块数据)产生新的状态(状态数据):

区块数据:包括交易、回执、世界状态Root Hash等信息,和数据库系统中的日志类似,但是块之间由Hash锚定防篡改,并且不会删除。(区块数据记录的是区块链上发生的每一笔交易,如:Alice向Bob转账xx)

状态数据:记录账户、资产、业务合约数据等状态信息,和数据库系统中表数据类似,需要实现可验证可追溯。(状态数据记录的是区块链上每个账户或智能合约的当前状态,如:Bob账户剩余xx)

链上数据的特点可以总结为以下三个:

持续增长:从创世块开始,账本数据随交易持续增长,保留周期长;

多版本:交易修改状态数据产生新版本,系统提供历史版本查询和验证功能;

可验证:交易和账户状态通过Merkle根哈希(Merkle Root Hash)锚定在区块头,通过SPV(simple payment verification,简单支付证明)提供存在性证明;

区块链应用通过可验证数据结构(Authenticated Data Structure,如Merkle tree)实现可验证和可追溯。我们认为,Web3“存力”一个非常重要的要素是可验证,而今天我们看到的区块链存储瓶颈大多来源于可验证结构ADS(如Merkle tree)的低效存取和查询,这正是蚂蚁链LETUS重点攻克的难题。

02 我们要什么?

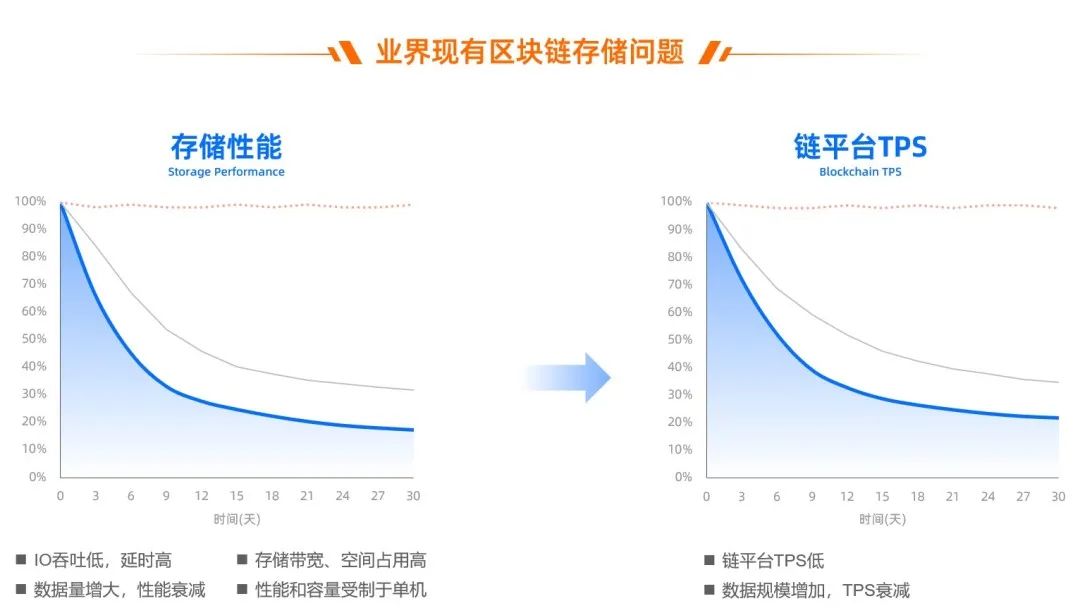

随着时间推移和链上交易的增加,对存储容量的要求也不断增长,随之而来的是区块数据存储成本的大幅提升;与此同时,链上状态数据规模也持续增加,可验证数据结构持续膨胀,导致交易性能随账户规模提升和历史状态数据增加而持续下降。

2019年,蚂蚁链上线了一个供应链金融业务,大家特别兴奋。但是,这种兴奋并没有维持多久,随着程序跑的时间越来越长,问题慢慢暴露出来。

供应链金融是面向ToB的,不像ToC端随时都有数据,可能会在某个时刻(比如每天晚上)有一笔状态数据非常大的交易进来,跑了一个星期后发现性能越来越慢。

链平台TPS的衰减和存储直接相关,而与共识、虚拟机都无关,随着业务合约持续写入数据,存储性能大幅衰减。

如果要在技术上长时间支持亿级账户规模、每天能稳定支撑亿级交易量,存储的规模和性能问题必须要攻克。

期间,团队也曾试过各种技术方法对他进行优化,得到一些缓解。但多次尝试之后发现,随着数量增加而出现的性能衰减,是一个绕不开的瓶颈,需要从本质上解决。

我们需要从问题表象分析背后的原因。

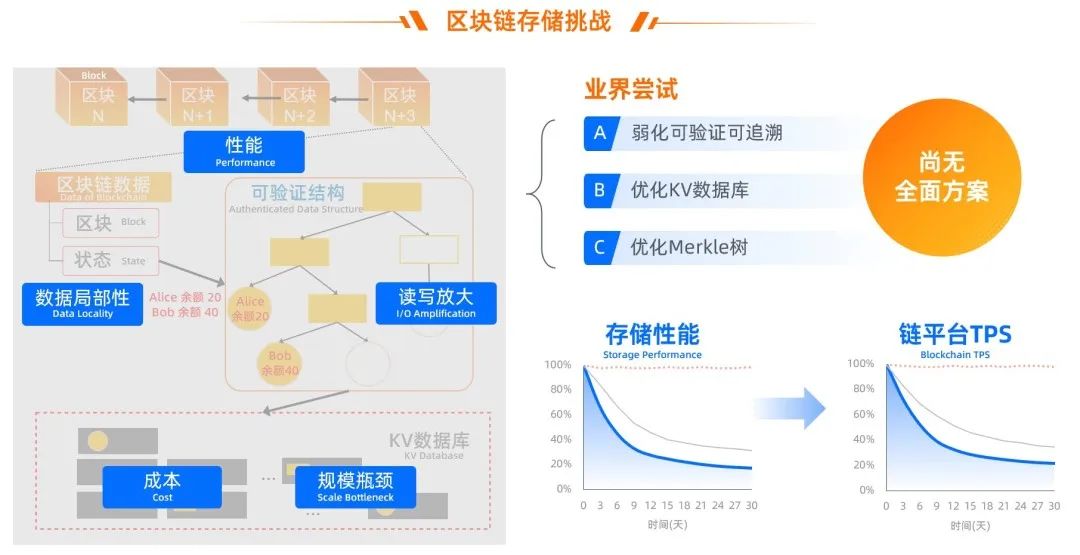

区块链应用通过可验证数据结构实现可验证和可追溯,但是可验证数据结构会带来读写放大(问题1)和数据局部性(问题2)。

而存储系统为了实现数据管理,需要对数据分页/分层、排序,如KV数据库基于LSM-tree将数据分层有序存储,而mysql之类的数据库将数据分页,也会基于B-tree数据结构来排序索引。

业界现有的实现方式,大多采用基于LSM架构的通用 Key-Value 数据库,在数据库之上运行一个独立Merkle树来实现可验证,如:

以太坊:MPT(Merkle Patricia Tree)+LevelDB

Diem:JMT(Jellyfish Merkle Tree)+RocksDB

背后的核心矛盾为:

- Merkle树每次状态数据修改,即使只改一个KV,也需要从叶子节点到根节点,每一层节点都重新编码后,写到KV数据库,例如上图中Alice给Bob转账,需要写入Merkle树的2个叶子节点和3个中间节点,最坏情况需要写入数十个中间节点;

- Merkle树的节点的key完全随机(如对内容算hash,再以hash为key),数据局部性(data locality)非常不友好,如RocksDB里为了让Level内sst文件有序,即使没有垃圾依然需要层层进行数据压实(compaction),从而消耗了大部分的磁盘读写带宽;

- 数据规模越大,Merkle树本身的层数越多,需要额外写入的key-value越多,DB里的数据量越多,后台数据管理的代价越大(如compaction流量),消耗大量的磁盘和CPU资源。

除此之外,吞吐、延时等存储性能(问题3)、持续增长下的存储成本(问题4)、单机存储下的规模瓶颈(问题5)也都是需要解决的问题。

03 面临什么挑战?

在过去几年的快速发展中,区块链的业务场景对交易吞吐量和响应时间要求越来越高,很多技术也被推动迭代发展,如PBFT、HoneyBadger、MyTumbler等高性能共识算法,BTN等网络基础设施,JIT加持的WASM虚拟机、以及高效的并行执行技术。

但比较而言,存储的性能对区块链平台整体性能影响非常大。对面向2C场景的数字藏品类业务(如鲸探,需支持秒杀),交易TPS与延时要求极为苛刻;而对需要在链上保存大量数据的存证类业务,大容量存储带来的成本又十分可观。

要支撑业务的长期可持续发展,我们归纳出区块链存储面临的核心挑战:

- 规模:业务账户规模可达数10亿,状态数据和历史版本规模分别需要支撑到十亿、千亿级;

- 性能:转账交易需求可达十万级TPS、百毫秒级延时,要求性能不能受制于单机瓶颈,数据规模持续增长下性能不衰减;

- 成本:随着交易增长,存储容量持续增加,存储空间占用、节点间带宽占用居高不下。业务持续增长要求低成本存储。

这些问题在行业内很普遍。业界技术路线主要分三条:

- 路线A:弱化可验证可追溯,如HyperLedger Fabric 1.0开始不支持可验证和多版本,保存读写集、只持久化最新版本状态数据;

- 路线B:优化KV数据库存储,如实现键值分离、hash索引的KV数据库等(BadgerDB、ParityDB),接入通用分布式数据库(MySQL)等;

- 路线C:优化Merkle树,交易ID作为版本、树结构稀疏化,如Diem JMT。

根据公开信息,目前区块链产品中主流的MPT + LevelDB、JMT + RocksDB、MySQL等存储架构,没有能全部解决上述5个问题的方案,难以在支持多版本和可验证的同时,满足10亿级账户规模下的高性能、易扩展、低成本的业务要求。

04 我们做到了什么?

我们自研了一套区块链存储引擎LETUS(Log-structured Efficient Trusted Universal Storage),保证完整的可验证、多版本能力,既满足区块数据不可篡改、可追溯、可验证等要求,也提供对合约数据友好访问、存储规模可分片扩展,高性能低成本等特性。同时也满足通用性,统一管理区块数据、状态数据。

LETUS在2022云栖大会发布

4年前不敢想象的能力,现在具备了(以下数据为统一环境下的测试结果):

- 大规模:通过存储集群扩展支持十亿账户规模,TPS超过12万,交易平均时延低于150ms;

- 高性能:存储层IO吞吐相比以太坊MPT + LevelDB等架构提升10~20倍,IO延迟降低90%以上。链平台在7x24高压力压测中,端到端TPS不随数据量增加而衰减;

- 低成本:相比MPT + LevelDB架构,磁盘带宽减少95%、空间占用减少60%;相比于Diem JMT + RocksDB架构,磁盘带宽减少约60%、空间占用降低约40%;

- 进一步降成本方案,供用户选用:(a)针对区块数据容量与成本持续增长,提供智能控温分层存储能力,并应用于存证等业务降低约70%存储成本,同时也降低运维成本。(b)针对状态数据的历史版本容量与成本持续增长,提供范围扫描的批量裁剪能力,实现历史版本状态数据的裁剪和后台空间回收,在十亿账户规模时,使用链原生存储可以减少近90%状态存储空间。

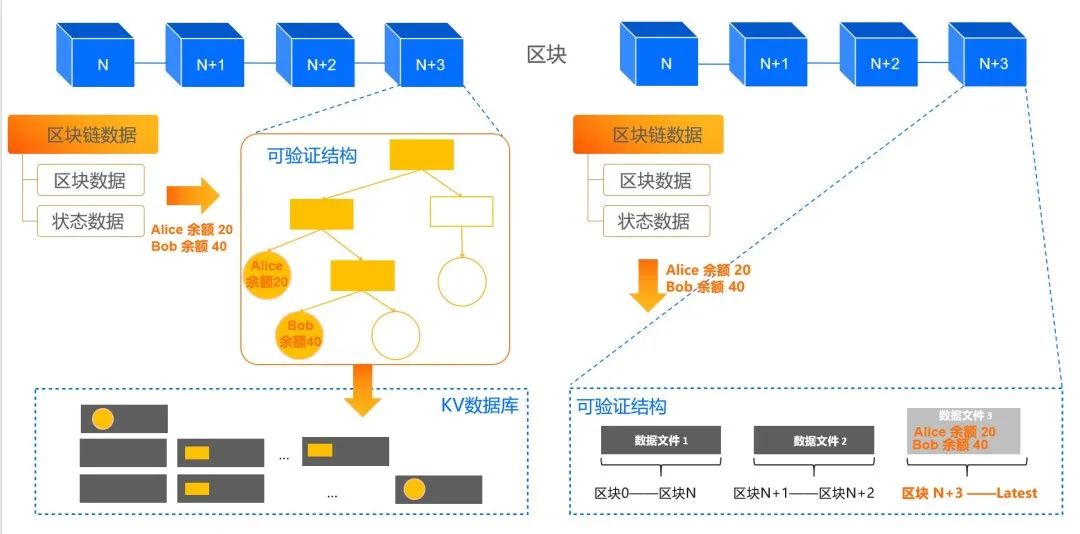

但这背后是一个技术架构的跨越,从下图左边的可验证数据结构+KV数据库架构,升级为现在的LETUS存储引擎,架构更简洁,系统更高效。

如Alice给Bob转账,只需要写增量数据,不需要写入7个Merkle树节点,数据局部性更友好,如Alice和Bob的账户数据,按区块号有序,不再hash随机。

05 怎么做到的?

回顾这四年,主要经历的三个大的阶段。

阶段一:开源思路优化

第一年里,为了满足业务急迫诉求,我们需要在有限时间内,实现亿级账户规模和交易TPS。先从已有系统入手,深度优化了状态树,基于开源MPT到自研FDMT,同时调优RocksDB数据库、增加并发、提升介质性能。

一系列优化措施缓解了问题,但依然无法根本解决,例如数据规模增加后,写放大依然有几十倍,数据在底层存储里依然随机分布。

阶段二:自研存储引擎

为了能彻底解决上述所有问题,我们不得不重新思考存储引擎的设计。

核心设计

针对读写放大(问题1)、数据局部性(问题2)和性能(问题3),我们结合区块链特征,如可验证数据结构的读写行为、链上数据的多版本诉求、只追加和不可篡改等,重新设计存储引擎的架构分层、关键组件、索引数据结构:

根据区块链特征,我们根据可验证数据结构的读写行为、链上数据的多版本诉求,重新设计存储引擎的架构分层、关键组件、索引数据结构:

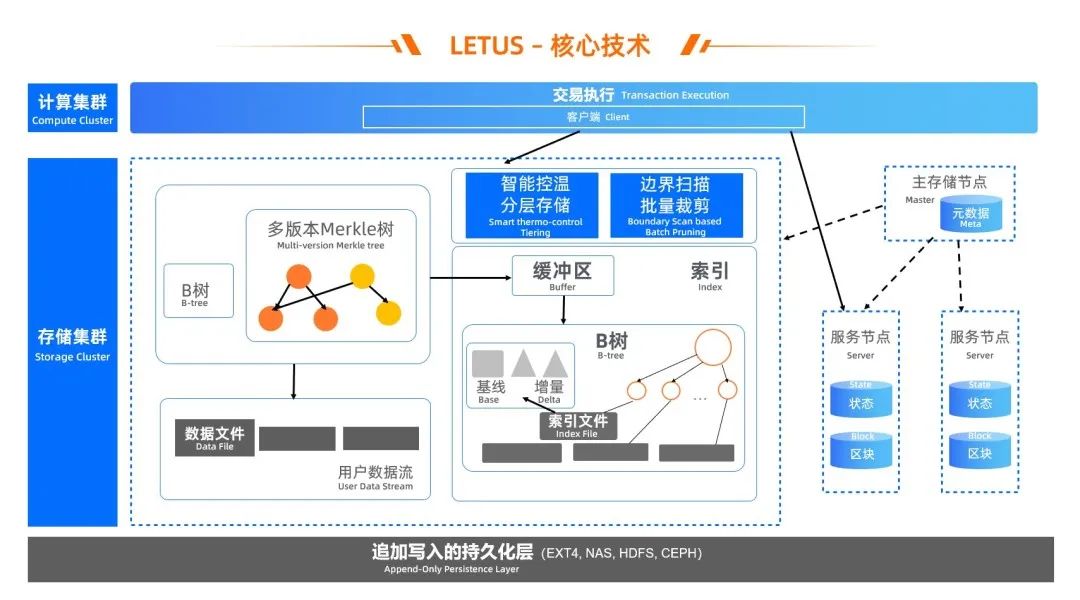

- 将可验证特性下推到存储引擎内部,由内置的Version-based(区块号)多版本Merkle树提供可验证可追溯,并且直接操作文件,从而缩短IO路径;

- 多版本Merkle树的Node聚合为page,提升磁盘友好性,page存储采用Delta-encoding思想避免in-place更新(结合Bw-tree思路),状态数据修改时主要保存增量,定期保存基线,从而减少写放大,也减少了空间占用;

- 为page存储实现Version-based的存储与检索,索引page都按区块号有序写入、在索引文件里有序总局,核心数据结构为B树变种,从而实现有序数据locality;

- 利用区块链场景数据的追加写、Immutable特点,架构上采用Log-Structured思想,通过日志文件来组织数据;

- 数据与索引分离,数据按区块号有序写入数据文件,通过异步IO、协程并发等提升系统并发度,索引多模,区块&状态通用,除Merkle树支持状态数据,实现有序B树支持区块数据;

- 当前最新版本Merkle树优先在内存里缓存或者全部缓存,链上合约执行时,如果存在则直接读取,不需要访问page来重放,从而加速合约执行。

基于这些核心设计,实现了成本降低的同时性能提升,链平台交易TPS、延时等性能指标不会随着数据规模的提升而衰减。

降成本

虽然存储资源占用大幅降低后,但是链上数据依然面临持续增长带来的高成本问题(问题4)。

基于LETUS架构的后台数据治理框架,我们能很方便的扩展实现数据迁移/压缩/垃圾回收等治理策略,基于这些策略,为用户提供进一步降成本能力,并针对自己的业务特点来选择使用:

- 智能控温分层存储:存储介质按照性能、成本分层,通过智能控温调度数据在不同介质的分布量,将冷数据后台自动迁移到廉价介质(如NAS),降低存储整体成本,并实现容量扩展,不受单盘空间限制。

- 范围扫描的批量裁剪:对于历史版本Merkle树和状态对象,基于版本有序性与内置Merkle树,让用户可以指定目标区块号范围裁剪,通过Page边界扫描,批量索引与数据裁剪、垃圾回收实现存储空间释放,进一步降低状态数据成本。

规模扩展

针对问题5,LETUS采用分布式存储架构,实现单个共识参与方计算和存储分离,计算层和存储层可分别部署独立集群,通过高性能网络通讯框架进行数据读写访问。

为了对海量状态数据进行灵活的数据分片,并且保证各个区块链的参与方hash计算的一致性,将数据切片为256个最小存储单元(msu),并将一个或者多个msu构成一个状态数据分片(partition),将所有数据分片调度到多个物理机器。从而实现规模弹性扩展,解决了单机存储的容量瓶颈和带宽瓶颈。

阶段三:生产落地

为了全面落地铺开的同时让业务平稳运行,能够开着飞机换引擎,在这几年的研发过程里,我们充分准备、循序渐进的分阶段落地:

2021年5月,基于LETUS存储引擎的区块数据冷热分层,在版权存证业务灰度上线,存储成本降低71%,解决容量瓶颈并降低运维成本。

2021年8月,基于LETUS存储引擎的状态数据,在数字藏品平台“鲸探”双写灰度上线,并成功支撑秒杀场景;

2022年2-6月,LETUS引擎的历史状态数据裁剪、存储服务架构升级等生产ready,在数字藏品和版权存证等业务全面落地,并从灰度双写切为单写;LETUS单写意味着对硬件资源要求大幅下降,我们将“鲸探”生产环境的云资源全面降配,降配后链平台性能水位提升200%,同时存储成本下降75%。

06 总结与展望

蚂蚁一直坚持“成熟一个开放一个”的技术战略。同样的,LETUS不只为蚂蚁链定制,也同样给其他联盟链、公链提供高性能、低成本的支持。

蚂蚁链坚持技术自研,确保在共识协议、智能合约、网络传输、存储引擎、跨链技术、区块链隐私计算等领域处于全球领先水平。我们始终认为,坚持技术自主研发是建立长期可持续竞争力的关键。

在“可信存力”这条赛道上,我们也需要为进一步的技术壁垒提前布局,如合约结构化查询语言,为链上合约实现结构化+可验证的查询能力,提升开发者体验;Fast-Sync与节点多形态,提升组网效率和节点成本灵活性;以及Web3等潜在的技术生态。

技术创新永远在路上。接下来,继续沿着硬核技术方向突破,啃一些硬骨头,持续为整个价值互联网提供可靠的、可持续的存力。

文 | LETUS技术负责人 田世坤

数据中心级持久内存如何破解PB级数据分析难题

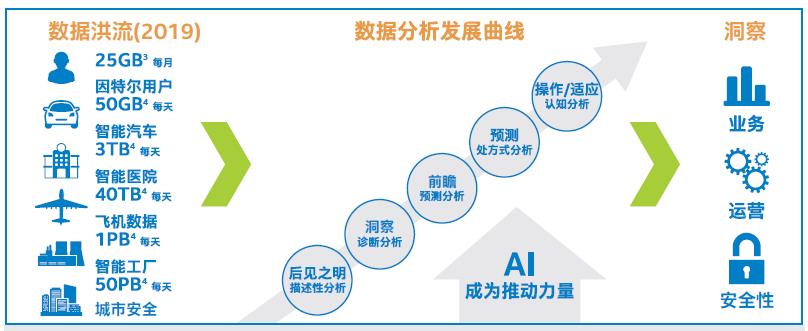

5G商用,物联网加速落地,人工智能快速发展,必将产生大量的数据,形成数据洪流,给数据的管理分析带来巨大挑战!

一、全球超过一半数据创建于过去两年,只有2%的数据经过了分析

根据IDC2018年11月公布的数据,全球超过一半数据产生于过去两年。2018年,仅中国数据量就达到 7.6 ZB。2025年将达到 48.6 ZB,年均增长30%。其中只有2%的数据经过了分析,数据只有经过分析才有价值,从统计结果看显然,数据分析还远远不够普及。

数据洪流和数据分析发展曲线

数据分析非常复杂,从大的方向来划分,可以分为软件解决方案和硬件解决方案,下面我们分别了解下两种解决方案。

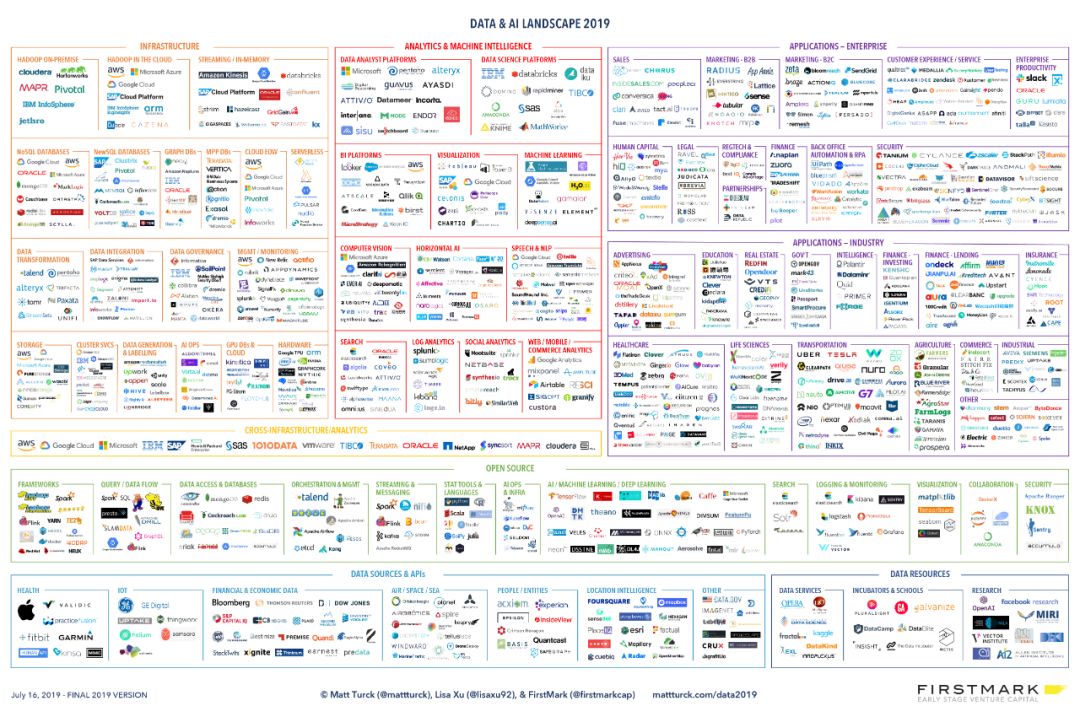

二、数据分析软件解决方案生态及典型工具

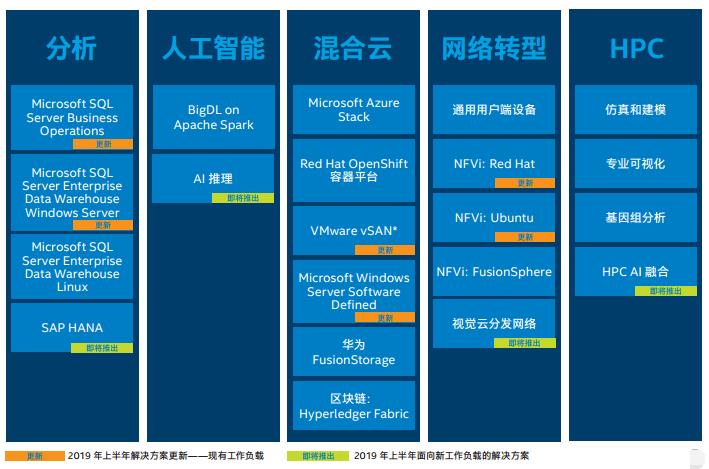

mattturck.com网站每年会发布数据及AI生态图谱,下图是最新的2019年图谱,可以看到和数据相关的企业非常多,涉及的领域也非常复杂。

数据和AI生态,图可点击放大,图来源:mattturck.com网站

从图谱来看,大的模块如下:

基础架构:Hadpoop生态,关系数据库、内存数据库、NoSQL数据库、图数据库、存储等

数据分析工具:数据分析平台、数据科学平台、BI、可视化、日志分析、社交分析等

企业应用数据分析:销售、市场、客服、人力资源、法律、财务、安全

APP应用数据分析:广告、教育、健康、生命科学、交通等

云厂商数据分析(往往提供从基础架构到解决方案):AWS、微软、谷歌、IBM、VMware、甲骨文

下面我们在来看看在一些不同领域,典型的数据分析工具:

1. Excel

Excel可以说是随手可得的数据分析工具,对于数据量不大的情况,使用Excel可以轻松分析,Excel提供的函数可以满足更复杂的分析要求,提供的VBA工具还可以编程,但是对于数据量特别大的分析,Excel就难以胜任了。

2. Hadoop

Hadoop是数据分析重量级的解决方案,如今已经形成生态,有不同的商业发行版和上下游企业。Hadoop是一个由Apache基金会开发的分布式系统基础架构。用户可以在不了解分布式底层细节的情况下,开发分布式程序。充分利用集群的威力进行高速运算和存储。

Hadoop实现了分布式文件系统(HDFS),Hadoop的框架最核心的设计就是HDFS和MapReduce。HDFS为海量的数据提供了存储,而MapReduce则为海量的数据提供了计算。

3. R语言

R语言常用于统计分析、绘图的语言和操作环境,并且是开源的。R语音是一套完整的数据处理、计算和制图软件系统。其功能包括:数据存储和处理系统;数组运算工具(其向量、矩阵运算方面功能尤其强大);完整连贯的统计分析工具;优秀的统计制图功能;简便而强大的编程语言:可操纵数据的输入和输出,可实现分支、循环,用户可自定义功能。另外,在数据处理领域,Python也是常有的语言。

4. Tableau

Tableau是比较成功的数据分析工具,尤其是BI方面,今年6月份,Salesforce.com斥资153亿美元收购Tableau。Tableau的数据分析和展现做的比较好,很容易上手,兼容性也很好,同时支持Windows、Linux、MacOS等各种平台。。

5. Splunk

Splunk是最成功的商业日志管理分析工具,目前市值接近200亿美金。Splunk 收集、分析基础设施、安全系统和业务应用的数据,并将数据分析结果可视化。支持多平台,可以满足复杂的日志分析需求。

6.Elasticsearch

Shay Banon在2004年创造了Elasticsearch的前身,称为Compass。Shay Banon在2010年2月发布了Elasticsearch的第一个版本。Elasticsearch是开源的实时全文搜索和分析引擎,提供搜集、分析、存储数据三大功能。ElasticSearch提供了一个分布式多用户能力的全文搜索引擎,基于RESTful web接口。

软件方案一般门槛高,有学习成本,在数据量比较大的时候,要快速提升数据分析能力,使用硬件方案是好的选择。

笔者在英特尔网站发现了一份通过硬件提升数据分析能力的白皮书,基于英特尔®“傲腾™”数据中心级持久内存可以显著提升数据分析能力,笔者仔细阅读了白皮书,将其中重要的部分摘抄出来,和大家分享下。

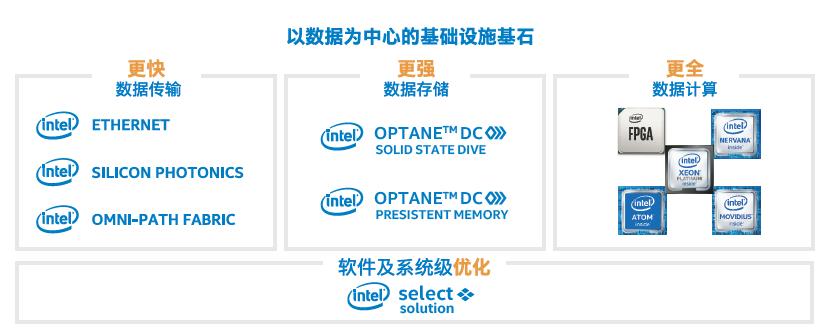

三、数据分析加速利器-英特尔®“傲腾™”数据中心级持久内存

1. 英特尔®“傲腾™”数据中心级持久内存原理

为了让数据分析的速度提升,英特尔®推出的新一代的至强可扩展平台,是一套真正体现“以数据为中心”宗旨的产品技术组合,不仅仅配备第二代英特尔®至强®可扩展处理器,并且与之搭配的英特尔®“傲腾™”数据中心级持久内存更为抢眼,随之而来的是数据处理和分析平台在内存和存储结构上的真正革新,也是破解数据分析难题症结的一剂良方。

英特尔®推出的新一代的至强可扩展平台

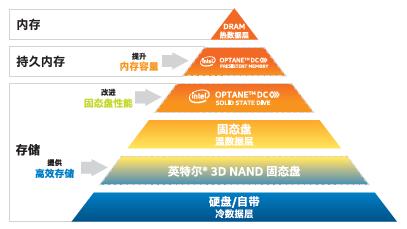

“傲腾™”数据中心级持久内存与普通服务器的DRAM的不同之处,在于“傲腾™”能以更经济的成本来扩展出更高的容量,具备数据持久性,且与DRAM内存有相近的数据读写和延时性能。

英特尔®“傲腾™”数据中心级持久内存和英特尔“傲腾™”固态盘存储结构

如图所示,添加了英特尔®“傲腾™”数据中心级持久内存和英特尔“傲腾™”固态盘后的全新内存和存储结构,为数据存存储到技术,从冷到热提供了更为精细的分层结果,更多的缓存,让数据的流动、处理、分析更为流畅。

英特尔®“傲腾™”数据中心级持久内存特点

英特尔®“傲腾™”数据中心级持久内存具有低成本大容量特点,单一模块可以提供128GB/256GB/512GB三种选择,与传统的DDR4 DRAM内存一同安装在基于至强可扩展处理器平台上时,可以更经济的在八路系统上实现高达24TB的容量(每路最高3TB)。

2. 英特尔®“傲腾™”数据中心级持久内存工作模式

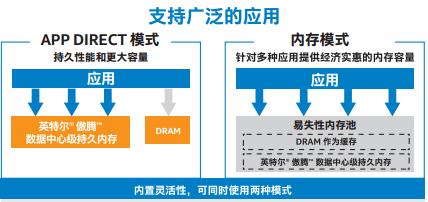

英特尔®“傲腾™”数据中心级持久内存,即可以做内存,也可以做存储,有三种玩法。

工作模式一:内存模式

使用“傲腾™”技术,处理器控制器将DRAM视为缓存,将“傲腾™”数据中心级内存用做可寻址的主内存,让数据以高性价比一直运行在内存中成为可能。由于“傲腾™”的高性价比,可以一次性将数据加载到内存中处理,大大提升了数据处理效果。

云计算的关键技术,虚拟化和容器可以以最快的速度直接从这种模式中收益,可以直接提升虚拟机或者容器性能,进一步提升单机的虚拟化密度。

工作模式二:App Direct模式

操作系统将DRAM和“傲腾™”数据中心级内存视为两个独立的内存池,“傲腾™”数据中心级内存可以像内存一样寻址,像存储设备一样具备数据持久性。在机器重启期间也能保留之前加载的数据,从而增加系统的业务弹性,缩短重启时间,提升业务恢复的速度。

工作模式三:双重模式

可以通过与配置的方式,部分处于内存模式,企业部分处于App Direct模式,用来满足用户即对内存模式有需求,又有工作负载需要运行在App Direct模式。

英特尔®“傲腾™”数据中心级持久内存三种工作模式

3. 案例:良好的效果

百度Feed流服务

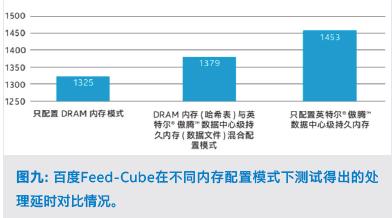

百度Feed流服务的核心模块Feed-Cube从仅配置DRAM内存的模式,迁移至同时使用DRAM与英特尔®“傲腾™”数据中心级持久内存混合配置模式,再到全面部署在英特尔®“傲腾™”数据中心级持久内存上的模式,卓有成效的降低了总体拥有成本(TCO)。

百度Feed-Cube在不同内存配置模式下测试效果对比

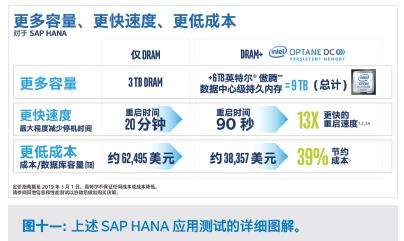

SAP HANA

SAP测试了HANA在3TB DRAM内存平台,以及在3TB DRAM内存+6TB英特尔®“傲腾™”数据中心级持久内存平台上的表现,让系统重新启动从20分钟缩短到90秒,实现了13倍的提示,并使每TB数据库容量成本节约39%。

SAP HANA测试效果

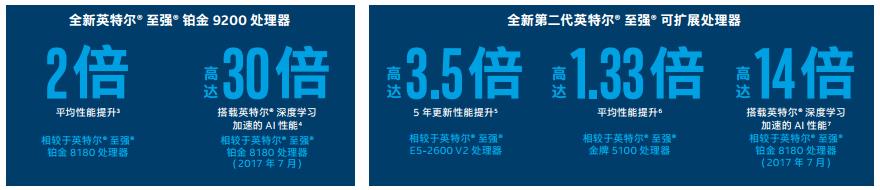

英特尔®“傲腾™”数据中心级持久内存基于英特尔®至强®可扩展平台,英特尔®至强®可扩展平台有许多革命性的改进,我们再来简单介绍下英特尔®至强®可扩展平台。

四、英特尔®至强®可扩展平台介绍

到2020年,全球2000强跨国公司中有半数公司的成功将取决于打造数字化增强型产品、服务和体验的能力,背后的推动力便是技术的进步和由此带来的新模式。这使得全球对灵活计算、网络和存储的需求激增,数据中心需要演进,英特尔®至强®可扩展的数据中心平台实现了敏捷性和可扩展性的飞跃,并且能够提高效率并降低TCO。

英特尔®至强®可扩展平台内置人工智能加速并已针对工作负载进行优化,提供了多云与智能边缘之间无障碍性能切换的基础,平台搭载第二代英特尔®至强®可扩展处理器,将性能的一致性、普遍性和突破性提升到了新的高度。

为5G就绪云优化网络

英特尔®至强®可扩展平台提供的架构能够轻松扩展和改造,第二代英特尔®至强®可扩展处理器“N”SKU,专门用于网络/NFV,开源数据平面开发套件(DPDK)在英特尔架构上实现了优化的通信操作。

总结:5G时代,数据分析能力才是王道

目前,数据洪流已经到来,随着5G的到来,数据洪流还要加剧。数据是企业的血液,是企业生产的根本,数据如何存储、分析,产生更大的价值,是每家企业都要面临的挑战,企业需要从软件和硬件方面同时着手。英特尔®至强®可扩展平台是应对数据洪流的利器,英特尔®“傲腾™”数据中心级持久内存是加速数据分析的利器,可以让企业在数据处理方面走的更快更稳。

提示:

1. 本文中提到的英特尔官网的《傲腾数据中心级持久内存如何破解数据分析难题》白皮书链接如下,也可以点击原文链接直达:

https://www.intel.cn/content/www/cn/zh/architecture-and-technology/optane-dc-persistent-memory-case-gallery.html

2. 想要更详细的了解英特尔®至强®可扩展平台,可以访问以下链接:

https://www.intel.cn/content/www/cn/zh/products/docs/processors/xeon/2nd-gen-xeon-scalable-processors-brief.html

以上是关于如何破解Web3的“存力”难题的主要内容,如果未能解决你的问题,请参考以下文章