yolov3模型训练——使用yolov3训练自己的模型

Posted 萝北村的枫子

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了yolov3模型训练——使用yolov3训练自己的模型相关的知识,希望对你有一定的参考价值。

本文主要讲述了在Windows10环境下使用yolov3训练模型的具体步骤

本文主要包括以下内容:

- 一、程序下载与准备

- 二、环境搭建

- 三、数据集制作

- 四、yolov3模型训练

- (1)修改数据配置文件

- (2)修改模型配置文件

- (3)train.py主函数修改

- (4)模型训练可能遇到的问题

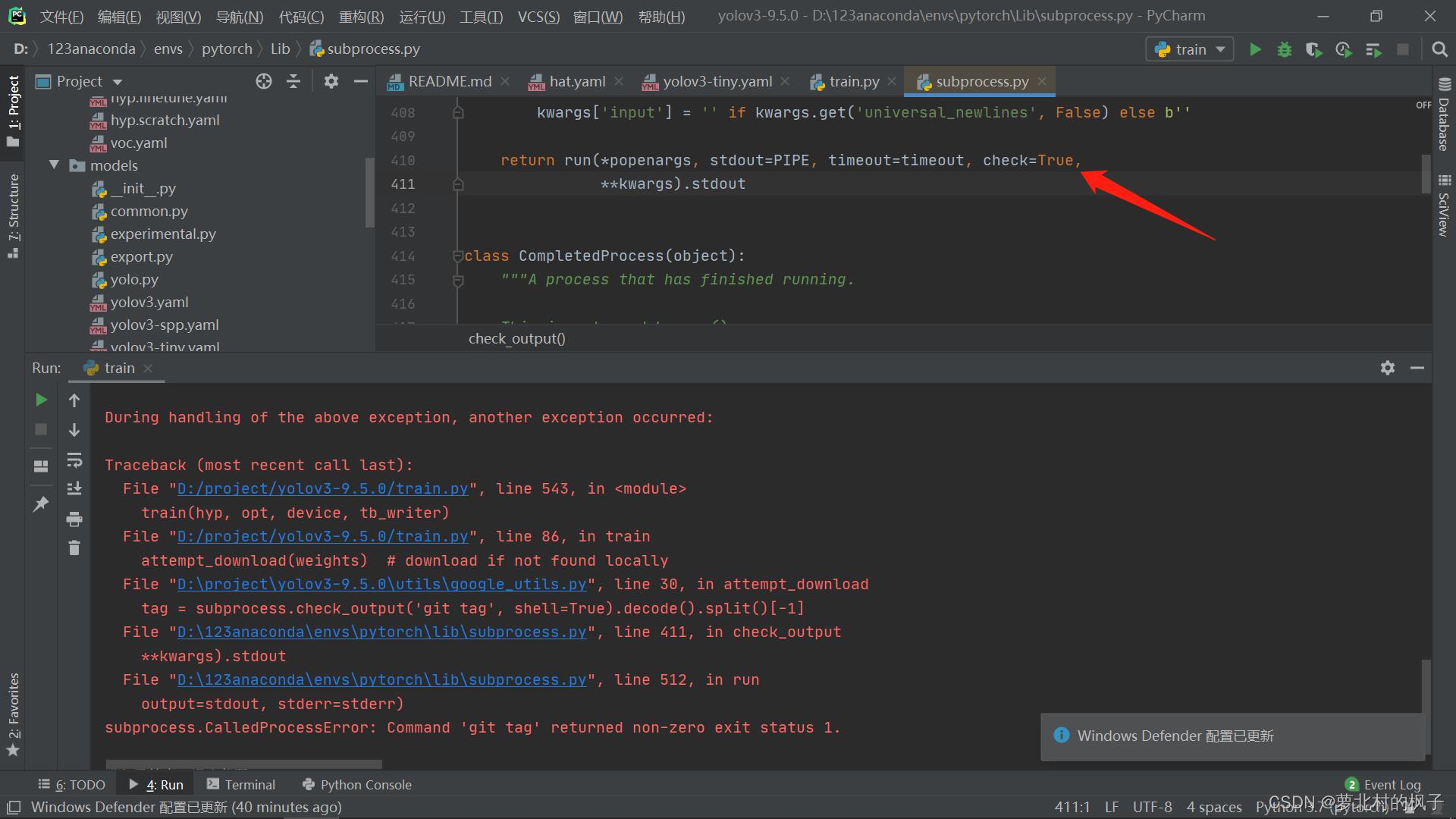

- 1.遇到错误 subprocess.CalledProcessError: Command 'git tag' returned non-zero exit status 1.

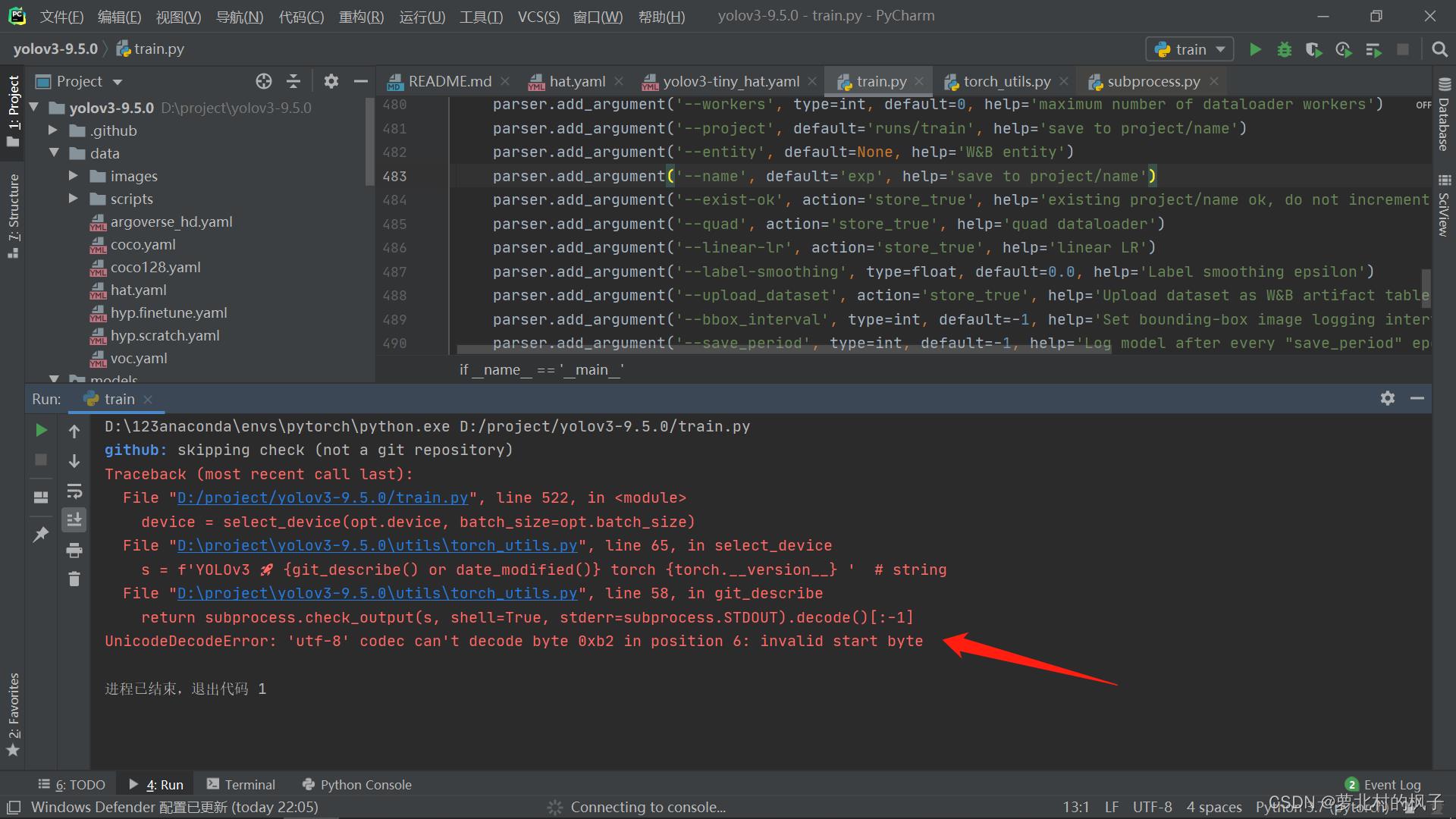

- 2.遇到错误 UnicodeDecodeError:: 'utf-8' codec can't decode byte 0xc8 in position 0: invalid contin

- 3.遇到错误 BrokenPipeError: [Errno 32] Broken pipe

- 4.遇到错误 OMP: Error #15: Initializing libiomp5md.dll, but found libiomp5md.dll already initialized.

- 五、测试结果

软件准备:anaconda3,pycharm

一、程序下载与准备

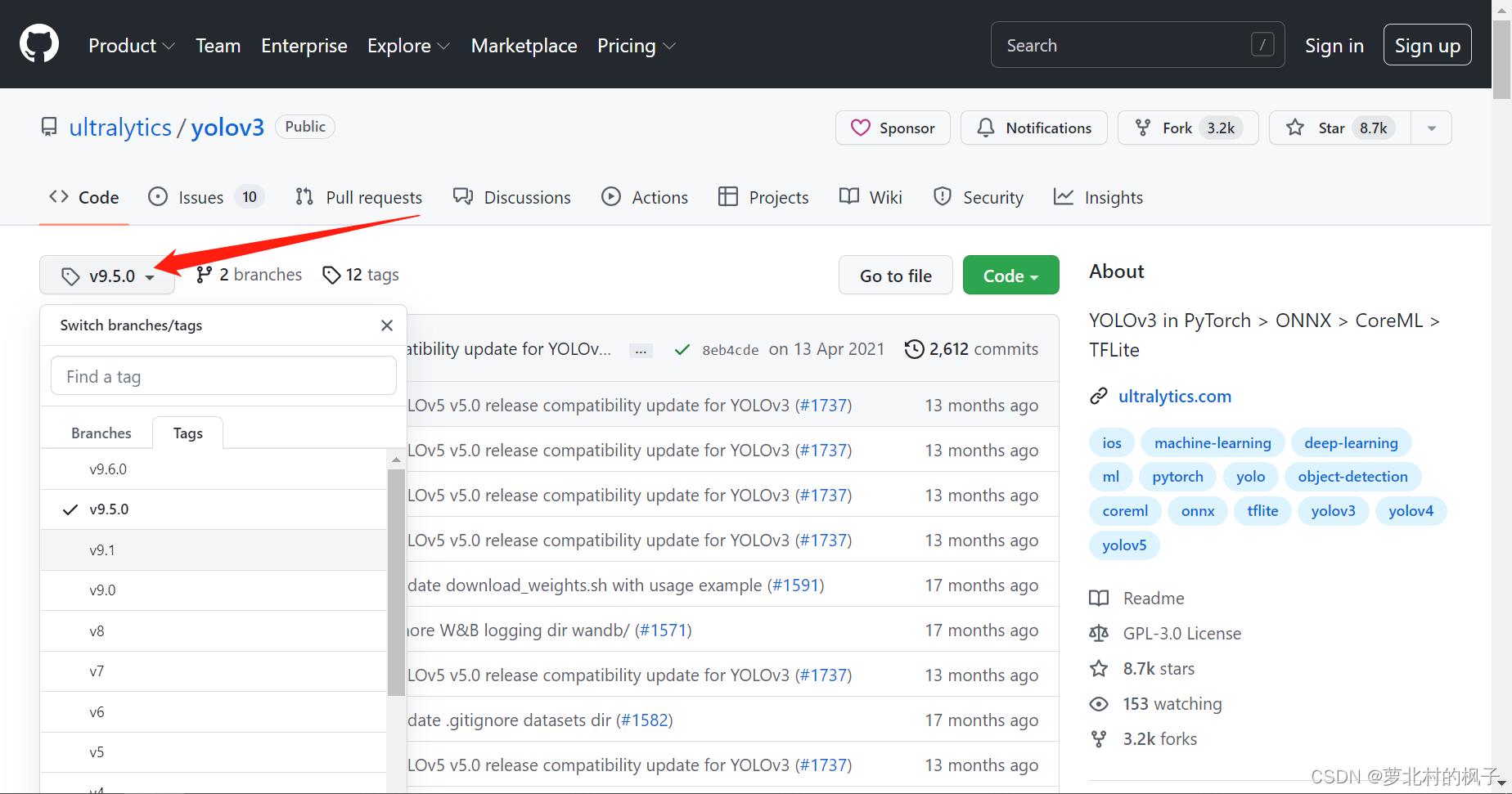

(1)yolov3下载

yolov3的github地址:yolov3

1.可以点击此处选择自己想要下载的版本(本文以9.5.0为例)

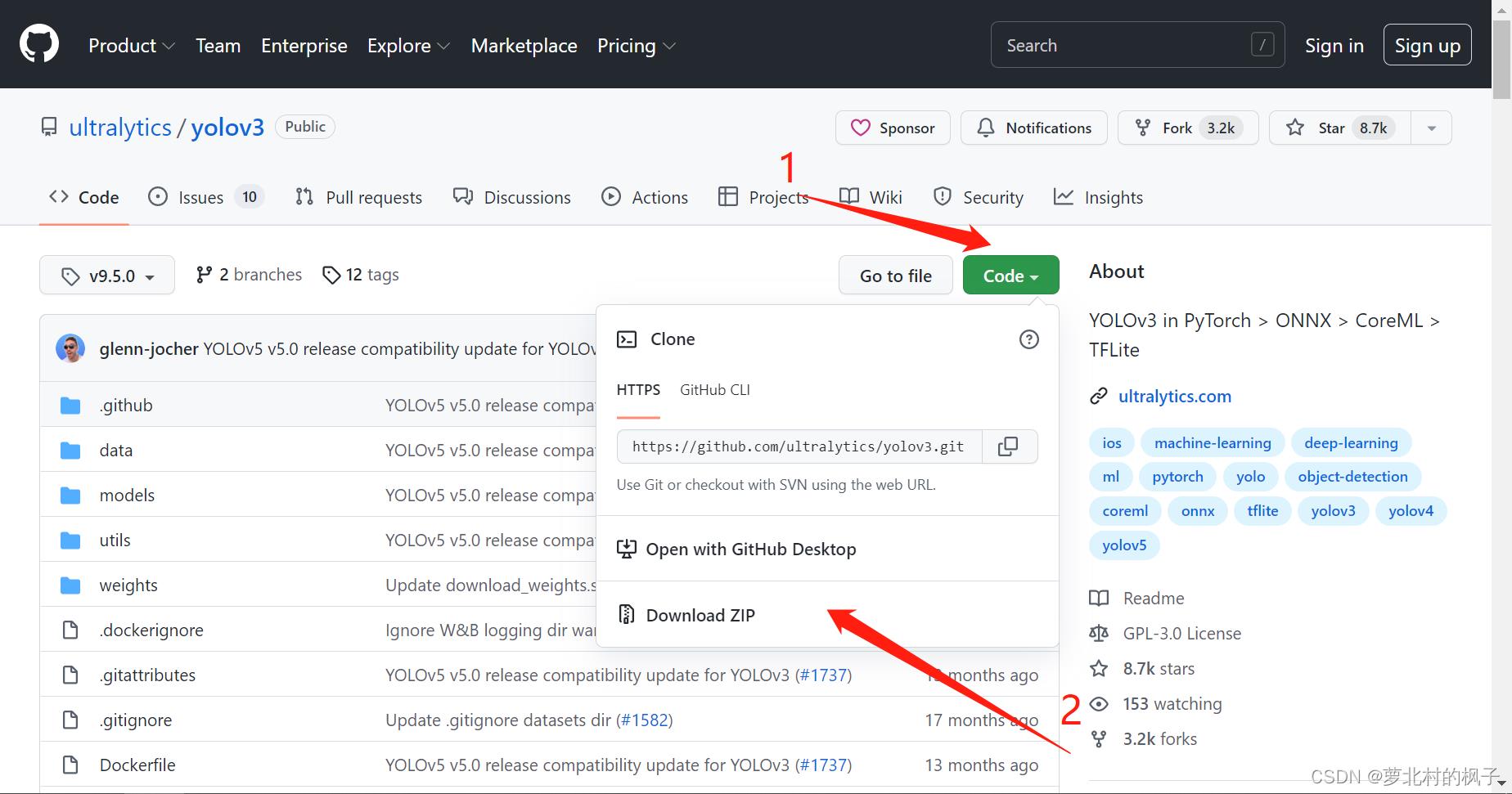

2.点击左边的download即可下载压缩包

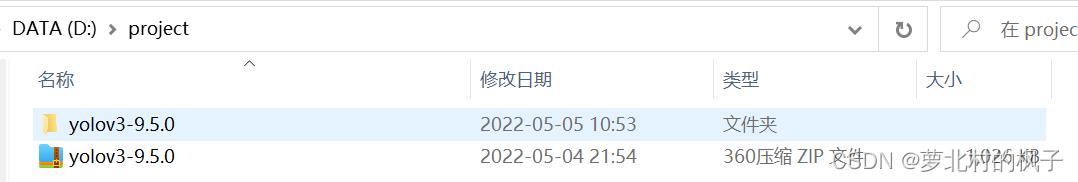

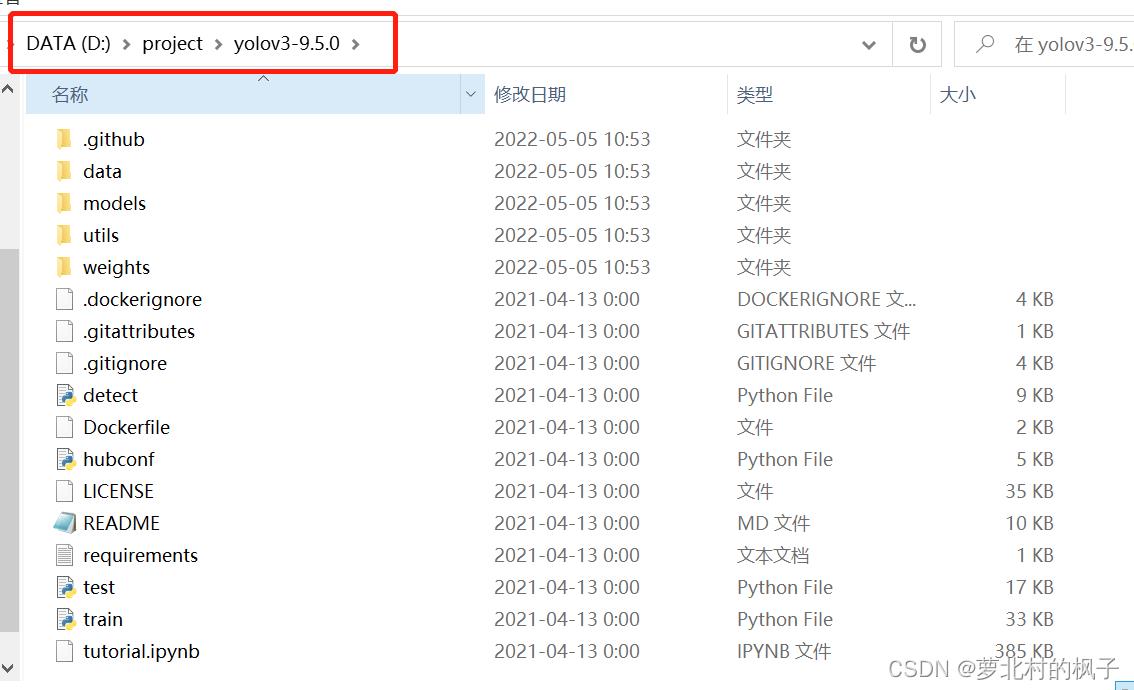

3.下载并解压后的文件夹如图所示:

在pycharm中打开工程目录如下图所示:

(2)训练集文件夹创建

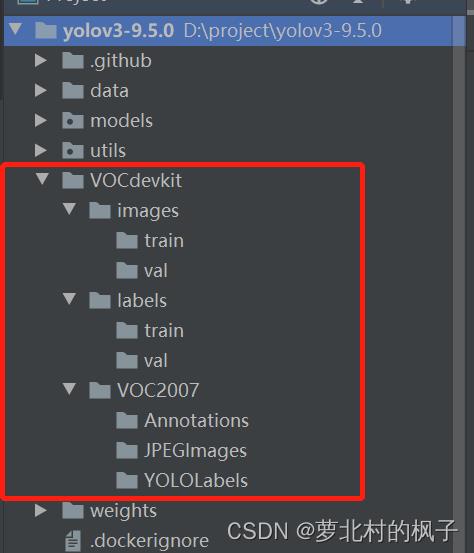

1.在yolov3-9.5.0工程文件夹下,新建一个名称为VOCdevkit的文件夹

2.在VOCdevkit文件夹下,新建三个名称分别为images,labels,VOC2007的文件夹

3.在images和labels文件夹下分别新建两个名为train和val的文件夹

4.在VOC2007文件夹下新建三个名称分别为Annotations,JPEGImages,YOLOLabels的文件夹

如下图所示:

Annotations:xml标签文件夹

JPEGImages:图片文件夹

YOLOLabels:txt标签文件夹(yolov训练需要txt格式的标签文件)

(3)预训练权重下载

加载预训练权重进行网络的训练可以减小缩短网络训练时间,并且提高精度。预训练权重越大,训练出来的精度就会越高,但是其检测的速度就会越慢。

1.预训练权重下载地址:yolov5权重

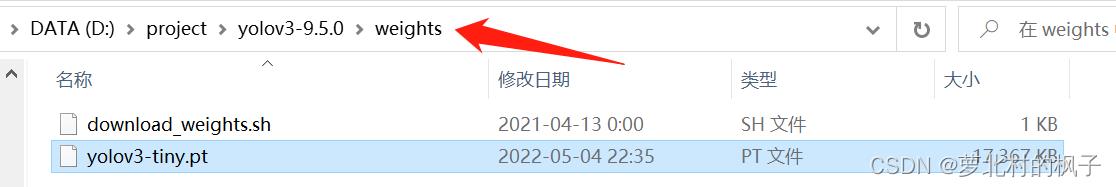

本文在此处选择下载的是yolov3-tiny.pt

(不同的预训练权重对应着不同的网络层数,我们需要根据预训练权重使用对应的yaml文件,即在之后的训练中需要使用名称为yolov3-tiny.yaml的文件)

2.将下载好的权重文件保存在weights文件夹中

二、环境搭建

(1)pytorch安装

windows10系统中通过anaconda安装pytorch的具体步骤可以阅读此篇博客:

anaconda安装pytorch(anaconda3,Windows10)

(2)将pytorch应用到工程

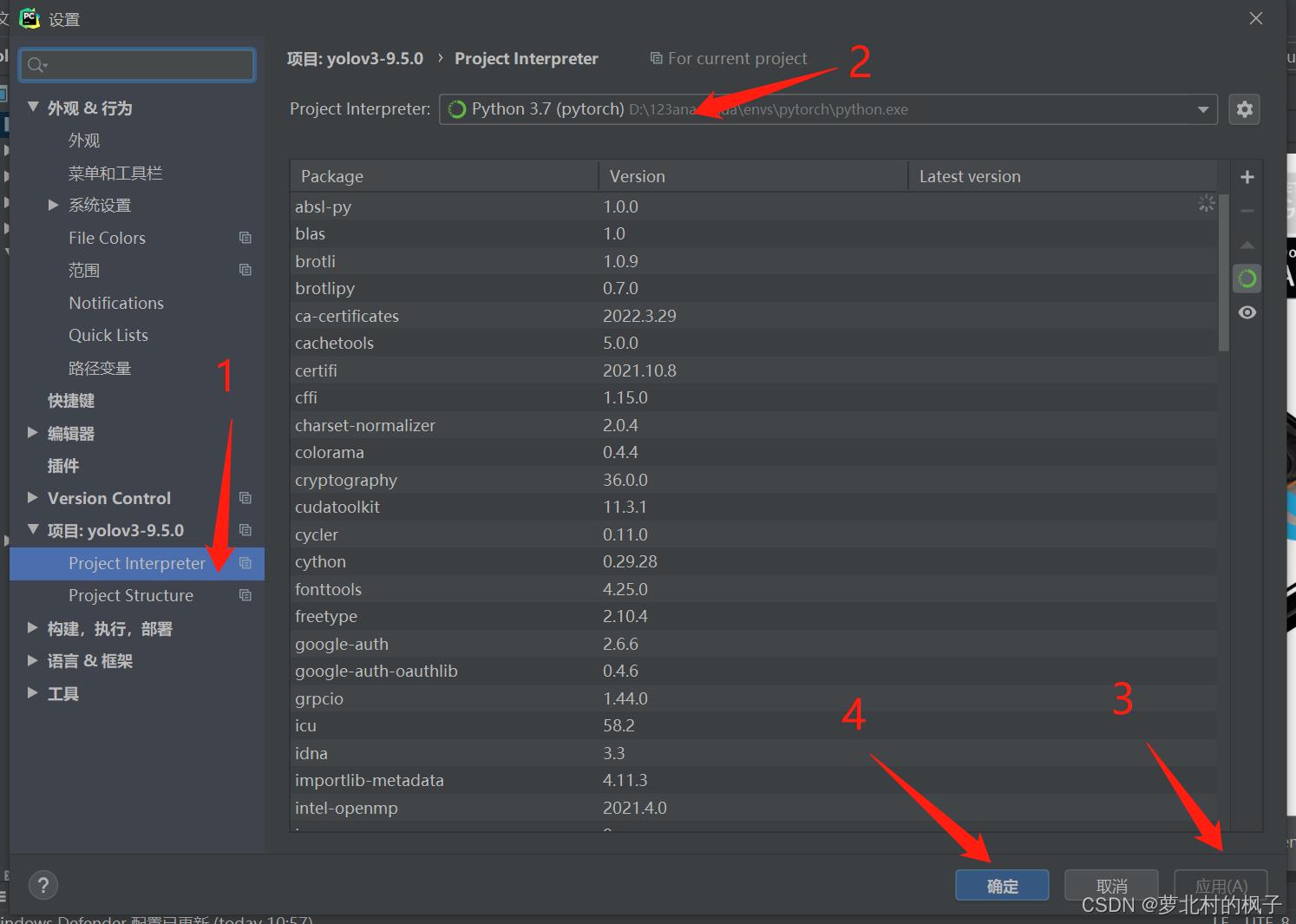

在上一步中我们通过anaconda安装了pytorch,并将其导入了pycharm,下面我们来将名称为pyotch环境中的编译器应用到工程文件中去。

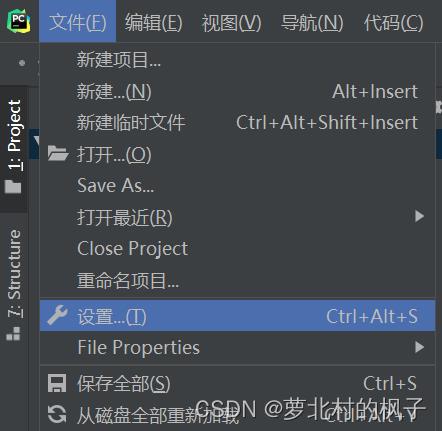

1.点击文件→设置

2.选择Project Interpreter,选择刚刚导入pycharm的pytorch环境,点击应用,最后点击确认

这样我们就成功将名称为pytorch环境中的编译器应用到了yolov3-9.5.0工程中

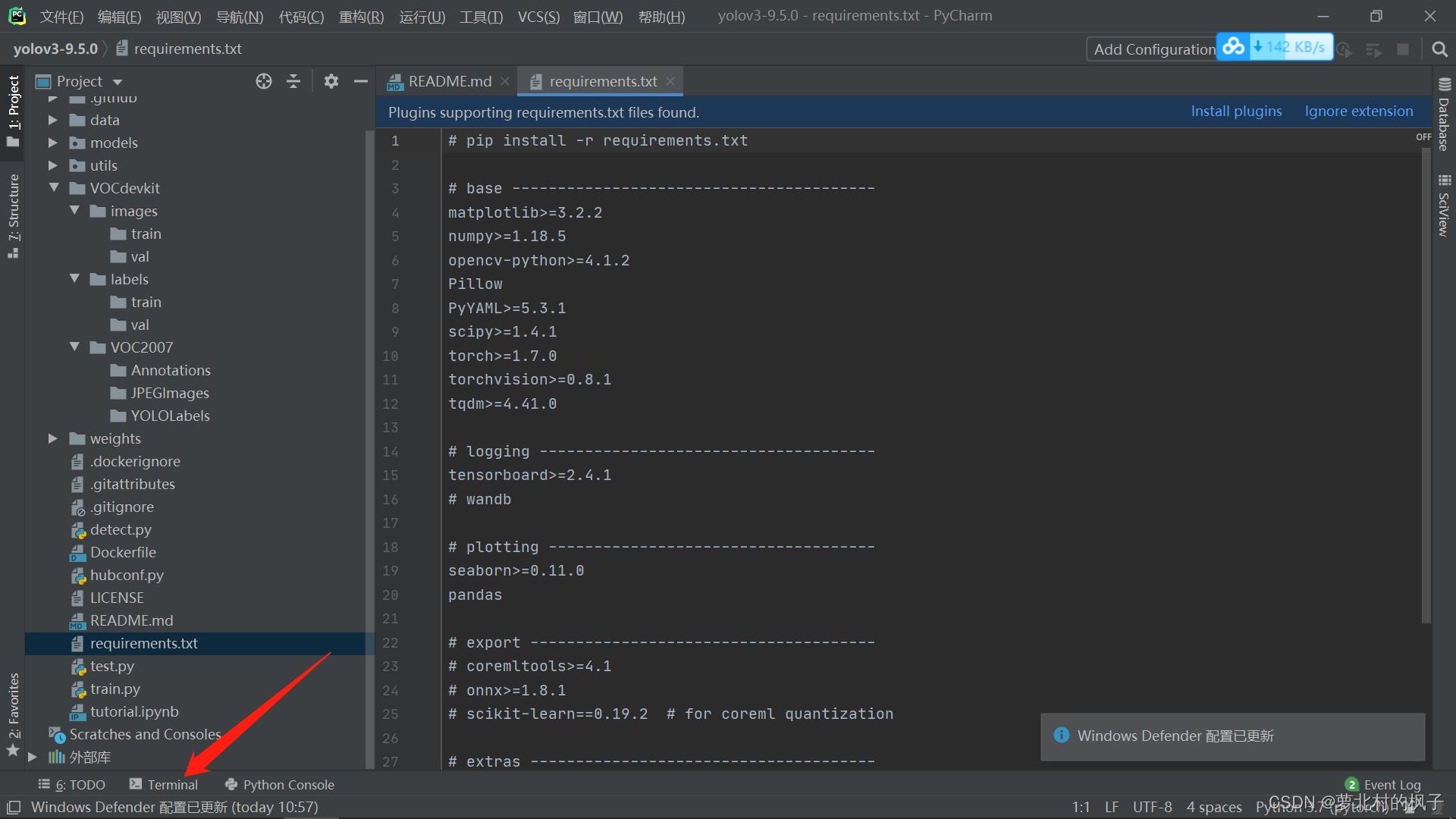

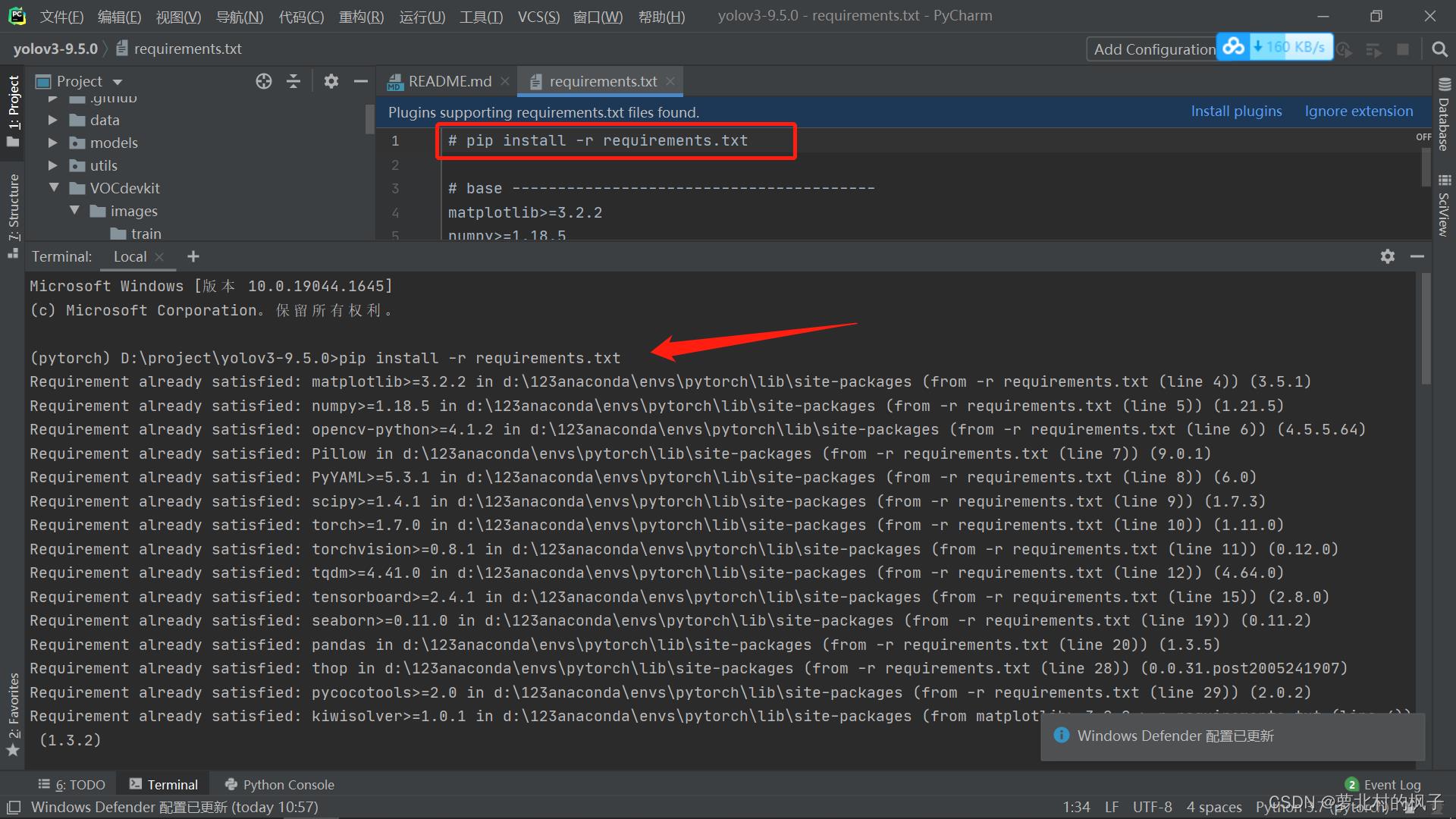

(3)requirements中的依赖包安装

1.接下来对工程所需的依赖包进行安装,首先打开terminal

2.复制requirements.txt文件中的命令行:

pip install -r requirements.txt

粘贴在terminal中,并按回车键运行命令行,requirements中的依赖包就开始安装了

(4)环境搭建可能遇到的问题

1.遇到错误 ERROR: Could not build wheels for pycocotools which use PEP 517 and cannot be installed directly

参考此篇博客中的环境搭建可能遇到的问题部分:

目标检测—基于Yolov5的目标检测项目(学习笔记)

(如有其它错误会后续更新)

三、数据集制作

使用labelimg来制作我们自己的数据集,labelimg的安装和基本操作可以阅读此篇博客:

数据集制作——使用labelimg制作数据集

yolov网络训练所需要的文件格式是txt格式的

如果通过labelimg给数据集打标签时输出为xml格式,可以通过代码将xml格式的标注文件转换为txt格式的标注文件;

如果输出为txt格式的标签文件则可以直接使用。同时训练自己的yolov3检测模型的时候,数据集需要划分为训练集和验证集,也可以通过相关代码实现。

本文以识别两个标签"person"和"har"为例,同时本文的数据集是以基于识别人带安全帽的数据集为例

本文以使用labelimg标注xml格式的标签文件为例:

(打标签过程省略)

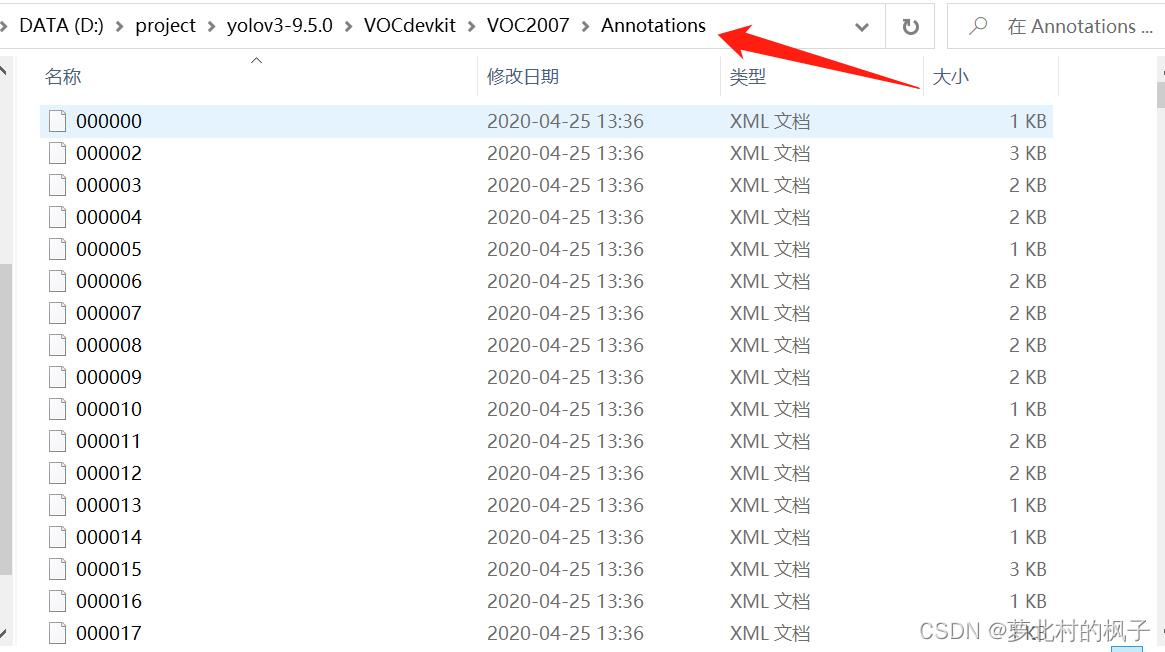

1.首先将图片数据集存放在JPEGImages文件夹下;将xml标签文件存放在Annotations文件夹下;即:

JPEGImages里面存放着图片文件

Annotations里面存放着xml格式的标签

如图所示:

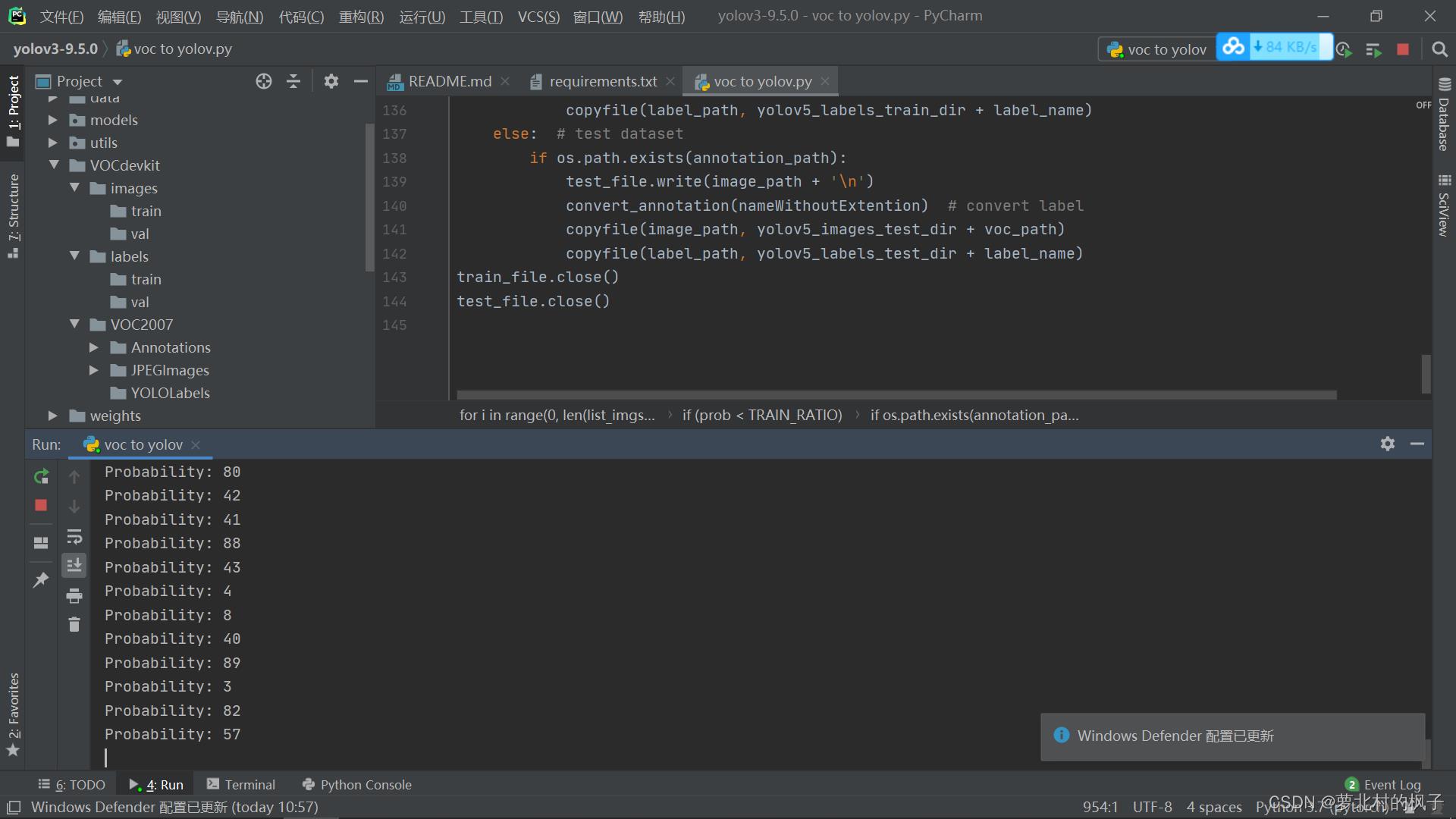

2.在工程中新建一个python的file,复制粘贴下面的代码并运行,即可将数据集划分为训练集和验证集

(注意将下面代码中的标签种类classes = [“hat”, “person”] 修改为自己的标签,下面代码中训练集占比TRAIN_RATIO = 80为80%)

import xml.etree.ElementTree as ET

import pickle

import os

from os import listdir, getcwd

from os.path import join

import random

from shutil import copyfile

classes = ["hat", "person"] #标签种类

#classes=["ball"]

TRAIN_RATIO = 80 #训练集占比

def clear_hidden_files(path):

dir_list = os.listdir(path)

for i in dir_list:

abspath = os.path.join(os.path.abspath(path), i)

if os.path.isfile(abspath):

if i.startswith("._"):

os.remove(abspath)

else:

clear_hidden_files(abspath)

def convert(size, box):

dw = 1./size[0]

dh = 1./size[1]

x = (box[0] + box[1])/2.0

y = (box[2] + box[3])/2.0

w = box[1] - box[0]

h = box[3] - box[2]

x = x*dw

w = w*dw

y = y*dh

h = h*dh

return (x,y,w,h)

def convert_annotation(image_id):

in_file = open('VOCdevkit/VOC2007/Annotations/%s.xml' %image_id)

out_file = open('VOCdevkit/VOC2007/YOLOLabels/%s.txt' %image_id, 'w')

tree=ET.parse(in_file)

root = tree.getroot()

size = root.find('size')

w = int(size.find('width').text)

h = int(size.find('height').text)

for obj in root.iter('object'):

difficult = obj.find('difficult').text

cls = obj.find('name').text

if cls not in classes or int(difficult) == 1:

continue

cls_id = classes.index(cls)

xmlbox = obj.find('bndbox')

b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text), float(xmlbox.find('ymin').text), float(xmlbox.find('ymax').text))

bb = convert((w,h), b)

out_file.write(str(cls_id) + " " + " ".join([str(a) for a in bb]) + '\\n')

in_file.close()

out_file.close()

wd = os.getcwd()

wd = os.getcwd()

data_base_dir = os.path.join(wd, "VOCdevkit/")

if not os.path.isdir(data_base_dir):

os.mkdir(data_base_dir)

work_sapce_dir = os.path.join(data_base_dir, "VOC2007/")

if not os.path.isdir(work_sapce_dir):

os.mkdir(work_sapce_dir)

annotation_dir = os.path.join(work_sapce_dir, "Annotations/")

if not os.path.isdir(annotation_dir):

os.mkdir(annotation_dir)

clear_hidden_files(annotation_dir)

image_dir = os.path.join(work_sapce_dir, "JPEGImages/")

if not os.path.isdir(image_dir):

os.mkdir(image_dir)

clear_hidden_files(image_dir)

yolo_labels_dir = os.path.join(work_sapce_dir, "YOLOLabels/")

if not os.path.isdir(yolo_labels_dir):

os.mkdir(yolo_labels_dir)

clear_hidden_files(yolo_labels_dir)

yolov5_images_dir = os.path.join(data_base_dir, "images/")

if not os.path.isdir(yolov5_images_dir):

os.mkdir(yolov5_images_dir)

clear_hidden_files(yolov5_images_dir)

yolov5_labels_dir = os.path.join(data_base_dir, "labels/")

if not os.path.isdir(yolov5_labels_dir):

os.mkdir(yolov5_labels_dir)

clear_hidden_files(yolov5_labels_dir)

yolov5_images_train_dir = os.path.join(yolov5_images_dir, "train/")

if not os.path.isdir(yolov5_images_train_dir):

os.mkdir(yolov5_images_train_dir)

clear_hidden_files(yolov5_images_train_dir)

yolov5_images_test_dir = os.path.join(yolov5_images_dir, "val/")

if not os.path.isdir(yolov5_images_test_dir):

os.mkdir(yolov5_images_test_dir)

clear_hidden_files(yolov5_images_test_dir)

yolov5_labels_train_dir = os.path.join(yolov5_labels_dir, "train/")

if not os.path.isdir(yolov5_labels_train_dir):

os.mkdir(yolov5_labels_train_dir)

clear_hidden_files(yolov5_labels_train_dir)

yolov5_labels_test_dir = os.path.join(yolov5_labels_dir, "val/")

if not os.path.isdir(yolov5_labels_test_dir):

os.mkdir(yolov5_labels_test_dir)

clear_hidden_files(yolov5_labels_test_dir)

train_file = open(os.path.join(wd, "yolov5_train.txt"), 'w')

test_file = open(os.path.join(wd, "yolov5_val.txt"), 'w')

train_file.close()

test_file.close()

train_file = open(os.path.join(wd, "yolov5_train.txt"), 'a')

test_file = open(os.path.join(wd, "yolov5_val.txt"), 'a')

list_imgs = os.listdir(image_dir) # list image files

prob = random.randint(1, 100)

print("Probability: %d" % prob)

for i in range(0,len(list_imgs)):

path = os.path.join(image_dir,list_imgs[i])

if os.path.isfile(path):

image_path = image_dir + list_imgs[i]

voc_path = list_imgs[i]

(nameWithoutExtention, extention) = os.path.splitext(os.path.basename(image_path))

(voc_nameWithoutExtention, voc_extention) = os.path.splitext(os.path.basename(voc_path))

annotation_name = nameWithoutExtention + '.xml'

annotation_path = os.path.join(annotation_dir, annotation_name)

label_name = nameWithoutExtention + '.txt'

label_path = os.path.join(yolo_labels_dir, label_name)

prob = random.randint(1, 100)

print("Probability: %d" % prob)

if(prob < TRAIN_RATIO): # train dataset

if os.path.exists(annotation_path):

train_file.write(image_path + '\\n')

convert_annotation(nameWithoutExtention) # convert label

copyfile(image_path, yolov5_images_train_dir + voc_path)

copyfile(label_path, yolov5_labels_train_dir + label_name)

else: # test dataset

if os.path.exists(annotation_path):

test_file.write(image_path + '\\n')

convert_annotation(nameWithoutExtention) # convert label

copyfile(image_path, yolov5_images_test_dir + voc_path)

copyfile(label_path, yolov5_labels_test_dir + label_name)

train_file.close()

test_file.close()

运行此代码,过程如下图所示:(注意数据集文件夹名称要和上文中训练集文件夹创建部分一样,就可以直接复制粘贴运行)

然后就可以在images和labels文件夹中分别看到已经划分好的图片数据集和标签数据集

四、yolov3模型训练

(1)修改数据配置文件

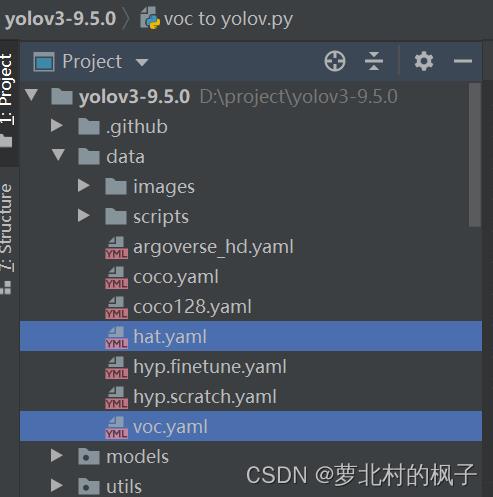

1.找到data目录下的voc.yaml文件,将该文件复制一份,将复制的文件重命名,方便后续操作,本文此处修改为hat.yaml

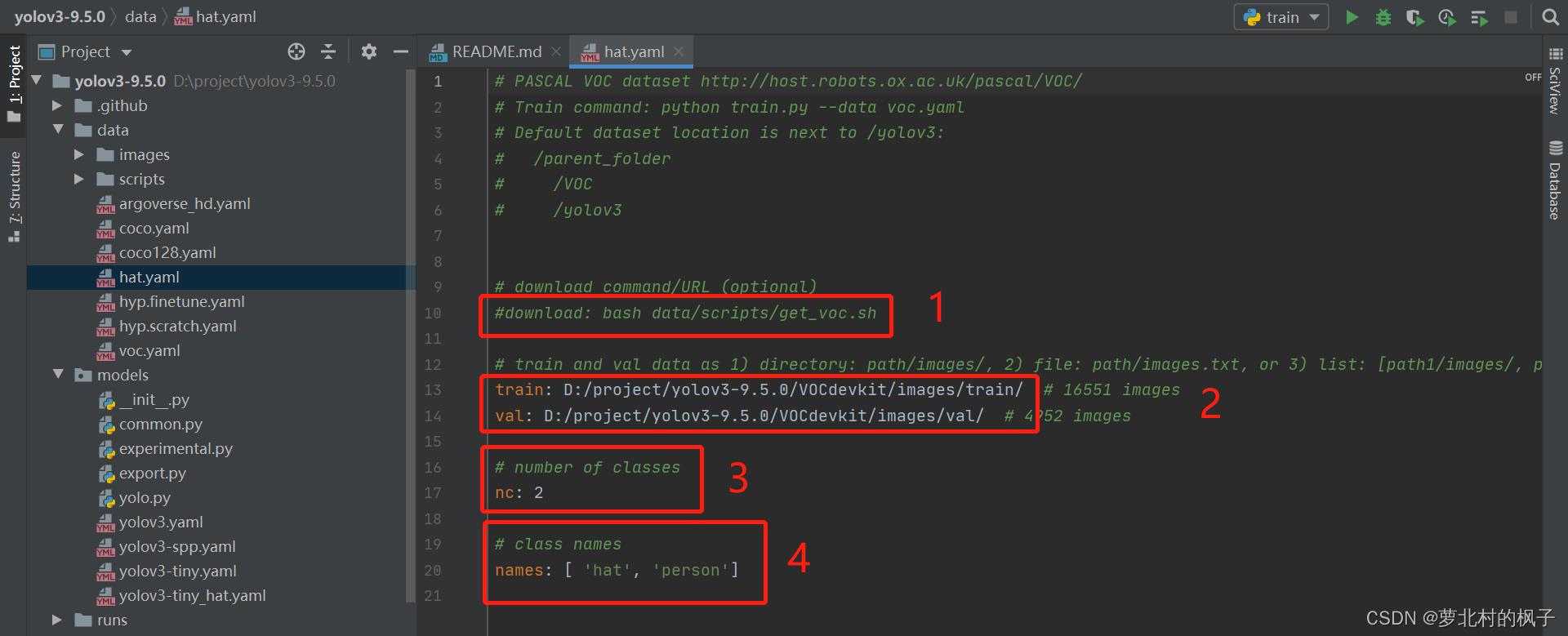

2.点击hat.yaml文件,修改以下部分:

注释掉语句:download: bash data/scripts/get_voc.sh

修改train和val地址为自己电脑中数据集地址

修改number of classes数值为自己数据集标签的种类个数(本文标签为两类)

修改class names为自己自己数据集标签的种类(本文为hat和person)

(2)修改模型配置文件

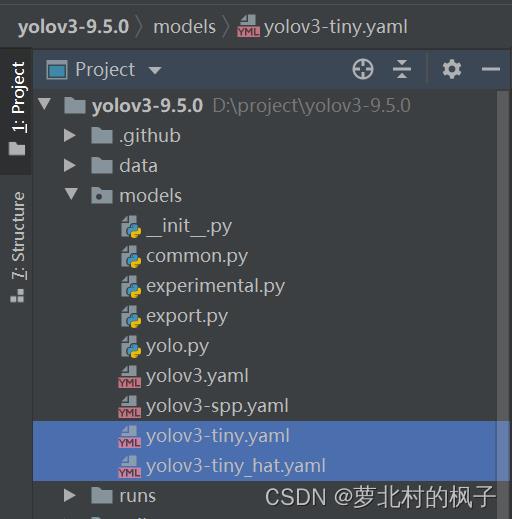

前面选择下载的权重文件为yolov3-tiny.pt,我们需要使用与之相对应的模型配置yaml文件

1.找到models目录下的yolov3-tiny.yaml文件,将该文件复制一份,将复制的文件重命名,方便后续操作,本文此处修改为yolov3-tiny_hat.yaml

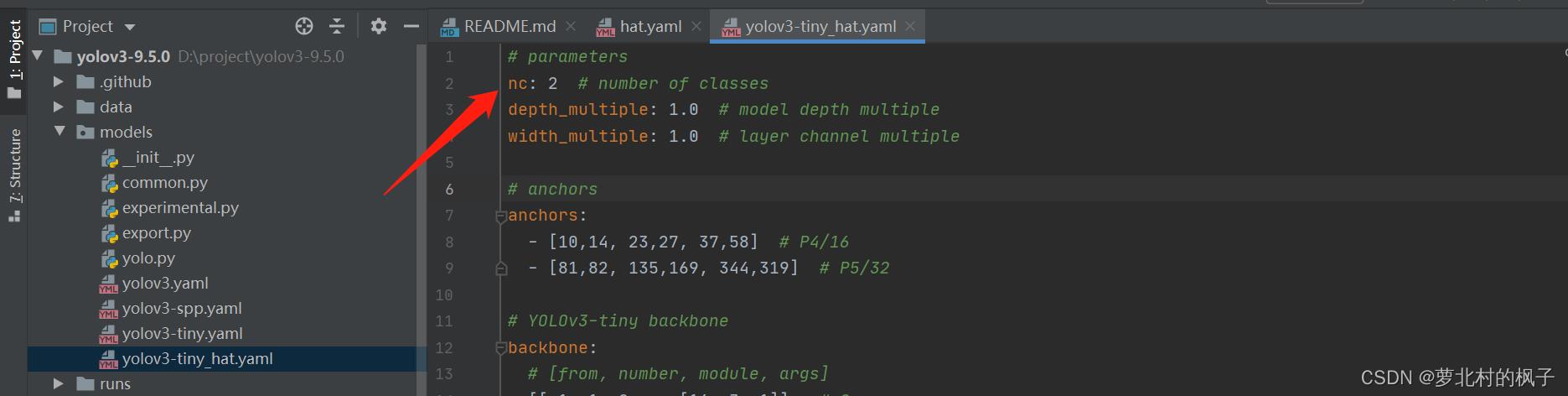

2.打开yolov3-tiny_hat.yaml文件,将number of classes改为数据集标签的种类(本文数据集识别种类为两类)

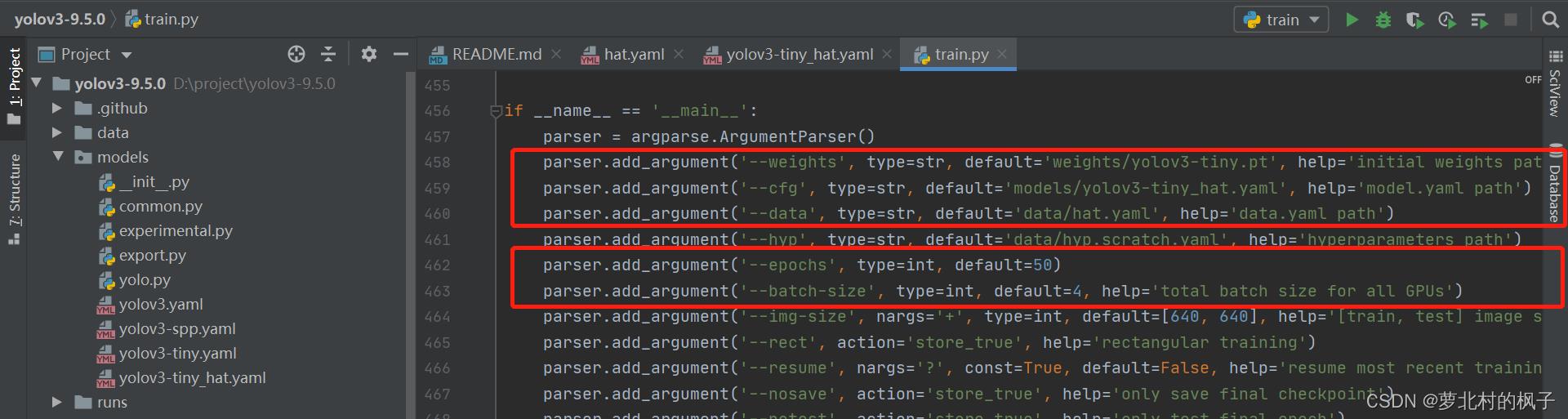

(3)train.py主函数修改

主要修改以下五个函数:

–weights:初始化的权重文件的路径地址

–cfg:模型yaml文件的路径地址

–data:数据yaml文件的路径地址

–epochs:训练次数

–batch-size:一轮训练的文件个数

1.打开train.py,作以下修改:

修改"–weights"中权重文件地址为文件yolov3-tiny.pt的地址

修改"–cfg"中模型yaml文件的地址为文件yolov3-tiny_hat.yaml的地址

修改"–data"中数据yaml文件的地址为文件hat.yaml的地址

parser.add_argument('--weights', type=str, default='weights/yolov3-tiny.pt', help='initial weights path')

parser.add_argument('--cfg', type=str, default='models/yolov3-tiny_hat.yaml', help='model.yaml path')

parser.add_argument('--data', type=str, default='data/hat.yaml', help='data.yaml path')

如下图所示:

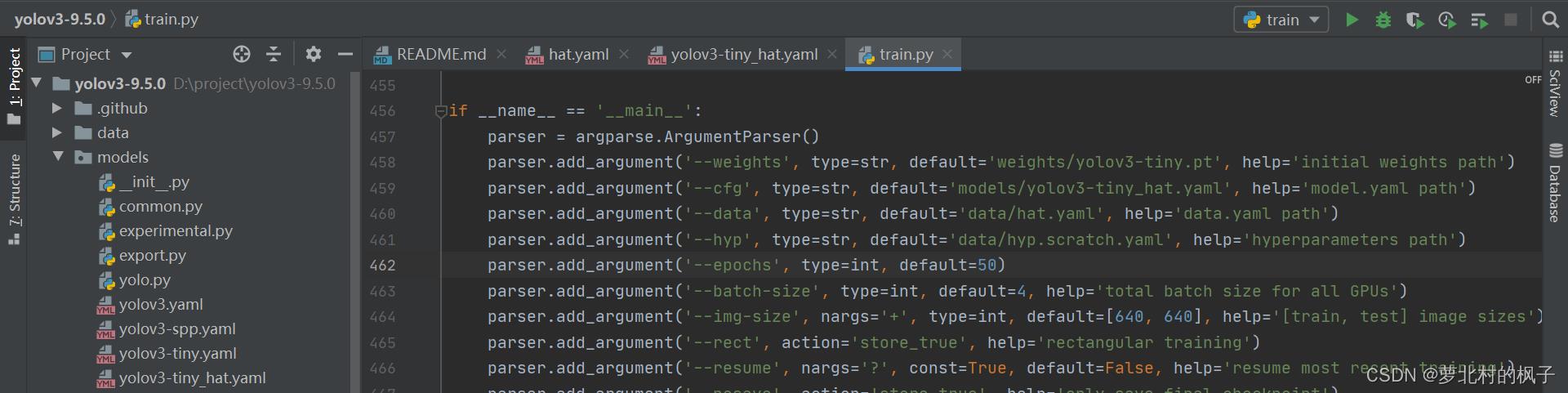

" --epochs"和"–batch-size"的数值可以根据GPU情况自行设置

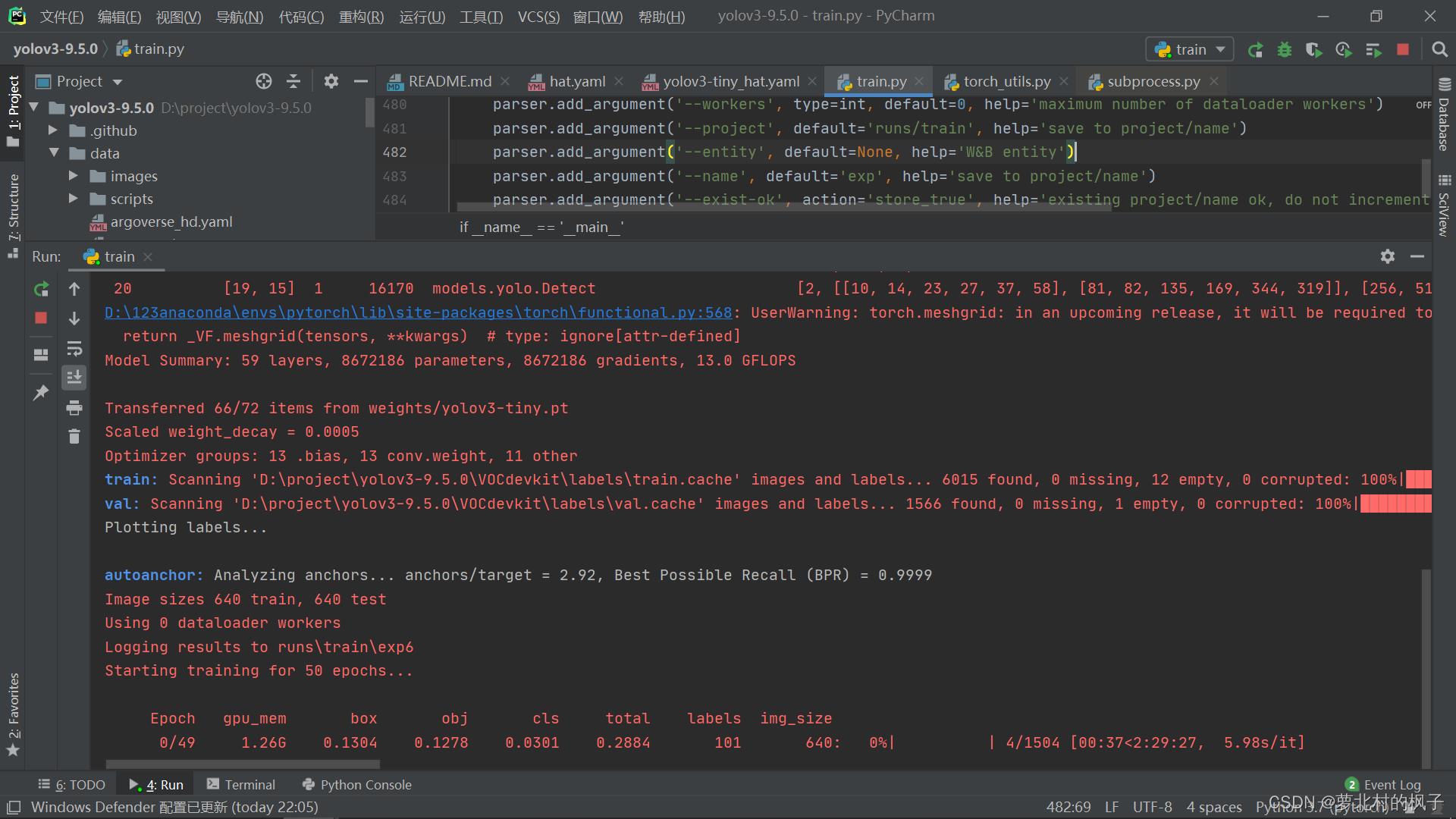

2.运行train.py,开始训练模型

在加载完train和val的数据集之后,可以看到模型开始训练~

(4)模型训练可能遇到的问题

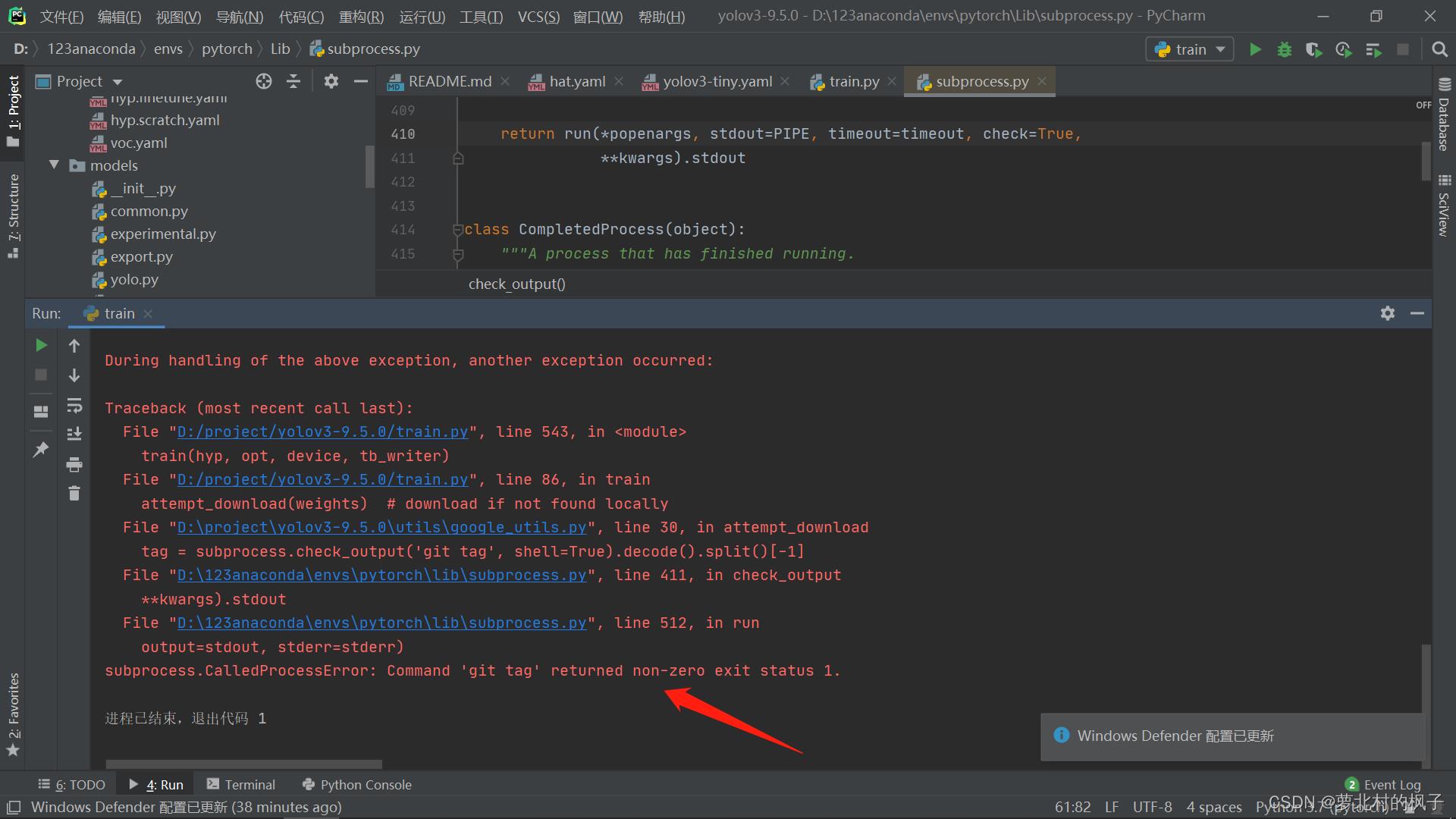

1.遇到错误 subprocess.CalledProcessError: Command ‘git tag’ returned non-zero exit status 1.

如下图所示:

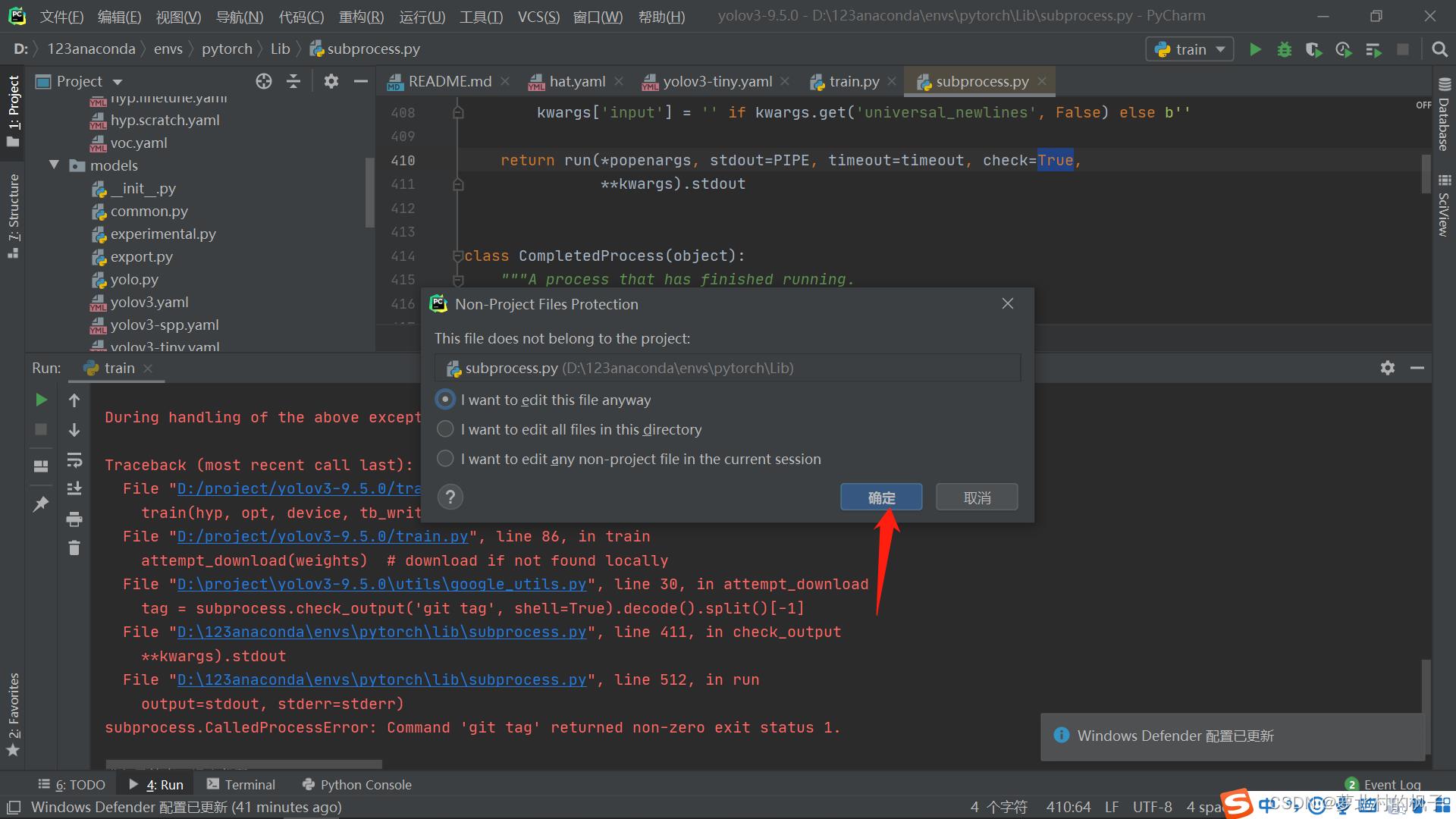

解决方法:

打开subprocess.py文件,在第410行,将check值修改为False

点击确定即可

2.遇到错误 UnicodeDecodeError:: ‘utf-8’ codec can’t decode byte 0xc8 in position 0: invalid contin

如下图所示:

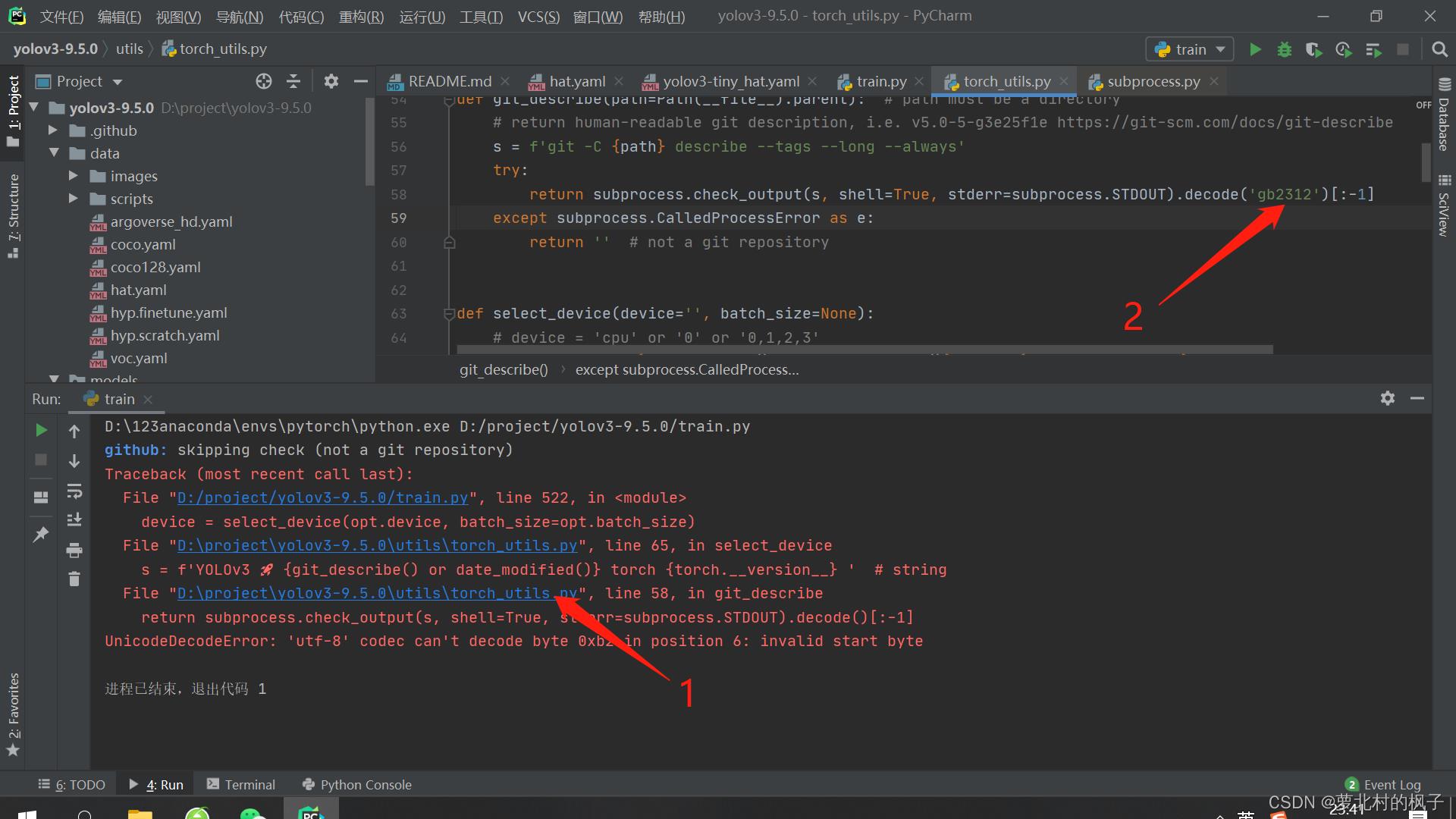

解决方法:

打开torch_utils.py,在第58行将编码方式改为decode(‘gb2312’)

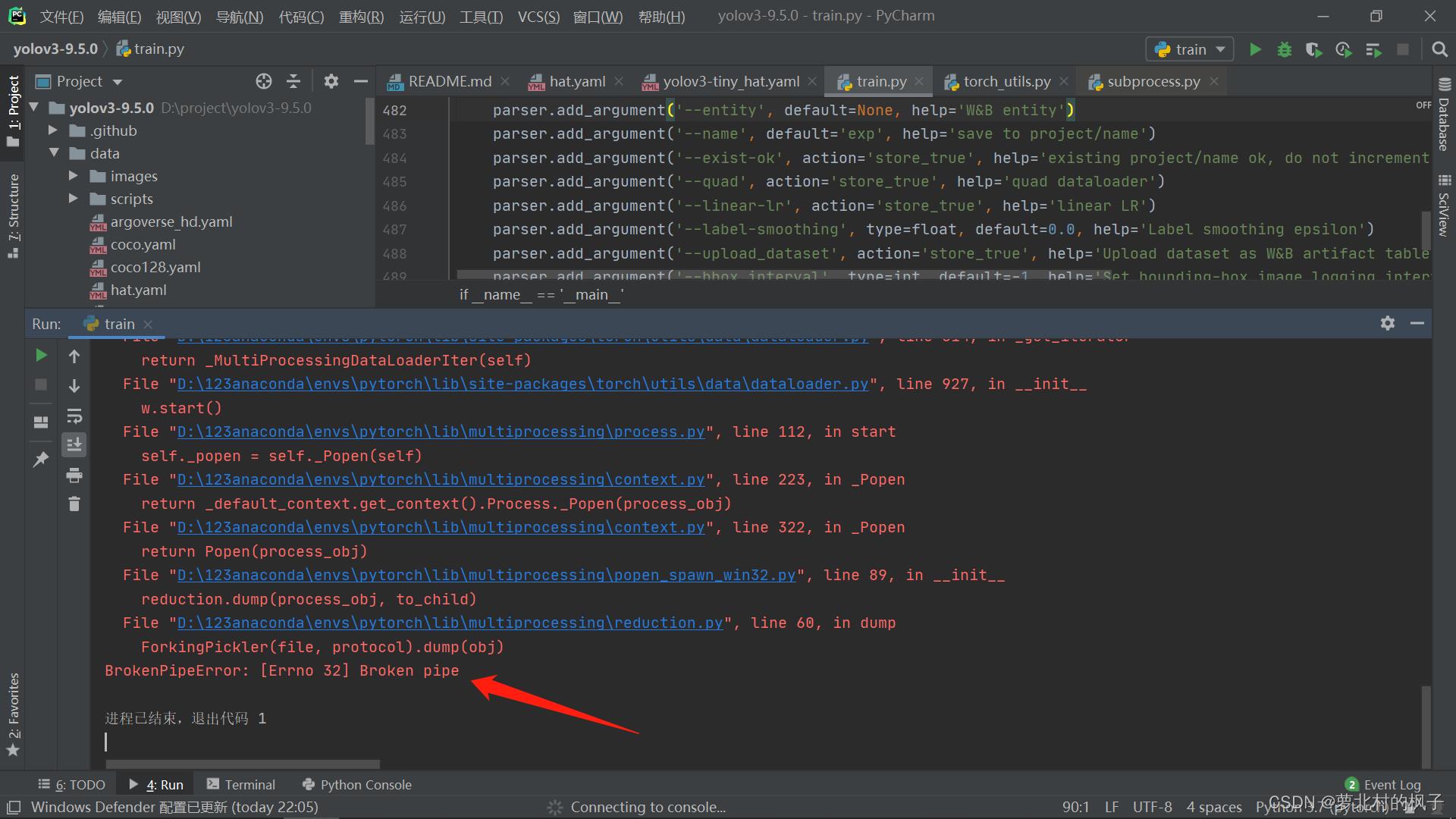

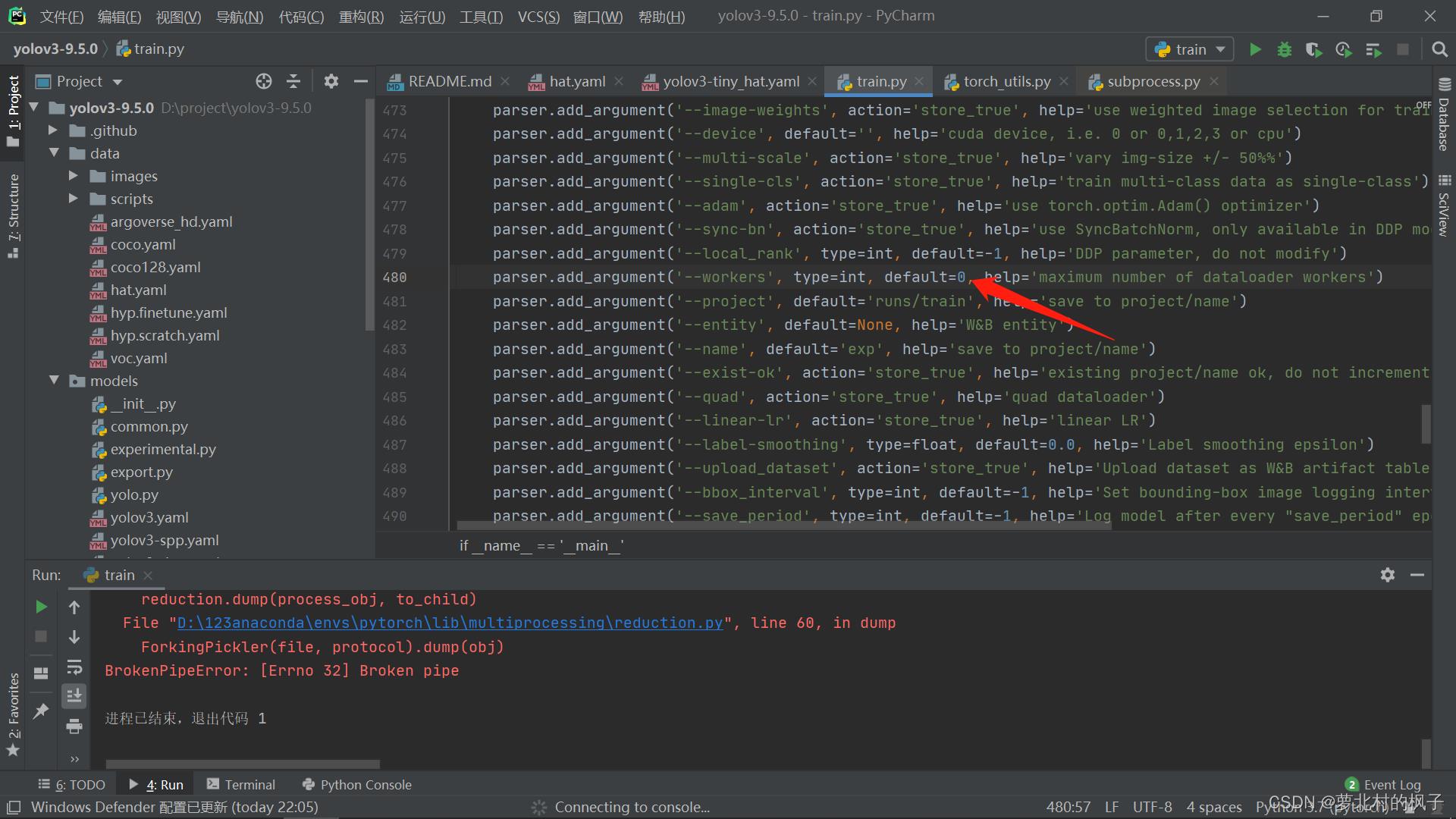

3.遇到错误 BrokenPipeError: [Errno 32] Broken pipe

如下图所示:

解决方法:

在第488行,将’–workers’的值改为0

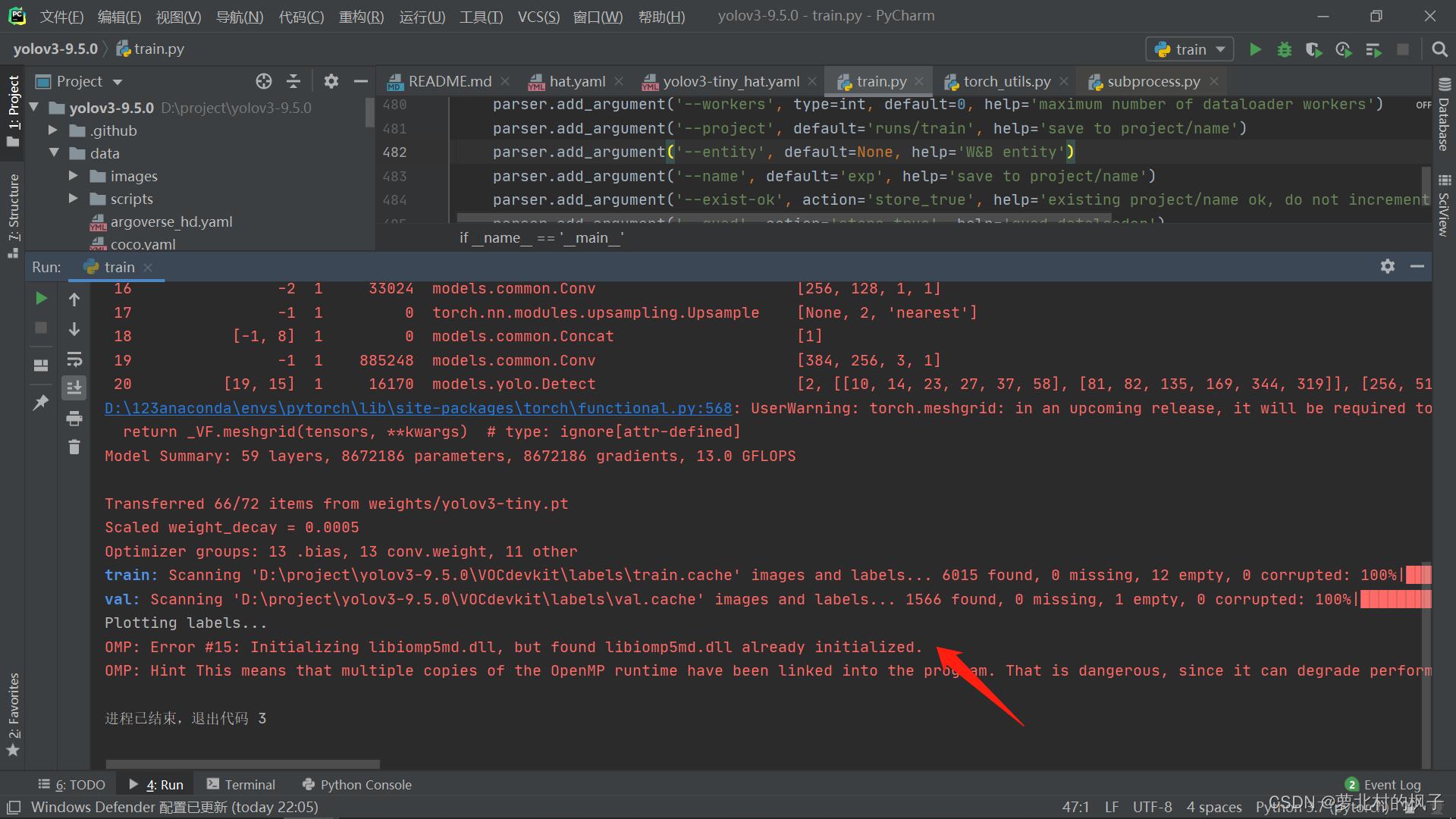

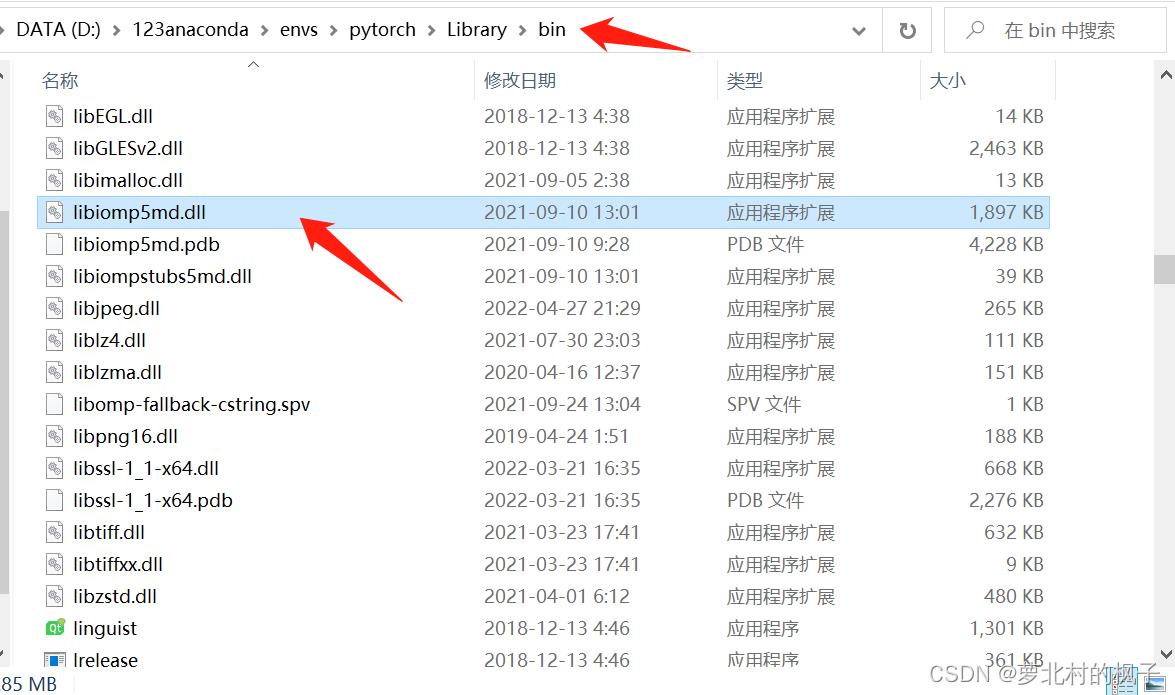

4.遇到错误 OMP: Error #15: Initializing libiomp5md.dll, but found libiomp5md.dll already initialized.

如下图所示:

解决方法:

在anaconda安装目录的envs文件夹下,找到pytorch环境,进入library的bin文件夹,删除libiomp5md.dll文件

五、测试结果

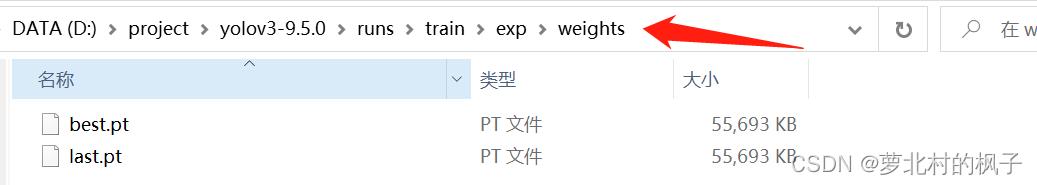

训练结束之后,在runs/train/exp/weights目录下会产生两个权重文件,一个是训练效果最好的权重文件,一个是训练最后一轮的权重文件

(接下来以best.pt权重文件为例)

(1)图片测试步骤

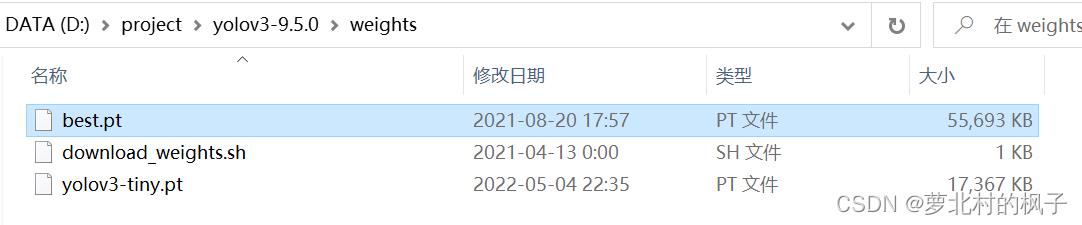

1.将best.pt权重文件复制粘贴在主目录的weights文件夹下(方便后续操作)

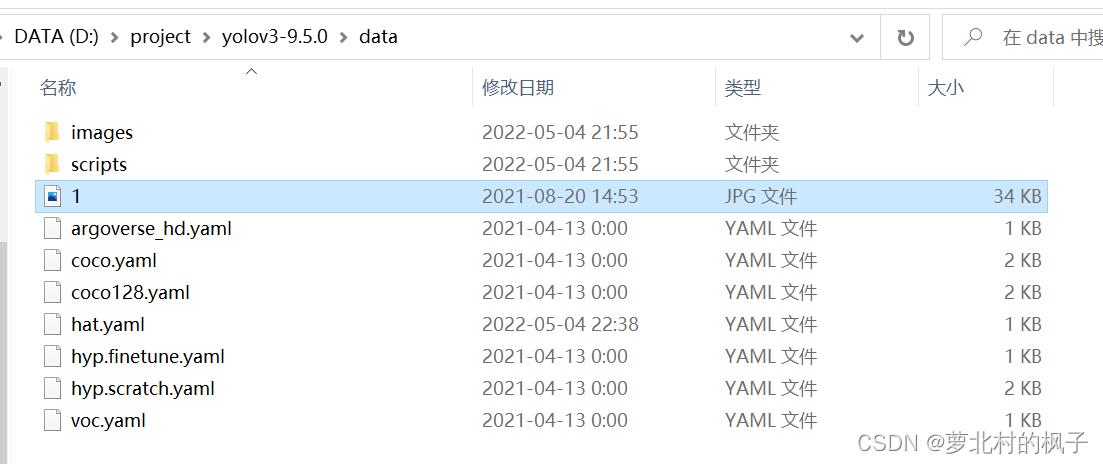

2.将想进行测试的图片放在主目录的data文件夹下,如图所示:

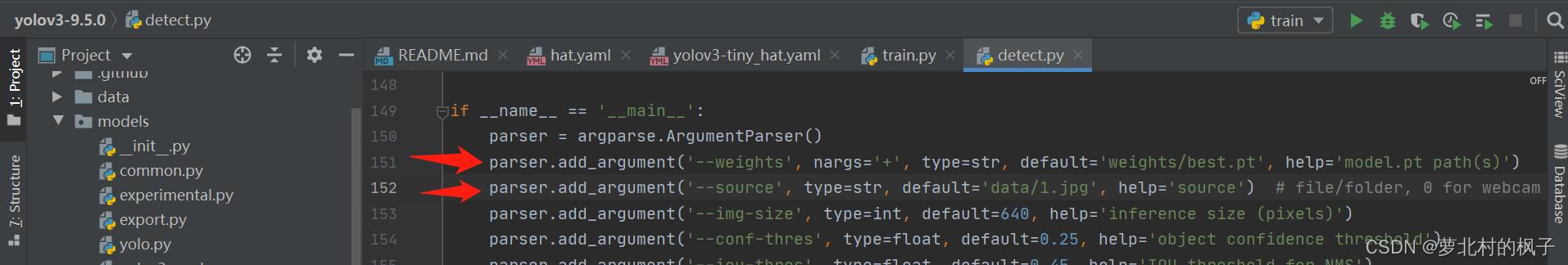

3.打开defect.py,更改以下部分:

将"–weight"改为best.pt权重文件的地址(在weights文件夹中)

将"–source"改为要测试的图片地址(在data文件夹中)

parser.add_argument('--weights', nargs='+', type=str, default='weights/best.pt', help='model.pt path(s)')

parser.add_argument('--source', type=str, default='data/1.jpg', help='source') # file/folder, 0 for webcam

如图所示:

4.运行defect.py,即可得到结果;

5.如果识别视频,在将"–source"改为要测试的视频地址即可(注意加.mp4后缀名)

如果识别摄像头,在将"–source"的值置0即可,即:

parser.add_argument('--source', type=str, default='0', help='source') # file/folder, 0 for webcam

Yolov5训练自己的数据集(详细完整版)

文章目录

一. 环境

本教程使用环境:

-

pytorch: 1.10.0

-

python: 3.9

ps: 如果要使用GPU,cuda版本要 >=10.1

下载安装yolov5:

yolov5官方要求 Python>=3.6 and PyTorch>=1.7

yolov5源码下载:https://github.com/ultralytics/yolov5

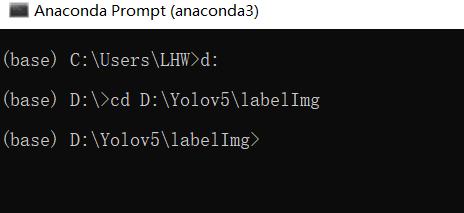

下载后,进入pytorch环境进入yolov5文件夹

使用换源的方法安装依赖。如果你前面安装时没有换源,我强烈建议你使用换源的方法在安装一次

安装过的模块不会在安装,以防缺少模块,影响后续程序运行以及模型训练。

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple

因为本教程主详细讲解训练自己的数据集,避免篇幅过多,因此这里不详细说明了。

二. 准备工作

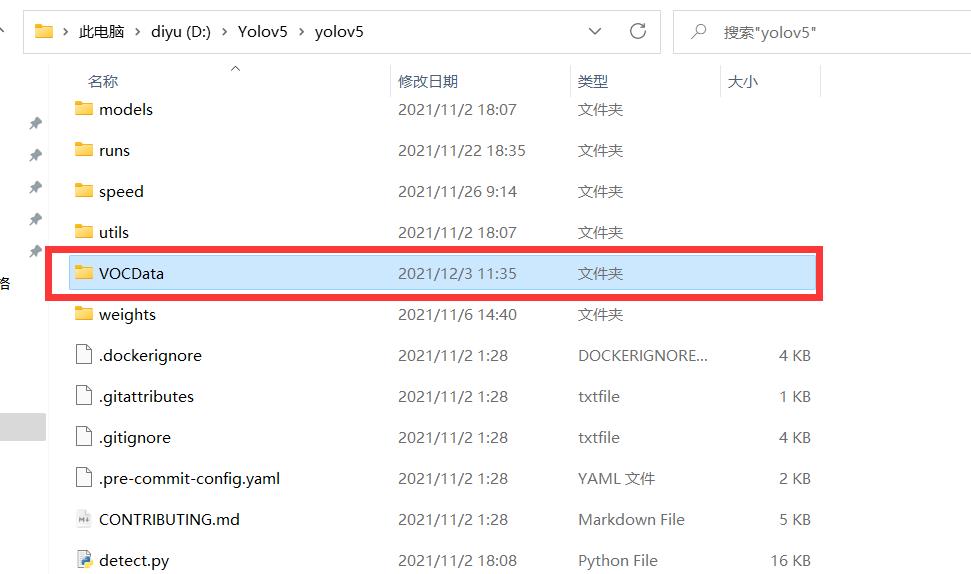

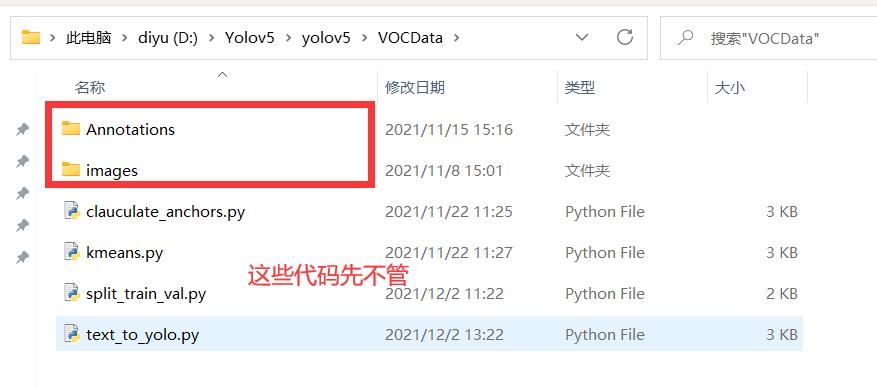

- 在 yolov5目录下 新建文件夹 VOCData

- 新建两个文件夹 Annotations 以及 images

images:用于存放要标注的图片(jpg格式)

Annotations :用于存放标注图片后产生的内容(这里采用XML格式)

后续使用代码保存位置如图

本教程需要用到图中的四个代码文件,这里先不用管,后面会给出代码。

这里提供本人编写的python代码,用于将视频转图片。

只需更改两个参数,视频路径以及间隔多少帧取图片。

代码运行,需要装有opencv模块,装opencv模块前需要装numpy模块。

所以,你可以选择进入pytorch环境进入代码所在文件夹,用命令行形式运行程序。

三. 使用labelImg标注图片

1. 安装labellmg

labelImg下载:https://github.com/tzutalin/labelImg

各种安装方法都在此链接中,这里只给出 windows +aconda 进行安装。

aconda安装可以查看我的另一篇博客

最新安装anaconda与tensorflow、pytorch(详细完整版)

ps: 如果你进入不了github,这里给出百度网盘链接

labellImg百度网盘链接:https://pan.baidu.com/s/1oQroHL94vMhX7bDTX79RGw

提取码:1jbq

此labelImg是采用命令行形式运行,需要使用命令行安装一些依赖。

如果你认为这个太麻烦,网上有人打包好了此软件,可以自行去下载。

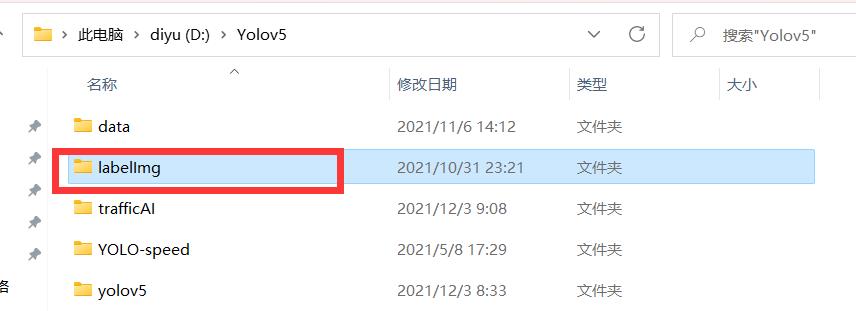

本人labellmg存放位置

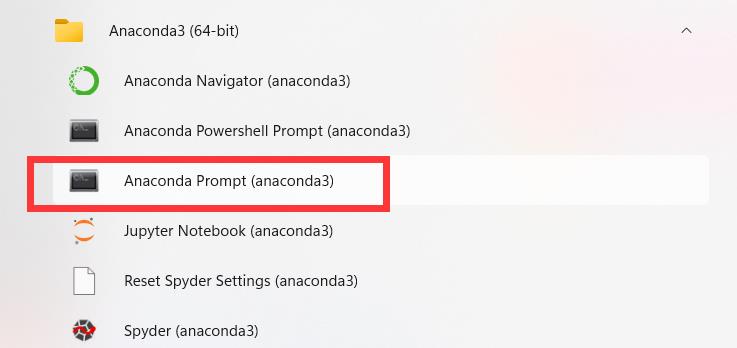

打开 aconda prompt (类似于cmd)

进入 labellmg文件夹

我建议就在base环境下进行安装labellmg,方便一点,你也可以进入pytorch环境下安装。

在哪个环境安装的就在哪个环境下启动软件。

执行命令前,建议更新一下conda

conda update -n base -c defaults conda

-n:指定更新哪个环境的conda,这里是base环境

依次执行下面命令 (不要连接外网)

conda install pyqt=5

conda install -c anaconda lxml

pyrcc5 -o libs/resources.py resources.qrc

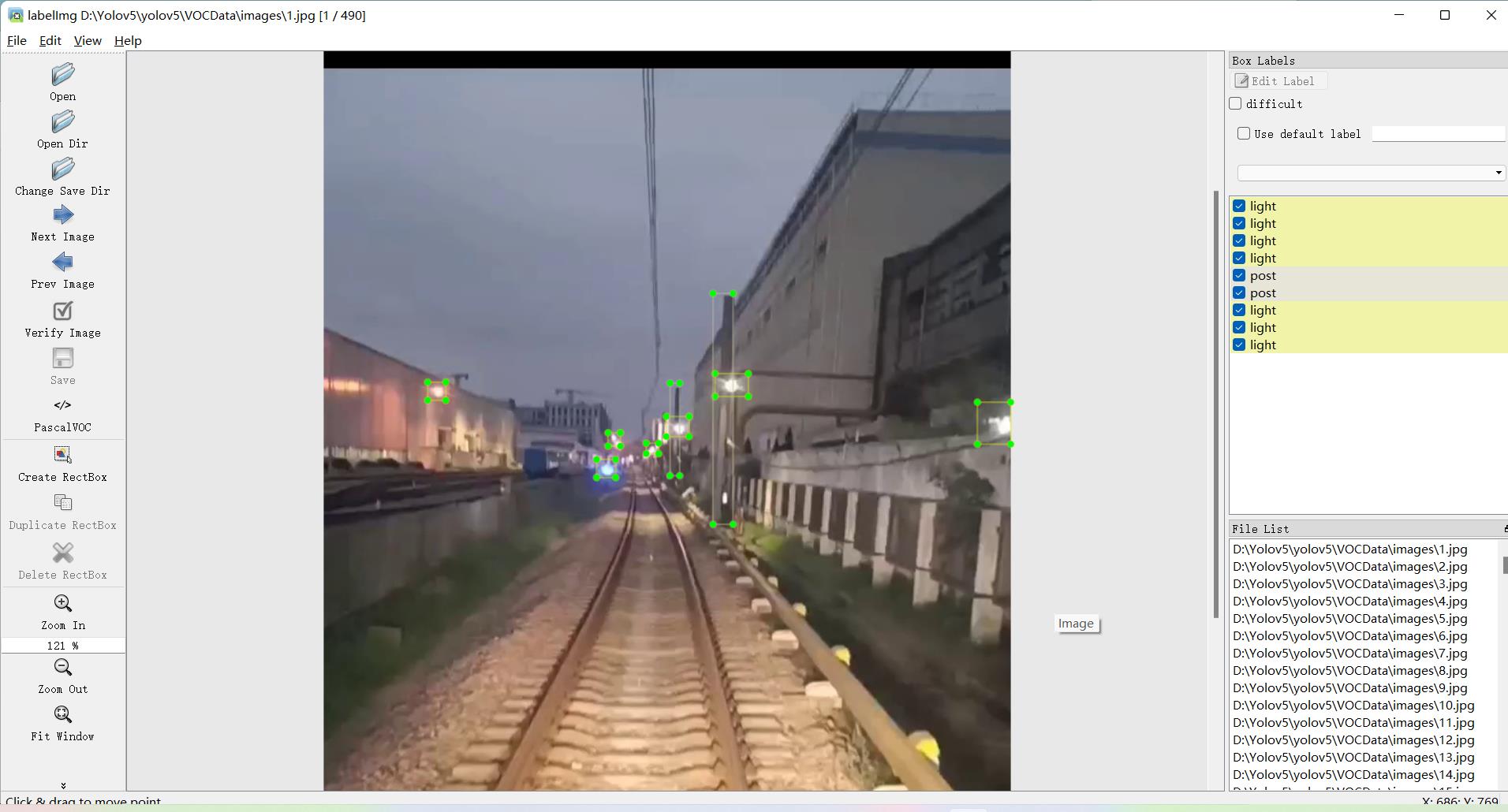

2. 使用labellmg

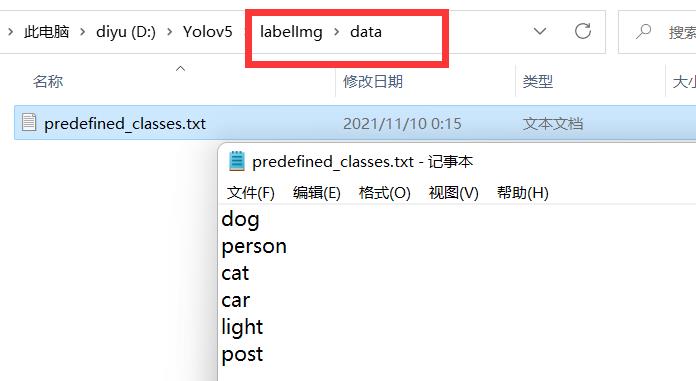

运行软件前可以更改下要标注的类别。

也可以进入软件后添加,不过那样每次进入软件都要添加,麻烦。

打开labellmg(要进入labellmg文件夹)

python labelImg.py #运行软件

勾选 auto save mode 自动保存

格式就默认是XML格式,可以更改成yolo,这里就使用默认的XML格式

点击左方边栏或者屏幕右键选择 Create RectBox 即可进行标注。

尽可能的完全拟合标注物体,建议放大标注

其它看个人标准。

四. 划分数据集以及配置文件修改

运行代码方式

-

第一种:使用pycharm、vscode、python自带的IDLE。如果出现缺少模块的情况(no module named),你可以安装模块,也可以使用后一种方法。

-

第二种:进入pytorch环境,进入代码所在目录,使用命令行形式运行(python + 程序名)

1. 划分训练集、验证集、测试集

在VOCData目录下创建程序 split_train_val.py 并运行

程序如下:(可以不更改)

# coding:utf-8

import os

import random

import argparse

parser = argparse.ArgumentParser()

#xml文件的地址,根据自己的数据进行修改 xml一般存放在Annotations下

parser.add_argument('--xml_path', default='Annotations', type=str, help='input xml label path')

#数据集的划分,地址选择自己数据下的ImageSets/Main

parser.add_argument('--txt_path', default='ImageSets/Main', type=str, help='output txt label path')

opt = parser.parse_args()

trainval_percent = 1.0 # 训练集和验证集所占比例。 这里没有划分测试集

train_percent = 0.9 # 训练集所占比例,可自己进行调整

xmlfilepath = opt.xml_path

txtsavepath = opt.txt_path

total_xml = os.listdir(xmlfilepath)

if not os.path.exists(txtsavepath):

os.makedirs(txtsavepath)

num = len(total_xml)

list_index = range(num)

tv = int(num * trainval_percent)

tr = int(tv * train_percent)

trainval = random.sample(list_index, tv)

train = random.sample(trainval, tr)

file_trainval = open(txtsavepath + '/trainval.txt', 'w')

file_test = open(txtsavepath + '/test.txt', 'w')

file_train = open(txtsavepath + '/train.txt', 'w')

file_val = open(txtsavepath + '/val.txt', 'w')

for i in list_index:

name = total_xml[i][:-4] + '\\n'

if i in trainval:

file_trainval.write(name)

if i in train:

file_train.write(name)

else:

file_val.write(name)

else:

file_test.write(name)

file_trainval.close()

file_train.close()

file_val.close()

file_test.close()

运行完毕后 会生成 ImagesSets\\Main 文件夹,且在其下生成 测试集、训练集、验证集,存放图片的名字(无后缀.jpg)

由于没有分配测试集,所以测试集为空。

若要分配,更改第 14、15 行代码,更改所在比例即可。

2. XML格式转yolo_txt格式

在VOCData目录下创建程序 text_to_yolo.py 并运行

程序如下:

需要将第 7 行改成自己所标注的类别 以及 代码中各文件绝对路径

路径需为:d:\\\\images 或者 d:/images

# -*- coding: utf-8 -*-

import xml.etree.ElementTree as ET

import os

from os import getcwd

sets = ['train', 'val', 'test']

classes = ["light", "post"] # 改成自己的类别

abs_path = os.getcwd()

print(abs_path)

def convert(size, box):

dw = 1. / (size[0])

dh = 1. / (size[1])

x = (box[0] + box[1]) / 2.0 - 1

y = (box[2] + box[3]) / 2.0 - 1

w = box[1] - box[0]

h = box[3] - box[2]

x = x * dw

w = w * dw

y = y * dh

h = h * dh

return x, y, w, h

def convert_annotation(image_id):

in_file = open('D:/Yolov5/yolov5/VOCData/Annotations/%s.xml' % (image_id), encoding='UTF-8')

out_file = open('D:/Yolov5/yolov5/VOCData/labels/%s.txt' % (image_id), 'w')

tree = ET.parse(in_file)

root = tree.getroot()

size = root.find('size')

w = int(size.find('width').text)

h = int(size.find('height').text)

for obj in root.iter('object'):

difficult = obj.find('difficult').text

#difficult = obj.find('Difficult').text

cls = obj.find('name').text

if cls not in classes or int(difficult) == 1:

continue

cls_id = classes.index(cls)

xmlbox = obj.find('bndbox')

b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text), float(xmlbox.find('ymin').text),

float(xmlbox.find('ymax').text))

b1, b2, b3, b4 = b

# 标注越界修正

if b2 > w:

b2 = w

if b4 > h:

b4 = h

b = (b1, b2, b3, b4)

bb = convert((w, h), b)

out_file.write(str(cls_id) + " " + " ".join([str(a) for a in bb]) + '\\n')

wd = getcwd()

for image_set in sets:

if not os.path.exists('D:/Yolov5/yolov5/VOCData/labels/'):

os.makedirs('D:/Yolov5/yolov5/VOCData/labels/')

image_ids = open('D:/Yolov5/yolov5/VOCData/ImageSets/Main/%s.txt' % (image_set)).read().strip().split()

if not os.path.exists('D:/Yolov5/yolov5/VOCData/dataSet_path/'):

os.makedirs('D:/Yolov5/yolov5/VOCData/dataSet_path/')

list_file = open('dataSet_path/%s.txt' % (image_set), 'w')

for image_id in image_ids:

list_file.write('D:/Yolov5/yolov5/VOCData/images/%s.jpg\\n' % (image_id))

convert_annotation(image_id)

list_file.close()

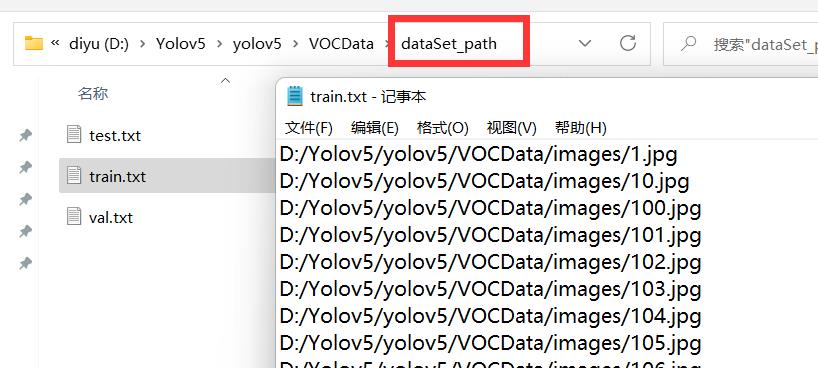

运行后会生成如下 labels 文件夹和 dataSet_path 文件夹。

其中 labels 中为不同图像的标注文件。每个图像对应一个txt文件,文件每一行为一个目标的信息,包括class, x_center, y_center, width, height格式,这种即为 yolo_txt格式

dataSet_path文件夹包含三个数据集的txt文件,train.txt等txt文件为划分后图像所在位置的绝对路径,如train.txt就含有所有训练集图像的绝对路径。

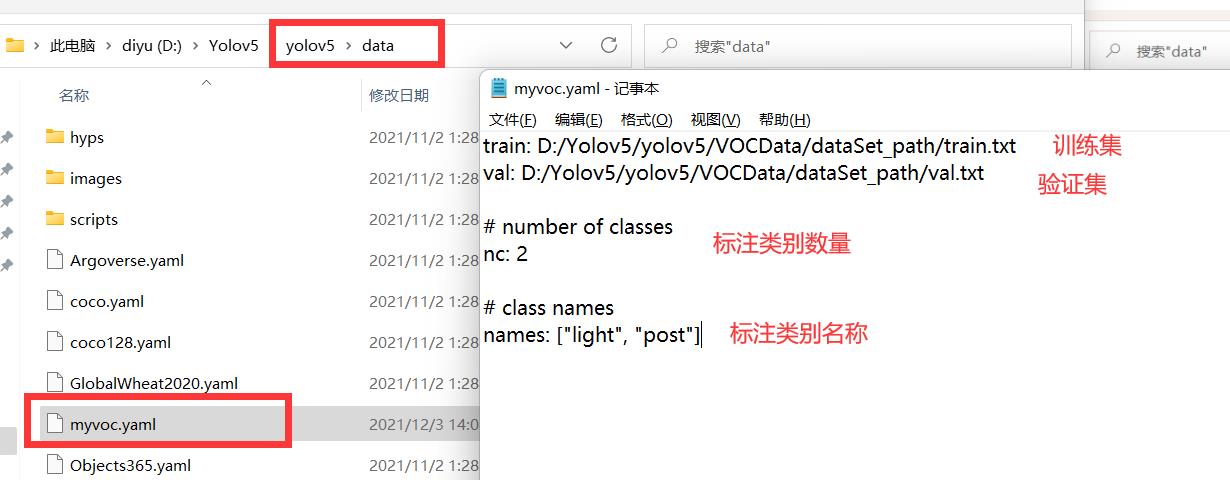

3. 配置文件

在 yolov5 目录下的 data 文件夹下 新建一个 myvoc.yaml文件(可以自定义命名),用记事本打开。

内容是:训练集以及验证集(train.txt和val.txt)绝对路径(通过 text_to_yolo.py 生成),然后是目标的类别数目和类别名称。

给出模板: 冒号后面需要加空格

train: D:/Yolov5/yolov5/VOCData/dataSet_path/train.txt

val: D:/Yolov5/yolov5/VOCData/dataSet_path/val.txt

# number of classes

nc: 2

# class names

names: ["light", "post"]

3. 聚类获得先验框

3.1 生成anchors文件

在VOCData目录下创建程序两个程序 kmeans.py 以及 clauculate_anchors.py

不需要运行 kmeans.py,运行 clauculate_anchors.py 即可。

kmeans.py 程序如下:这不需要运行,也不需要更改

如果报错,查看第 13 行内容

import numpy as np

def iou(box, clusters):

"""

Calculates the Intersection over Union (IoU) between a box and k clusters.

:param box: tuple or array, shifted to the origin (i. e. width and height)

:param clusters: numpy array of shape (k, 2) where k is the number of clusters

:return: numpy array of shape (k, 0) where k is the number of clusters

"""

x = np.minimum(clusters[:, 0], box[0])

y = np.minimum(clusters[:, 1], box[1])

if np.count_nonzero(x == 0) > 0 or np.count_nonzero(y == 0) > 0:

raise ValueError("Box has no area") # 如果报这个错,可以把这行改成pass即可

intersection = x * y

box_area = box[0] * box[1]

cluster_area = clusters[:, 0] * clusters[:, 1]

iou_ = intersection / (box_area + cluster_area - intersection)

return iou_

def avg_iou(boxes, clusters):

"""

Calculates the average Intersection over Union (IoU) between a numpy array of boxes and k clusters.

:param boxes: numpy array of shape (r, 2), where r is the number of rows

:param clusters: numpy array of shape (k, 2) where k is the number of clusters

:return: average IoU as a single float

"""

return np.mean([np.max(iou(boxes[i], clusters)) for i in range(boxes.shape[0])])

def translate_boxes(boxes):

"""

Translates all the boxes to the origin.

:param boxes: numpy array of shape (r, 4)

:return: numpy array of shape (r, 2)

"""

new_boxes = boxes.copy()

for row in range(new_boxes.shape[0]):

new_boxes[row][2] = np.abs(new_boxes[row][2] - new_boxes[row][0])

new_boxes[row][3] = np.abs(new_boxes[row][3] - new_boxes[row][1])

return np.delete(new_boxes, [0, 1], axis=1)

def kmeans(boxes, k, dist=np.median):

"""

Calculates k-means clustering with the Intersection over Union (IoU) metric.

:param boxes: numpy array of shape (r, 2), where r is the number of rows

:param k: number of clusters

:param dist: distance function

:return: numpy array of shape (k, 2)

"""

rows = boxes.shape[0]

distances = np.empty((rows, k))

last_clusters = np.zeros((rows,))

np.random.seed()

# the Forgy method will fail if the whole array contains the same rows

clusters = boxes[np.random.choice(rows, k, replace=False)]

while True:

for row in range(rows):

distances[row] = 1 - iou(boxes[row], clusters)

nearest_clusters = np.argmin(distances, axis=1)

if (last_clusters == nearest_clusters).all():

break

for cluster in range(k):

clusters[cluster] = dist(boxes[nearest_clusters == cluster], axis=0)

last_clusters = nearest_clusters

return clusters

if __name__ == '__main__':

a = np.array([[1, 2, 3, 4], [5, 7, 6, 8]])

print(translate_boxes(a))

运行:clauculate_anchors.py

会调用 kmeans.py 聚类生成新anchors的文件

程序如下:

需要更改第 9 、13行文件路径 以及 第 16 行标注类别名称

# -*- coding: utf-8 -*-

# 根据标签文件求先验框

import os

import numpy as np

import xml.etree.cElementTree as et

from kmeans import kmeans, avg_iou

FILE_ROOT = "D:/Yolov5/yolov5/VOCData/" # 根路径

ANNOTATION_ROOT = "Annotations" # 数据集标签文件夹路径

ANNOTATION_PATH = FILE_ROOT + ANNOTATION_ROOT

ANCHORS_TXT_PATH = "D:/Yolov5/yolov5/VOCData/anchors.txt" #anchors文件保存位置

CLUSTERS = 9

CLASS_NAMES = ['light', 'post'] #类别名称

def load_data(anno_dir, class_names):

xml_names = os.listdir(anno_dir)

boxes = []

for xml_name in xml_names:

xml_pth = os.path.join(anno_dir, xml_name)

tree = et.parse(xml_pth)

width = float(tree.findtext("./size/width"))

height = float(tree.findtext("./size/height"))

for obj in tree.findall("./object"):

cls_name = obj.findtext("name")

if cls_name in class_names:

xmin = float(obj.findtext("bndbox/xmin")) / width

ymin = float(obj.findtext("bndbox/ymin")) / height

xmax = float(obj.findtext("bndbox/xmax")) / width

ymax = float(obj.findtext("bndbox/ymax")) / height

box = [xmax - xmin, ymax - ymin]

boxes.append(box)

else:

continue

return np.array(boxes)

if __name__ == '__main__':

anchors_txt = open(ANCHORS_TXT_PATH, "w")

train_boxes = load_data(ANNOTATION_PATH, CLASS_NAMES)

count = 1

best_accuracy = 0

best_anchors = []

best_ratios = []

for i in range(10): ##### 可以修改,不要太大,否则时间很长

anchors_tmp = []

clusters = kmeans(train_boxes, k=CLUSTERS)

idx = clusters[:, 0].argsort()

clusters = clusters[idx]

# print(clusters)

for j in range(CLUSTERS):

anchor = [round(clusters[j][0] * 640, 2), round(clusters[j][1] * 640, 2)]

anchors_tmp.append(anchor)

print(f"Anchors:anchor")

temp_accuracy = avg_iou(train_boxes, clusters) * 100

print("Train_Accuracy::.2f%".format(temp_accuracy)