太详细了,在 Windows 上安装 PySpark 保姆级教程

Posted Python数据开发

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了太详细了,在 Windows 上安装 PySpark 保姆级教程相关的知识,希望对你有一定的参考价值。

在本文中,我将和大家一起学习如何在 Windows 上安装和运行 PySpark,以及如何使用 Web UI 启动历史服务器和监控 Jobs。

安装 Python 或 Anaconda 发行版

https://www.python.org/downloads/windows/

从 Python.org 或 Anaconda 发行版 下载并安装 Python, 其中包括 Python、Spyder IDE 和 Jupyter notebook。我建议使用 Anaconda,因为它很受机器学习和数据科学社区的欢迎和使用。

https://www.anaconda.com/

推荐使用 Anaconda 安装 PySpark 并运行 Jupyter notebook。

技术提升

本文由技术群粉丝分享,项目源码、数据、技术交流提升,均可加交流群获取,群友已超过2000人,添加时最好的备注方式为:来源+兴趣方向,方便找到志同道合的朋友

方式①、添加微信号:dkl88191,备注:来自CSDN +研究方向

方式②、微信搜索公众号:Python学习与数据挖掘,后台回复:加群

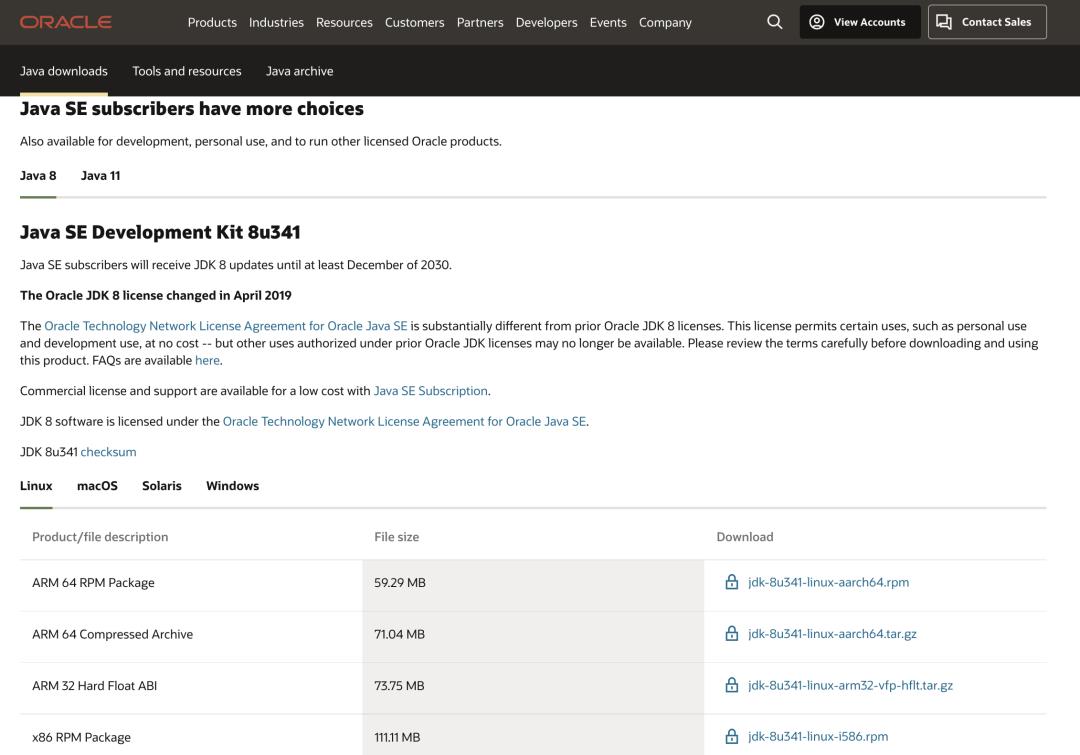

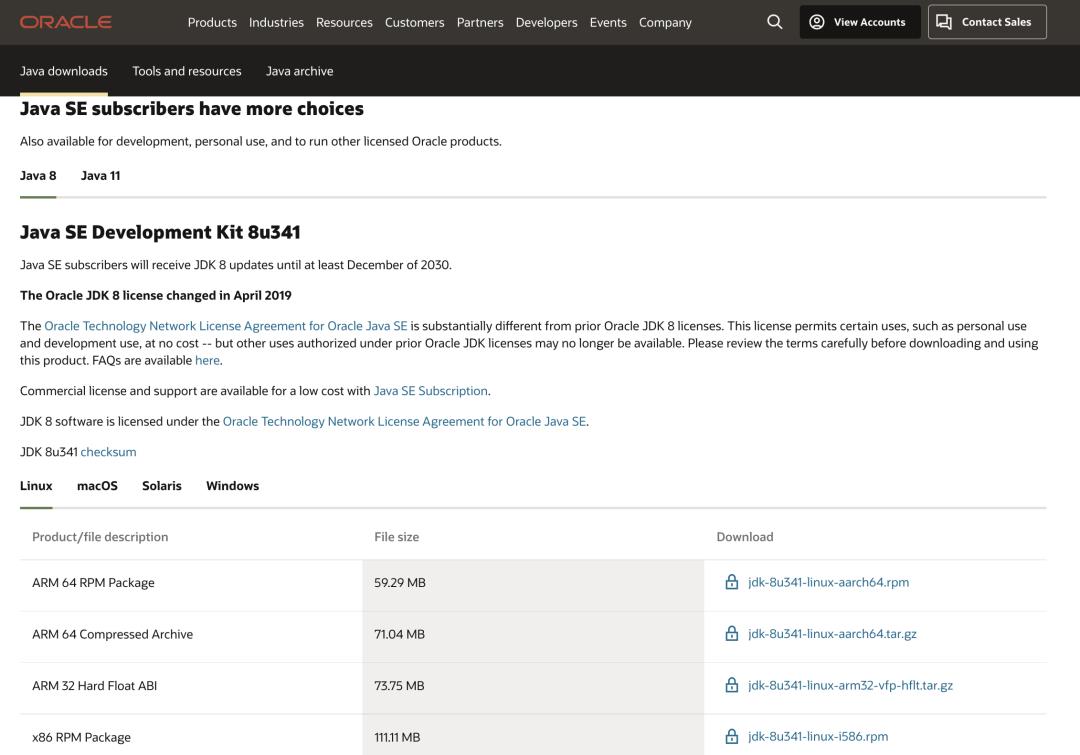

安装 Java 8

要运行 PySpark 应用程序,需要 Java 8 或更高版本,因此从 Oracle 下载 Java 版本并将其安装在系统上。

https://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html

安装后设置 JAVA_HOME 和 PATH 变量。

JAVA_HOME = C:\\Program Files\\Java\\jdk1.8.0_201

PATH = %PATH%;C:\\Program Files\\Java\\jdk1.8.0_201\\bin

在 Windows 上安装 PySpark

PySpark 是一个用 Python 编写的 Spark 库,用于使用 Apache Spark 功能运行 Python 应用程序。所以没有 PySpark 库可供下载。一切只需要 Spark。按照以下步骤在 Windows 上安装 PySpark。

1. 在Spark下载页面,选择 Download Spark (第3点) 链接进行下载。如果你想使用其他版本的 Spark 和 Hadoop,请从下拉列表中选择你想要的版本,第 3 点上的链接会更改为所选版本,并为你提供更新的下载链接。

https://spark.apache.org/downloads.html

2. 下载后,解压二进制文件并将底层文件夹复制 spark-3.0.0-bin-hadoop2.7 到 c:\\apps

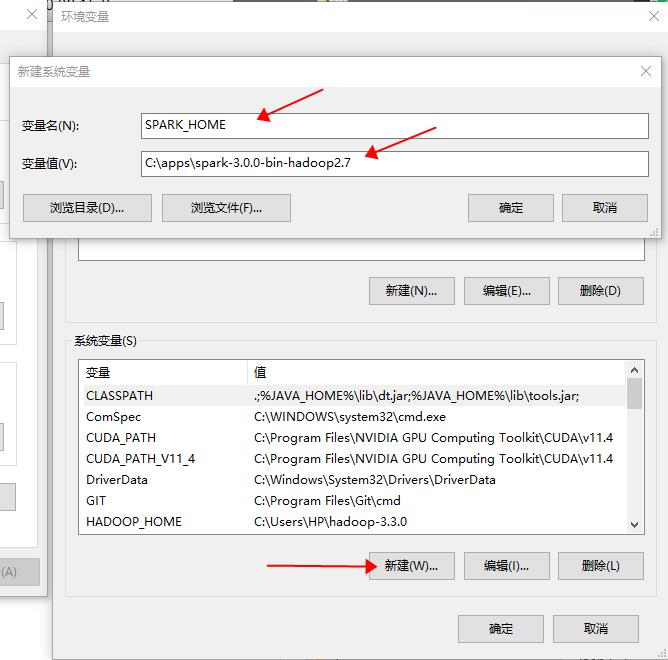

3. 现在设置以下环境变量。

SPARK_HOME = C:\\apps\\spark-3.0.0-bin-hadoop2.7

HADOOP_HOME = C:\\apps\\spark-3.0.0-bin-hadoop2.7

PATH=%PATH%;C:\\apps\\spark-3.0.0-bin-hadoop2.7\\bin

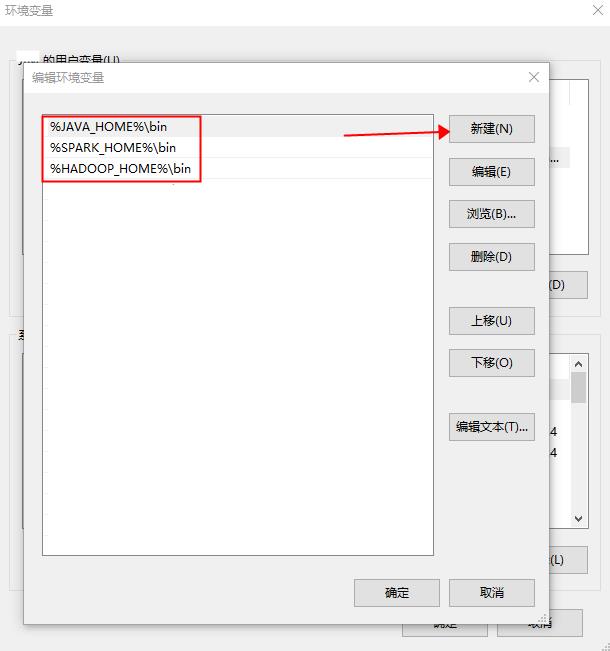

如果你还不知道如何在 Windows 上添加或编辑环境变量,请按照以下步骤操作。

1.打开编辑系统环境变量窗口,在高级选项卡下选择环境变量。

编辑系统环境变量

2.在以下环境变量屏幕上,通过选择新建选项添加 SPARK_HOME、 HADOOP_HOME 及 JAVA_HOME

3. 这将打开用户变量窗口,可以在其中输入变量名称和值。

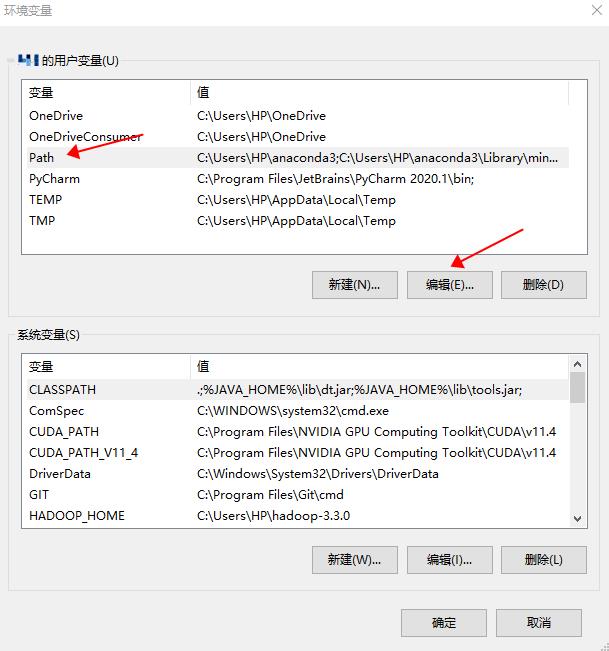

4.现在编辑PATH变量

5. 通过选择新建选项添加 Spark、Java 和 Hadoop bin 路径。

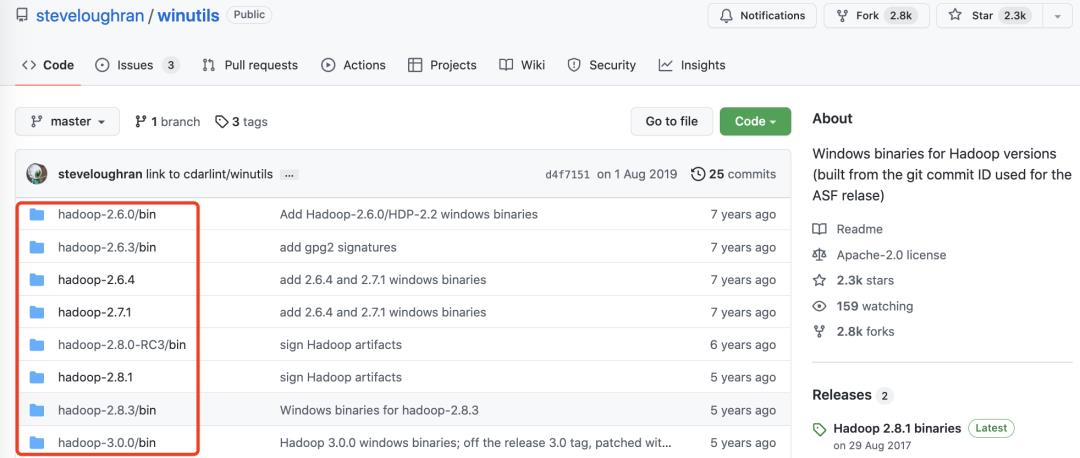

在 Windows 上安装 winutils.exe

从winutils 下载 winutils.exe 文件 ,并将其复制到%SPARK_HOME%\\bin文件夹中。Winutils 对于每个 Hadoop 版本都不同,因此请从下载正确的版本。

https://github.com/steveloughran/winutils/blob/master/hadoop-2.7.1/bin/winutils.exe

PySpark shell

现在打开命令提示符并键入 pyspark 命令以运行 PySpark shell。应该在下面看到类似的内容。

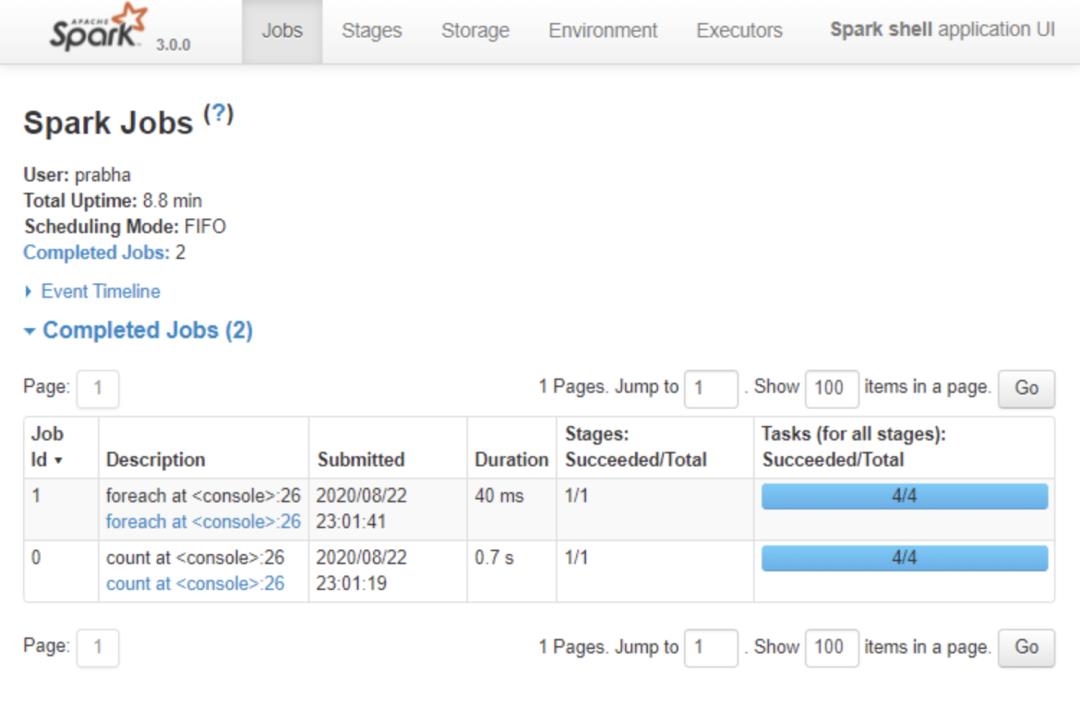

Spark-shell 还创建了一个 Spark 上下文 Web UI,默认情况下,它可以从 http://localhost:4041/ 访问。

Web UI

Apache Spark 提供了一套 Web UI(Jobs, Stages, Tasks, Storage, Environment, Executors, and SQL)来监控 Spark 应用程序的状态。

Spark Web UI

历史服务器

历史服务器,记录你通过 spark-submit、pyspark shell 提交的所有 PySpark 应用程序。在开始之前,首先需要设置以下配置 spark-defaults.conf

spark.eventLog.enabled true

spark.history.fs.logDirectory file:///c:/logs/path

现在,通过运行在 Linux 或 Mac 上启动历史服务器。

$SPARK_HOME/sbin/start-history-server.sh

如果在 Windows 上运行 PySpark,可以通过启动以下命令来启动历史服务器。

$SPARK_HOME/bin/spark-class.cmd org.apache.spark.deploy.history.HistoryServer

默认情况下,历史服务器监听 18080 端口,你可以使用http://localhost:18080/从浏览器访问它。

在Windows上安装虚拟机详细图文教程

用虚拟机来安装最新的软件,安装最新的系统等等比较保险,可以避免安装不顺利影响自己原来的系统和应用,想尝鲜又担心自己完全更换系统不适应的朋友可以尝试。

虚拟机下载:https://yunpan.cn/cqdKMyu9AWjsw 访问密码 7be7

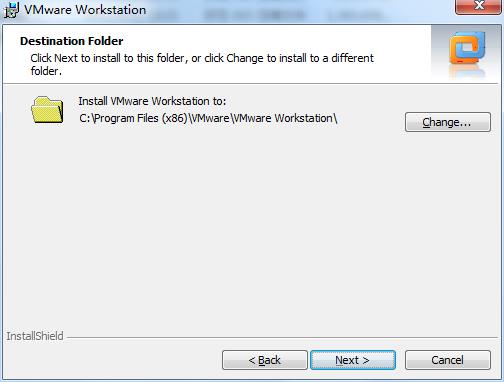

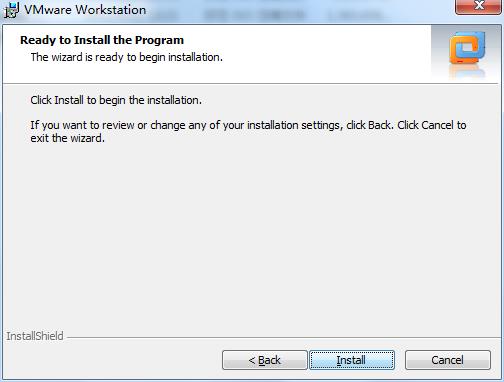

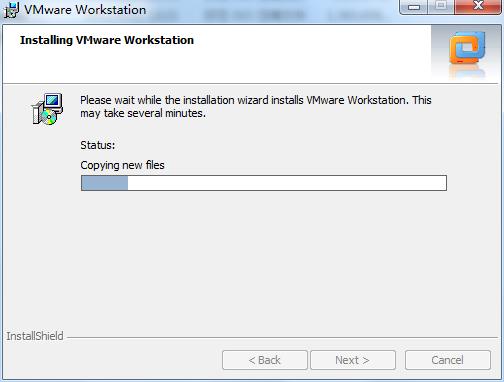

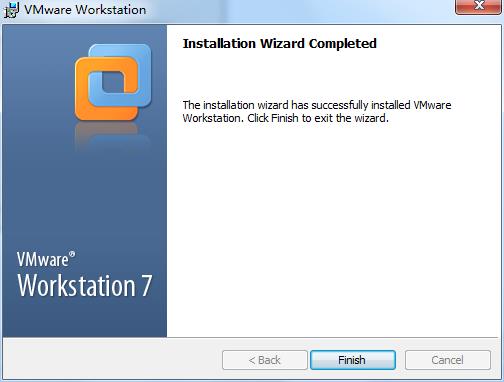

在Windows上安装虚拟机。

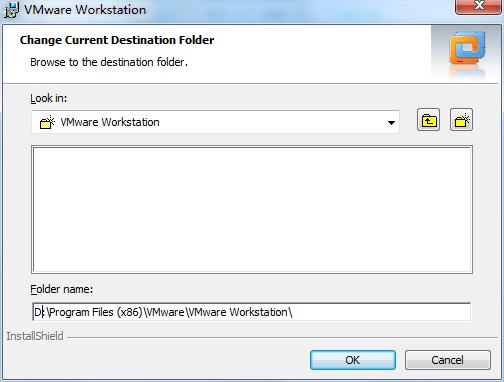

选择自己的路径:

在桌面创建一个图标:

启动虚拟机,新建虚拟机,并进行各种硬件定制。

以上是关于太详细了,在 Windows 上安装 PySpark 保姆级教程的主要内容,如果未能解决你的问题,请参考以下文章