yolov7训练自己的数据集及报错处理

Posted 长沙有肥鱼

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了yolov7训练自己的数据集及报错处理相关的知识,希望对你有一定的参考价值。

######################1##########################

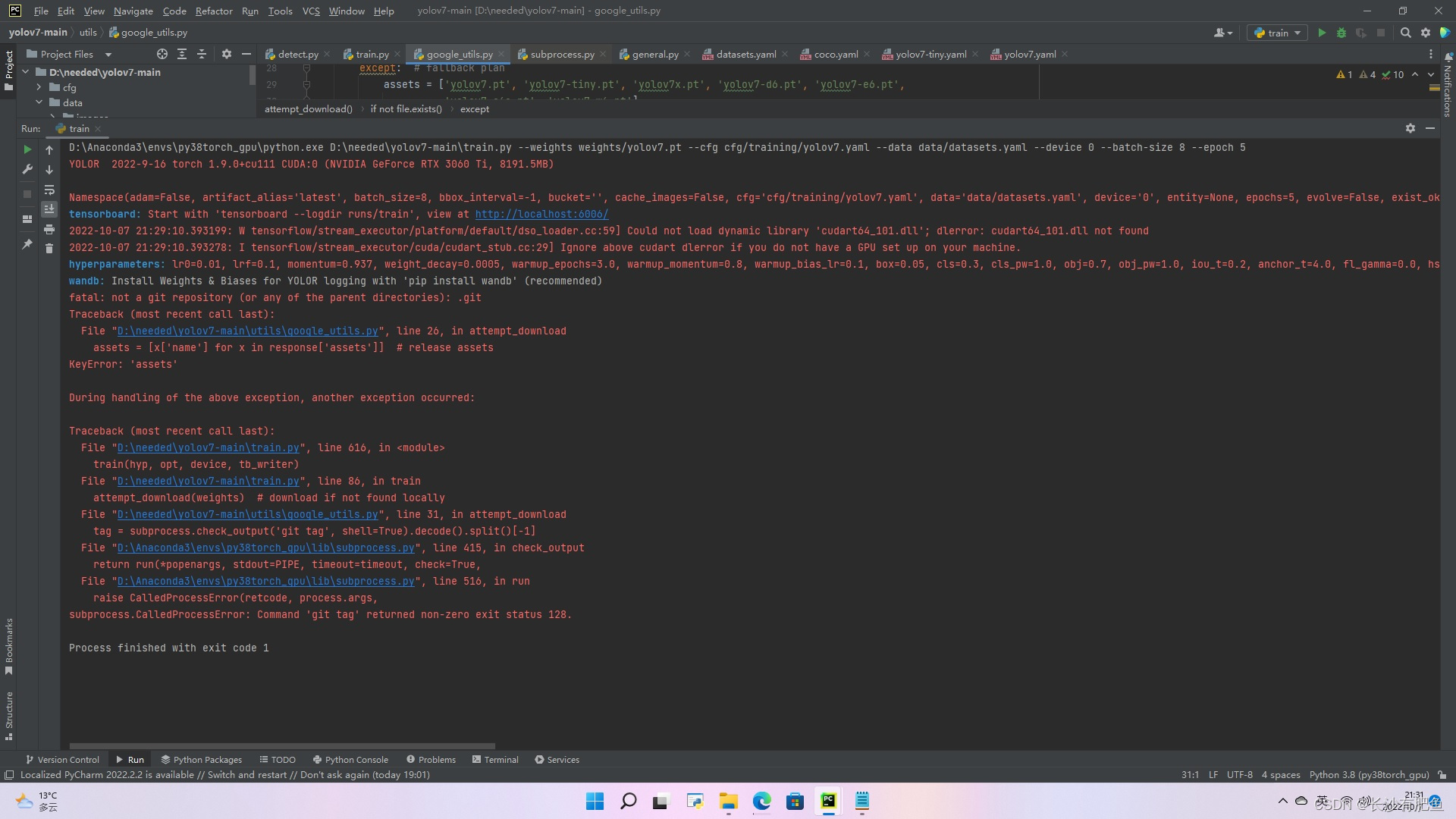

D:\\Anaconda3\\envs\\py38torch_gpu\\python.exe D:\\needed\\yolov7-main\\train.py --weights weights/yolov7.pt --cfg cfg/training/yolov7.yaml --data data/datasets.yaml --device 0 --batch-size 8 --epoch 5

YOLOR 2022-9-16 torch 1.9.0+cu111 CUDA:0 (NVIDIA GeForce RTX 3060 Ti, 8191.5MB)Namespace(adam=False, artifact_alias='latest', batch_size=8, bbox_interval=-1, bucket='', cache_images=False, cfg='cfg/training/yolov7.yaml', data='data/datasets.yaml', device='0', entity=None, epochs=5, evolve=False, exist_ok=False, freeze=[0], global_rank=-1, hyp='data/hyp.scratch.p5.yaml', image_weights=False, img_size=[640, 640], label_smoothing=0.0, linear_lr=False, local_rank=-1, multi_scale=False, name='exp', noautoanchor=False, nosave=False, notest=False, project='runs/train', quad=False, rect=False, resume=False, save_dir='runs\\\\train\\\\exp5', save_period=-1, single_cls=False, sync_bn=False, total_batch_size=8, upload_dataset=False, v5_metric=False, weights='weights/yolov7.pt', workers=0, world_size=1)

tensorboard: Start with 'tensorboard --logdir runs/train', view at http://localhost:6006/

2022-10-07 21:29:10.393199: W tensorflow/stream_executor/platform/default/dso_loader.cc:59] Could not load dynamic library 'cudart64_101.dll'; dlerror: cudart64_101.dll not found

2022-10-07 21:29:10.393278: I tensorflow/stream_executor/cuda/cudart_stub.cc:29] Ignore above cudart dlerror if you do not have a GPU set up on your machine.

hyperparameters: lr0=0.01, lrf=0.1, momentum=0.937, weight_decay=0.0005, warmup_epochs=3.0, warmup_momentum=0.8, warmup_bias_lr=0.1, box=0.05, cls=0.3, cls_pw=1.0, obj=0.7, obj_pw=1.0, iou_t=0.2, anchor_t=4.0, fl_gamma=0.0, hsv_h=0.015, hsv_s=0.7, hsv_v=0.4, degrees=0.0, translate=0.2, scale=0.9, shear=0.0, perspective=0.0, flipud=0.0, fliplr=0.5, mosaic=1.0, mixup=0.15, copy_paste=0.0, paste_in=0.15, loss_ota=1

wandb: Install Weights & Biases for YOLOR logging with 'pip install wandb' (recommended)

fatal: not a git repository (or any of the parent directories): .git

Traceback (most recent call last):

File "D:\\needed\\yolov7-main\\utils\\google_utils.py", line 26, in attempt_download

assets = [x['name'] for x in response['assets']] # release assets

KeyError: 'assets'During handling of the above exception, another exception occurred:

Traceback (most recent call last):

File "D:\\needed\\yolov7-main\\train.py", line 616, in <module>

train(hyp, opt, device, tb_writer)

File "D:\\needed\\yolov7-main\\train.py", line 86, in train

attempt_download(weights) # download if not found locally

File "D:\\needed\\yolov7-main\\utils\\google_utils.py", line 31, in attempt_download

tag = subprocess.check_output('git tag', shell=True).decode().split()[-1]

File "D:\\Anaconda3\\envs\\py38torch_gpu\\lib\\subprocess.py", line 415, in check_output

return run(*popenargs, stdout=PIPE, timeout=timeout, check=True,

File "D:\\Anaconda3\\envs\\py38torch_gpu\\lib\\subprocess.py", line 516, in run

raise CalledProcessError(retcode, process.args,

subprocess.CalledProcessError: Command 'git tag' returned non-zero exit status 128.Process finished with exit code 1

answer:下载yolov7.pt权重文件

修改train.py中:

parser.add_argument('--weights', type=str, default='yolov7.pt', help='initial weights path')#######################2##########################

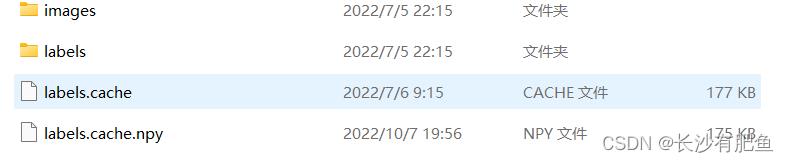

_pickle.UnpicklingError: STACK_GLOBAL requires str找到数据集下面的图片和标签文件,删掉labels.cache,labels.cache.npy文件

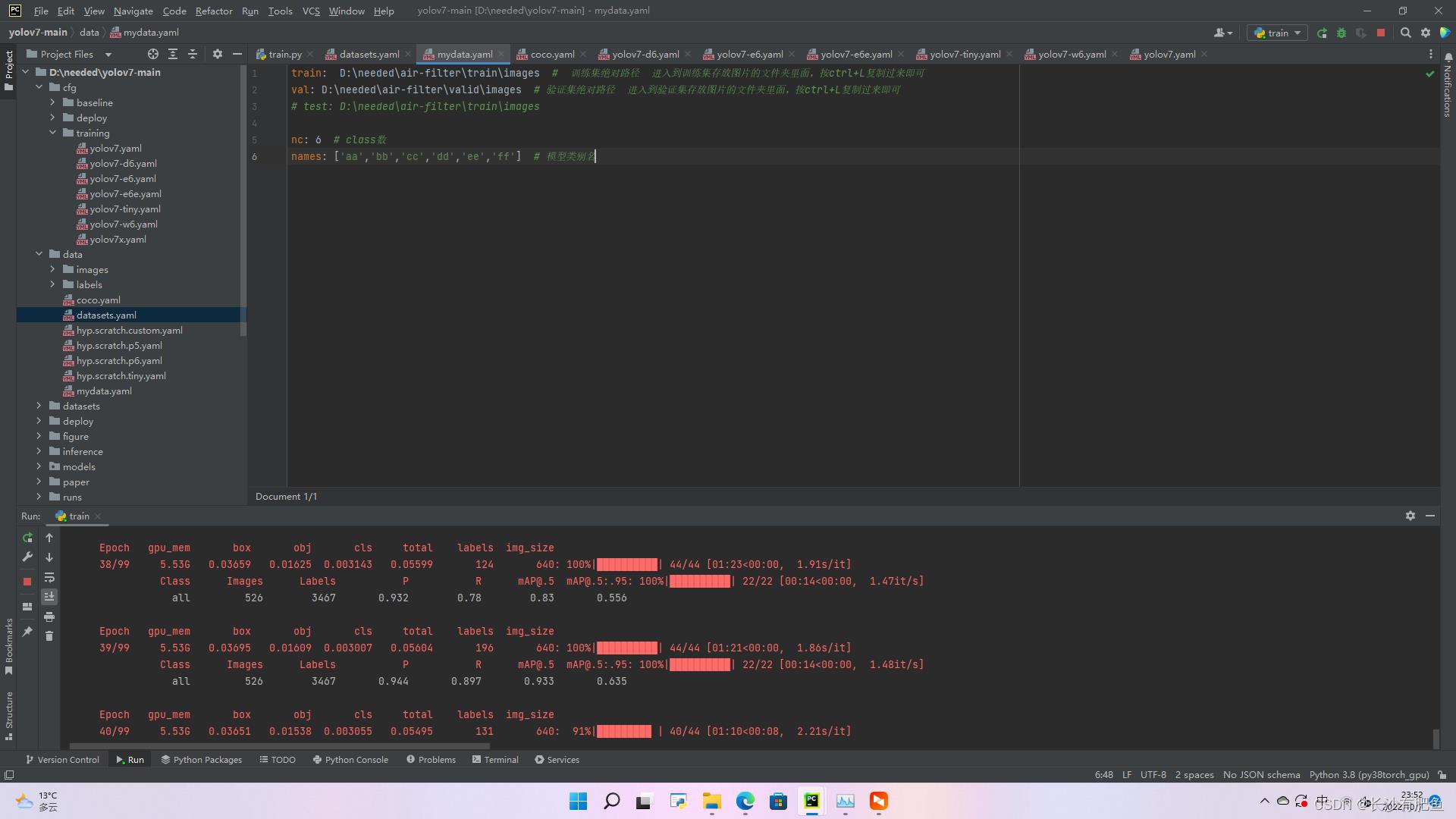

yolov7用自己的数据集训练:

1.data文件夹下面的mydata.yaml文件修改:

train: D:\\needed\\air-filter\\train\\images # 训练集绝对路径 进入到训练集存放图片的文件夹里面,按ctrl+L复制过来即可 val: D:\\needed\\air-filter\\valid\\images # 验证集绝对路径 进入到验证集存放图片的文件夹里面,按ctrl+L复制过来即可 # test: D:\\needed\\air-filter\\train\\images nc: 6 # class数 names: ['aa','bb','cc','dd','ee','ff'] # 模型类别名

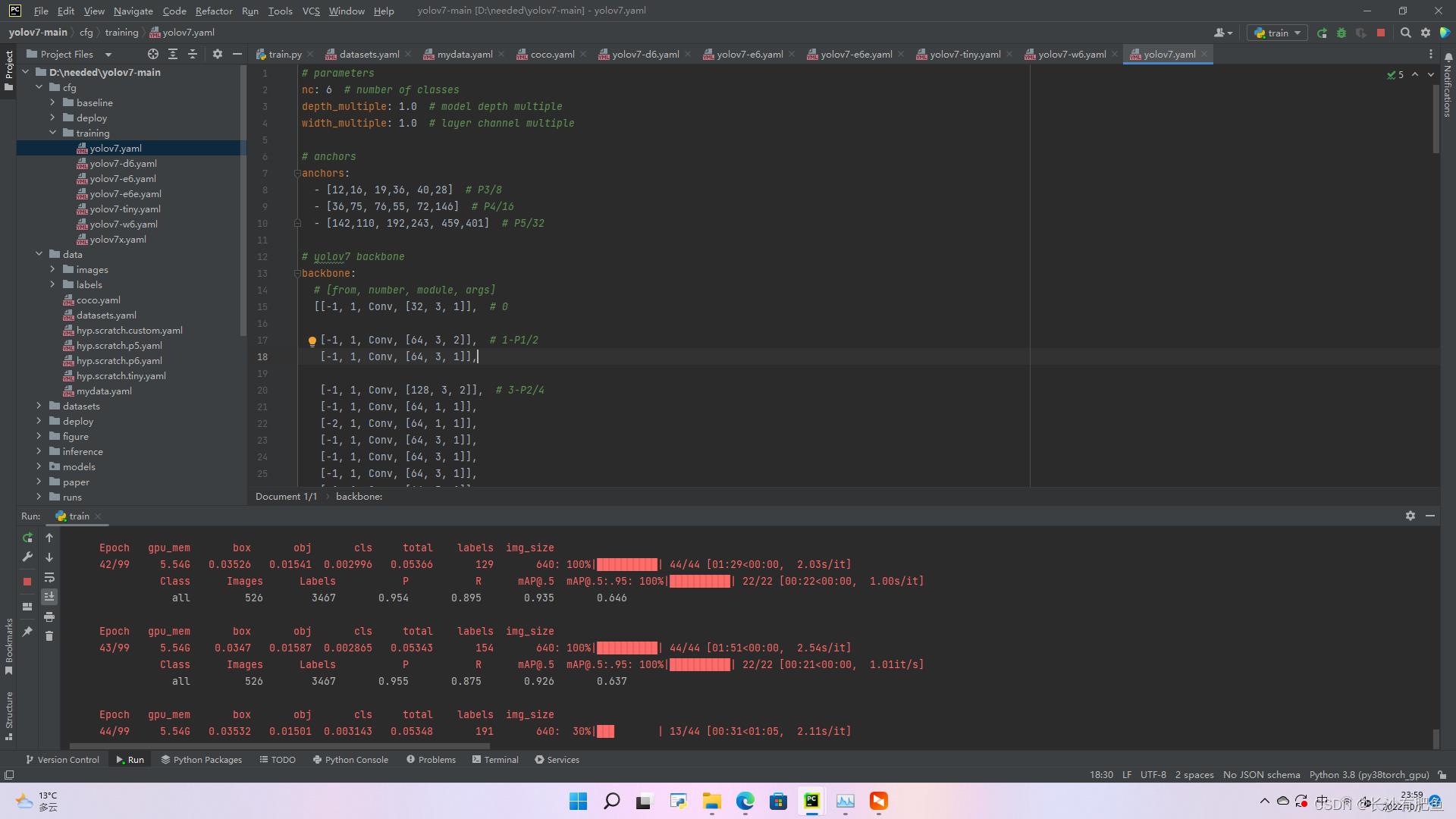

2.修改yolov7.yaml文件

将nc修改为自己的类别数,如果自己的GPU不给力,把下面的参数改改:

depth_multiple: 0.33 # model depth multiple width_multiple: 0.50 # layer channel multiple

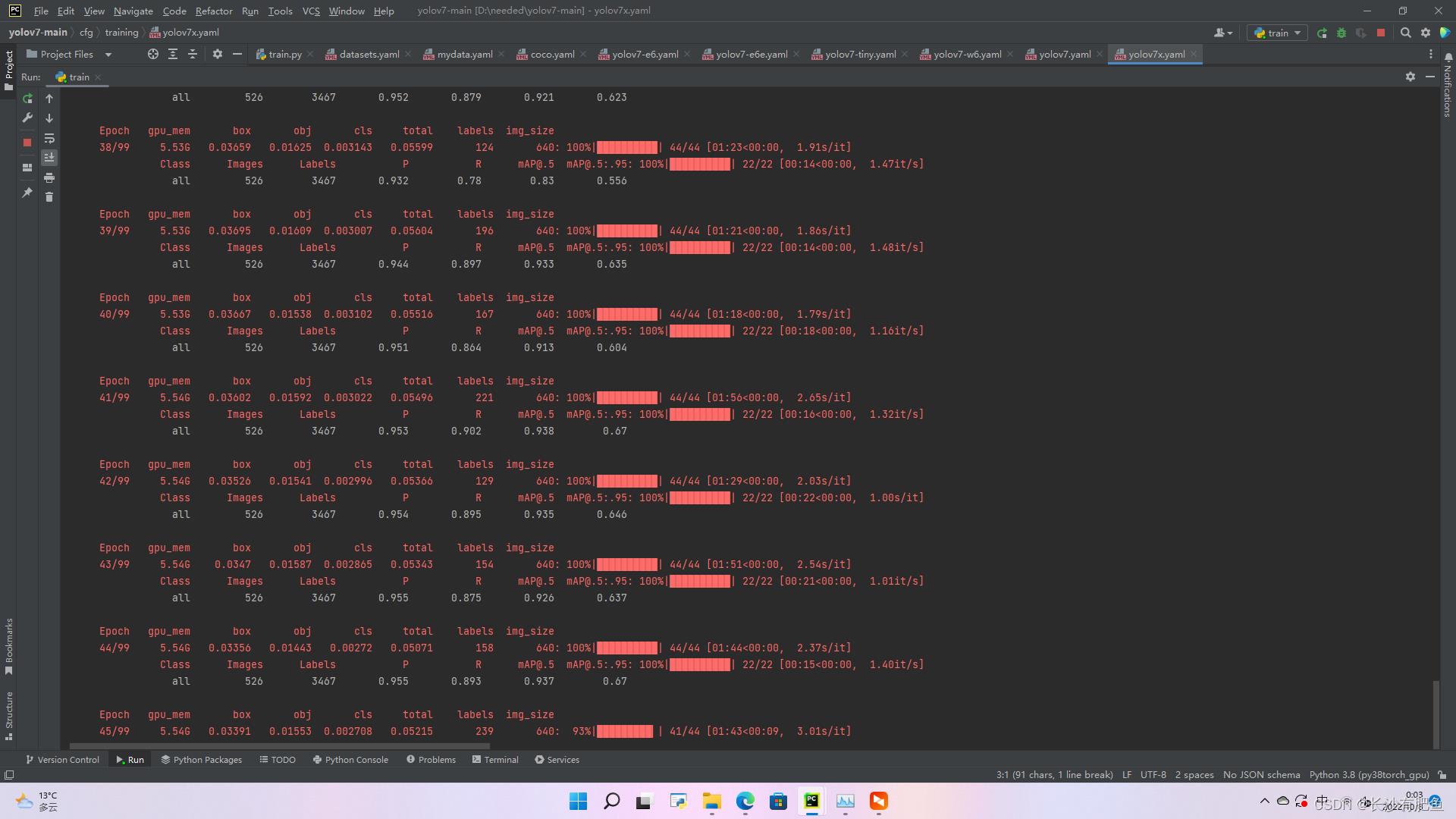

3.训练

--weights weights/'yolov7.pt' --cfg cfg/training/yolov7.yaml --data data/mydata.yaml --device 0 --batch-size 16 --epoch 100 --device 0

自定义ava数据集及训练与测试 完整版 时空动作/行为 视频数据集制作 yolov5, deep sort, VIA MMAction, SlowFast

前言

这一篇博客应该是我花时间最多的一次了,从2022年1月底至2022年4月底。

我已经将这篇博客的内容写为论文,上传至arxiv:https://arxiv.org/pdf/2204.10160.pdf

欢迎大家指出我论文中的问题,特别是语法与用词问题

在github上,我也上传了完整的项目:https://github.com/Whiffe/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset

关于自定义ava数据集,也是后台私信我最多的,也是我想完成的。

下面是我在知乎、B站的同步内容:

知乎:https://zhuanlan.zhihu.com/p/503031957

B站:https://www.bilibili.com/video/BV1j3411M7Ba/

目录

- 前言

- 1 最终要产生的标注文件

- 2 AI平台 与 项目下载

- 3 数据集视频准备

- 4 视频裁剪与抽帧

- 5 yolov5与deep sort 安装

- 6 生成dense_proposals_train.pkl

- 7 导入via

- 8 via标注信息的提取

- 9 deep sort

- 10 其它标注文件的生成

- 11 val文件的生成

- 12 rawframes

- 13 标注文件修正

- 14 mmaction2 安装

- 15 训练与测试

1 最终要产生的标注文件

我将标注3个视频,每个视频10秒,作为简单的例子。

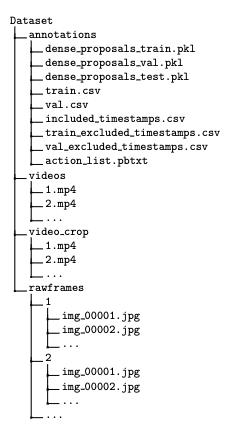

我们最终需要如下文件:

train.csv

test.csv

train_excluded_timestamps.csv

test_excluded_timestamps.csv

val_excluded_timestamps.csv

avaMin_included_timestamps.csv

avaMin_dense_proposals_train.pkl

avaMin_dense_proposals_test.pkl

avaMin_dense_proposals_val.pkl

avaMin_action_list_v2.2.pbtxt

avaMin_action_list_v2.2_for_activitynet_2019.pbtxt

数据集文件结构如下:

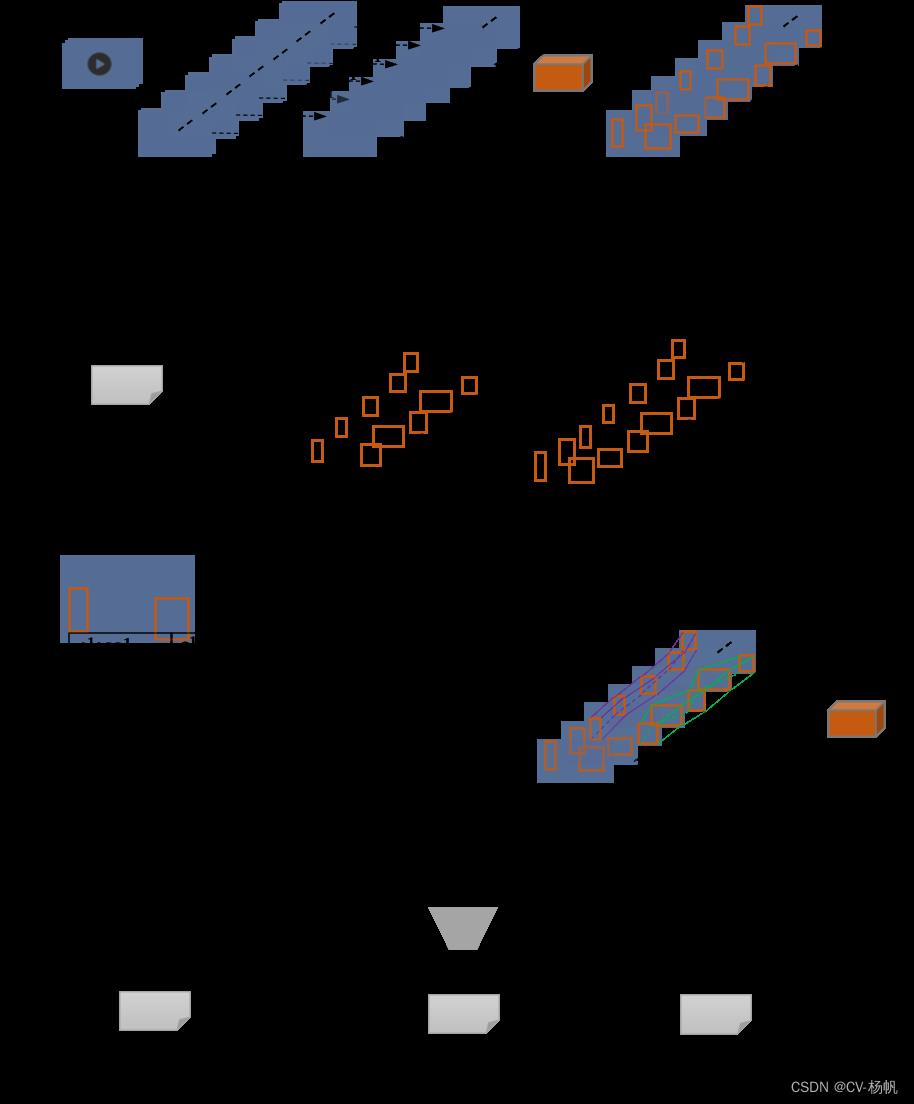

下图是本文的数据集制作的总流程图

2 AI平台 与 项目下载

2.1 AI 平台

我使用的AI平台:https://cloud.videojj.com/auth/register?inviter=18452&activityChannel=student_invite

以下的操作均在该平台的基础上完成

实例镜像选择:Pytorch 1.8.0,python 3.8,CUDA 11.1.1

2.2 项目下载

为了让项目可以快速下载,我将项目同步到了码云:https://gitee.com/YFwinston/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset.git

cd /home

git clone https://gitee.com/YFwinston/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset.git

3 数据集视频准备

视频是从AVA数据集中随机选择了1个,我会从这个视频中裁剪出3个10秒的片段:

https://s3.amazonaws.com/ava-dataset/trainval/2DUITARAsWQ.mp4

将视频下载到极链AI平台的镜像实例,代码如下:

(如果速度慢了,可以现采用迅雷下载,然后上传)

在AI平台执行:

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/videos

wget https://s3.amazonaws.com/ava-dataset/trainval/2DUITARAsWQ.mp4 -O ./1.mp4

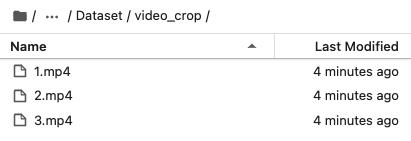

4 视频裁剪与抽帧

4.1 安装ffmpeg

本文使用ffmpeg进行视频裁剪与抽帧,所以先安装ffmpeg

conda install x264 ffmpeg -c conda-forge -y

4.2 视频裁剪

在/home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset下执行:

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset

sh cut_video.sh

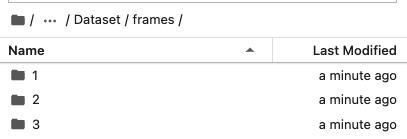

4.3 视频抽帧

参考ava数据集,每秒裁剪30帧

在/home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset 下执行:

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset

bash cut_frames.sh

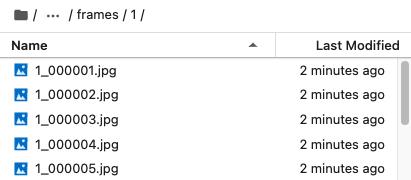

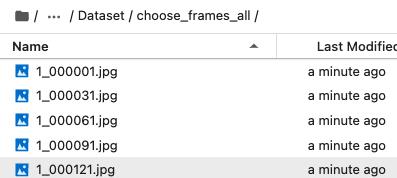

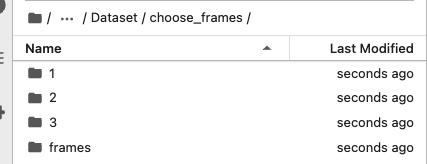

4.4 整合与缩减帧

4.3节中产生的frames文件夹的结构,在后续yolov5检测时会出现不方便,所以我采用下面的方式,将所有的图片放在了一个文件夹(choose_frames_all)中。

同时,并不是,所有图片都需要检测与标注,在10秒的视频中,检测标注:x_000001.jpg、x_000031.jpg、x_000061.jpg、x_000091.jpg、x_0000121jpg、x_000151.jpg、x_000181.jpg、x_000211.jpg、x_000241.jpg、x_000271.jpg、x_000301.jpg。

在/home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset 下执行:

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset

python choose_frames_all.py 10 0

其中10代表视频长度,0代表从第0秒开始

4.5 不整合的缩减

4.4的整合与缩减是为了yolov5的检测,这里的不整合的缩减是为了via的标注。

在/home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset 下执行:

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset

python choose_frames.py 10 0

5 yolov5与deep sort 安装

5.1 安装

运行以下命令:

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/yolovDeepsort

pip install -r requirements.txt

pip install opencv-python-headless==4.1.2.30

wget https://github.com/ultralytics/yolov5/releases/download/v6.1/yolov5s.pt -O /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/yolovDeepsort/yolov5/yolov5s.pt

mkdir -p /root/.config/Ultralytics/

wget https://ultralytics.com/assets/Arial.ttf -O /root/.config/Ultralytics/Arial.ttf

采用deep sort的原因:为生成[train/val].csv做准备,dense_proposals_[train/val/test].pkl不会用到deep sort的检测结果。

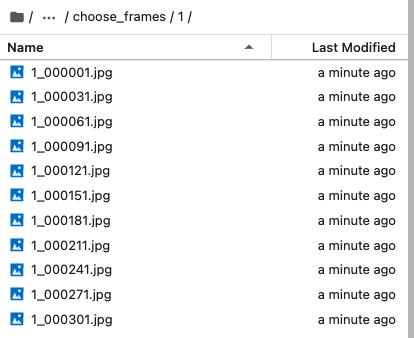

5.2 对choose_frames_all进行检测

在/home/yolov5_deepsort_pytorch_-yf中

进行检测

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/yolovDeepsort

python ./yolov5/detect.py --source ../Dataset/choose_frames_all/ --save-txt --save-conf

结果存储在:/home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/yolovDeepsort/yolov5/runs/detect/exp

6 生成dense_proposals_train.pkl

在 /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/yolovDeepsort/mywork下运行:

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/yolovDeepsort/mywork

python dense_proposals_train.py ../yolov5/runs/detect/exp/labels ./dense_proposals_train.pkl show

7 导入via

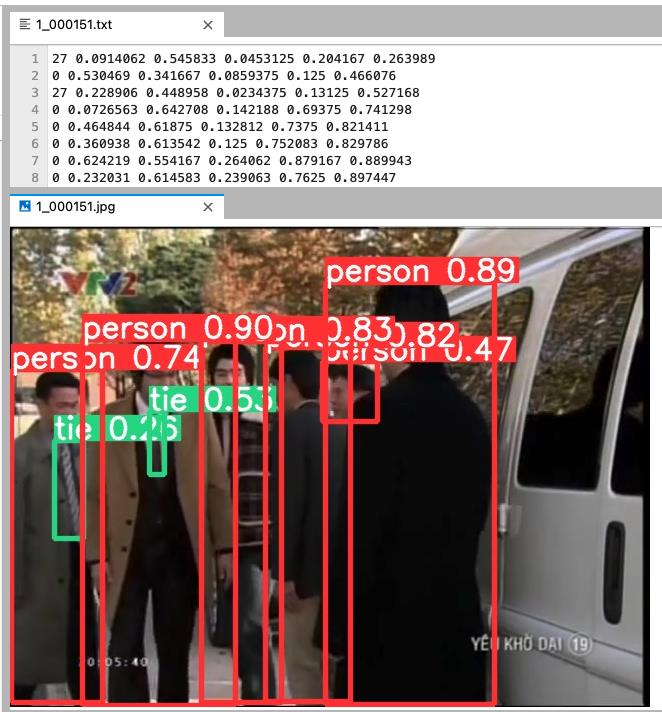

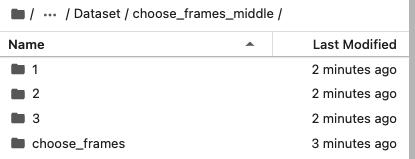

7.1 choose_frames_all_middle

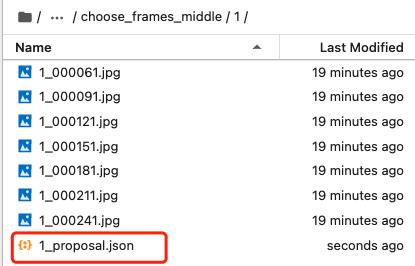

/home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset 下的 choose_frames 文件夹中包含10秒视频中11张图片,但是在最后生成的标注文件,不包含前2张图片和后2张图片。所以需要创建一个choose_frames_middle文件夹,存放不含前2张图片与后2张图片的文件夹。

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/

python choose_frames_middle.py

7.2 生成via标注文件

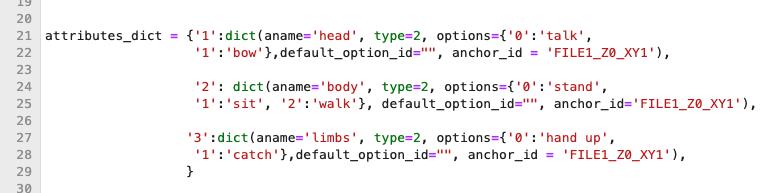

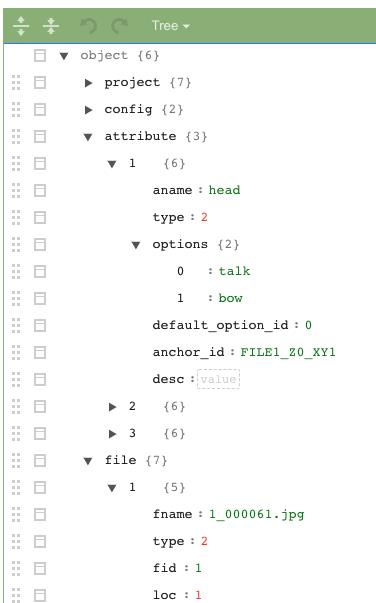

自定义动作在:/home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/yolovDeepsort/mywork/dense_proposals_train_to_via.py文件中,具体位置如下图:

在/home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/yolovDeepsort/mywork/下执行

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/yolovDeepsort/mywork/

python dense_proposals_train_to_via.py ./dense_proposals_train.pkl ../../Dataset/choose_frames_middle/

生成的标注文件保存在:/home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/choose_frames_middle中

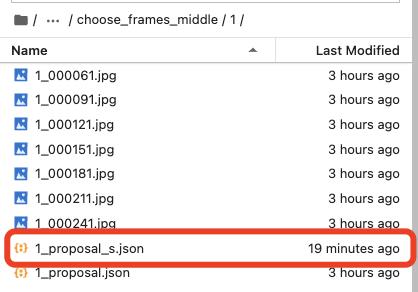

7.3 去掉via默认值

标注时有默认值,这个会影响我们的标注,需要取消掉。

我尝试了很多次,想在生成via标注文件时,去掉标注选项中的默认值,结果还是没有实现,那就在生成之后,直接对via的json文件进行操作,去掉默认值。

在:/home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/下运行

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset

python chang_via_json.py

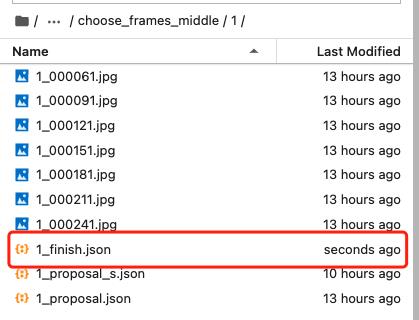

7.5 下载choose_frames_middle与VIA标注

对choose_frames_middle文件压缩

在/home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset中执行:

apt-get update

apt-get install zip

apt-get install unzip

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset

zip -r choose_frames_middle.zip choose_frames_middle

下载:choose_frames_middle.zip

然后使用via进行标注

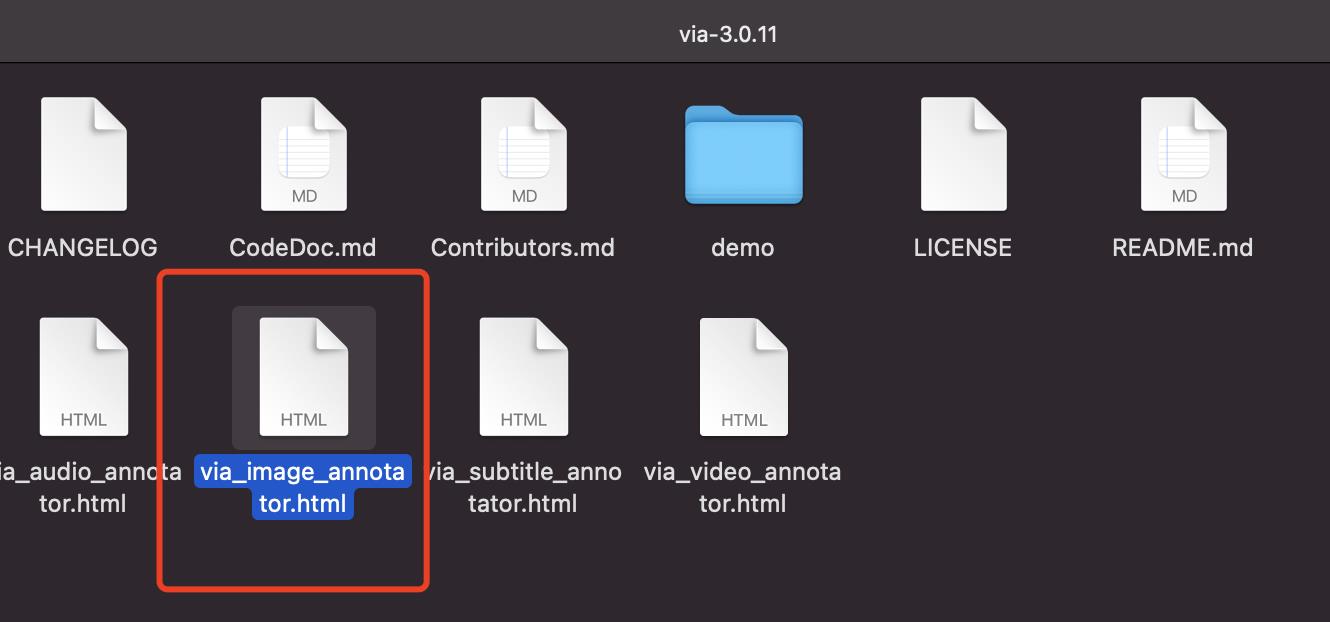

via官网:https://www.robots.ox.ac.uk/~vgg/software/via/

via标注工具下载链接:https://www.robots.ox.ac.uk/~vgg/software/via/downloads/via3/via-3.0.11.zip

点击 via_image_annotator.html

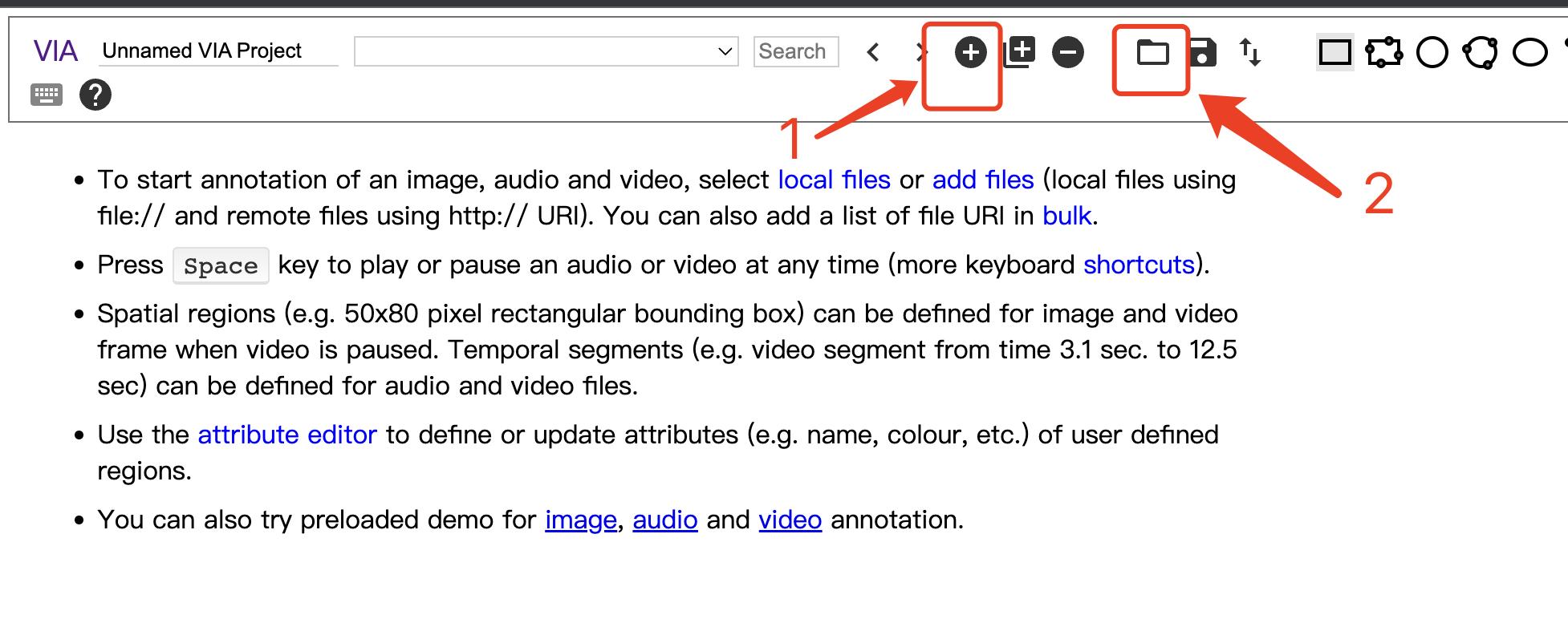

下图是via的界面,1代表添加图片,2代表添加标注文件

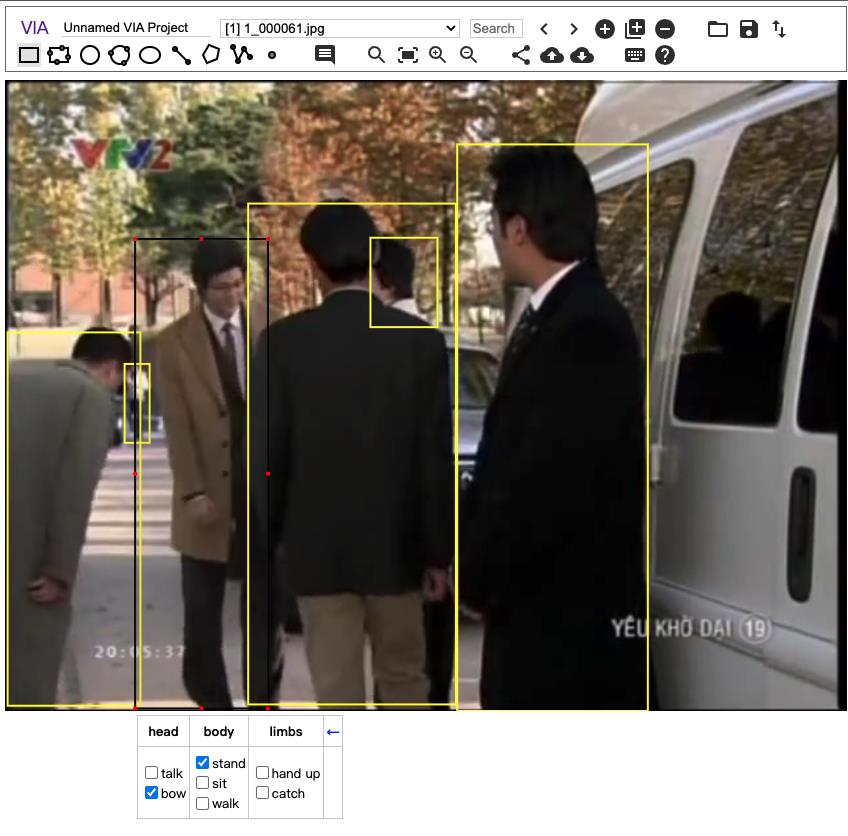

导入图片,打开标注文件(注意,打开x_proposal_s.json),最后结果:

8 via标注信息的提取

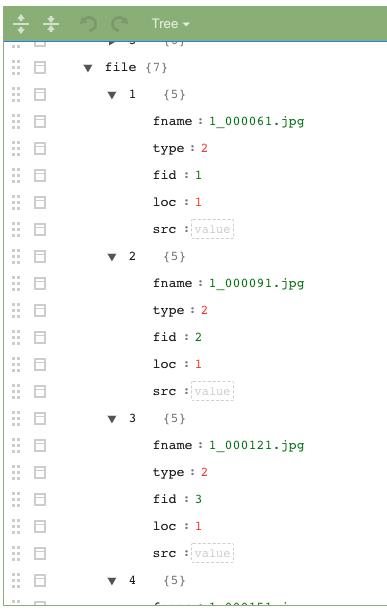

经过动作标注,via的标注信息保存为json文件,json文件中包含:视频的名字、视频帧的编号、人的坐标值、动作类别编号

这些信息都是标注文件所需要的,需要把json文件中的信息整合,这一节就是对via中信息做整合。

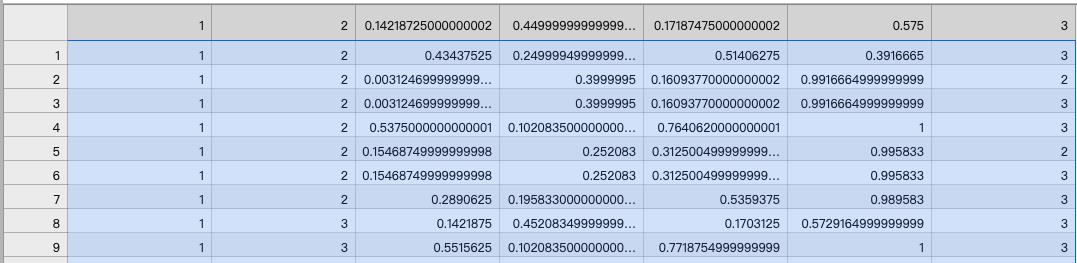

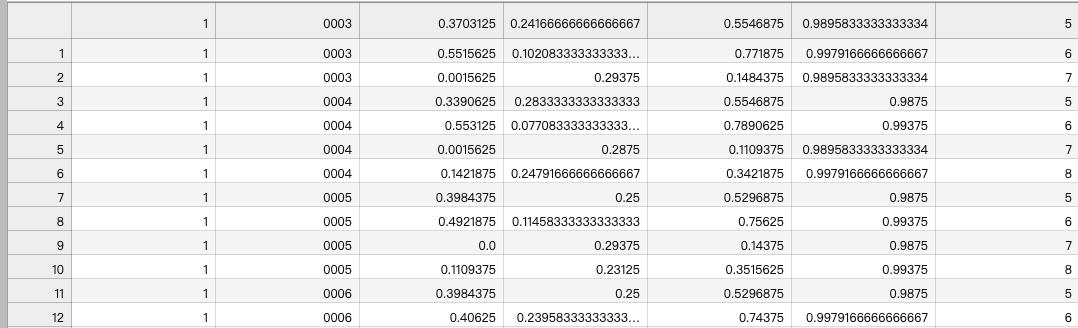

8.1 ava_train

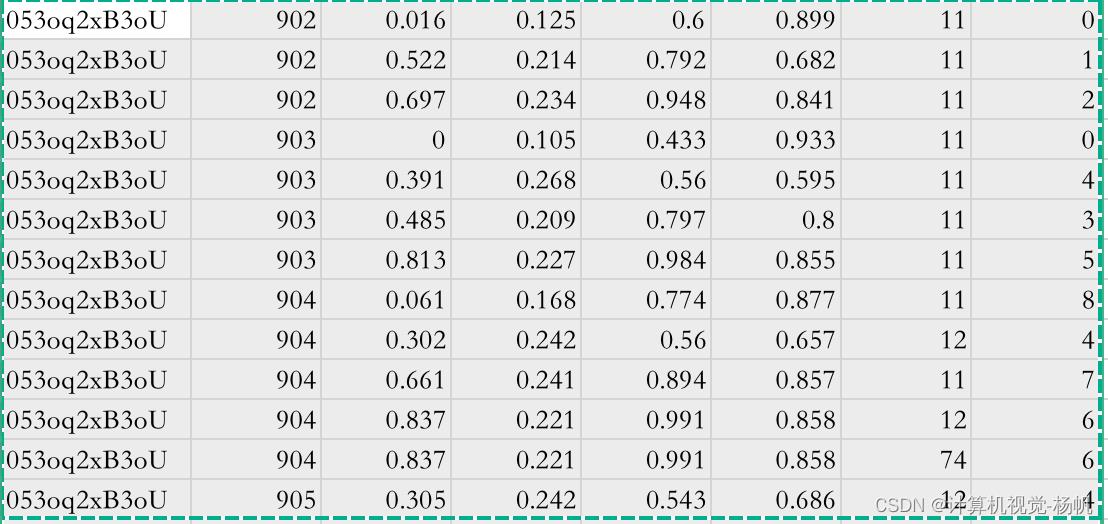

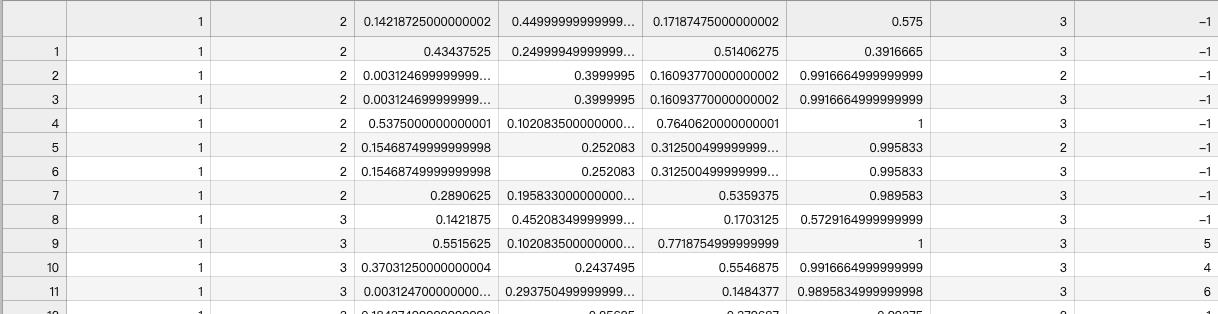

下图是ava标注文件(ava_train.csv)

第一列:视频的名字

第二列:视频帧ID,比如15:02这一帧,表示为902,15:03这一帧表示为903

第三列到第六列: 人的坐标值(x1,y1,x2,y2)

第七列:动作类别编号

第八列:人的ID

目前,我们的数据中没有最后一列的ID,其它都生成了,所以我们先将这些信息提取出来。

8.2 via Json 解析

解析使用菜鸟平台的json解析网站:https://c.runoob.com/front-end/53/

8.3 提取上传标注完成的json文件

这里需要注意的是,我给每个标注完成的文件取名:视频名_finish.json,如视频1,标注完成后的名字为:1_finish.json

在/home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/下执行

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/

python json_extract.py

会在/home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/下生成:

train_without_personID.csv

9 deep sort

9.1 dense_proposals_train_deepsort.py

由于deepsort需要提前送入2帧图片,然后才能从第三帧开始标注人的ID,dense_proposals_train.pkl是从第三张开始的(即缺失了0,1),所以需要将0,1添加

在/home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/yolovDeepsort/mywork下执行

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/yolovDeepsort/mywork

python dense_proposals_train_deepsort.py ../yolov5/runs/detect/exp/labels ./dense_proposals_train_deepsort.pkl show

接下来使用deep sort来关联人的ID

将图片与yolov5检测出来的坐标,送入deep sort进行检测

在/home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/yolovDeepsort/执行命令如下:

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/yolovDeepsort/

wget https://drive.google.com/drive/folders/1xhG0kRH1EX5B9_Iz8gQJb7UNnn_riXi6 -O ./deep_sort_pytorch/deep_sort/deep/checkpoint/ckpt.t7

python yolov5_to_deepsort.py --source /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/frames

ckpt.t7 可以单独下载后上传AI平台

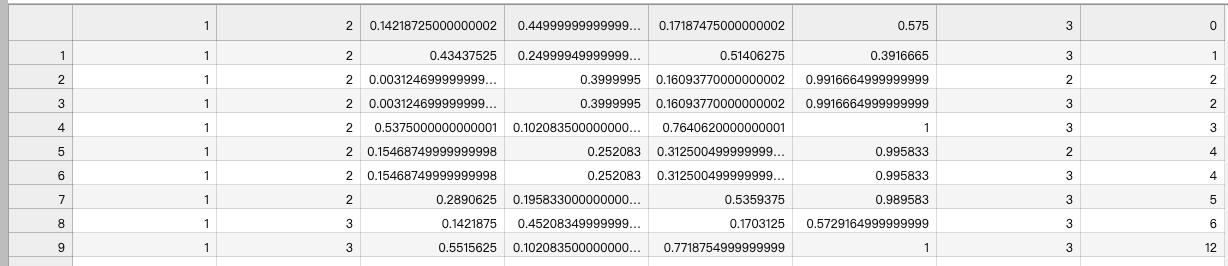

结果在:/home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/train_personID.csv,如下图

9.2 融合actions与personID

目前已经有2个文件了:

1,train_personID.csv

包含 坐标、personID

2,train_without_personID.csv

包含 坐标、actions

所以现在需要将两者拼在一起

在/home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/下执行

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/

python train_temp.py

最后结果:home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/train_temp.csv

运行结束后,会发现有些ID是-1,这些-1是deepsort未检测出来的数据,原因是人首次出现或者出现时间过短,deepsort未检测出ID。

9.3 修正ava_train_temp.csv

针对train_temp.csv中存在-1的情况,需要进行修正

在/home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/下执行

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/

python train.py

结果在:/home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/annotations/train.csv

10 其它标注文件的生成

这篇博客几乎花了85%的内容说了ava_train.csv的方法,其余的标注文件的生成方法相对来说都要简单需要

10.1 train_excluded_timestamps.csv

由于视频中没有需要排除的视频帧,所以这里就创建空的avaMin_train_excluded_timestamps.csv文件。

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/annotations

touch train_excluded_timestamps.csv

10.2 included_timestamps.txt

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/annotations

touch included_timestamps.txt

然后在included_timestamps.txt 中写入

02

03

04

05

06

07

08

10.3 action_list.pbtxt

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/annotations

touch action_list.pbtxt

item

name: "talk"

id: 1

item

name: "bow"

id: 2

item

name: "stand"

id: 3

item

name: "sit"

id: 4

item

name: "walk"

id: 5

item

name: "hand up"

id: 6

item

name: "catch"

id: 7

10.4 dense_proposals_train.pkl

cp /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/yolovDeepsort/mywork/dense_proposals_train.pkl /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/annotations

11 val文件的生成

val文件的生成

我只是做一个样例,所以我就把train与val设置为一样的

11.1 dense_proposals_val.pkl

cp /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/annotations/dense_proposals_train.pkl /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/annotations/dense_proposals_val.pkl

11.2 val.csv

cp /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/annotations/train.csv /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/annotations/val.csv

11.3 train_excluded_timestamps.csv

cp /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/annotations/train_excluded_timestamps.csv /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/annotations/val_excluded_timestamps.csv

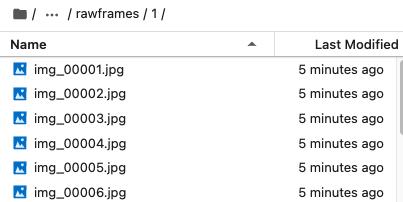

12 rawframes

在取名上,裁剪的视频帧存在与训练不匹配的问题,所以需要对/home/Dataset/frames中的图片进行名字修改

例如:

原本的名字:rawframes/1/1_000001.jpg

目标名字:rawframes/1/img_00001.jpg

cp -r /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/frames/* /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/Dataset/rawframes

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/yolovDeepsort/mywork/

python change_raw_frames.py

13 标注文件修正

有部分的标注文件在字段类型上有些问题

所以需要修正

13.1 dense_proposals_train

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/yolovDeepsort/mywork

python change_dense_proposals_train.py

13.2 dense_proposals_val

cd /home/Custom-ava-dataset_Custom-Spatio-Temporally-Action-Video-Dataset/yolovDeepsort/mywork

python change_dense_proposals_val.py

14 mmaction2 安装

cd /home

git clone https://gitee.com/YFwinston/mmaction2_YF.git

pip install mmcv-full==1.3.17 -f https://download.openmmlab.com/mmcv/dist/cu111/torch1.8.0/index.html

pip install opencv-python-headless==4.1.2.30

pip install moviepy

cd mmaction2_YF

pip install -r requirements/build.txt

pip install -v -e .

mkdir -p ./data/ava

cd ..

git clone https://gitee.com/YFwinston/mmdetection.git

cd mmdetection

pip install -r requirements/build.txt

pip install -v -e .

cd ../mmaction2_YF

wget https://download.openmmlab.com/mmdetection/v2.0/faster_rcnn/faster_rcnn_r50_fpn_2x_coco/faster_rcnn_r50_fpn_2x_coco_bbox_mAP-0.384_20200504_210434-a5d8aa15.pth -P ./Checkpionts/mmdetection/

wget https://download.openmmlab.com/mmaction/recognition/slowfast/slowfast_r50_8x8x1_256e_kinetics400_rgb/slowfast_r50_8x8x1_256e_kinetics400_rgb_20200716-73547d2b.pth -P ./Checkpionts/mmaction/

15 训练与测试

15.1 配置文件

在 /mmaction2_YF/configs/detection/ava/下创建 my_slowfast_kinetics_pretrained_r50_4x16x1_20e_ava_rgb.py

cd /home/mmaction2_YF/configs/detection/ava/

touch my_slowfast_kinetics_pretrained_r50_4x16x1_20e_ava_rgb.py

# model setting

model = dict(

type='FastRCNN',

backbone=dict(

type='ResNet3dSlowFast',

pretrained=None,

resample_rate=8,

speed_ratio=8,

channel_ratio=8,

slow_pathway=dict(

type='resnet3d',

depth=50,

pretrained=None,

lateral=True,

conv1_kernel=(1, 7, 7),

dilations=(1, 1, 1, 1),

conv1_stride_t=1,

pool1_stride_t=1,

inflate=(0, 0, 1, 1),

spatial_strides=(1, 2, 2, 1)),

fast_pathway=dict(

type='resnet3d',

depth=50,

pretrained=None,

lateral=False,

base_channels=8,

conv1_kernel=(5, 7, 7),

conv1_stride_t=1,

pool1_stride_t=1,

spatial_strides=(1, 2, 2, 1))),

roi_head=dict(

type='AVARoIHead',

bbox_roi_extractor=dict(

type='SingleRoIExtractor3D',

roi_layer_type='RoIAlign',

output_size=8,

with_temporal_pool=True),

bbox_head=dict(

type='BBoxHeadAVA',

in_channels=2304,

num_classes=81,

multilabel=True,

dropout_ratio=0.5)),

train_cfg=dict(

rcnn=dict(

assigner=dict(

type='MaxIoUAssignerAVA',

pos_iou_thr=0.9,

neg_iou_thr=0.9,

min_pos_iou=0.9),

sampler=dict(

type='RandomSampler',

num=32,

pos_fraction=1,

neg_pos_ub=-1,

add_gt_as_proposals=True),

pos_weight=1.0,

debug=False))YOLOv7 pytorch