educoder-Hadoop开发环境搭建

Posted 秃头速度缓慢

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了educoder-Hadoop开发环境搭建相关的知识,希望对你有一定的参考价值。

educoder-Hadoop开发环境搭建

第一关

mkdir /app

cd /opt

tar -zxvf jdk-8u171-linux-x64.tar.gz

mv jdk1.8.0_171/ /app

mkdir /app

cd /opt

tar -zxvf jdk-8u171-linux-x64.tar.gz

mv jdk1.8.0_171/ /app

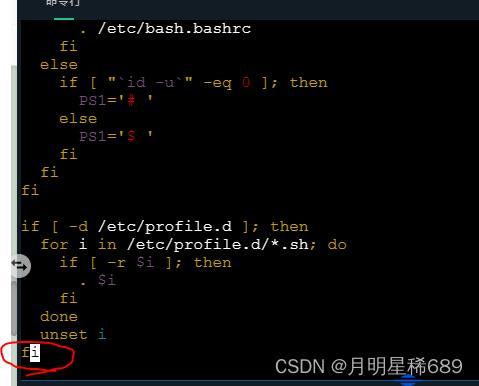

vim /etc/profile

进入过后,移动光标,移动到最末端

按住键盘 fn + delete

看到最末端出现

–insert–

就能进入写入操作

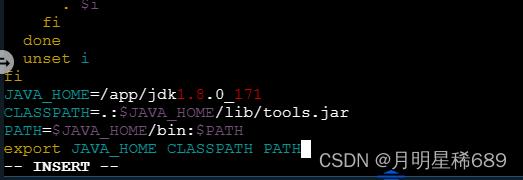

然后输入

JAVA_HOME=/app/jdk1.8.0_171

CLASSPATH=.:$JAVA_HOME/lib/tools.jar

PATH=$JAVA_HOME/bin:$PATH

export JAVA_HOME CLASSPATH PATH

在英文键盘下

按esc键

冒号shift + :

输入wq

就能退出

source /etc/profile //启动配置

java -version //检查配置是否成功

第二关 配置开发环境 - Hadoop安装与伪分布式集群搭建

cd /opt

tar -zxvf hadoop-3.1.0.tar.gz -C /app

cd /app

mv hadoop-3.1.0/ hadoop3.1

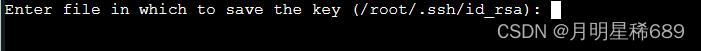

ssh-keygen -t rsa -P ''

会出现

我们复制括号中的内容

/root/.ssh/id_rsa

回车

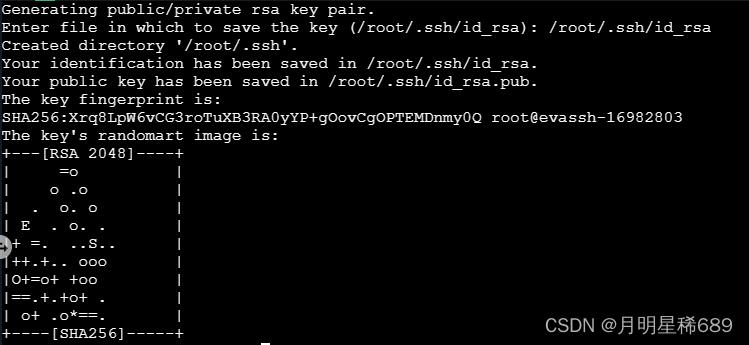

这样就生成了密钥,然后输入

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

chmod 600 ~/.ssh/authorized_keys

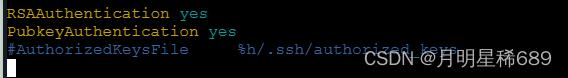

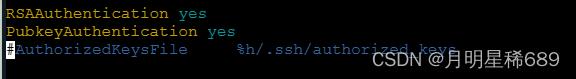

vim /etc/ssh/sshd_config

移动光标找到

按键盘上移 移动到

按键盘上的delete

然后按esc,

shift + :

输入wq

退出

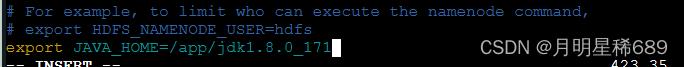

cd /app/hadoop3.1/etc/hadoop/

vim hadoop-env.sh

进入hadoop-env.sh的配置环境中

光标移动到最后

按住 fn + delete

进入后插入

export JAVA_HOME=/app/jdk1.8.0_171

在英文键盘下

按esc键

冒号shift + :

输入wq

退出

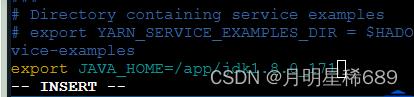

vim env.sh

进入env.sh的配置环境中

光标移动到最后

按住 fn + delete

进入后插入

export JAVA_HOME=/app/jdk1.8.0_171

在英文键盘下

按esc键

冒号shift + :

输入wq

退出

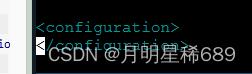

vim core-site.xml

移动光标到最末端

按住 fn + delete进入后按空格

插入以下代码块

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

<description>HDFS的URI,文件系统://namenode标识:端口号</description>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/hadoop/tmp</value>

<description>namenode上本地的hadoop临时文件夹</description>

</property>

在英文键盘下

按esc键

冒号shift + :

输入wq

退出

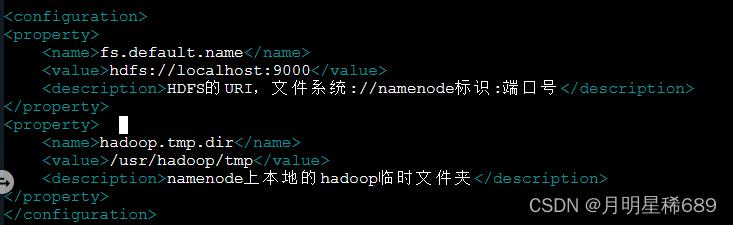

配置 hdfs-site.xml

vim hdfs-site.xml

移动光标到最末端

<property>

<name>dfs.name.dir</name>

<value>/usr/hadoop/hdfs/name</value>

<description>namenode上存储hdfs名字空间元数据 </description>

</property>

<property>

<name>dfs.data.dir</name>

<value>/usr/hadoop/hdfs/data</value>

<description>datanode上数据块的物理存储位置</description>

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

在英文键盘下

按esc键

冒号shift + :

输入wq

退出

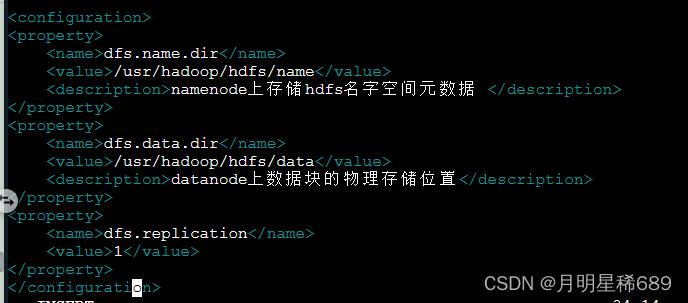

配置mapred-site.xml

vim mapred-site.xml

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

在英文键盘下

按esc键

冒号shift + :

输入wq

退出

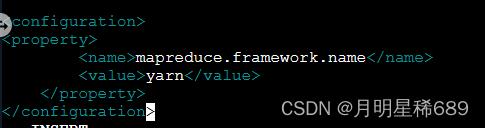

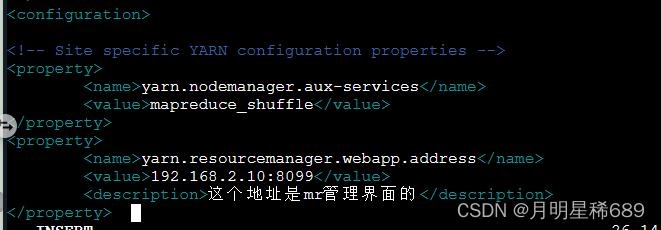

配置yarn-site.xml

vim yarn-site.xml

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>192.168.2.10:8099</value>

<description>这个地址是mr管理界面的</description>

</property>

在英文键盘下

按esc键

冒号shift + :

输入wq

退出

创建文件夹

mkdir -p /usr/hadoop/tmp

mkdir /usr/hadoop/hdfs

mkdir /usr/hadoop/hdfs/data

mkdir /usr/hadoop/hdfs/name

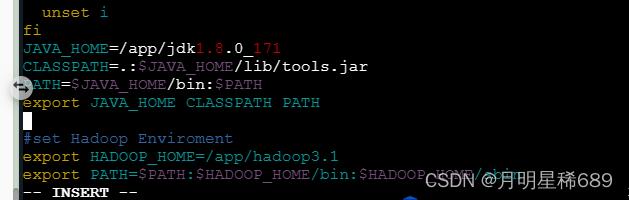

光标移动到末尾

按 fn + delete

插入

#set Hadoop Enviroment

export HADOOP_HOME=/app/hadoop3.1

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

在英文键盘下

按esc键

冒号shift + :

输入wq

退出

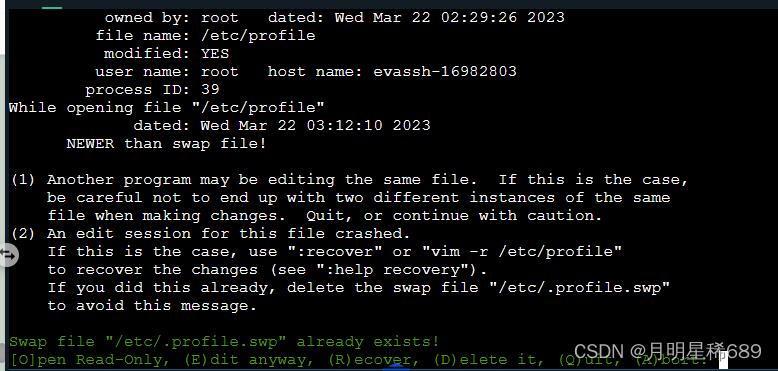

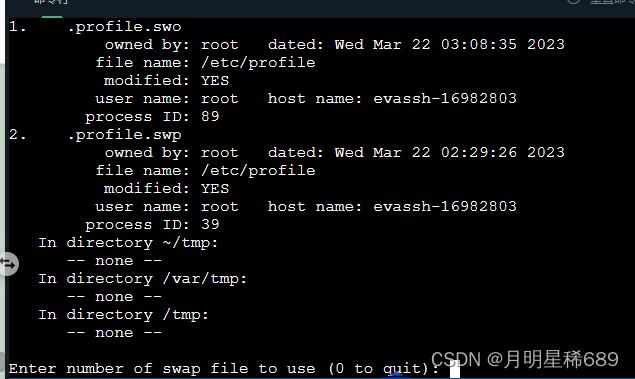

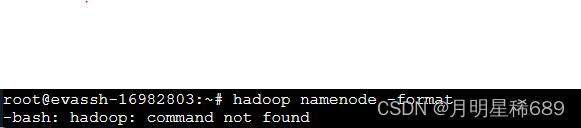

问题:如果出现图片中的问题(如果没有就跳过)

输入R去覆盖之前的文件

然后输入2然后一直回车就能进入了

然后输入

source /etc/profile

启动配置

验证

如果出现(没有就跳过)

那就是之前配置没做好,再去检查一下哪里遗忘了

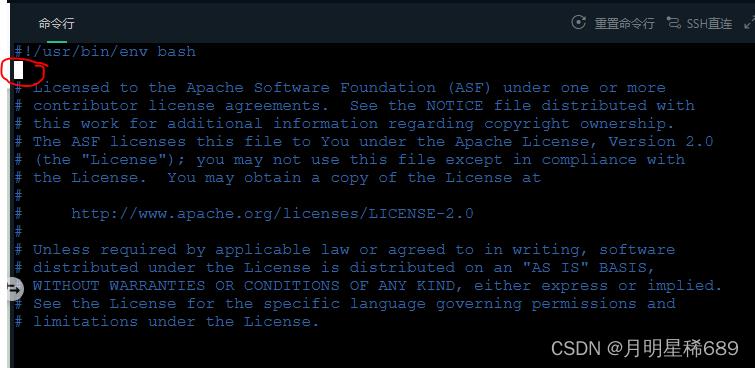

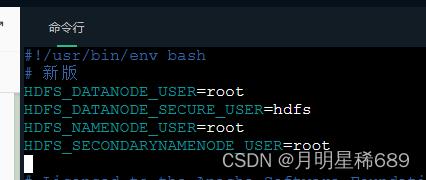

cd /app/hadoop3.1/sbin

vim start-dfs.sh

在这里按 fn + delete

插入代码

# 新版

HDFS_DATANODE_USER=root

HDFS_DATANODE_SECURE_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root

在英文键盘下

按esc键

冒号shift + :

输入wq

退出

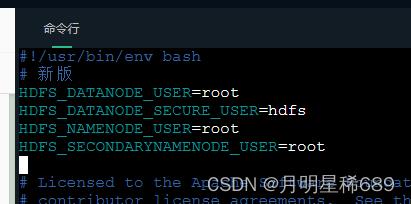

vim stop-dfs.sh

# 新版

HDFS_DATANODE_USER=root

HDFS_DATANODE_SECURE_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root

在英文键盘下

按esc键

冒号shift + :

输入wq

退出

3.

vim start-yarn.sh

YARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=yarn

YARN_NODEMANAGER_USER=root

在英文键盘下

按esc键

冒号shift + :

输入wq

退出

vim stop-yarn.sh

YARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=yarn

YARN_NODEMANAGER_USER=root

在英文键盘下

按esc键

冒号shift + :

输入wq

退出

hadoop namenode -format

start-dfs.sh

jps

以上是关于educoder-Hadoop开发环境搭建的主要内容,如果未能解决你的问题,请参考以下文章