基于pytorch后量化(mnist分类)---浮点训练vs多bit后量化vs多bit量化感知训练效果对比

Posted 踟蹰横渡口,彳亍上滩舟。

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了基于pytorch后量化(mnist分类)---浮点训练vs多bit后量化vs多bit量化感知训练效果对比相关的知识,希望对你有一定的参考价值。

基于pytorch后量化(mnist分类)—浮点训练vs多bit后量化vs多bit量化感知训练效果对比

代码下载地址:下载地址

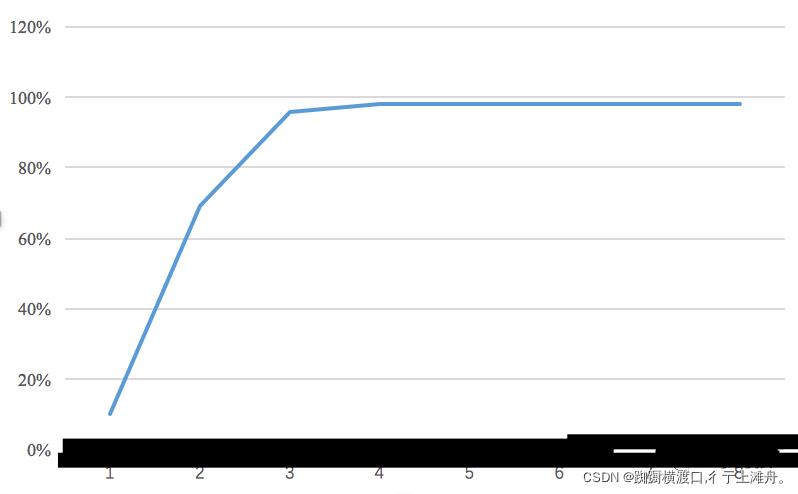

试了 bit 数为 1~8 的准确率,得到下面这张折线图:

发现,当 bit >= 3 的时候,精度几乎不会掉,bit = 2 的时候精度下降到 69%,bit = 1 的时候则下降到 10%。

这一方面是 mnist 分类任务比较简单,但也说明神经网络中的冗余量其实非常大,所以量化在分类网络中普遍有不错的效果。

卷积层量化

以上是关于基于pytorch后量化(mnist分类)---浮点训练vs多bit后量化vs多bit量化感知训练效果对比的主要内容,如果未能解决你的问题,请参考以下文章