英伟达让AI“演技”再上台阶:仅靠语音驱动1张照片说话,惊讶恐惧表情狠狠拿捏...

Posted QbitAl

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了英伟达让AI“演技”再上台阶:仅靠语音驱动1张照片说话,惊讶恐惧表情狠狠拿捏...相关的知识,希望对你有一定的参考价值。

Pine 发自 凹非寺

量子位 | 公众号 QbitAI

输入一段台词,让照片“演戏”又进阶了!

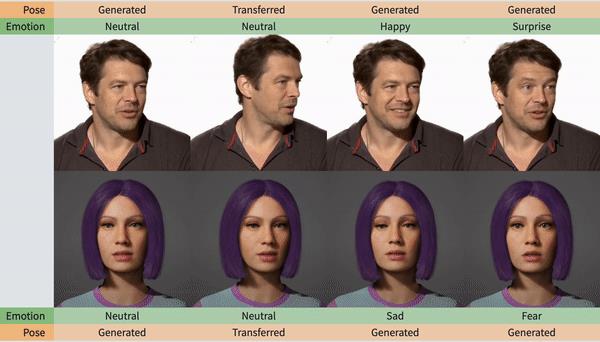

这次的AI直接让“演技”整体上了一个台阶,表演生气、开心、可怜……各种情绪都不在话下。

并且,口型、眼神、头部动作也都让这个AI狠狠拿捏住了!

甚至还能调节喜怒哀乐的程度。

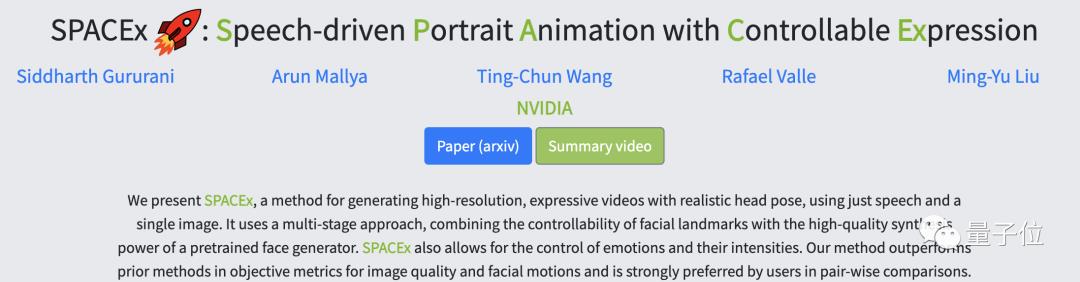

这是英伟达最新推出的一款AI,名为SPACEx (此SPACEx非马斯克的SpaceX),全称是可控表达的语音驱动肖像动画(Speech-driven Portrait Animation with Controllable Expression)。

其实,在英伟达推出SPACEx之前,已经有不少语音驱动照片的AI问世,那相较于之前那些AI,SPACEx有什么优势呢?

人脸动作更稳定,更注重细节

此前,最常使用的语音驱动照片的AI主要有三个:PC-AVS、MakeItTalk和Wav2Lip。

但这三个AI都或多或少有些缺陷之处,并且要么只能对口型,要么就只是整体面部控制的比较好,多个功能往往不能兼顾。

先来说说PC-AVS,它在对图像和语音进行处理时,会对输入图像进行严格的剪裁,甚至还会改变姿势,此外,生成的人脸动作很不稳定。

而MakeItTalk,在对口型方面效果不是很好,有时候生成的视频中还会出现空白的地方。

Wav2Lip的功能则比较单一,它主要是配音AI,只改变唇部的动作,唇部之外的面部表情毫无变化。

而这些问题,在SPACEx身上通通都被解决掉了,话不多说,直接看看它们之间的效果对比!

可以看出,无论是细节的口型、眼神,还是整体的面部动作,SPACEx都会更加自然一些。

而细分到各个具体的功能,SPACEx都集成了哪些功能呢?

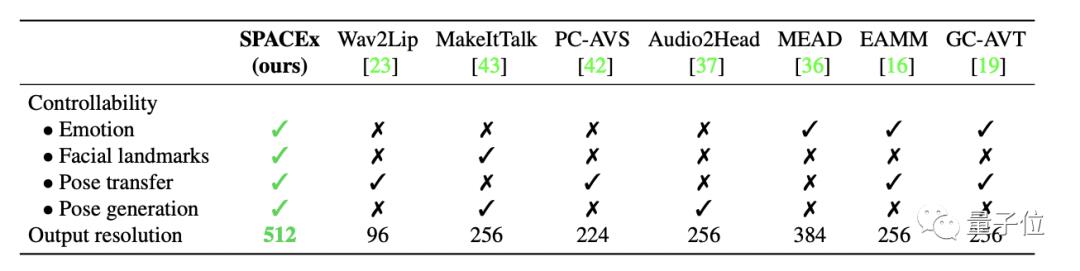

下面这个表格给出了答案,情绪控制、标记面部landmark、头部转动和动作生成,SPACEx都能很好地兼顾,不会像以往的模型顾此失彼。

值得注意的是,SPACEx生成视频的质量也整体上升了一个台阶,以往同类型的AI最高只能达到384的分辨率,而SPACEx这次已经达到了512X512。

兼顾这么多功能还能生成高质量视频,SPACEx又是怎样做到的呢?

具体原理

其中,很大一部分功劳是face-vid2vid贡献的,它是英伟达两年前公布的一个AI算法。

它不仅能压缩视频的流量,还能保证视频的画质。

并且,face-vid2vid还能让视频中的人物随意扭头。

不过它要求输入的是一个视频,而SPACEx则是一个图片,它俩又是怎么关联到一起的?

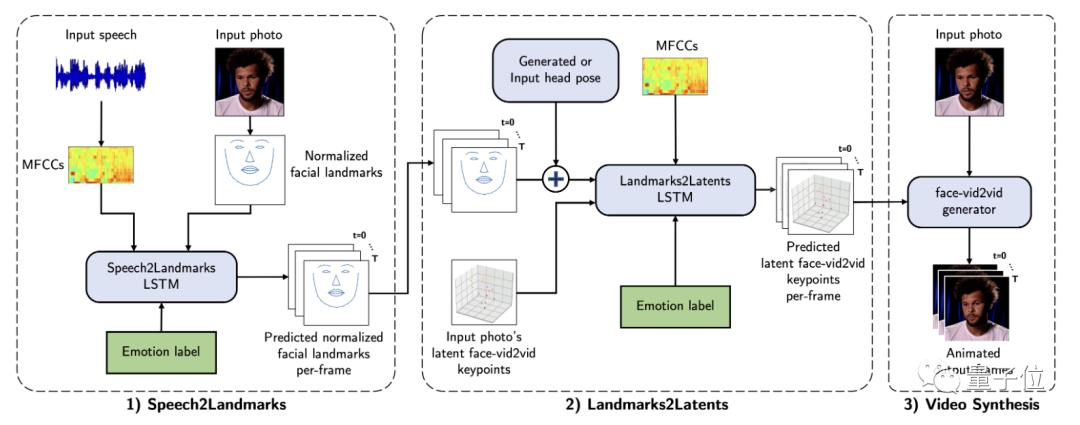

这得从SPACEx生成视频的过程来看,主要分三个阶段。

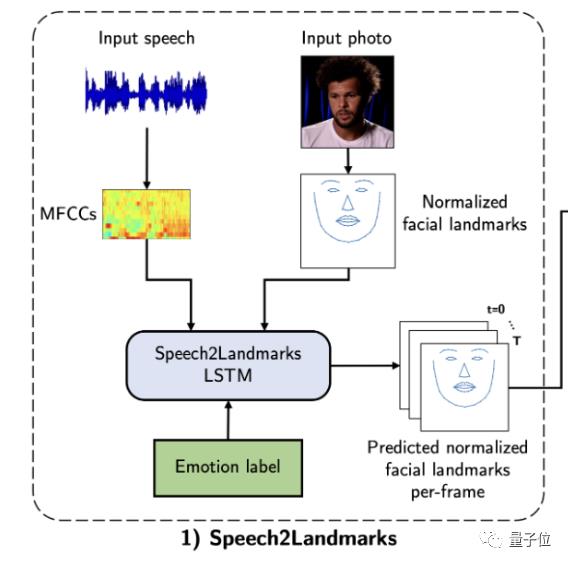

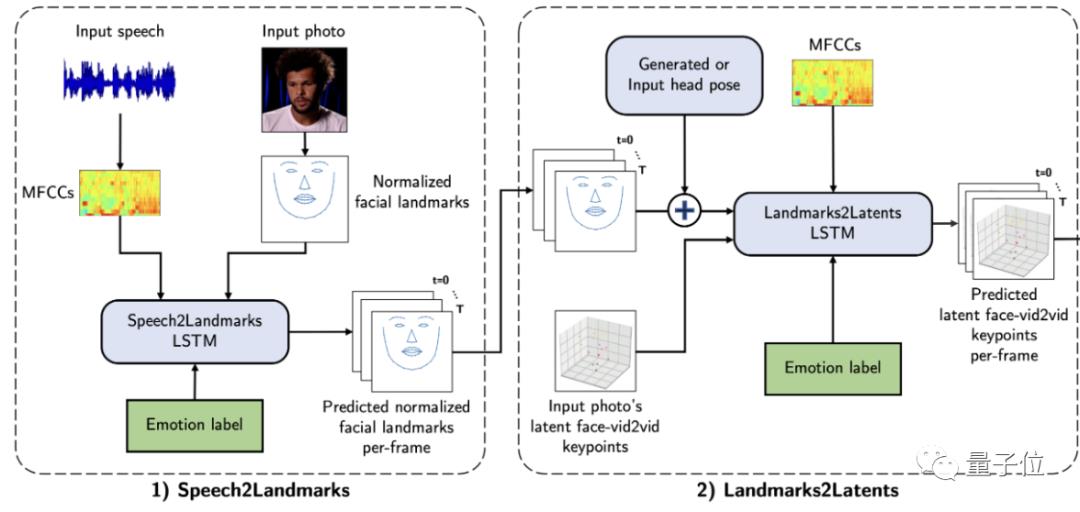

第一个阶段可以概括为Speech2Landmarks,即从输入的语音中来预测各个音节所对应的标准面部landmarks。

在预测的过程中,还会插入对应的情绪标签。

预测好面部landmarks后,来到第二步:Landmarks2Latents,输入各个图像的face-vid2vid关键点,以控制整个面部表情。

然后将这些关键点对应到上一步输出的标准面部landmarks上。

最后一步便能通过face-vid2vid生成器来生成视频了。

话说回来,当然SPACEx也不是个全能选手,当输入有较大的头部旋转时,现有的方法表现就不是很好了。

不过还是值得一试的,感兴趣可以戳下文链接~

论文地址:

https://arxiv.org/pdf/2211.09809.pdf

参考链接:

https://deepimagination.cc/SPACEx/

— 完 —

MEET 2023 大会定档!

首批嘉宾阵容公布

量子位「MEET2023智能未来大会」正式定档12月14日!

首批嘉宾包括郑纬民院士、MSRA刘铁岩、阿里贾扬清、百度段润尧、高通Ziad Asghar、小冰李笛、浪潮刘军以及中关村科金张杰等来自产学研界大咖嘉宾,更多重磅嘉宾陆续确认中。

点击“预约”按钮,一键直达大会直播现场!

点这里关注我 👇 记得标星噢 ~

以上是关于英伟达让AI“演技”再上台阶:仅靠语音驱动1张照片说话,惊讶恐惧表情狠狠拿捏...的主要内容,如果未能解决你的问题,请参考以下文章

2D 照片变身 3D 模型,来看英伟达的 AI 新“魔法”!

入门NLP实现语音识别和语音合成,用这个开源工具SoEasy | 英伟达NLP公开课