BN(batch Normalization)笔记

Posted 刘二毛

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了BN(batch Normalization)笔记相关的知识,希望对你有一定的参考价值。

l BN(batch Normalization)

What is BN

通常在神经网络训练开始前,都要对输入数据做一个归一化处理

Why BN?

1. 提升泛华能力

神经网络学习过程本质就是为了学习数据分布,一旦训练数据与测试数据的分布不同,那么网络的泛化能力也大大降低;

2. 提高训练速度

一旦每批训练数据的分布各不相同(batch 梯度下降),那么网络就要在每次迭代都去学习适应不同的分布,这样将会大大降低网络的训练速度;

3. 减小累计误差

深度网络的训练是一个复杂的过程,只要网络的前面几层发生微小的改变,那么后面几层就会被累积放大下去。一旦网络某一层的输入数据的分布发生改变,那么这一层网络就需要去适应学习这个新的数据分布,所以如果训练过程中,训练数据的分布一直在发生变化,那么将会影响网络的训练速度;

How to BN

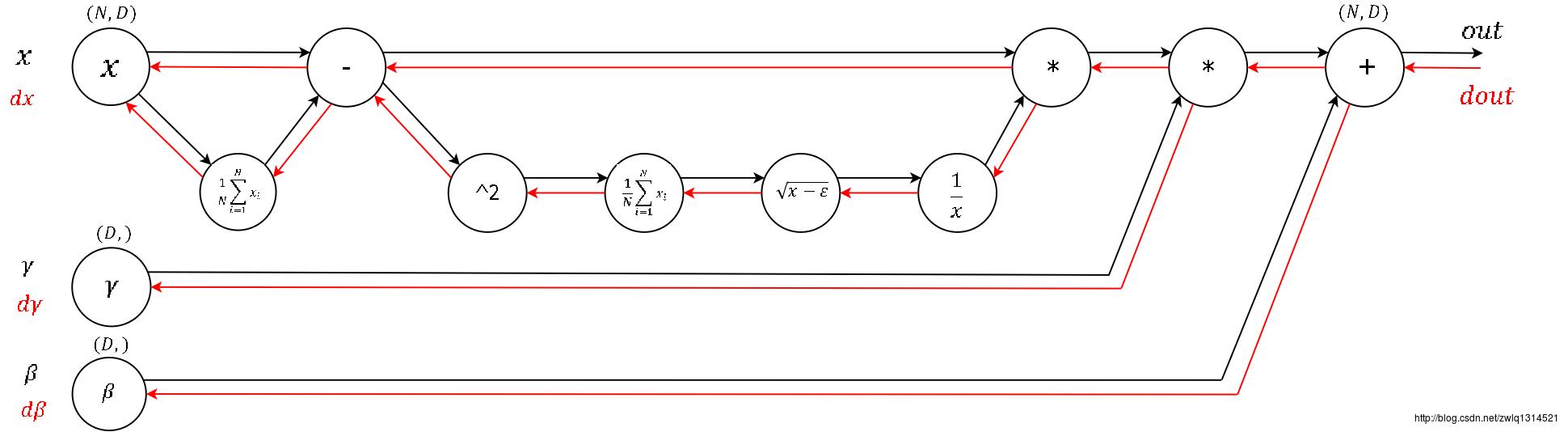

每一维度减去自身均值,再除以自身标准差,由于使用的是随机梯度下降法,这些均值和方差也只能在当前迭代的batch中计算,故作者给这个算法命名为Batch Normalization。

在Normalization完成后,Google的研究员仍对数值稳定性不放心,又加入了两个参数gamma和beta,使得yi=γx i ^ +β

在训练初期,分界面还在剧烈变化时,计算出的参数不稳定,所以退而求其次,在Wx+b之后进行归一化。这样,初始的W是从标准高斯分布中采样得到的,而W中元素的数量远大于x,Wx+b每维的均值本身就接近0、方差接近1,所以在Wx+b后使用Batch Normalization能得到更稳定的结果。

BN 计算表

在tensorflow中对应的接口为:tf.nn.batch_ normalization

batch_normalization(

x,

mean,

variance,

offset,

scale,

variance_epsilon,

name=None

)

在MINST中使用

def batch_norm(x, n_out, phase_train):

"""

Batch normalization on convolutional maps.

Ref.: http://stackoverflow.com/questions/33949786/how-could-i-use-batch-normalization-in-tensorflow

Args:

x: Tensor, 4D BHWD input maps

n_out: integer, depth of input maps

phase_train: boolean tf.Varialbe, true indicates training phase

scope: string, variable scope

Return:

normed: batch-normalized maps

"""

with tf.variable_scope('bn'):

beta = tf.Variable(tf.constant(0.0, shape=[n_out]),

name='beta', trainable=True)

gamma = tf.Variable(tf.constant(1.0, shape=[n_out]),

name='gamma', trainable=True)

batch_mean, batch_var = tf.nn.moments(x, [0,1,2], name='moments')

ema = tf.train.ExponentialMovingAverage(decay=0.5)

def mean_var_with_update():

ema_apply_op = ema.apply([batch_mean, batch_var])

with tf.control_dependencies([ema_apply_op]):

return tf.identity(batch_mean), tf.identity(batch_var)

mean, var = tf.cond(phase_train,

mean_var_with_update,

lambda: (ema.average(batch_mean), ema.average(batch_var)))

normed = tf.nn.batch_normalization(x, mean, var, beta, gamma, 1e-3)

return normed

#以上是关于BN(batch Normalization)笔记的主要内容,如果未能解决你的问题,请参考以下文章