空洞卷积可分组卷积

Posted 醉公子~

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了空洞卷积可分组卷积相关的知识,希望对你有一定的参考价值。

目录

空洞(扩张)卷积--------Dilated Convolution

空洞卷积(atrous convolutions)又名扩张卷积(dilated convolutions),在ICLR 2016上提出,其主要作用:

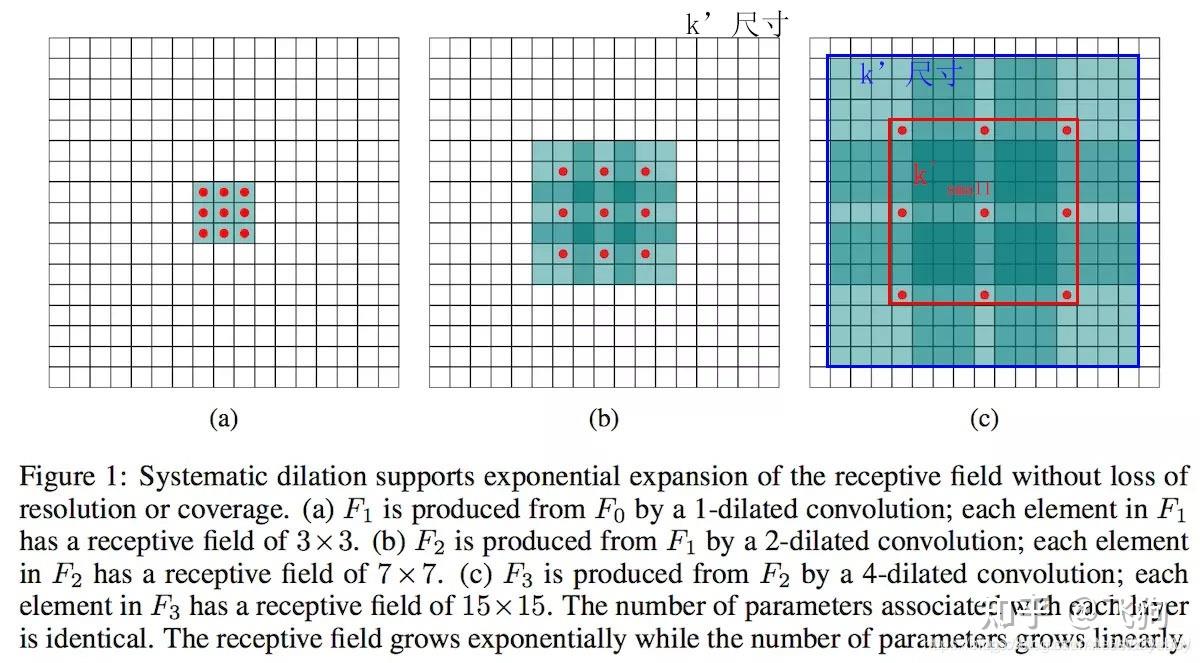

在不增加参数和模型复杂度的条件下,可以指数倍的扩大视觉感受野(每一个输出是由诗句感受野大小的输入决定的)的大小。是针对图像语义分割问题中下采样会降低图像分辨率、丢失信息而提出的一种卷积思路。利用添加空洞扩大感受野,向卷积层引入了一个称为“扩张率(dilate rate)”的超参数,该参数定义了卷积核处理数据时各值的间距。

空洞卷积是对卷积核的操作,在参数数量不变的情况下,具有更大的感受野。

空洞卷积诞生于图像分割领域,图像输入到网络中经过CNN提取特征,再经过pooling降低图像尺度的同时增大感受野。

由于图像分割是pixel-wise预测输出,所以还需要通过upsampling将变小的图像恢复到原始大小。upsampling通常是通过deconv(转置卷积)完成。因此图像分割FCN有两个关键步骤:

- 池化操作增大感受野

- upsampling操作扩大图像尺寸。

缺点:

虽然经过upsampling操作恢复了大小,但是很多细节还是被池化操作丢失了。

由上图可知,空洞卷积就是在原有的kernel的基础上扩大了卷积核的大小(产生了新的卷积核),eg:

由上图可知,空洞卷积就是在原有的kernel的基础上扩大了卷积核的大小(产生了新的卷积核),eg:

3

∗

3

—

—

—

>

5

∗

5

3 * 3 ———> 5*5

3∗3———>5∗5

但是他没有去获取更多的参数,只是以一定规律去选取特定区域的值,感受野变大。

o : 输出特征图

o : 输出特征图

ℹ :输入图大小

p :填充

k :kernel大小

d :膨胀系数

s : 步长

优点:

在参数量不变的情况下,获取到更大的感受视野,提取更大目标;

可分组卷积

分组卷积(Group convolution)最早在AlexNet中出现,由于当时的硬件资源有限,训练AlexNet时卷积操作不能全部放在同一GPU处理,因此作者把feature maps分给多个GPU分别进行处理,最后把多个GPU的结果进行融合。

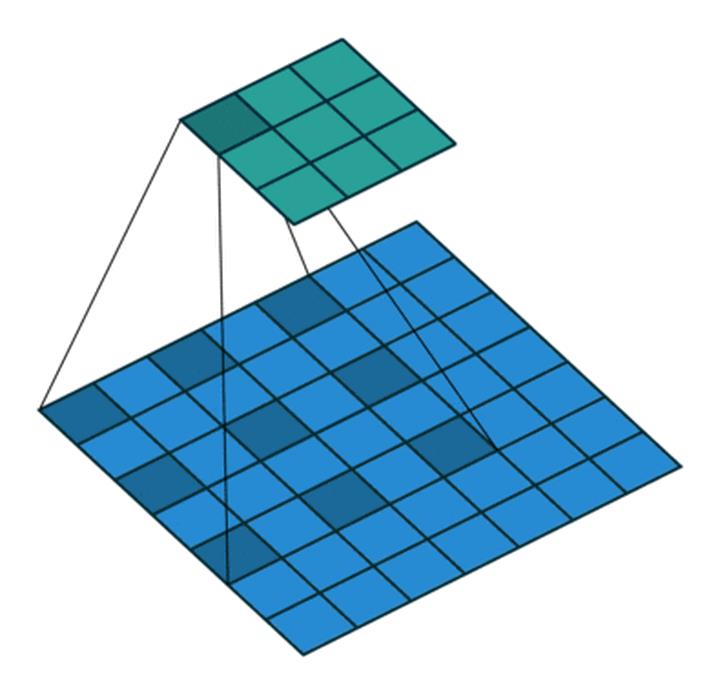

一般卷积计算:

输入256个特征图,输出256个特征图

input : 256

kernel: 3*3

output:256

参数量:256 * 3 * 3 * 256

分组卷积计算:

将256个通道,分为8组,每组32个特征图

input : 32

kernel: 3*3

group: 8

output:32

参数量:8 * 32 * 3 * 3 * 32

优点:

- 可以更好的结构化学习;

- 克服过拟合;

- 减少参数;

希望这篇文章对你有用!

谢谢点赞评论!

以上是关于空洞卷积可分组卷积的主要内容,如果未能解决你的问题,请参考以下文章